作者:愛吃牛油果的璐璐[1]

前沿

最近AI圈很火的一個(gè)話題就是AI Agent了!AI創(chuàng)投圈也在密切關(guān)注著相關(guān)創(chuàng)業(yè)公司的進(jìn)展。很多人說大模型都沒搞明白,又來了個(gè)AI Agent…... 但是別擔(dān)心Agent目前也是在起始階段。

AI Agent能力其實(shí)是和大模型相生的,大模型的能力邊界還是決定了AI Agent的能力邊界。

最近,復(fù)旦大學(xué),斯坦福大學(xué)都發(fā)表了對(duì)AI AGENT的看法和認(rèn)識(shí)。

研究背景

早在 1950 年代,Alan Turing 就將「智能」的概念擴(kuò)展到了人工實(shí)體,并提出了著名的圖靈測試。這些人工智能實(shí)體通常被稱為 —— 代理(Agent)。「代理」這一概念起源于哲學(xué),描述了一種擁有欲望、信念、意圖以及采取行動(dòng)能力的實(shí)體。斯坦福大學(xué)的一篇名為《Generative Agents: Interactive Simulacra of Human Behavior,titled[2]》的論文深入研究了記憶、反應(yīng)和計(jì)劃的AI Agent。

什么是AI Agent

AI Agent 被認(rèn)為是 OpenAI 發(fā)力的下一個(gè)方向。OpenAI 聯(lián)合創(chuàng)始人 Andrej Karpathy 在近期的公開活動(dòng)上說 “ 相比模型訓(xùn)練方法,OpenAI 內(nèi)部目前更關(guān)注 Agent 領(lǐng)域的變化,每當(dāng)有新的 AI Agents 論文出來的時(shí)候,內(nèi)部都會(huì)很興奮并且認(rèn)真地討論 ” 。

在人工智能領(lǐng)域,這一術(shù)語被賦予了一層新的含義:具有自主性、反應(yīng)性、積極性和社交能力特征的智能實(shí)體。

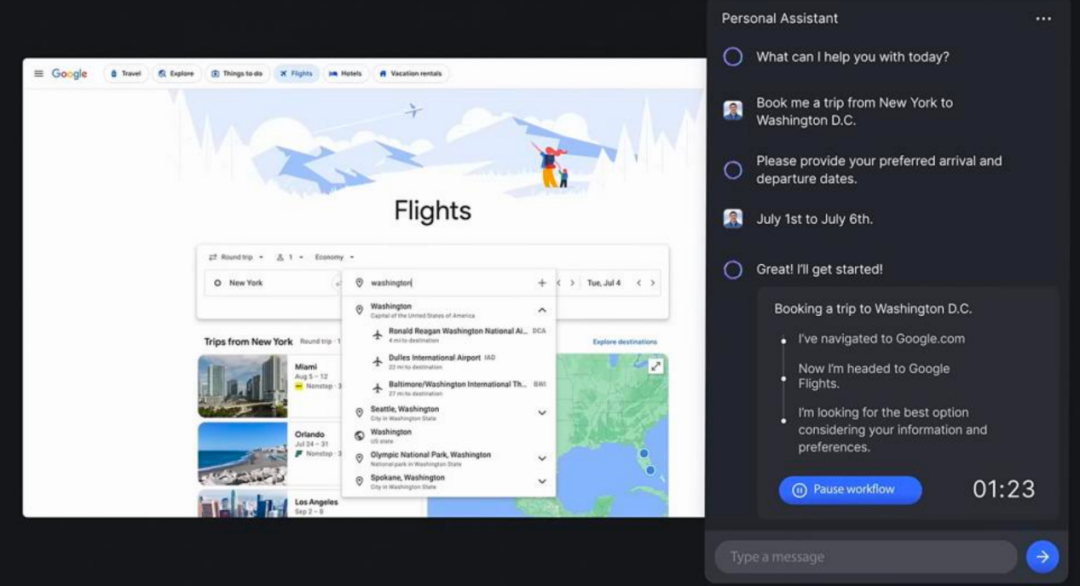

AI Agent,它被設(shè)計(jì)為具有獨(dú)立思考和行動(dòng)能力的AI程序。你只需要提供一個(gè)目標(biāo),比如寫一個(gè)游戲、開發(fā)一個(gè)網(wǎng)頁,他就會(huì)根據(jù)環(huán)境的反應(yīng)和獨(dú)白的形式生成一個(gè)任務(wù)序列開始工作。就好像是人工智能可以自我提示反饋,不斷發(fā)展和適應(yīng),以盡可能最好的方式來實(shí)現(xiàn)你給出的目標(biāo)。

NLP 到 AGI 的發(fā)展路線

NLP 到 AGI 的發(fā)展路線分為五級(jí):語料庫、互聯(lián)網(wǎng)、感知、具身和社會(huì)屬性,那么目前的大型語言模型已經(jīng)來到了第二級(jí),具有互聯(lián)網(wǎng)規(guī)模的文本輸入和輸出。在這個(gè)基礎(chǔ)上,如果賦予 LLM-based Agents 感知空間和行動(dòng)空間,它們將達(dá)到第三、第四級(jí)。進(jìn)一步地,多個(gè)代理通過互動(dòng)、合作解決更復(fù)雜的任務(wù),或者反映出現(xiàn)實(shí)世界的社會(huì)行為,則有潛力來到第五級(jí) —— 代理社會(huì)。

?

為什么需要AI Agent

為什么大語言模型(LLM)剛流行不久,就需要AI Agent呢?LLM與LangChain 等工具相結(jié)合,釋放了內(nèi)容生成、編碼和分析方面的多種可能性,目前在ChatGPT插件中比較有代表性的插件就是code interpreter。在這方面的應(yīng)用上Agent的概念應(yīng)用發(fā)揮著舉足輕重的作用。

這里可以將Agent視為人工智能大腦,它使用LLM進(jìn)行推理、計(jì)劃和采取行動(dòng)。

語言模型 (LLM) 僅限于它們所訓(xùn)練的知識(shí),并且這些知識(shí)很快就會(huì)過時(shí)。(每天用最新信息重新訓(xùn)練這么大的模型是不可行的。)

LLM的一些缺點(diǎn)

會(huì)產(chǎn)生幻覺。

結(jié)果并不總是真實(shí)的。

對(duì)時(shí)事的了解有限或一無所知。

很難應(yīng)對(duì)復(fù)雜的計(jì)算。

這就是AI Agent的用武之地,它可以利用外部工具來克服這些限制。

這里的工具是什么呢?工具就是代理用它來完成特定任務(wù)的一個(gè)插件、一個(gè)集成API、一個(gè)代碼庫等等,例如:

Google搜索:獲取最新信息

Python REPL:執(zhí)行代碼

Wolfram:進(jìn)行復(fù)雜的計(jì)算

外部API:獲取特定信息

而LangChain則是提供一種通用的框架通過大語言模型的指令來輕松地實(shí)現(xiàn)這些工具的調(diào)用。AI Agent的誕生就是為了處理各種復(fù)雜任務(wù)的,就復(fù)雜任務(wù)的處理流程而言AI Agent主要分為兩大類:行動(dòng)類、規(guī)劃執(zhí)行類。

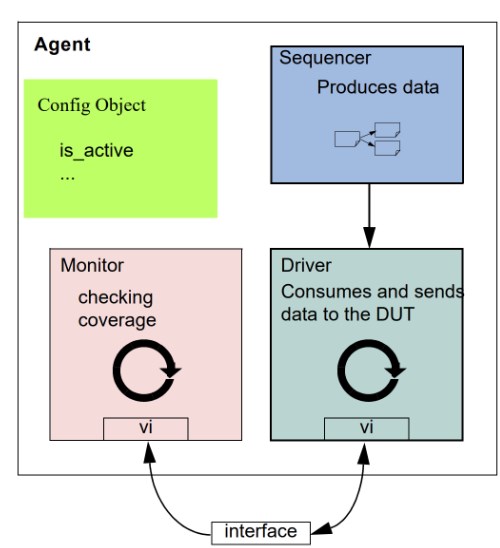

智能代理的框架

LLM-based Agent[3] 的概念框架,包含三個(gè)組成部分:控制端(Brain)、感知端(Perception)和行動(dòng)端(Action)。下面將分別介紹:

?

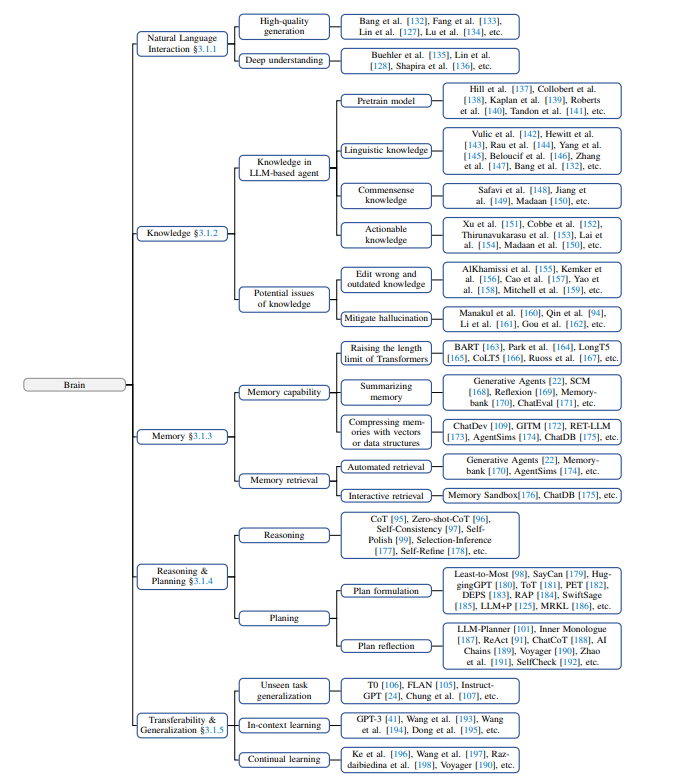

控制端:Brain

是智能代理的核心。它不僅可以存儲(chǔ)記憶和知識(shí),還承擔(dān)著信息處理、決策等不可或缺的功能。它可以呈現(xiàn)推理和計(jì)劃的過程,并很好地應(yīng)對(duì)未知任務(wù),反映出智能代理的泛化性和遷移性。控制端作為智能代理最核心的組成成分,作者們從五個(gè)方面展開介紹其能力:

自然語言交互:語言是溝通的媒介,其中包含著豐富的信息。得益于 LLMs 強(qiáng)大的自然語言生成和理解能力,智能代理能夠通過自然語言與外界進(jìn)行多輪交互,進(jìn)而實(shí)現(xiàn)目標(biāo)。具體而言,可以分為兩個(gè)方面:

高質(zhì)量文本生成:大量評(píng)估實(shí)驗(yàn)表明,LLMs 能夠生成流暢、多樣、新穎、可控的文本。盡管在個(gè)別語言上表現(xiàn)欠佳,但整體上具備良好的多語言能力。

言外之意的理解:除了直觀表現(xiàn)出的內(nèi)容,語言背后可能還傳遞了說話者的意圖、偏好等信息。言外之意有助于代理更高效地溝通與合作,大模型已經(jīng)展現(xiàn)出了這方面的潛力。

知識(shí):基于大批量語料訓(xùn)練的 LLMs,擁有了存儲(chǔ)海量知識(shí)(Knowledge)的能力。除了語言知識(shí)以外,常識(shí)知識(shí)和專業(yè)技能知識(shí)都是 LLM-based Agents 的重要組成部分。

雖然 LLMs 其本身仍然存在知識(shí)過期、幻覺等問題,現(xiàn)有的一些研究通過知識(shí)編輯或調(diào)用外部知識(shí)庫等方法,可以在一定程度上得到緩解。

記憶:在本文框架中,記憶模塊(Memory)儲(chǔ)存了代理過往的觀察、思考和行動(dòng)序列。通過特定的記憶機(jī)制,代理可以有效地反思并應(yīng)用先前的策略,使其借鑒過去的經(jīng)驗(yàn)來適應(yīng)陌生的環(huán)境。

短期記憶:我認(rèn)為所有的上下文學(xué)習(xí)(參見提示工程)都是利用模型的短期記憶來學(xué)習(xí)。

長期記憶:這為代理提供了長時(shí)間保留和回憶(無限)信息的能力,通常是通過利用外部向量存儲(chǔ)和快速檢索。

通常用于提升記憶能力的方法有三種:

擴(kuò)展 Backbone 架構(gòu)的長度限制:針對(duì) Transformers 固有的序列長度限制問題進(jìn)行改進(jìn)。

總結(jié)記憶(Summarizing):對(duì)記憶進(jìn)行摘要總結(jié),增強(qiáng)代理從記憶中提取關(guān)鍵細(xì)節(jié)的能力。

壓縮記憶(Compressing):通過使用向量或適當(dāng)?shù)臄?shù)據(jù)結(jié)構(gòu)對(duì)記憶進(jìn)行壓縮,可以提高記憶檢索效率。

此外,記憶的檢索方法也很重要,只有檢索到合適的內(nèi)容,代理才能夠訪問到最相關(guān)和準(zhǔn)確的信息。

推理 & 規(guī)劃:推理能力(Reasoning)對(duì)于智能代理進(jìn)行決策、分析等復(fù)雜任務(wù)而言至關(guān)重要。具體到 LLMs 上,就是以 思維鏈(Chain-of-Thought,CoT) 為代表的一系列提示方法。而規(guī)劃(Planning)則是面對(duì)大型挑戰(zhàn)時(shí)常用的策略。它幫助代理組織思維、設(shè)定目標(biāo)并確定實(shí)現(xiàn)這些目標(biāo)的步驟。在具體實(shí)現(xiàn)中,規(guī)劃可以包含兩個(gè)步驟:

計(jì)劃制定(Plan Formulation):代理將復(fù)雜任務(wù)分解為更易于管理的子任務(wù)。例如:一次性分解再按順序執(zhí)行、逐步規(guī)劃并執(zhí)行、多路規(guī)劃并選取最優(yōu)路徑等。在一些需要專業(yè)知識(shí)的場景中,代理可與特定領(lǐng)域的 Planner 模塊集成,提升能力。

計(jì)劃反思(Plan Reflection):在制定計(jì)劃后,可以進(jìn)行反思并評(píng)估其優(yōu)劣。這種反思一般來自三個(gè)方面:借助內(nèi)部反饋機(jī)制;與人類互動(dòng)獲得反饋;從環(huán)境中獲得反饋。

遷移性 & 泛化性:擁有世界知識(shí)的 LLMs 賦予智能代理具備強(qiáng)大的遷移與泛化能力。一個(gè)好的代理不是靜態(tài)的知識(shí)庫,還應(yīng)具備動(dòng)態(tài)的學(xué)習(xí)能力:

對(duì)未知任務(wù)的泛化:隨著模型規(guī)模與訓(xùn)練數(shù)據(jù)的增大,LLMs 在解決未知任務(wù)上涌現(xiàn)出了驚人的能力。通過指令微調(diào)的大模型在 zero-shot 測試中表現(xiàn)良好,在許多任務(wù)上都取得了不亞于專家模型的成績。

情景學(xué)習(xí)(In-context Learning):大模型不僅能夠從上下文的少量示例中進(jìn)行類比學(xué)習(xí),這種能力還可以擴(kuò)展到文本以外的多模態(tài)場景,為代理在現(xiàn)實(shí)世界中的應(yīng)用提供了更多可能性。

持續(xù)學(xué)習(xí)(Continual Learning):持續(xù)學(xué)習(xí)的主要挑戰(zhàn)是災(zāi)難性遺忘,即當(dāng)模型學(xué)習(xí)新任務(wù)時(shí)容易丟失過往任務(wù)中的知識(shí)。專有領(lǐng)域的智能代理應(yīng)當(dāng)盡量避免丟失通用領(lǐng)域的知識(shí)。

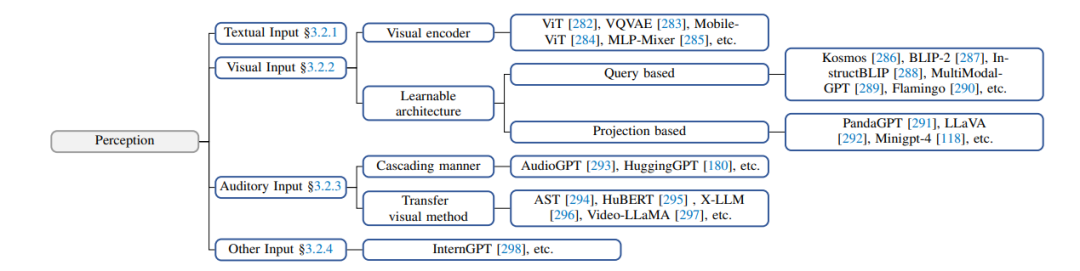

感知端:Perception

多模態(tài)感知能加深代理對(duì)工作環(huán)境的理解,顯著提升了其通用性。

文本輸入:作為 LLMs 最基礎(chǔ)的能力,這里不再贅述。

視覺輸入:LLMs 本身并不具備視覺的感知能力,只能理解離散的文本內(nèi)容。而視覺輸入通常包含有關(guān)世界的大量信息,包括對(duì)象的屬性,空間關(guān)系,場景布局等等。常見的方法有:

將視覺輸入轉(zhuǎn)為對(duì)應(yīng)的文本描述(Image Captioning):可以被 LLMs 直接理解,并且可解釋性高。

對(duì)視覺信息進(jìn)行編碼表示:以視覺基礎(chǔ)模型 + LLMs 的范式來構(gòu)成感知模塊,通過對(duì)齊操作來讓模型理解不同模態(tài)的內(nèi)容,可以端到端的方式進(jìn)行訓(xùn)練。

聽覺輸入:聽覺也是人類感知中的重要組成部分。由于 LLMs 有著優(yōu)秀的工具調(diào)用能力,一個(gè)直觀的想法就是:代理可以將 LLMs 作為控制樞紐,通過級(jí)聯(lián)的方式調(diào)用現(xiàn)有的工具集或者專家模型,感知音頻信息。此外,音頻也可以通過頻譜圖(Spectrogram)的方式進(jìn)行直觀表示。頻譜圖可以作為平面圖像來展示 2D 信息,因此,一些視覺的處理方法可以遷移到語音領(lǐng)域。

其他輸入:現(xiàn)實(shí)世界中的信息遠(yuǎn)不止文本、視覺和聽覺。作者們希望在未來,智能代理能配備更豐富的感知模塊,例如觸覺、嗅覺等器官,用于獲取目標(biāo)物體更加豐富的屬性。同時(shí),代理也能對(duì)周圍環(huán)境的溫度、濕度和明暗程度有清楚的感受,采取更 Environment-aware 的行動(dòng)。

此外,還可以為代理引入對(duì)更廣闊的整體環(huán)境的感知:采用激光雷達(dá)、GPS、慣性測量單元等成熟的感知模塊。

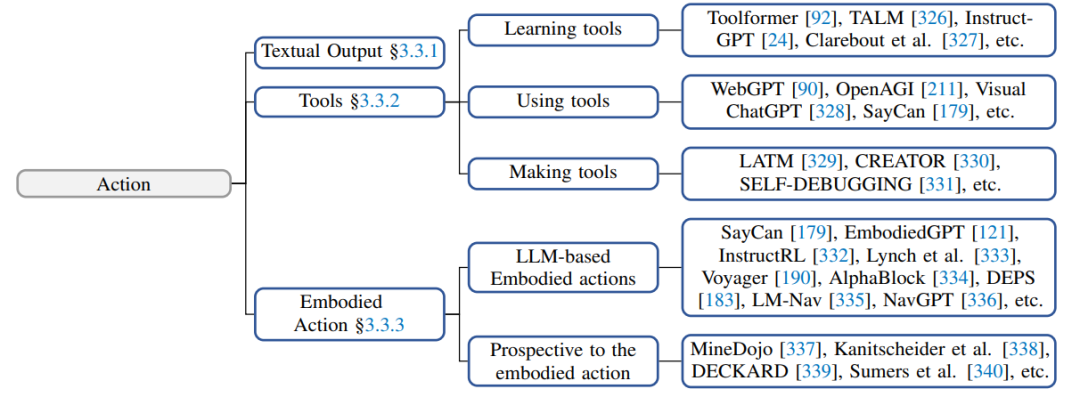

行動(dòng)端:Action

在大腦做出分析、決策后,代理還需要做出行動(dòng)以適應(yīng)或改變環(huán)境:

文本輸出:作為 LLMs 最基礎(chǔ)的能力,這里不再贅述。

工具使用:盡管 LLMs 擁有出色的知識(shí)儲(chǔ)備和專業(yè)能力,但在面對(duì)具體問題時(shí),也可能會(huì)出現(xiàn)魯棒性問題、幻覺等一系列挑戰(zhàn)。與此同時(shí),工具作為使用者能力的擴(kuò)展,可以在專業(yè)性、事實(shí)性、可解釋性等方面提供幫助。例如,可以通過使用計(jì)算器來計(jì)算數(shù)學(xué)問題、使用搜索引擎來搜尋實(shí)時(shí)信息。

另外,工具也可以擴(kuò)展智能代理的行動(dòng)空間。例如,通過調(diào)用語音生成、圖像生成等專家模型,來獲得多模態(tài)的行動(dòng)方式。因此,如何讓代理成為優(yōu)秀的工具使用者,即學(xué)會(huì)如何有效地利用工具,是非常重要且有前景的方向。

目前,主要的工具學(xué)習(xí)方法包括從演示中學(xué)習(xí)和從反饋中學(xué)習(xí)。此外,也可以通過元學(xué)習(xí)、課程學(xué)習(xí)等方式來讓代理程序在使用各種工具方面具備泛化能力。更進(jìn)一步,智能代理還可以進(jìn)一步學(xué)習(xí)如何「自給自足」地制造工具,從而提高其自主性和獨(dú)立性。

具身行動(dòng):具身(Embodyment)是指代理與環(huán)境交互過程中,理解、改造環(huán)境并更新自身狀態(tài)的能力。具身行動(dòng)(Embodied Action)被視為虛擬智能與物理現(xiàn)實(shí)的互通橋梁。

傳統(tǒng)的基于強(qiáng)化學(xué)習(xí)的 Agent 在樣本效率、泛化性和復(fù)雜問題推理等方面存在局限性,而 LLM-based Agents 通過引入大模型豐富的內(nèi)在知識(shí),使得 Embodied Agent 能夠像人類一樣主動(dòng)感知、影響物理環(huán)境。根據(jù)代理在任務(wù)中的自主程度或者說 Action 的復(fù)雜程度,可以有以下的原子 Action:

Observation 可以幫助智能代理在環(huán)境中定位自身位置、感知對(duì)象物品和獲取其他環(huán)境信息;

Manipulation 則是完成一些具體的抓取、推動(dòng)等操作任務(wù);

Navigation 要求智能代理根據(jù)任務(wù)目標(biāo)變換自身位置并根據(jù)環(huán)境信息更新自身狀態(tài)。

通過組合這些原子行動(dòng),代理可以完成更為復(fù)雜的任務(wù)。例如「廚房的西瓜比碗大嗎?」這類具身的 QA 任務(wù)。為了解決這個(gè)問題,代理需要導(dǎo)航到廚房,并在觀察二者的大小后得出答案。

智能代理的應(yīng)用場景

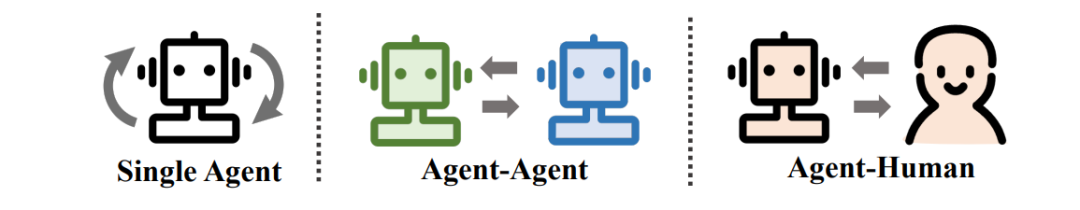

LLM-based Agent 的三種應(yīng)用范式:單代理、多代理、人機(jī)交互。

單代理場景

可以接受人類自然語言命令,執(zhí)行日常任務(wù)的智能代理目前備受用戶青睞,具有很高的現(xiàn)實(shí)使用價(jià)值。作者們首先在單智能代理的應(yīng)用場景中,闡述了其多樣化的應(yīng)用場景與對(duì)應(yīng)能力。

在論文中,單智能代理的應(yīng)用被劃分為如下三個(gè)層次:

?

單代理應(yīng)用場景的三個(gè)層次:任務(wù)導(dǎo)向、創(chuàng)新導(dǎo)向、生命周期導(dǎo)向。

在任務(wù)導(dǎo)向的部署中,代理幫助人類用戶處理日常基本任務(wù)。它們需要具備基本的指令理解、任務(wù)分解、與環(huán)境交互的能力。具體來說,根據(jù)現(xiàn)有的任務(wù)類型,代理的實(shí)際應(yīng)用又可以分為模擬網(wǎng)絡(luò)環(huán)境與模擬生活場景。

在創(chuàng)新導(dǎo)向的部署中,代理能夠在前沿科學(xué)領(lǐng)域展現(xiàn)出自主探究的潛力。雖然來自專業(yè)領(lǐng)域的固有復(fù)雜性和訓(xùn)練數(shù)據(jù)的缺乏給智能代理的構(gòu)建帶來了阻礙,但目前已經(jīng)有許多工作在化學(xué)、材料、計(jì)算機(jī)等領(lǐng)域取得了進(jìn)展。

在生命周期導(dǎo)向的部署中,代理具備在一個(gè)開放世界中不斷探索、學(xué)習(xí)和使用新技能,并長久生存的能力。在本節(jié)中,作者們以《我的世界》游戲?yàn)槔归_介紹。由于游戲中的生存挑戰(zhàn)可以被認(rèn)為是現(xiàn)實(shí)世界的一個(gè)縮影,已經(jīng)有許多研究者將其作為開發(fā)和測試代理綜合能力的獨(dú)特平臺(tái)。

多代理場景

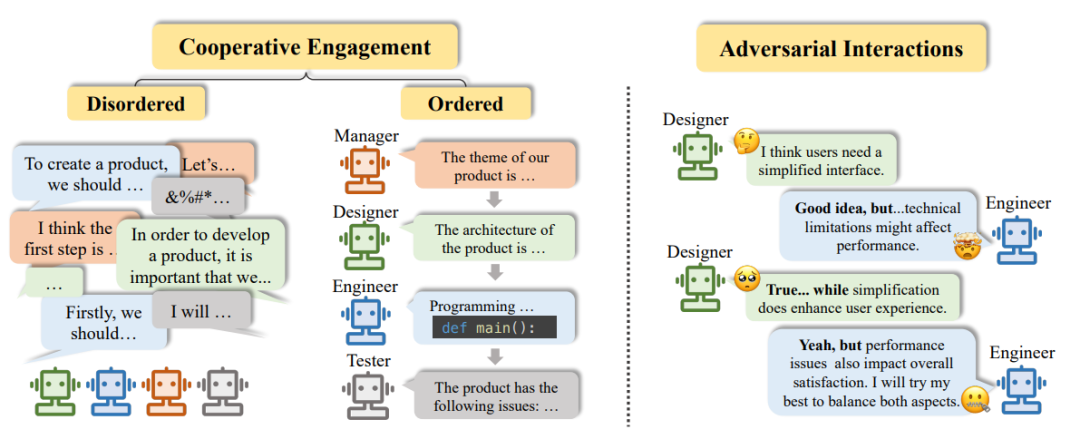

多代理應(yīng)用場景的兩種交互形式:合作型互動(dòng)、對(duì)抗型互動(dòng)。

合作型互動(dòng):作為實(shí)際應(yīng)用中部署最為廣泛的類型,合作型的代理系統(tǒng)可以有效提高任務(wù)效率、共同改進(jìn)決策。具體來說,根據(jù)合作形式的不同,作者們又將合作型互動(dòng)細(xì)分為無序合作與有序合作。

當(dāng)所有代理自由地表達(dá)自己的觀點(diǎn)、看法,以一種沒有順序的方式進(jìn)行合作時(shí),稱為無序合作。

當(dāng)所有代理遵循一定的規(guī)則,例如以流水線的形式逐一發(fā)表自己的觀點(diǎn)時(shí),整個(gè)合作過程井然有序,稱為有序合作。

對(duì)抗型互動(dòng):智能代理以一種針鋒相對(duì)(tit for tat)的方式進(jìn)行互動(dòng)。通過競爭、談判、辯論的形式,代理拋棄原先可能錯(cuò)誤的信念,對(duì)自己的行為或者推理過程進(jìn)行有意義的反思,最終帶來整個(gè)系統(tǒng)響應(yīng)質(zhì)量的提升。

人機(jī)交互場景

?

人機(jī)交互場景的的兩種模式:Instructor-Executor 模式 vs. Equal Partnership 模式。

Instructor-Executor 模式:人類作為指導(dǎo)者,給出指令、反饋意見;而代理作為執(zhí)行者,依據(jù)指示逐步調(diào)整、優(yōu)化。這種模式在教育、醫(yī)療、商業(yè)等領(lǐng)域得到了廣泛的應(yīng)用。

Equal Partnership 模式:有研究觀察到代理能夠在與人類的交流中表現(xiàn)出共情能力,或是以平等的身份參與到任務(wù)執(zhí)行中。智能代理展現(xiàn)出在日常生活中的應(yīng)用潛力,有望在未來融入人類社會(huì)。

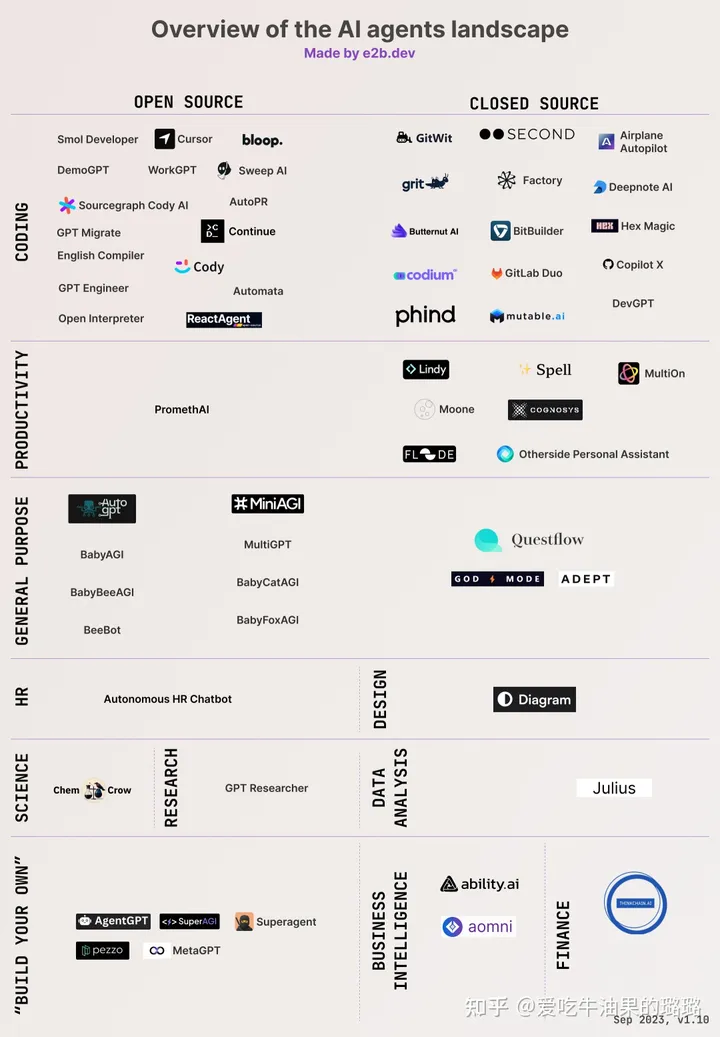

AI Agent 一覽表

開放性問題討論

智能代理與大語言模型的研究該如何互相促進(jìn)、共同發(fā)展?

大模型在語言理解、決策制定以及泛化能力等方面展現(xiàn)出強(qiáng)大的潛力,成為代理構(gòu)建過程中的關(guān)鍵角色,而代理的進(jìn)展也為大模型提出了更高的要求。

LLM-based Agents 會(huì)帶來哪些挑戰(zhàn)與隱憂?

智能代理能否真正落地,需要經(jīng)過嚴(yán)謹(jǐn)?shù)陌踩栽u(píng)估,避免對(duì)真實(shí)世界帶來危害。作者總結(jié)了更多潛在威脅,例如:非法濫用、失業(yè)風(fēng)險(xiǎn)、對(duì)人類福祉造成影響等等。

代理數(shù)量的提升(scaling up)會(huì)帶來哪些機(jī)遇和挑戰(zhàn)?

在模擬社會(huì)中,提升個(gè)體數(shù)量可以顯著提升模擬的可信度與真實(shí)性。然而,隨著代理數(shù)量的上升,通信與消息傳播問題會(huì)變得相當(dāng)復(fù)雜,信息的失真、誤解或者幻覺現(xiàn)象都會(huì)顯著降低整個(gè)模擬系統(tǒng)的效率。

網(wǎng)絡(luò)上關(guān)于 LLM-based Agent 是否是通向 AGI 的合適道路的爭論。

有研究者認(rèn)為,以 GPT-4 為代表的大模型已經(jīng)在足夠的語料上進(jìn)行了訓(xùn)練,在此基礎(chǔ)上構(gòu)建的代理有潛力成為打開 AGI 之門的鑰匙。但也有其他研究者認(rèn)為,自回歸語言建模(Auto-regressive Language Modeling)并不能顯現(xiàn)出真正的智能,因?yàn)樗鼈冎皇亲鞒鲰憫?yīng)。一個(gè)更完備的建模方式,例如世界模型(World Model),才能通向 AGI。

群體智能的演化歷程。群體智能是一種集結(jié)眾人的意見進(jìn)而轉(zhuǎn)化為決策的過程。

然而,一味通過增加代理的數(shù)量,是否會(huì)產(chǎn)生真正的「智能」?此外,如何協(xié)調(diào)單個(gè)代理,讓智能代理社會(huì)克服「團(tuán)體迷思」和個(gè)人認(rèn)知偏差?

代理即服務(wù)(Agent as a Service,AaaS)。

由于 LLM-based Agents 比大模型本身更加復(fù)雜,中小型企業(yè)或個(gè)人更加難在本地構(gòu)建,因此云廠商可以考慮以服務(wù)的形式來將智能代理落地,即 Agent-as-a-Service。就像其他的云服務(wù)一樣,AaaS 有潛力為用戶提供高靈活性和按需的自助服務(wù)。

審核編輯:黃飛

?

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論