本文旨在回顧現(xiàn)有的方法和理論,幫助理解和重新思考人類駕駛員之間的交互,從而實現(xiàn)社會自主駕駛。這項綜述為了尋求一系列基本問題的答案:

1)什么是道路交通場景中的社會交互?2) 如何衡量和評估社會交互?3) 如何建模和揭示社會交互過程?4) 人類駕駛員如何在社會交互中達成隱性協(xié)議并順利協(xié)商?

本文回顧了建模和學習人類駕駛員之間社會交互的各種方法,從優(yōu)化理論和圖模型(graphical models)到社會力理論和行為認知科學。還強調(diào)了一些新的方向、關鍵挑戰(zhàn)以及未來研究的開放性問題。

人類可以被訓練成具有強大社會交互能力的卓越駕駛員。在現(xiàn)實世界的交通中,理性的人類駕駛員可以通過使用非語言通信(如手勢,向另一輛車揮手讓路)、指示語(如使用轉(zhuǎn)向信號燈指示意圖)等有效地與周圍環(huán)境協(xié)商,在復雜和擁擠的場景中做出與社會兼容的決策,以及運動線索(例如加速/減速/轉(zhuǎn)彎)。

理解復雜交通場景中人類駕駛員之間動態(tài)交互的原則和規(guī)則,可以 1)利用對他人行為或反應的信念和期望,產(chǎn)生不同的社會駕駛行為;2) 預測具有移動目標場景的未來狀態(tài),對于構(gòu)建可能安全的智能車輛至關重要,其具有行為預測和潛在碰撞檢測的能力;3)創(chuàng)建逼真的駕駛模擬器。

然而,這項任務不簡單,因為從交通心理學家的角度來看,在駕駛交互過程中存在各種社會因素,包括社會動機、社會感知和社會控制。一般來說,人類駕駛行為由人類駕駛員的社會交互和與場景的物理交互所構(gòu)成。

由于人類之間的連續(xù)閉環(huán)反饋,社會交互比物理交互更加復雜,并且存在許多不確定性。社會交互可能只需要簡單的決策,直接將人類感知映射到行動,而無需具體的推理和規(guī)劃(例如,刺激反應、反應性交互、跟車)。社會交互也可能需要復雜的決策,通過預測其他智體的行為并評估所有可能替代方案的影響,迫使人類駕駛員謹慎地決定備選方案中的行動(例如,讓路或通過)。

另一方面,人類駕駛員可以通過顯式通信相互交流,例如使用手勢和閃光燈。然而,在實踐中,明確的溝通選項并不總是可用或最有效。在許多情況下,人類駕駛員更喜歡使用隱式而非顯式通信來完成交互交通場景中的駕駛?cè)蝿铡?/p>

從人與人之間交互到人與自動駕駛汽車(AV)的交互

人與人之間的社會交互。人類是自然的社會傳播者;人類駕駛員安全高效地與其他智體進行協(xié)商,形成一個交互密集的多智體系統(tǒng)。一般來說,人類駕駛行為受兩類規(guī)范的支配:法律規(guī)范和社會規(guī)范。

交通規(guī)則構(gòu)成法律規(guī)范,人類社會因素構(gòu)成社會規(guī)范。在真實的交通中,人類駕駛員并不總是嚴格和刻板地遵守交通法規(guī)(例如,在高速公路上保持在限速之下),這是合規(guī)的行為(即法律規(guī)范)。

相反,人類駕駛員通常會根據(jù)隱含的社會規(guī)范和規(guī)則駕駛,促進道路高效和安全的行為。現(xiàn)有研究還表明,根據(jù)隨便的行為(即社會規(guī)范)行事,可以使其他人的行為變得可識別和可預測,從而減少交互不確定性,促進每個智體的決策。

因此,通過純粹的法律規(guī)范理解和推斷其他人的駕駛行為可能是無效的,因為:

交通規(guī)則并不總是規(guī)定駕駛行為。例如,當駕駛員打算在擁擠的交通中改變車道時,交通法只禁止碰撞,但沒有具體說明駕駛員應如何與他人合作或競爭以形成空檔。社會規(guī)范通常主導這種交互行為。

人工駕駛不嚴格遵守交通規(guī)則。如圖說明了現(xiàn)實生活中經(jīng)常發(fā)生的交互場景。一名經(jīng)驗豐富的駕駛員(紅色)打算通過十字路口,但其領路車正在等待左轉(zhuǎn)。駕駛員可以越過白色實線并從右側(cè)通過超車,節(jié)省行駛時間。雖然這種行為稍微違反了交通規(guī)則,但卻提高了交通流效率。

因此,讓自動駕駛汽車(AV)配備人與人之間交互的集體動力學,可以在人類環(huán)境中做出知情和社會兼容的決策。

自動駕駛車輛的社會行為。作為移動智能的智體,智能車輛也需要與人類交互,并將成為復雜社會系統(tǒng)的一部分。在這樣一個安全-緊要的系統(tǒng)中,AVs應該無縫地融入到有人類駕駛的道路中,并在社交上與達到人類水平的性能兼容。然而,如圖所示,人類駕駛員遵循的規(guī)范與自動駕駛車輛之間存在很大差距。

嚴格遵循法律規(guī)范的自動駕駛車輛可能無法應對高度交互的場景,并搞糊涂其他遵循社會規(guī)范的人類駕駛員。例如,在停車標志(可被視為法律規(guī)范)向人類傳遞令人困惑的社會線索之前,AV嚴格且刻板地遵循3秒法則:“為什么車輛不前進?”為了有效溝通,AVs需要模仿或理想地改進,如人類一般駕駛,這要求他們:

理解并適應他人的社交和運動線索。這將AV視為信息接收器,使其在功能上安全高效。例如,如果沒有認識到其他駕駛員的攻擊性水平,將使AV不安全或過于保守。

提供可識別、信息豐富的社交和動作線索。AVs視為信息發(fā)送者,其他人類駕駛員能夠感知和理解AVs行為,從而能夠進行安全有效的工作。例如,在讓行和通過之間猶豫的AV會搞糊涂其他道路使用者,導致事故或交通堵塞。

并不是說AVs為了表現(xiàn)得像人類駕駛員或與社會兼容就要違反交通規(guī)則。學習和理解人類駕駛員遵循的社會規(guī)范有助于高效安全的交互。

如圖說明了兩個智體(人類駕駛員和/或AV)之間的動態(tài)通信過程,每個智體在信息交換過程中扮演兩個角色:信息發(fā)送者和接收者。例如,智體A將充當信息發(fā)送者,“告訴”智體B其意圖。同時,智體B應該感知并理解智體A提供的信息(即感知),然后通過提供可識別的有用信息采取一些行動來響應或適應智體A。

賦予AVs人類社會能力,提高復雜交通場景中的交互性能。例如,用計算認知模型對人類社會偏好(如利他、親社會、利己和競爭)以及與AV交互時的合作水平進行定量評估。

在量化社會交互之前,我們首先需要弄清楚在特定場景中 “交互何時發(fā)生?”或者“是否人類駕駛員之間發(fā)生交互?”。一個相關的問題是 “誰參與了交互?”

在實際交通中,道路使用者并不總是有豐富的交互。例如,在人行道上移動的單個行人通常不會影響其他行人,但更豐富社會交互模式的任務除外,例如體育。同樣,駕駛員之間豐富的社會交互可能并不總是發(fā)生。

人類駕駛員主要單獨駕駛,并對物理環(huán)境做出反應,但在大多數(shù)駕駛?cè)蝿罩校绺咚俟返能嚨辣3中袨楹统鞘行盘柦徊媛房诘氖鼙Wo左轉(zhuǎn)行為,不會與其他道路使用者直接交互。有三種常用的方法來確定何時發(fā)生交互以及誰參與交互。

潛在沖突檢查

確定一個駕駛員是否會與另一個駕駛員(直接或間接)交互的一種直接方法是檢查他們近期的路徑是否沖突。如果路徑?jīng)_突,則會發(fā)生交互,否則不會發(fā)生交互。該檢查方法即沖突點的定義,“靠近車輛路徑合并、分流或交叉區(qū)域的位置。”

假設只有潛在沖突的車輛才能相互交互,簡化了交互場景,這與日常駕駛過程中的人類直覺一致。可以從多個移動目標的預測未來運動和意圖來評估潛在沖突。

駕駛員可以利用道路幾何和交通法規(guī)的相關信息來檢查與他人的潛在沖突。當駕駛員進入交通規(guī)則明確的交叉路口時,可以通過檢查與其他虛擬參考線的交叉點來識別沖突點。此外,駕駛員還用指示語及其對他人意圖和動作的社會推理來識別潛在沖突點。例如,當駕駛員(表示為A)注意到相鄰車輛(表示為B)打著閃光燈(即指示燈)或有意接近,目的是切入駕駛員A的前方間隙(即社會推理)時,駕駛員A可以識別駕駛員B的換道意圖,接著發(fā)生沖突。

感興趣區(qū)域設置

確定交互何時發(fā)生的另一種方法是在環(huán)境中設置特定的感興趣區(qū)域(RoI)。同時占據(jù)RoI的任意一對智體之間存在交互,并且一旦任何一個智體移動到RoI之外,交互就會消失。設置RoI通常是面向應用的,可以根據(jù)以下兩種方法進行設計:

以場景為中心。確定地圖上的RoI,并將該地區(qū)的所有人類駕駛員視為交互智體。該方法通常用于預測和分析特定交通區(qū)域(如城市交叉口和環(huán)島)中的多智體駕駛行為。在這些情況下,研究人員在地圖上確定了涵蓋此類場景的RoI,并假設占據(jù)RoI的所有駕駛員都會相互影響。

以智體為中心。將RoI與一個感興趣的智體(即自智體)連接起來。這種方法通常用于研究自智體與其周圍智體的交互行為,例如高速公路上的車道變換行為。RoI的形狀有多種選擇。例如,在研究高速公路上的車道變換交互行為時,通常將矩形區(qū)域連接到自車并設置為RoI。

請注意,有些方法還混合二者。例如,在設定高速公路路段的RoI后,進一步計算了智體之間的距離,以確定交互的存在。

上述RoI需要手工制定的規(guī)則,相關的評估性能可能對RoI的配置敏感。一般來說,RoI越大,參與的智體越多,可能會高估交互;而RoI小,參與的智體越少,可能會低估交互。為了克服這些缺點,可以根據(jù)駕駛?cè)蝿罩鲃舆x擇交互智體。

面向任務的智體選擇

人類將根據(jù)具體的駕駛?cè)蝿眨羞x擇地確定應該更多關注哪些智體以及何時應該關注。受這一事實的啟發(fā),研究人員根據(jù)問題及其相應交互過程的領域知識,根據(jù)經(jīng)驗為特定任務選擇交互智體。例如,對于左車道變換任務,研究人員假設自車僅與當前車道上的領頭車輛以及左目標車道上的領頭和跟隨車輛交互。該假設符合人類駕駛經(jīng)驗,并且可以通過只關注任務相關的智體來簡化交互問題。然而,它需要具有特定領域知識的手工規(guī)則,并且可能無法捕捉個體在如何關注方面的差異。

檢查駕駛員對彼此的影響可以確定是否存在人類交互。對于駕駛員之間的交互,一項關鍵任務是弄清楚 “如何在利用社會因素的同時量化這些交互?” 常用的量化方法,通常可分為兩類:基于顯式模型的方法和隱式數(shù)據(jù)驅(qū)動的方法。

基于模型的方法

最常用的顯式量化交互的方法是構(gòu)建交互模型,其中一些參數(shù)可以從傳感器數(shù)據(jù)中估計,以量化智體之間的社會交互強度。研究人員利用基于不同假設的傳感器信息開發(fā)了許多交互模型,如圖所示四類。

對于作為模型輸入的傳感器數(shù)據(jù),設計師可以明確解釋與物理距離相關的度量,從而獲得更多研究人員的吸引。在應用中,可以直觀地假設交互強度與交通場景中智體相對距離及其變量(例如,相對速度和加速度)相關。例如,相距較近的駕駛員在直覺上會視為彼此具有較大的交互影響。

1 基于理性效用的模型

人類駕駛行為或動作是(接近)最佳結(jié)果,可最大化環(huán)境的某些效用。在這一點上,研究人員將物理距離相關信息整合到目標/成本函數(shù)中,將駕駛員之間的相互作用表述為優(yōu)化問題,這可以用現(xiàn)成的動態(tài)和線性規(guī)劃算法來解決。通常,成本函數(shù)是根據(jù)交通管制和駕駛?cè)蝿盏南闰炗蛑R手工構(gòu)建的。例如,研究人員將駕駛員的換道機動視為一個優(yōu)化問題,即在車輛動力學約束下最小化橫向路徑跟蹤誤差(橫向控制),同時保持期望速度(縱向控制)。通常,基于效用的模型可以在類似場景中仔細調(diào)參達到預期性能,但在未知場景中通用性較低。通常使用的模型是最優(yōu)群(optimal swarms)、博弈論模型、模仿學習和馬爾可夫決策過程(MDP)。

2 概率生成模型

社會交互情境的描述是一種條件,其中單個駕駛員的行為由其組織特征和環(huán)境決定,其他駕駛員的行為是環(huán)境的一個組成部分,反之亦然。從條件概率角度來看,駕駛員之間的交互影響可以解釋為“在感知到周圍其他駕駛員的狀態(tài)后,一個駕駛員可能怎樣采取特定的行動?”。該問題可以通過概率條件分布或條件行為預測來表示。

這一概念是貝葉斯網(wǎng)絡的基礎。此外,可以通過一種意外的交互來量化智體的交互作用。在這種交互作用中,一個智體(表示為智體B),由于另一個智體(表示為智體A)觀察到的軌跡,而經(jīng)歷行為的變化。這種想法使得信息論中的大多數(shù)現(xiàn)成相似性度量方法(如KL發(fā)散)變得容易。

另一方面,交互作用也可以進一步視為(潛在的)概率生成過程或條件概率模型。例如,一種概率圖模型捕捉領頭車輛的未來狀態(tài)與動態(tài)系統(tǒng)(即領頭車輛和后隨車輛)歷史狀態(tài)之間的相互作用。然而,它沒有考慮并入車輛對前后車輛之間相互作用的影響。一種交互-覺察概率駕駛員模型,捕捉駕駛員的交互偏好,并且考慮到周圍駕駛員行為的預測,駕駛員將在當前時間步執(zhí)行機動。然后,在逆優(yōu)化框架下,通過加權特征(即導航和風險特征)的組合來制定交互偏好。

3 潛在/風險域

基于人類駕駛行為來自基于風險域的假設,提出潛在/風險域的模型。在人類機器人和多車輛交互,已經(jīng)廣泛研究了勢函數(shù)對智體之間交互進行建模。物理距離相關度量通過某些可學習可解釋的函數(shù)(稱為潛函數(shù))允許有效地制定交互,這些函數(shù)可以嵌入交通規(guī)則和駕駛場景上下文的領域知識。

另一方面,勢函數(shù)相對坐標系(例如,x和y方向)的導數(shù),導致“推”或“拉”車輛的尺度化虛擬力,最小化車輛的局部規(guī)劃成本,同時與周圍的駕駛員進行交互。研究人員還設計了能量函數(shù),根據(jù)周圍車輛和自車之間的相對距離(通常是兩條車輛軌跡的最小值或最近點)捕捉車輛間的交互作用。

然而,基于相對距離的測量并不總是正確地捕捉駕駛員之間的交互。當智體之間存在物理約束時,距離較近的駕駛員可能非常弱或無交互作用,例如高速公路護欄或?qū)γ孳嚨赖姆指艟€。

4 認知模型

研究人員用相對距離來表征駕駛員風格,并揭示多智體之間的交互過程,例如,心理學理論和信息累積測度。從行為科學和心理學角度出發(fā),還開發(fā)了其他類型的交互模型來模擬人類的駕駛行為。

數(shù)據(jù)驅(qū)動的方法

與上述模型不同,該模型直接利用顯式傳感器信息來表征人類駕駛員之間的交互,另一種方法使用編碼的隱式信息來量化交互。此類隱式信息通常以低維標量或向量的形式出現(xiàn)(在圖模型中也稱為嵌入),分為三種編碼交互的方法。

1 深度神經(jīng)網(wǎng)絡

神經(jīng)網(wǎng)絡表示通過一系列基本層(例如,卷積和遞歸)將多個傳感器信息映射到低維向量特征,例如,在自動編碼器和生成對抗網(wǎng)絡(GAN)結(jié)構(gòu)中。此外,注意機制還可以集成到網(wǎng)絡中,模擬駕駛員之間的交互。

2 具有社會池化的圖神經(jīng)網(wǎng)絡

圖神經(jīng)網(wǎng)絡(GNN)與常規(guī)深度學習(嵌入結(jié)構(gòu)信息作為模型輸入的多層神經(jīng)網(wǎng)絡)有一些共同點。信息池化是一種靈活的工具,可根據(jù)深度神經(jīng)網(wǎng)絡和大量編程開源的優(yōu)勢,將時域空間和空域空間的智體之間關系抽象為低維可量化嵌入(例如,歸一化連續(xù)向量)。嵌入可以是時域相關的,捕獲演化圖(evolving graph)中節(jié)點和邊緣的時間信息。

因此,它們可以通過聚合操作來表征人類駕駛員之間的交互強度,例如平均聚合、加權聚合和圖演化消息(或圖消息傳遞)。此外,池化操作可以獨立或同時用不同的神經(jīng)網(wǎng)絡結(jié)構(gòu)將信息嵌入到時域和空域維度上的低維潛狀態(tài)中。前者通常首先應用時域模型(例如,LSTM)來獨立概括每個駕駛員隨時間變化的特征,然后用一個社會模型制定概括特征的交互,如convolutional social pooling。

能夠模擬車輛交互的編碼嵌入可以通過訓練GAN和自動編碼器獲得。盡管一些方法在標準基準測試中顯示了有希望的結(jié)果,但仍不清楚這些方法應該用什么信息來預測未來狀態(tài),以及如何用物理意義解釋這些嵌入。量化交互關系的另一種方法,是在序列觀測下采用某些圖邊緣的可學習權重,也稱為加權圖邊緣。這些“編碼器”的一個顯著特征是,它們很少或根本沒有提及學習的編碼信息的有效性和可解釋性。

3 拓撲模型

編碼駕駛員之間交互的另一個想法是使用拓撲編織(topological braids)的形式將其映射為二重代數(shù)和幾何性質(zhì)的緊湊表示。這種緊湊的拓撲表示有助于理解任何環(huán)境中與任何數(shù)量駕駛員的復雜交互行為。

對社會駕駛過程中的影響建模

交通場景中的顯式傳感器信息和其他駕駛員行為中的隱式社會推斷,使人類可以非常好地駕駛,從而進行安全的和社會可接受的操縱。人類的天性是,以社會偏好、社會模仿和社會推理等因素,賦予信息吸收和行為預期能力,這是社會兼容駕駛行為的核心。

對這些社會因素的定量評估需要計算認知科學和技術。

1 駕駛偏好的社會價值取向(SVO,Social Value Orientation)

人類駕駛員在與他人交互時會有各種社會偏好。社會偏好,如其他人類駕駛車輛的利他傾向,可以從計算心理學(如SVO)進行定量評估。SVO模型衡量了一個駕駛員如何將其獎勵相對其他智體的獎勵的加權,這可以從逆強化學習(IRL)結(jié)構(gòu)下的觀測軌跡中學習。然后,SVO模型的在線學習駕駛偏好,集成到兩輛或多輛的車輛協(xié)同交互的游戲場景中。SVO概念已被廣泛研究并應用于社會兼容的自主駕駛中。

2 社交驅(qū)動模仿的社會凝聚力

”人類駕駛員像綿羊一樣相互跟隨‘,共同作用對交通行為的影響非常強烈。因此,人類駕駛車輛的行為具有社會凝聚力——駕駛員會采取與周圍駕駛員類似的行動。例如,如果領頭車輛減速并采取輕微的“避碰”行為,自車駕駛員通常會采取類似的行動,在社交上假設可能存在虛擬障礙物(例如,圓錐體、動物身體、路面坑)。受人類駕駛員司社會凝聚力的啟發(fā),有人開發(fā)了一種凝聚增強的獎勵函數(shù),確定哪些方面(what aspects)、誰(who)、和何時(when)跟隨以保證安全,自動跟隨其他車輛。

3 現(xiàn)場-覺察的社會感知

人類可以主動收集并獲取有關環(huán)境的附加信息,創(chuàng)建相對完整的交通場景,從而提供足夠的信息并提高環(huán)境意識,從而進行安全高效的機動。例如,通過感知相鄰車輛的減速和停車行為,無論駕駛員的視線是否被遮擋,人類駕駛員可以推斷出潛在的行人通過道路。人類將其他駕駛員視為傳感器的能力已被設計并集成到自動駕駛車輛中,增強駕駛員的現(xiàn)場-覺察。

4 駕駛風格的社會交互風格

人類駕駛員通過評估和平衡未來不同的獎勵條款來制定規(guī)劃并采取行動。根據(jù)其內(nèi)部模型、駕駛?cè)蝿蘸蛣訖C,人類可能會格外關注不同的獎勵條件,通過這些條件,人類與周圍環(huán)境之間表現(xiàn)出不同的交互風格,如攻擊性、保守性、禮貌性、自私性和非理性。因此,交互樣式可以表示為在生成軌跡時不同特征的加權結(jié)果。例如,研究人員定量衡量這些社會因素誘發(fā)的交互風格作為獎勵特征。然后,用逆強化學習(IRL)從軌跡中學習此類特征的權重或排名目標函數(shù)。

如圖是人類駕駛員之間交互建模和學習的方法概述:包括基于理性效用的模型、基于深度神經(jīng)網(wǎng)絡的模型、基于圖模型、社會場和社會力以及計算認知模型。

基于理性效用的模型

日常交通中最常見的交互場景是城市環(huán)境和高速公路中的跟車、匯入/匯出和換道。研究人員將人類駕駛員視為最優(yōu)控制器,其具有可訪問的目標函數(shù),實現(xiàn)預定義的目標導向(goal-oriented)任務,制定這些場景中的行為。

例如,當在公路閘道上匯合時,將整個過程視為一個顯式動態(tài)系統(tǒng),可以將公路上后方車輛對前方車輛的縱向行為(如加速/減速)表示為一個最優(yōu)控制器。然而,自然交通場景中駕駛員或其他人之間的交互具有物理(例如,運動學和幾何)和社會(例如,意圖、注意和責任)約束。

通常,基于優(yōu)化的方法需要特定的目標(例如,車輛之間的期望間隙和車頭前進速度)和待優(yōu)化的目標函數(shù)。

本文沒有列舉所有基于優(yōu)化的方法,但選擇了一些流行的方法,包括基于swarm/flocking的模型、博弈論模型、模仿學習和馬爾可夫決策過程(MDP)。

基于swarms/flocks的方法

值得注意的是,在應用中Reynolds規(guī)則的大多數(shù)具體實例是基于牛頓運動定律傳播的動態(tài)模型。因此,這需要開發(fā)一套反映Reynolds定律的力分量全集,這些力分量(即內(nèi)聚、分離和對齊)與用于模擬行人交互的社會力理論各部分完全匹配。

Reynolds規(guī)則揭示了交互的基本機制,比基于社會力的理論更具普遍性。

盡管flocking啟發(fā)的規(guī)則成功地揭示了動物(如鳥類、魚類和羊群)之間的群體(swarm)交互機制,但它們只能在自由空間或有靜態(tài)障礙物的空間(如天空中的鳥類和海洋中的魚類)中很好地工作。

在交互式交通場景中,這些規(guī)則可能由于兩種類型約束而失效。

(i)交通環(huán)境的限制。flocks運動的空間有微弱的物理限制,甚至沒有物理限制,例如在開闊的天空和水下。相反,道路車輛的運動空間具有來自道路輪廓和交通基礎設施的許多約束。例如,車輛應在車道內(nèi)行駛,而不是在道路邊界內(nèi)行駛。

(ii)智體本身的約束。行人和flocks具有高度的運動,例如行人可以在不改變位置的情況下轉(zhuǎn)身。然而,人類駕駛員操作的車輛具有物理運動約束,例如車輛結(jié)構(gòu)導致的最大轉(zhuǎn)彎角和最小轉(zhuǎn)彎半徑。

總之,在真實道路交通中,采用flocks啟發(fā)的方法去捕捉人類駕駛員交互會帶來一些挑戰(zhàn):

1.交通規(guī)則:交通場景是結(jié)構(gòu)性的,因為交通標志和燈控制交通。人類駕駛員應該遵守許多交通規(guī)范和規(guī)則,以確保安全和效率,例如保持車輛在車道上。

2.個體異質(zhì)性:并非每個人類駕駛員都會嚴格遵守Reynolds規(guī)則的每一項;相反,人類駕駛員可能會根據(jù)他們的駕駛?cè)蝿照{(diào)整規(guī)則。例如,人類駕駛員的期望狀態(tài)可能因其駕駛風格而不同。此外,人類行為可能是隨機和時變的。因此,因為道路使用者的個體異質(zhì)性,很難完美地標定模型匹配所有個體的觀測值。

博弈方法

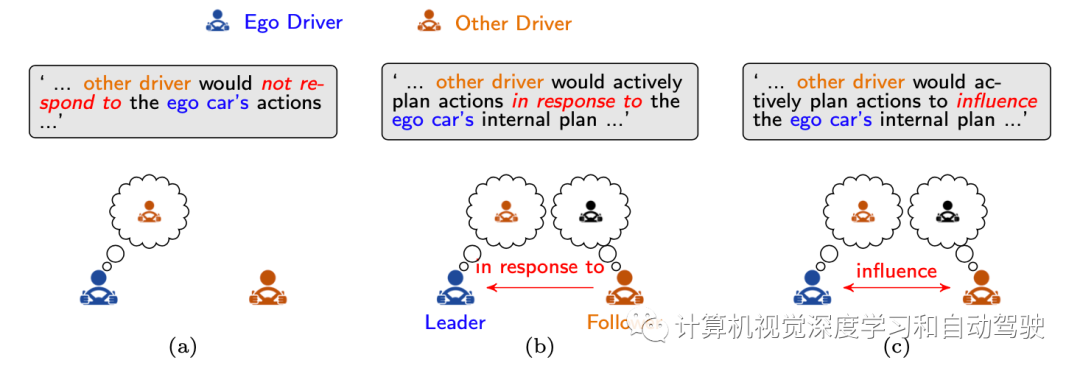

大多數(shù)最早的駕駛員交互博弈論模型關注矩陣博弈。目前,大多數(shù)人將交互行為轉(zhuǎn)化為迭代優(yōu)化問題,角色分配將影響模型性能。因此,動態(tài)博弈所需的第一個問題是“自車應如何在連續(xù)博弈的單個階段考慮其他駕駛員的影響和角色?”通常,這個問題有三種解決方案,如圖所示,將人類駕駛員視為(a)障礙,(b)理性追隨者,以及(c)相互依賴的參與者。

博弈論框架提供了一個可解釋的顯式解決方案來模擬人類駕駛員之間的動態(tài)交互。然而,盡管簡化系統(tǒng)動力學和信息結(jié)構(gòu)方面取得了一些進展,但仍難以滿足其在連續(xù)狀態(tài)-動作空間中計算易處理的實時約束。由于這些限制,大多數(shù)當前的博弈論交互建模方法都存在可擴展性問題,因此僅限于兩個車輛的設置和模擬實驗,或只是成對地處理多智體場景。

社會偏好是一種方法,將重復博弈的長期影響補償為單步博弈的獎勵。社會價值反映了智體在交互中的經(jīng)驗,可嵌入智體的效用(RL領域稱為獎勵,或控制理論領域稱為成本函數(shù))。

人類是有適應性的,通過與環(huán)境安全交互的獎勵-強化機制學習駕駛。受此啟發(fā),學習與其他駕駛員交互的過程,可以通過博弈論的強化學習來制定。除自車之外的智體可視為環(huán)境的一部分,會產(chǎn)生兩種交互建模的博弈方案。如圖所示:分為異步和同步。

?異步方案。每個駕駛員將其他周圍駕駛員視為環(huán)境的一部分,如圖(a)所示。異步方案下人類駕駛員之間的交互動力學可以用特定的博弈論方案實現(xiàn),如k-級博弈,其中人類駕駛員的行為以迭代方式預測,如圖(c),而不是同時評估。具體來說,為了獲得一個k-級智體的策略,所有其他智體的策略都設置為(k-1)-級 ,這有效地成為動態(tài)已知環(huán)境的一部分。因此,k-級智體的策略估計是對其他(k-1)級智體操作的最佳響應 ,如圖(b)所示。

?同步方案。在多駕駛員交互場景中,每個人類駕駛員都試圖通過類似試錯的過程同時解決順序決策問題。環(huán)境狀態(tài)的演變和每個人類駕駛員收到的獎勵函數(shù),是由所有駕駛員的聯(lián)合行動決定。因此,人類駕駛員需要考慮環(huán)境和其他人類駕駛員并與其交互。為此,同步方案可以通過馬爾可夫博弈,也被稱為隨機博弈,捕獲涉及多個人類駕駛員的決策過程。每個智體表示為基于MDP的智體,形成多智體強化學習(MARL)。

MARL算法的不同學習范式可以設計為不同交互任務的特定假設。從理論上講,學習范式可分為六組,如圖所示:(a)共享策略、(b)獨立策略和(c)組內(nèi)共享策略。(d) 一旦中央控制器控制所有駕駛員。(e) 集中訓練和分散執(zhí)行:在訓練期間,駕駛員可以隨時與任何其他駕駛員交換信息;在執(zhí)行過程中,駕駛員獨立操作。(f) 聯(lián)網(wǎng)駕駛員進行分散訓練:在訓練期間,駕駛員可以與網(wǎng)絡中的鄰居交換信息;在執(zhí)行過程中,駕駛員獨立操作。

單智體的MDP

另一個建模自車如何學習與他人交互的流水線是單智體MDPs方案。單智體MDP假設包含其他智體的環(huán)境是靜止的,因此可以通過馬爾可夫決策過程(MDP)來表示。自車在與環(huán)境交互時,動態(tài)展開交互軌跡,在考慮其行為影響的情況下,嘗試選擇最佳規(guī)劃,最大化相關獎勵。

從人類演示學習駕駛

以上討論的群優(yōu)化和博弈論方法都是前向設計。通過啟發(fā)式設置超參來解決優(yōu)化問題,而不是使用數(shù)據(jù)進行優(yōu)化。利用認知領悟分析場景,然后設計一個先驗已知的相關成本/目標函數(shù),模擬人類駕駛員之間的交互行為。

駕駛員之間社會交互背后的決策和運動,潛在機制是復雜的,難以編碼為簡單的手工編程規(guī)則。一般來說,演示交互行為要比指定生成相同行為的獎勵函數(shù)容易得多。這一事實為模擬和學習人類駕駛員的交互提供了另一種選擇:通過模仿學習直接從人類演示中學習交互行為。

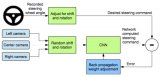

基于所學(行為軌跡或效用),有兩種方法:(i)行為克隆,其直接學習從觀測(例如,圖像)到動作(例如,轉(zhuǎn)向角和油門踏板)的映射;或(ii)效用恢復,它間接地使用數(shù)據(jù)來檢索獎勵函數(shù),計劃的交互行為盡可能地模仿演示。

行為克隆是模仿學習的最簡單形式,它專注于監(jiān)督學習去復制智體的策略。其主要優(yōu)點是簡單和高效。行為克隆旨在解決回歸問題,其中通過最大化目標函數(shù)(例如,在訓練數(shù)據(jù)中采取行動的可能性)或最小化損失(例如,模擬數(shù)據(jù)和真實數(shù)據(jù)之間的行為推導)來實現(xiàn)優(yōu)化。

行為克隆在為簡單的駕駛行為(如車道跟蹤和高速公路上的汽車跟隨)制定駕駛政策方面表現(xiàn)出了效率。行為克隆的成功依賴于能夠充分覆蓋訓練和測試數(shù)據(jù)集的狀態(tài)和活動空間的足夠數(shù)據(jù)。然而,行為克隆并沒有利用訓練過程中的級聯(lián)學習(cascaded learning)錯誤。假設數(shù)據(jù)獨立且相同分布(i.i.d.),測試過程中將出現(xiàn)級聯(lián)誤差。因此,行為克隆學習的模型在復雜的交互場景中通常表現(xiàn)不佳。

行為克隆旨在通過回歸技術直接復制專家的行為或軌跡。相反,IRL方法依賴于從觀察的交互行為/軌跡中檢索成本函數(shù),前提是獎勵函數(shù)在不同交通場景中最簡潔、穩(wěn)健和可轉(zhuǎn)移。這一假設與一個事實相吻合,即人類駕駛員可以從未見過的場景中與其他智體高效、安全地交互。

恢復智體之間的交互過程通常假設環(huán)境狀態(tài)本質(zhì)上具有馬爾可夫?qū)傩裕鋵W習任務模擬為馬爾可夫決策過程(MDP)。因此,人類駕駛員的交互過程通過參數(shù)化模型來描述,該模型參數(shù)可以通過優(yōu)化設計的目標函數(shù)來估計。直接的方法是使用標準MDP,其中其他人類駕駛員被視為環(huán)境的一部分。

在現(xiàn)實交通中,人類駕駛員的感知能力有限,無法準確感知所需信息;因此,可以使用部分可觀察的MDP(POMDP)對交互進行建模。在MDP結(jié)構(gòu)下,人類駕駛員的交互決策和控制被視為當前交通場景的最佳解決方案,通考慮短期內(nèi)可能的結(jié)果,最大化其回報(或最小化其成本)。這種假設允許逆最優(yōu)控制(IOC)或IRL學習人類駕駛員的交互過程。

請注意,IRL在模仿學習和博弈論模型中用作檢索獎勵的函數(shù),但發(fā)揮不同的作用。在模仿學習中,IRL旨在學習自車智體的獎勵函數(shù),模仿自車智體的駕駛行為。在博弈論模型中,IRL用于學習作為自車智體輸入的其他智體獎勵函數(shù)。

基于深度神經(jīng)網(wǎng)絡的方法

主要關注車輛狀態(tài)(例如,位置、速度、加速度和航向角)作為輸入的方法,同時考慮以下兩個方面。首先,直接處理原始傳感器數(shù)據(jù)的深度學習方法(例如,攝像機RGB圖像和3D激光雷達點云的卷積),通常遵循純端到端學習過程,導致弱和隱式交互推理。此外,這些工作的中心焦點通常不在于交互建模。第二,大多數(shù)現(xiàn)有的高質(zhì)量自主駕駛運動數(shù)據(jù)集16可以提供足夠和精確的代理狀態(tài)軌跡信息。

交互編碼

深度學習是一種強大的工具,具有良好的多智體交互建模潛力。如今,神經(jīng)網(wǎng)絡可能非常復雜。例如,用于自然語言處理(NLP)任務的大型模型GPT-3在其完整版本中有1750億個模型參數(shù)。

然而,基本上有四種類型的基本神經(jīng)網(wǎng)絡構(gòu)建塊(全連接層、卷積層、遞歸層和圖層),可以為特定應用開發(fā)復雜的網(wǎng)絡。不同的構(gòu)建塊在數(shù)據(jù)和解決方案空間上造成不同的歸納偏差。人們選擇不同的構(gòu)建塊將不同的歸納偏差注入學習過程獲得更好的性能,而不匹配的歸納偏差可能反過來導致次優(yōu)或較差的性能。

對于許多深度學習實踐者來說,這些模塊可能已經(jīng)是現(xiàn)成的,并且正在開發(fā)每個層更復雜的變型和操作。

社會交互的特征表征

時空狀態(tài)特征張量、空間占用網(wǎng)格和動態(tài)插入?yún)^(qū)域是與深度學習模型交互建模常用的三種特征表示。

1)狀態(tài)特征列表

假設N個智體對交通場景感興趣,并且其狀態(tài)特征是可測量的。將時間步t第i個智體的狀態(tài)特征表示為垂直向量x(i),如圖所示。

這種表示是有效的,是表示交互場景所需的最小信息量。然而,它有兩個局限性。首先,特征大小、車輛數(shù)量和每個車輛的有效時間步長T可能隨時間和空間變化,這對于期望恒定大小輸入的學習方法是有問題的。其次,這種類型的特征表示是置換可變的,即取決于交互智體列出的順序。例如,簡單地切換智體i和智體j的特征條目將導致不同的特征表示。避免這些限制的常用方法是使用占用網(wǎng)格圖如下。

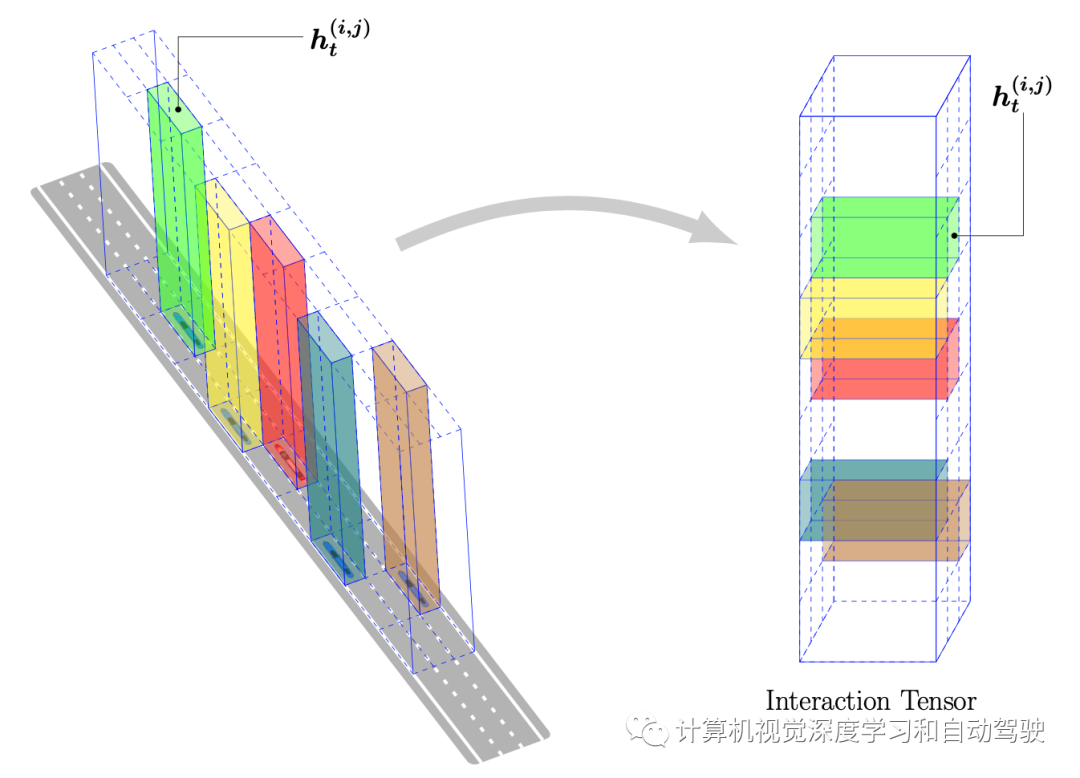

2)占用網(wǎng)格圖

占用網(wǎng)格圖定義了自車周圍(即以自車為中心)或特定固定區(qū)域(即以場景為中心)中的空間網(wǎng)格。占用網(wǎng)格圖可以處理感興趣區(qū)域(RoI)中不同數(shù)量的智體。占用網(wǎng)格圖可以通過填充原始狀態(tài)(例如,位置、速度、加速度)或編碼狀態(tài)(例如由全連接層輸出的隱藏狀態(tài))來表示交互場景。智體之間的空間關系自然地在網(wǎng)格圖布局中捕獲。此外,如圖所示,如果網(wǎng)格h(i,j)(由色條表示)由隱藏特征填充,這些隱藏特征的編碼獨立于每個車輛的τ時間步長歷史軌跡:

請注意,網(wǎng)格圖的形狀取決于場景。例如,網(wǎng)格圖可以是公路交互的矩形網(wǎng)格或環(huán)形交叉口的對數(shù)極坐標網(wǎng)格。空間網(wǎng)格表示是光柵大小和智體順序不變的,但反過來,由于張量的大小與覆蓋面積大小和網(wǎng)格分辨率相關,因此會受到精度-大小權衡的影響。

3)交互圖

另一種表示將駕駛場景中的實體表示為圖節(jié)點vi,并將實體之間的關系表示為圖邊緣ei。時間范圍T中的所有節(jié)點和邊緣,然后構(gòu)造時空交互圖G,該圖允許顯式交互和關系推理。

有兩種類型圖,在實體/節(jié)點的定義上有所不同。第一種是基于智體的圖,它將場景中的智體表示為節(jié)點。智體指道路參與者,如車輛、行人、摩托車。每個節(jié)點由每個智體的狀態(tài)特征或編碼特征表示。

基于智體的圖集中于表示智體,而另一個稱為基于區(qū)域的圖集中表示車輛的意圖。許多方法根據(jù)機動級別對駕駛意圖分類,如車道保持、車道變換和轉(zhuǎn)彎。然而,這些操作在駕駛場景中受到高度限制。例如,由于不同的道路拓撲結(jié)構(gòu),在高速公路或環(huán)島上的機動可能會非常不同。

為了使自動駕駛車輛在現(xiàn)實生活中經(jīng)過動態(tài)交互交通場景,需要對駕駛意圖進行統(tǒng)一和通用的定義。為此,一個有希望的表示是動態(tài)插入?yún)^(qū)域(DIA),即車輛可以插入的駕駛場景可用間隙。如圖所示,當從場景中提取DIA時,靜態(tài)元素(道路拓撲,如Frenet幀坐標、道路標記,如停車標志)和動態(tài)元素(如場景中的移動車輛)都會被利用。因此,DIA可以作為動態(tài)環(huán)境的統(tǒng)一表示,涵蓋所有道路設置上所有類型的駕駛意圖和交互。在形式上,時間步t的第i個DIA定義為Ati =(Xfront,Xrear,Xref),包括DIA所在的前邊界Xfront、后邊界Xrear和參考路徑Xref的信息。前邊界和后邊界由車輛或道路標記形成。然后,時間范圍T中的所有DIA可以構(gòu)造時空語義圖Gt,其中每個DIA用作圖的節(jié)點。

社會交互編碼

智體交互的編碼,采用以下幾種神經(jīng)網(wǎng)絡:全連接層、卷積層、遞推層和圖 層。

全連接層交互編碼的思想是,將來自不同智體的所有特征展平并連接到單個向量中,并饋送到全連接層中。理想情況下,智體之間的交互通過堆疊的全連接層之間的信息交換進行編碼和處理。然而,這些架構(gòu)中的交互建模通常被認為是非常弱和隱式的,因為缺乏數(shù)據(jù)結(jié)構(gòu)并在模型中造成歸納偏差。

對于神經(jīng)網(wǎng)絡來說,區(qū)分來自不同智體的特征可能具有挑戰(zhàn)性。此外,按不同順序排列智體導致不同的輸出,這可能是矛盾的,因為考慮的是相同的場景和智體。因此,但很少用于建模智體間交互。

卷積層交互編碼的思想是將時空特征(例如,狀態(tài)特征張量或占用網(wǎng)格圖饋送到卷積神經(jīng)網(wǎng)絡中,用于交互分析。

理想情況下,卷積交互編碼可以更好地利用智體之間的空間關系進行更深入的交互推理。然而,實際交互可以是局部、非局部和選擇性的,取決于具體的駕駛情況。因此,在空間網(wǎng)格上應用卷積運算是否能夠覆蓋足夠的交互信息和推理仍然是一個問題。

遞歸層交互編碼處理時域推理的交互編碼。

圖層交互編碼有望更好地處理多智體環(huán)境中的關系推理。通常,智體被表示為具有屬性的圖節(jié)點。智體之間的關系由節(jié)點之間的無向或有向邊緣表示。節(jié)點和邊緣一起構(gòu)成時空圖。然后,創(chuàng)建的圖被饋送到圖層中,用于消息傳遞中的交互學習,其中每個節(jié)點聚集其相鄰節(jié)點的特征更新其自身的節(jié)點屬性。這種圖層交互編碼具有兩個優(yōu)點:可變的智體數(shù)和置換不變性。

通過注意編碼社會交互

除了上面的神經(jīng)網(wǎng)絡層之外,另一種編碼主體之間社會交互的流行思想是注意——一種量化一個特征如何影響其他特征的機制,從而表示特征之間的關系。在實際交通中,人類在交互場景中駕駛車輛,有選擇性地計算其他交通智體的空間和時間影響。每個智體都應該關注歷史、現(xiàn)在和未來時間其他智體的駕駛行為。例如,一名駕駛員在高速公路上臨時改變車道時,會比其他車道上的車輛更加關注目標車道(target lane)的汽車。

那么,如何制定注意機制并設計注意模塊來捕捉這種影響呢?

在不損失一般性的情況下,一個簡單的想法是將每個實體矢量化,然后使用特定的功能度量來計算注意水平。以簡化的兩個智體交互場景(智體i和智體j是實體)為例,每個智體行為由獨立矢量化特征(分別表示為hi和hj)表征。如果功能測量輸出大的注意值,則智體i對智體j具有強大的影響。

根據(jù)最一般的定義,注意機制可以量化不同類型實體對時域空間(短期和長期)和空域空間(遠程和局部)的影響。以下有五種常用的實體表示:

- 時域注意

- 智體成對注意

- 基于空域網(wǎng)格的注意

- 基于DIA的注意

- 基于圖的注意

- 模型參數(shù)學習

在智體交互建模之后,需要一個訓練過程來使用數(shù)據(jù)標定模型參數(shù),這通常是通過基于梯度的優(yōu)化算法實現(xiàn)的。根據(jù)任務的目標,設計不同的損失函數(shù)反向傳播和調(diào)整模型參數(shù)。例如,對于駕駛行為預測任務,損失函數(shù)通常會使預測與真實情況之間的誤差最小化,而對于強化學習任務,損失函數(shù)會鼓勵智體獲得更高的回報。

此外,損失函數(shù)的設計還取決于模型輸出的表示。許多現(xiàn)有工作具有模型輸出確定性值,其中訓練過程被視為確定性回歸器。還有一些方法采用生成概率方法,輸出這些行為和意圖的概率分布,其訓練過程是一個概率最大化過程。

基于圖模型

日常交通場景中道路用戶之間的交互是結(jié)構(gòu)化的;它們隨著不確定性的時空動態(tài)變化,其中相互關聯(lián)的部分(例如,智體、道路線、障礙物)在交通規(guī)則和社會規(guī)范的約束下組織和演變。事實上,基于圖的模型為處理交互行為的復雜性和不確定性提供了一種自然工具。

圖模型提供了一個直觀的界面,研究人員可以通過該界面對高度交互的變量集和數(shù)據(jù)結(jié)構(gòu)進行建模。此外,基于圖的模型通常可以解釋為人類主體之間的結(jié)構(gòu)化關系。使用圖模型,能夠設想針對特定環(huán)境的新模型。例如,圖神經(jīng)網(wǎng)絡將其節(jié)點(頂點)指定為人類智體、實例或決策相關狀態(tài),并將節(jié)點之間的邊緣(弧)指定為交互,例如智體的速度和相對位置。

如圖提供了一個案例,以圖方式表示智體之間的交互關系,其中行為隨時間演變。

以下是三種基于圖的交通場景交互建模方法:圖神經(jīng)網(wǎng)絡、貝葉斯動態(tài)網(wǎng)絡和拓撲模型。

圖神經(jīng)網(wǎng)絡

用于交通智體交互的基于GNN模型,有不同的名稱,例如交互圖、智體圖、場景圖或交通圖。本文統(tǒng)稱為交互圖。

在該模型中,交互場景中的N個智體通常由具有N個智體節(jié)點(也稱為頂點)和N×N條邊緣的圖表示,這些邊緣表征它們之間的交互。交互圖可以具有一些節(jié)點屬性(例如人類駕駛員的狀態(tài))和邊緣屬性(例如,人類駕駛員之間的關系)。除了將人類智體視為圖節(jié)點外,其他特征,例如潛目標位置(例如,車輛之間的插入?yún)^(qū)域)也可以視為圖節(jié)點。

設計的圖結(jié)構(gòu)可以是靜態(tài)的或動態(tài)的。借助動態(tài)圖,模型可以利用圖關聯(lián)結(jié)構(gòu)的不同交互和不同的模型輸入。在創(chuàng)建高效的交互圖之前,應考慮一些相關問題,包括:

如何使交互圖能夠捕獲智體在空域和時時域的依賴關系?

如何使學習的交互圖可轉(zhuǎn)移?

如何使交互圖適用于交通中的異構(gòu)智體?

如何將環(huán)境信息整合到交互圖中?

如何使交互圖與任意數(shù)量的智體兼容?

貝葉斯動態(tài)模型

貝葉斯網(wǎng)絡是一種概率圖模型(PGM)。通常,PGM被用作一種標準圖工具,用于計算具有高度結(jié)構(gòu)的大概率分布。與基于GNN的交互模型不同,BNs的節(jié)點表示隨機變量(例如,具有噪聲或離散機動的智體狀態(tài)或傳感器信息),邊緣表示條件概率分布中節(jié)點之間的隨機因果關系。這些依存關系可以用有向無環(huán)圖進行示意性表示,依賴的結(jié)構(gòu)通常反映分層生成過程,類似于條件行為預測。普通BNs提供了一個概率圖架構(gòu),該架構(gòu)明確描述了單個時間片上智體之間的因果依賴關系,但不包括時間依賴關系,如圖(a)所示。

動態(tài)貝葉斯網(wǎng)絡(DBN)作為一種貝葉斯動態(tài)模型,是一種BN,包括節(jié)點的時間依賴性,簡單地說,隨著時間的推移重復普通BN的依賴性結(jié)構(gòu),如圖(b)所示。DBN節(jié)點在這些時間片上的某些依賴性通常被視為交互的時間動態(tài)。

作為一般框架,DBN適用于智體交互,建立描述不確定動態(tài)過程的概率模型。在應用中,DBN中的時間依賴性通常被實現(xiàn)為確定性遞歸過程(如RNN)或一階馬爾可夫過程(如狀態(tài)空間模型)。從這個角度來看,一些SSM和RNN可以被視為DBN的特殊情況。

在實際交通中,道路使用者的交互行為是非線性的、上下文相關的,并隨時間演化。觀察的傳感器狀態(tài),是其內(nèi)部模型(例如,潛/隱藏狀態(tài))的生成和實現(xiàn),通常是不可測量的。

基于BN的交互模型是一個強大的工具,可以以結(jié)構(gòu)明確的方式捕獲復雜的交互,包括物理約束、不可觀測狀態(tài)和觀測的不確定性。通常,使用DBN對交互進行建模可進行可靠的長期預測,因為其動態(tài)地考慮人類駕駛員的運動和決策之間的相互影響(或相關性)。

然而,模型性能在很大程度上取決于模型假設的正確性。例如,具有風險最小化假設的基于DBN模型,無法正確捕捉實際危險交通情況下的條件行為。另一方面,DBN的計算復雜度會隨著交互場景中涉及的智體數(shù)量的增加而呈指數(shù)增長。因此,目前DBN基于現(xiàn)有數(shù)據(jù)集進行離線評估和實驗室測試。

貝葉斯非參數(shù)動態(tài)網(wǎng)絡可以從多變量連續(xù)觀測中自動學習相關模式,而不需要模式數(shù)量的先驗知識。盡管貝葉斯非參數(shù)動態(tài)網(wǎng)絡能夠提取構(gòu)成連續(xù)行為的基本元素,但還不能直接揭示人類駕駛員在獎勵和行為方面的動態(tài)決策過程。這是因為他們的基本動態(tài)模型(如HMM、SSM)沒有考慮獎勵和動作。

拓撲模型

在交互場景中,人類是通用智體;人類行為解釋的機制是目的論(teleological)。此外,人們的決策受益于其構(gòu)建的心理表征,如拓撲結(jié)構(gòu),在復雜的交互中取得成功,有效地簡化了推理。因此,人類將其觀測抽象為高層嵌入,是不變、可共享和可重用的交叉交互場景和行為。那么,如何定義和查找這些嵌入?

盡管貝葉斯非參數(shù)動態(tài)網(wǎng)絡可以在低粒度提取基元來分析高維序列,但不能考慮多智體交互的行為和幾何結(jié)構(gòu)以及目的性推理。對于多智能體行為,自然會提出兩個基本問題:

是否有一種方法可以從代數(shù)和幾何上將任何復雜的、時空多智體交互行為編碼為緊湊表示?

是否有一種措施可以識別智體軌跡保持拓撲的變形?

拓撲模型為這兩個問題提供了初步解決方案,可以將結(jié)構(gòu)化信息轉(zhuǎn)化為抽象形式。經(jīng)常使用兩種拓撲模型:第一個問題的拓撲編織和第二個問題的拓撲學不變性(topological invariance)。

社會場和社會力

在模擬復雜(例如,環(huán)境、內(nèi)部和社會)運動激勵下的人類駕駛交互時,在感知道路邊界和人行道等交通環(huán)境時,必須考慮人類大腦中主動產(chǎn)生的虛擬力。另一方面,考慮其他人類駕駛員對社會駕駛規(guī)則的影響也同樣重要。例如,當人類駕駛員接近交叉口并在無保護情況下左轉(zhuǎn)時,看到一輛激進前行的車輛,駕駛員將在碰撞之前改變其決定。在這個過程中,前來的車輛不會向自車施加接觸力,但人類駕駛員的反應就像存在力一樣。這種不存在但可以直觀地描述和解釋社會交互的虛擬力是社會力模型。

此外,力是所有交互和運動的支配和統(tǒng)一因素,基于社會力的獎勵設計可以改善多機器人導航的交互性能。因此,可以合理地假設,與人類駕駛員相關的運動(例如,前移和轉(zhuǎn)向)由人類內(nèi)心產(chǎn)生的虛擬力(例如,內(nèi)部動機、期望速度和目的地)和外部約束(例如,交通管制、障礙物和運動智體)控制和驅(qū)動。

從場和勢的另一個角度來看,人類駕駛員跟隨車道并與其他車輛交互的根本原因是駕駛員將自己限制在交通環(huán)境和其他因素影響形成的場中。人類駕駛員通過平衡成本和回報來生成軌跡并采取行動,這導致以勢場(potential field)為特征的總效用。虛擬力迫使人類智體向較低的場值移動,類似于物理學中電場中的帶電粒子。在討論社會力時,相應積分如勢、場和能量等無法避開。

另一方面,如圖所示,人駕駛車輛的運動狀態(tài)(即速度和位置)是從隨時間變化的加速度得出的。因此,直接學習加速度可以捕捉到社會力的相同交互效應。

在物理學中,物理量(例如速度、溫度、電和磁)在特定空間區(qū)域中的分布稱為場(field)。類似地,交通相關量(如感興趣區(qū)域中的風險或安全水平)的分布被稱為風險或安全場,稱為安全旅行場(Safe Travel Field)。場論提供了一個統(tǒng)一的框架來描述環(huán)境約束和碰撞風險,從中可以實現(xiàn)移動機器人的次/最優(yōu)軌跡和運動規(guī)劃。人類駕駛員通過感知-動作環(huán)路與周圍環(huán)境交互:實時評估環(huán)境的風險水平,預測其他智體的運動,然后對動態(tài)環(huán)境產(chǎn)生反應。

社會場

場論是一個特殊的領域,它揭示在道路行駛時縱向和橫向車輛操作交互的潛在機制。相關構(gòu)造場也用于表示人類駕駛員與交通環(huán)境之間的交互。在多車輛交互交通場景中,現(xiàn)有研究采用了許多與場理論相關的不同術語,包括風險場/地圖或駕駛員風險場、駕駛風險勢場,人工勢場,事故風險成本,或駕駛安全場等。雖然使用的術語多種多樣,但它們有共同點:人為設計和基于風險信息。社會場分為三類:風險/安全場、潛在場和占用場。

安全行駛區(qū)域的特征在于預定義空間上風險值的標量,形成風險場。許多因素會影響風險水平。交通心理學認為,安全旅行場由三個子場組成:人類駕駛員場、其他人類駕駛員場和汽車場本身。然而,他們沒有考慮固定交通結(jié)構(gòu)(如道路邊緣和車道線)和交通控制(如停車標志和交通燈)的影響。

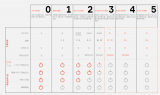

研究人員首先定性分析人類駕駛員在交互中的典型感知反應,然后設計具有相關約束的每個子場函數(shù)。如表1列出了每個子場公式的幾種常用核函數(shù),其中大多數(shù)是基于高斯的,因為可解釋和可微分。

除靜態(tài)障礙物和道路約束外,所有設計的子場都是動態(tài)的,并隨時間和空間變化。也有其他替代方法來模擬交互作用。例如,一個簡單的想法是使用純數(shù)據(jù)驅(qū)動的方法,如神經(jīng)網(wǎng)絡,但它們通常缺乏可解釋性。

在物理學中,電勢和場之間存在顯式和直觀的關系,例如電場和電勢,這里電場是電勢相對于距離微分的負數(shù)。與具有嚴格、客觀證明和驗證的物理定義勢不同,安全駕駛勢函數(shù)是啟發(fā)式,也是人工設計的,根據(jù)專家的見解和對人類駕駛行為的理解。

與風險場一樣,勢場是幾個獨立子勢場的聚合或加權和。然而,研究人員對勢場的定義有不同的看法。一些研究人員認為,移動和非移動目標都會影響勢場。

基于場論的方法固有的困難是參數(shù)估計。大多數(shù)研究人員根據(jù)他們對人-駕駛員互動的主觀定性判斷和評估確定了場參數(shù)。選擇最優(yōu)超參很繁瑣,這是一個NP- hard問題。雖然估計場參數(shù)似乎很難,但通過仔細設計特定駕駛行為的可計算場,已經(jīng)取得了一些有希望的進展。

一般來說,人類駕駛員之間的交互是復雜的,潛在和風險場的混合可以為特定實現(xiàn)的行為建模提供有效的解決方案。

社會力

這里不討論人類駕駛員與其他類道路使用者(即行人、騎自行車者和摩托車者)的交互;相反,只關心道路人類駕駛車輛之間的交互。

在自然交通場景中,復雜的傳感器激勵(即內(nèi)部、環(huán)境和社會)會帶來行為反應,該反應取決于人類駕駛員的目標(aims),并從一組行為備選方案中選擇使效用最大化。理性和有經(jīng)驗的人類駕駛員通常會根據(jù)其大腦習慣適應他們熟悉的情況;因此,駕駛員的反應是相對自動的,并由他們的經(jīng)驗決定哪種反應最好。

在這樣的觀點下,研究人員通過一個被稱為社會力的向量化,從數(shù)學上恢復了行為規(guī)則和人類主體之間的影響。人類主體和物理限制之間產(chǎn)生的社會力是導致行為變化的根源,通常由三種內(nèi)部、環(huán)境和社會激勵相對應的力組成:自驅(qū)動力、排斥力和吸引力。

這三類力來自行人或人群,基本上涵蓋了交通中交互駕駛行為的所有基本社會力。然而,由于行人和車輛之間的差異,有必要修改這些力,使其適合特定應用。例如,由于物理限制,對車輛加速度和角速度的限制必須比行人更嚴格。

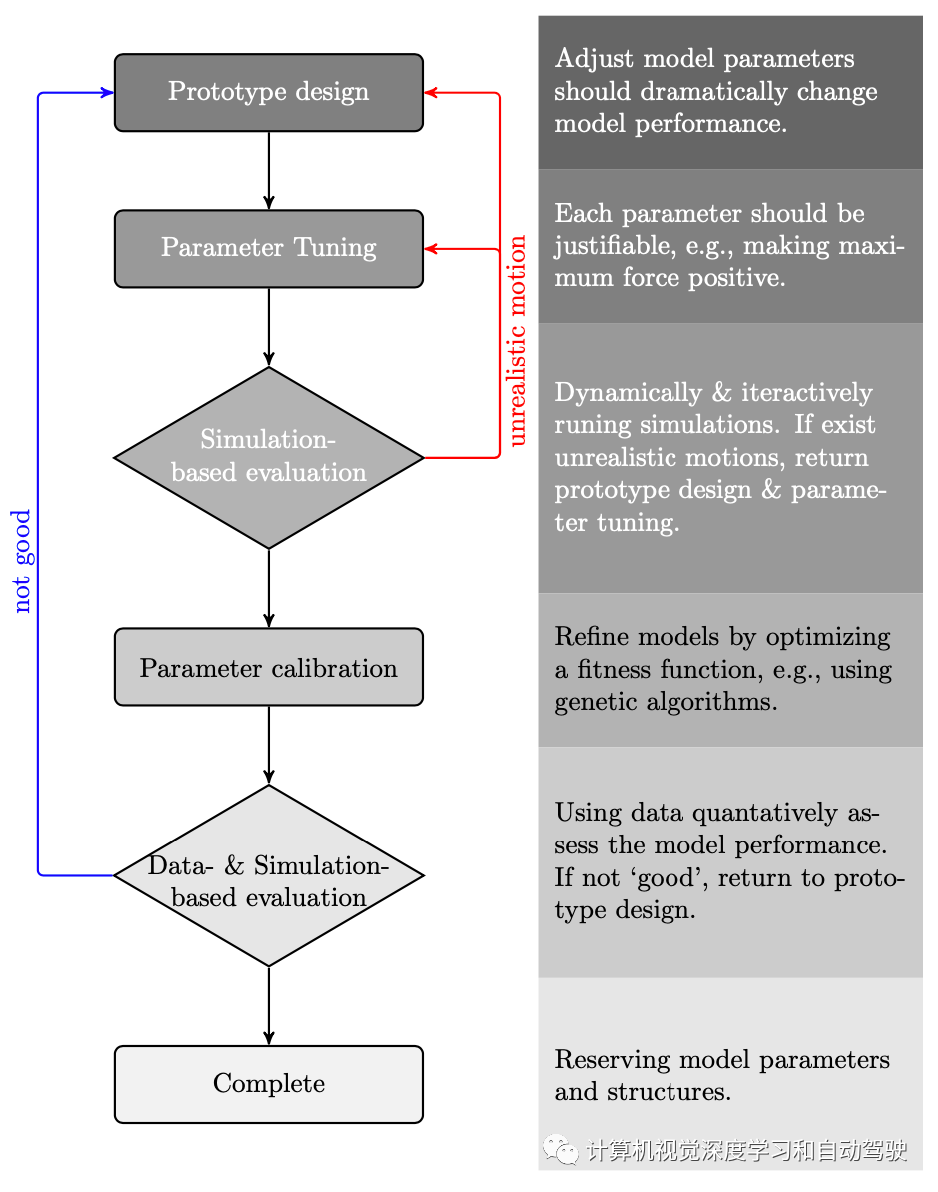

此外,社會力量允許將環(huán)境物理約束和交互行為的領域知識轉(zhuǎn)化為個人的動態(tài)模型。雖然簡單設計復雜的社會力模型聽起來很合理,但它通常不會像預期的那樣起作用。通用建模過程是一個循環(huán)和迭代過程,包括原型設計、參數(shù)調(diào)整、基于仿真的評估、參數(shù)標定以及基于數(shù)據(jù)和仿真的評估,如圖所示。

標定一個良好的社會力模型并非易事,因為(i)大多數(shù)模型參數(shù)沒有可直接測量的當前具體解釋-其中大多數(shù)是抽象意義,(ii)一個單一參數(shù)通常會影響駕駛行為的許多方面,盡管社會力模型被假設為幾個獨立的子力模型的組合,以及(iii)駕駛行為的特定方面由一個以上參數(shù)產(chǎn)生。

大多數(shù)現(xiàn)有的社會力模型在沒有具體解釋的情況下以啟發(fā)式和主觀方式標定模型參數(shù)。沒有唯一的標準方法來調(diào)整這些參數(shù)或使用數(shù)據(jù)驅(qū)動技術進行模型標定。幸運的是,存在一些方法來標定行人和車輛行人的社會力模型。

當使用數(shù)據(jù)驅(qū)動技術進行標定時,研究人員通常將模型參數(shù)分為兩類:可測量和不可測量。可測量參數(shù)可通過傳感器直接獲得,或通過統(tǒng)計數(shù)據(jù)分析和車輛的物理限制(如最大轉(zhuǎn)向角和加速度)進行標定。而對于不可測參數(shù),需要使用曲線擬合算法和遺傳算法非線性規(guī)劃。

受加速度和力之間關系的啟發(fā),直接學習加速度是產(chǎn)生社會力的一種替代方法,而不是通過場論估計智體之間受影響力。計算認知模型

認知機制是使人類駕駛員通過隱式通信安全有效地與其他理性主體交互的強大屬性之一。所有捕捉人類駕駛員交互的方法都有相關的行為基礎,并得到行為和心理行為認知的支持。因此,認知理解交互是設計有效交互建模方法的前提。解決認知科學前沿的基本問題,將是在社交道路上實現(xiàn)社會兼容自主駕駛的一個解決方案。

現(xiàn)有關于認知模型的研究大多集中于個體的駕駛行為,而不是主體之間的交互。它們特別適用于建模單個智體在較高級別和較低級別行為之間的關系。

在交互過程中,駕駛員需要主動和被動地感知其周圍的車輛,根據(jù)其先驗知識對其他車輛的當前行為以及自車預期的未來潛行為作出反應,并最終根據(jù)其對環(huán)境判斷的信念做出有效決策。受交互過程的啟發(fā),這里試圖從自車駕駛員的角度回答一些基本問題:

1.駕駛員會如何響應他人的行為?

2.駕駛員如何理解他人的行為?

3.駕駛員如何感知,即處理感知信息,去做出決策?

上述三個問題中的每一個都可以用一個特定的(但不是唯一的)認知理論來解釋。

激勵-響應

基于此,許多經(jīng)典的交互模型被開發(fā)來解釋人類駕駛員,例如經(jīng)典的跟車模型以及變道交互模型。激勵-響應交互歸類為簡單的社會交互(例如,跟車行為中的反應性交互)。

心理理論

人類是天生的讀心術;人類駕駛員天生就具有將自己置于其他駕駛員的位置并對其行為和意圖進行推理的能力。與人工機器不同,心智理論(ToM)描述了人類與其他人類主體交互能力的一個基本屬性,即人類可以對其他人類主體的心理狀態(tài)和行為進行推理。

一個經(jīng)典的認識是人類通過鏡像神經(jīng)元的能力,即將自己置于他人的位置的能力,能夠更好地與環(huán)境交互,并更有效地與同伴合作。例如,在高速公路上理性的人類駕駛員通常會留出空間,讓路給試圖合并的閘道車輛。

在交通心理學中,ToM廣泛指的是人類駕駛員在沒有明確溝通的情況下代表他人心理狀態(tài)的能力,包括他們的欲望、信念和意圖。

如圖(a)和(b)比較了ToM和IRL/RL的結(jié)構(gòu),并表明可以在IRL/RL結(jié)構(gòu)下指定ToM。藍色箭頭表示人類的心理狀態(tài)推斷(即在某些觀察行為下,推斷人類不可觀察的信念和愿望),這與IRL中的問題相對應(即,根據(jù)一些觀察策略執(zhí)行,推斷出智體的世界不可觀察模型和獎勵函數(shù))。此外,ToM可以將人類心理形式化,即給定觀察行為不可觀察變量(即信念、欲望和感知)的貝葉斯推理,這是行為的生成模型。

如表2還說明了ToM、IRL/RL和貝葉斯ToM的核心組件之間的聯(lián)系。

另一方面,ToM還提供了博弈論方法和假設,使它們在建模交互時計算上易于處理。

信息積累機制

漂移擴散模型(DDM)是一種具有擴散(Diffusion)信號的順序采樣模型。決策者積累證據(jù),直到達到上限或下限,然后停止并選擇對應于該邊界的備選方案。

一個典型的例子是在無信號環(huán)行交叉口匯入交通流時的決策過程。駕駛員在附路的環(huán)形交叉路口等待,直到目標“間隙”達到可接受程度。等待時間是駕駛員做出匯入風險決策的概率累積指標:等待時間越長,做出的風險決策就越大。許多現(xiàn)有的工作只關注駕駛員將做出什么決策,例如行為建模和預測,而較少關注該過程如何操作,以及隨著觀察到越來越多的信息去觸發(fā)決策。

請注意,為了揭示做決策時如何使用感知信息(即感知決策),行為科學中通常存在四種決策理論:理性模型、完善理性、證據(jù)累積和并行約束滿足模型。然而,到目前為止,只有證據(jù)積累被用于解釋交通場景中的人類駕駛行為。

討論

一些問題和可能的方向:

1 社會交互模型是真得社會覺察嗎?2 模型假設和數(shù)據(jù)集之間的移動3 認知科學能幫助自動駕駛車做到社會兼容?4 軌跡預測模型越精準就越好嗎?

總結(jié)一下:

道路交通的交互:什么角色?什么時候?

其中提到三種方法:潛在沖突檢查、RoI設置和面向任務的智體選擇。

基于潛在沖突的方法將低估交互,因為根據(jù)潛在沖突定義,例如智體之間的通行權。然而,駕駛過程中的一些社會交互并非源自潛在沖突,而是源自凝聚力。例如,一個好斗的司機會模仿他/她前車的行為,在十字路口面對黃燈時采取機會主義行動向前沖。

應該強調(diào)的是,潛在沖突的方法不會將其視為一種交互。如果假設占據(jù)RoI的所有智體都相互作用,則RoI方法可能會高估交互作用。在自然交通中,并非RoI中的所有智體都在交互網(wǎng)絡中激活;相反,人類駕駛員可能僅與某些智體直接交互。

此外,RoI的大小通常也難以配置,因為它與任務和環(huán)境相關。面向任務的智體選擇是模擬人類駕駛員如何交互的理想方法。然而,建立這種類型的模型具有挑戰(zhàn)性,因為交互過程的了解很少是先驗的。此外,人類在決策過程中的選擇性注意是動態(tài)和隨機的),這需要時域適應的模型。

基于理性效用的建模

理性人類駕駛行為是對動態(tài)環(huán)境做出響應的所有可能解決方案中“接近最優(yōu)”或“最優(yōu)”結(jié)果。這一觀察結(jié)果,能夠?qū)⑷伺c人之間的交互表述為一個可計算的優(yōu)化模型,最大化特定的目標。另一種流行的行為優(yōu)化方法是速度障礙(VO,velocity obstacles),用于模擬人類駕駛交互同時保證無碰撞,該方法已廣泛應用于多機器人領域。該方法成功地模擬異構(gòu)交通環(huán)境中的交互和交通軌跡的預測。

基于優(yōu)化的方法在分析上可以解釋,在數(shù)學上可以證明,包括不同的約束以避免碰撞。然而,對于具有滿意計算性能的在線應用程序來說,解決此類復雜優(yōu)化問題將是一個挑戰(zhàn)。

基于神經(jīng)網(wǎng)絡的建模

基于深度學習的方法提供了一種靈活的網(wǎng)絡架構(gòu),用于表示和學習交通智體之間的交互,得益于模塊化的層結(jié)構(gòu)和豐富的數(shù)據(jù)。基于深度學習的方法已經(jīng)通過許多與駕駛相關的挑戰(zhàn)、競賽和排行榜中占據(jù)領先地位而顯示出其力量和前景。未來,為了在真正的自主駕駛系統(tǒng)上安全地大規(guī)模部署,仍然存在許多挑戰(zhàn),例如(i)在保證性能的同時提高可解釋性,以及(ii)在各種駕駛實體、場景和情況下增強通用性。

基于圖的模型建模

人類駕駛員之間學習的時空交互可以將節(jié)點作為矢量化時空特征的圖模型來推理車輛關系。雖然GNN和帶有張量融合的社交池化可以方便地使用輔助信息以端到端的方式訓練網(wǎng)絡,但它們無法確保所需的物理或社會因素是否被實際捕獲和學習(即缺乏可解釋性)。

大多數(shù)用圖模型進行多智體行為和軌跡預測的工作,都是通過仔細采用這些預測來實現(xiàn)社會兼容自主車輛的安全路徑規(guī)劃和控制設計。然而,當其應用于人類駕駛-自主駕駛的混合環(huán)境時,在沒有自主智體的情況下,所導出的交互模型準確性是值得懷疑的,因為人類駕駛員可能對自動駕駛汽車有不同的行動。這些模型忽略自主系統(tǒng)對人類智體的影響。此外,GNN提供了直觀的理解,但在數(shù)量上并不精確,這不足以用于安全-緊要應用,如自動駕駛。

社會力和社會場的方法

借用物理學中場的概念(例如,電學理論中的電場或磁場)來創(chuàng)建一個驅(qū)動自身的虛擬場,一種在幾個方面與社會因素相結(jié)合、相當特殊的場。社會場和社會力提供了一個概念上統(tǒng)一的框架,解釋不同場景中的駕駛員行為,因此可以用于風險評估、最優(yōu)控制、行為預測和路徑規(guī)劃。

此外,它們還可以靈活利用其他交通因素。基于場論的模型通常是根據(jù)研究者對人類駕駛行為的主觀認知和理解,通過定量分析建立的。因此,可以利用許多因素,例如道路屬性(例如直線和曲線道路)、交通條件、車輛屬性(例如形狀和質(zhì)量)和人為因素(例如駕駛員的注意)。

理論上,基于場的模型可以處理復雜的場景,但僅在簡單的交互場景中得到驗證,例如,兩個智體之間的車輛跟隨和變道交互,這是由于大量的標定工作造成的。

生成場的元素更具選擇性。并非環(huán)境中的所有元素和智體(部分元素和智體)都對任務性能有顯著影響。這是因為主導運動和駕駛?cè)蝿盏南嚓P元素出現(xiàn),而非相關元素通常會遠離到背景中。

此外,根據(jù)兩個人在交互的角色,他們之間的影響可能是不對稱的。例如,周圍的車可能是領頭車、停放車、尾端車、匯入車等,它們對自車的潛在影響是不同的。每一類汽車可能共享相同的勢場,從而形成更緊湊的勢場模型。

安全旅行場本質(zhì)上是客觀或和主觀的表征。一些研究人員將駕駛風險場視為一個物理場,并聲稱這是一個客觀特征,不會隨個人的主觀意愿而變化。從“上帝的角度”來看,這可能是正確的——如果從鳥瞰的角度分析互動行為的話。

然而,如果從第一人稱角度分析自車的交互行為,并考慮社會因素,這個結(jié)論可能是錯誤的。該場是人類駕駛員主動和被動感知的風險場,反映了人類駕駛員在社會互動中的行為和反應,因此本質(zhì)上是一種主觀表征。

計算認知模型

計算認知為理解人類駕駛員之間社會交互中各種認知功能的本質(zhì)提供了新的視角。借鑒認知計算神經(jīng)科學的思想和發(fā)現(xiàn),一些工作解釋人類駕駛員在交互中的決策過程。

然而,一方面,現(xiàn)有方法通常提供過多的細節(jié),例如,描述低級神經(jīng)現(xiàn)象,使模型顯得過大。另一方面,有些方法過于簡單,在實踐中難以處理,例如,僅在實驗室環(huán)境中進行測試,缺乏復雜駕駛環(huán)境中的原則性調(diào)查,或提供決策的高級認知結(jié)構(gòu)。因此,在實時預測人類駕駛行為中實現(xiàn)這些機制的主要實驗室機制和實際應用之間存在著挑戰(zhàn)性的差距。

討論

很多交互模型未能調(diào)查對抗性魯棒性,沒有從社會理解的角度評估這些模型與社會行為的一致性。社會理解可以揭示當前模型的局限性,從而提供未來可能的方向。

在許多交通應用中,模型魯棒性仍然是一個核心問題。這可能是由設計模型和生成數(shù)據(jù)之間的不匹配造成的,包括兩個方面。

交互模型設計以目標為導向,但人類駕駛員產(chǎn)生的行為主要是習慣性的。這種行為最初是以目標為導向的,但后來在整個體驗中形成習慣。例如,一個新的駕駛員用一系列由教師制定的具體子目標來規(guī)劃行動。然后,駕駛員消化這些步驟并將其轉(zhuǎn)化為習慣,無需設定這些特定的子目標。基于習慣生成的數(shù)據(jù)集來訓練目標導向模型,可能會削弱模型的泛化能力。對于模型假設和數(shù)據(jù)之間的飄移,一種可能的解決方案可能是,制定基于模型和無模型的框架。

交互模型設計是社會導向的,但行為數(shù)據(jù)是通過物理交互和社會交互混合生成。在開發(fā)交互模型時,大多數(shù)工作直接建模其交互軌跡,例如使用圖神經(jīng)網(wǎng)絡(GNN),但忽略了對交互行為產(chǎn)生的原因和方式的洞察。反事實(Counterfactual)僅使用社會交互假設模型來近似社會和物理交互行為。

因此,深入了解相關數(shù)據(jù),為AI算法提供動力,可能是自動駕駛車輛具有社會兼容性和魯棒性的關鍵之一。

完美的自動駕駛需要超越路徑跟蹤、目標檢測和防撞的直覺心理。由于技術障礙和社會障礙,沒有直覺心理的自動汽車等路上無意識機器,與其他人類駕駛員共享道路空間還為時過早。

社會兼容的自動駕駛車輛應能夠發(fā)現(xiàn)其他人類智體的心理狀態(tài)和看法,與其他道路使用者進行安全和可接受的交互。換言之,最終目標是制造像理性的人類駕駛員一樣思考和學習的自動駕駛汽車。

然而,在他們學習的內(nèi)容和學習方式方面,真正類似人類的學習和思考能力超出了當前的工程動態(tài)。社會兼容的自主駕駛,迫使開發(fā)有效的工具,用結(jié)構(gòu)化計算認知模型的觀察來解釋和理解潛在的決策過程。

智體行為預測和推理已被公認為安全-緊要交互系統(tǒng)設計中不可或缺的一部分;例如,在人類環(huán)境中進行協(xié)商的自動駕駛車輛,需要在其規(guī)劃和決策中利用人類駕駛車輛的未來行為。

更多的工作熱衷于在復雜場景中對移動車輛進行更高精度的軌跡預測。在實踐中,需要仔細考慮“模型需要多精確才能成功交互”,而不是盲目追求軌跡預測的準確性,有必要考慮人類認知和行為的哪些方面對交互性能影響最大。

對于不同的實際任務,進行非常高精度的軌跡預測可能不會有利于整個交互性能,盡管它可能有利于低級控制器的設計。人類駕駛員的預測可能不如機器(例如,自動駕駛車輛)準確,但他們?nèi)阅苓M行有效的交互。

結(jié)論

了解人類駕駛員如何與他人交互是開發(fā)社會兼容自動駕駛車輛的一個核心問題。隨著自動駕駛車輛在社交道路上與其他人類智體的交互越來越緊密,有定量模型來預測這些交互行為變得越來越重要。

本文首先明確定義了道路交通中的社會交互。然后,它不可避免地對人類駕駛員和相關應用之間的交互作用進行了選擇性回顧,包括基于理性效用的模型、基于深度學習的模型、圖模型、社會場/力和計算認知模型。最后提出了關鍵的發(fā)現(xiàn)和開放的問題,這可以為自動駕駛車輛與人駕駛車輛的交互提供新的方向。

編輯:黃飛

電子發(fā)燒友App

電子發(fā)燒友App

評論