基于元學(xué)習(xí)的紅外弱小點(diǎn)狀目標(biāo)跟蹤算法

關(guān)注微信公眾號(hào):人工智能技術(shù)與咨詢。了解更多咨詢!

人工智能技術(shù)與咨詢 昨天

本文來(lái)自《激光技術(shù)》,作者熱孜亞·艾沙等

引言

紅外點(diǎn)狀目標(biāo)的跟蹤是紅外搜索和跟蹤(infrared search and track, IRST)系統(tǒng)中的關(guān)鍵技術(shù)之一[1],在紅外目標(biāo)跟蹤、遙感制圖等多個(gè)方面占據(jù)主要的位置[2]。在紅外背景的圖像中,目標(biāo)占據(jù)像素小、無(wú)具體的形狀、缺少紋理呈點(diǎn)狀[3-4], 在復(fù)雜的紅外背景下,跟蹤階段常常存有如目標(biāo)遮蔽、背景雜波、迅速移動(dòng)等困難,這些因素增加了紅外點(diǎn)狀目標(biāo)跟蹤的難度。目前所使用的大多數(shù)都是常規(guī)的一些手工設(shè)計(jì)的特征提取方法,使得傳統(tǒng)方法無(wú)法很好地用于紅外點(diǎn)狀目標(biāo)跟蹤。因此,在復(fù)雜背景下準(zhǔn)確地跟蹤紅外點(diǎn)狀目標(biāo)成為一項(xiàng)具有挑戰(zhàn)性的研究。

目前機(jī)器學(xué)習(xí)的算法被廣泛應(yīng)用于目標(biāo)跟蹤,通常需求大量的訓(xùn)練數(shù)據(jù)[5]。過度依賴于訓(xùn)練數(shù)據(jù)使得跟蹤模型存在以下問題:(1)需要耗費(fèi)大量人力進(jìn)行數(shù)據(jù)標(biāo)注,這給算法的計(jì)算帶來(lái)很多困難;(2)這種依賴大量訓(xùn)練數(shù)據(jù)的模型在訓(xùn)練數(shù)據(jù)上可以取得較小的誤差,但是在測(cè)試中遇到新狀態(tài)下的視頻序列時(shí)跟蹤性能比較差,無(wú)法精確跟蹤到目標(biāo)。機(jī)器學(xué)習(xí)的算法需要足夠的訓(xùn)練數(shù)據(jù),但紅外點(diǎn)狀目標(biāo)自身弱和小的特點(diǎn),而且在點(diǎn)狀目標(biāo)的跟蹤領(lǐng)域,公開的、大規(guī)模的點(diǎn)狀小目標(biāo)的視頻數(shù)據(jù)十分有限,由于沒有大數(shù)據(jù)的支撐,因而機(jī)器學(xué)習(xí)的算法不能直接用在紅外點(diǎn)狀目標(biāo)的跟蹤[6]。因此,如何根據(jù)紅外弱小點(diǎn)狀目標(biāo)的特點(diǎn),能夠讓模型盡量用少量的數(shù)據(jù),建立具有代表性的、結(jié)合深度學(xué)習(xí)的紅外點(diǎn)狀目標(biāo)跟蹤算法是一個(gè)很大的難題。

將機(jī)器學(xué)習(xí)的方法運(yùn)用在紅外點(diǎn)狀目標(biāo)跟蹤中,作者提出基于改進(jìn)的元學(xué)習(xí)紅外點(diǎn)狀目標(biāo)跟蹤算法,該算法使用靜態(tài)紅外圖像通過元學(xué)習(xí)的方法對(duì)卷積神經(jīng)網(wǎng)絡(luò)做離線訓(xùn)練,學(xué)習(xí)點(diǎn)狀目標(biāo)的通用特征表示,有效解決紅外點(diǎn)狀目標(biāo)訓(xùn)練數(shù)據(jù)不足的問題。其次將靜態(tài)紅外圖像傳入預(yù)訓(xùn)練的卷積神經(jīng)網(wǎng)絡(luò)中提取特征[7],將紅外點(diǎn)狀目標(biāo)跟蹤問題轉(zhuǎn)化為二元分類問題的判別模型,通過基于深度特征學(xué)習(xí)分類器來(lái)區(qū)分背景與前景信息。在跟蹤階段,依據(jù)點(diǎn)狀目標(biāo)的運(yùn)動(dòng)的特征,運(yùn)用基于運(yùn)動(dòng)模型的目標(biāo)位置預(yù)測(cè)的方法來(lái)除去后續(xù)的幀中非目標(biāo)點(diǎn)和噪聲點(diǎn)對(duì)跟蹤結(jié)果的影響,定位精確的目標(biāo)位置。結(jié)果表明,該實(shí)驗(yàn)方法能夠穩(wěn)定地、精確地跟蹤到紅外點(diǎn)狀目標(biāo)。

1.?? 相關(guān)工作

1.1?? 網(wǎng)絡(luò)結(jié)構(gòu)

牛津大學(xué)視覺幾何組(visual geometry group, VGG) 提出分類任務(wù)預(yù)訓(xùn)練網(wǎng)絡(luò)[8]。

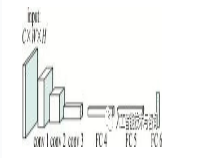

如圖 1所示,網(wǎng)絡(luò)模型包含3個(gè)卷積層(convolutional)conv 1~conv 3,3個(gè)全連接層(fully connected, FC)FC 4~FC 6。輸入圖像的大小為C×W×H,其中C為圖像的通道數(shù),W為圖像的寬度,H為圖像的高度。卷積層1有96個(gè)卷積核,卷積層2有256個(gè)卷積核,卷積層3有512個(gè)卷積核,其中卷積核的大小為3×3。兩個(gè)全連接層(FC 4,F(xiàn)C 5)分別有512個(gè)神經(jīng)元節(jié)點(diǎn)。首先通過網(wǎng)絡(luò)中的卷積層提取目標(biāo)的特征,其次將得到的特征作為全連接層的輸入,最后一層全連接層FC 6的輸出是二分類分支,判別目標(biāo)和背景。

Figure?1.? The architecture of VGG network

1.2?? 元學(xué)習(xí)

現(xiàn)存的大部分基于深度學(xué)習(xí)的方法都依賴于大規(guī)模的訓(xùn)練數(shù)據(jù),這要求人工標(biāo)注很多數(shù)據(jù)標(biāo)簽,這是極其浪費(fèi)時(shí)間的,使得只有少量標(biāo)注數(shù)據(jù)的任務(wù)難以進(jìn)一步發(fā)展,如紅外點(diǎn)狀目標(biāo)跟蹤。元學(xué)習(xí)是解決訓(xùn)練數(shù)據(jù)不足的有效方法。元學(xué)習(xí)的主要目的是使模型能夠用盡量少的訓(xùn)練數(shù)據(jù)獲得盡量大的泛化能力。

盡管元學(xué)習(xí)在如圖像分類等很多領(lǐng)域取得了不錯(cuò)的效果,但是基于元學(xué)習(xí)的單目標(biāo)跟蹤算法卻很少見。運(yùn)用元學(xué)習(xí)的離線訓(xùn)練和在線更新的方式,達(dá)到準(zhǔn)確地跟蹤點(diǎn)狀目標(biāo)。元學(xué)習(xí)又稱為學(xué)會(huì)學(xué)習(xí)[9-10]。基于優(yōu)化更新的元學(xué)習(xí)的主要思想是將跟蹤問題當(dāng)作二元分類問題。

使用初始幀數(shù)據(jù)(X1,?Y1)和網(wǎng)絡(luò)模型的參量θ,通過對(duì)損失函數(shù)Lθ經(jīng)過一次或少量幾次梯度下降得到模型f的參量θ*。采用隨機(jī)梯度下降的方法對(duì)參量進(jìn)行更新[11]:

|

θ?=θ?α?Lθ(X1,Y1)?θθ?=θ?α?Lθ(X1,Y1)?θ |

(1) |

式中,X1為初始幀圖像,Y1為X1所對(duì)應(yīng)的標(biāo)簽,θ為網(wǎng)絡(luò)模型的參量,α為學(xué)習(xí)率。

更新后的參量θ*滿足:

|

θ?=argminθ∑i=1nLθ(Xn,Yn)θ?=argminθ∑i=1nLθ(Xn,Yn) |

(2) |

式中,(Xn,?Yn)為后續(xù)幀的數(shù)據(jù),Xn為第n幀圖像,Yn為對(duì)應(yīng)的標(biāo)簽,Lθ(X,?Y)為損失函數(shù)。

將紅外點(diǎn)狀目標(biāo)跟蹤問題看作為二元分類問題的判別模型,其常用的損失函數(shù)為交叉熵?fù)p失:

|

L=?[YilnPi+(1?Yi)ln(1?Pi)]L=?[YilnPi+(1?Yi)ln(1?Pi)] |

(3) |

式中,Yi表示樣本i的標(biāo)簽,正樣本為1,負(fù)樣本為0,Pi表示樣本i預(yù)測(cè)為目標(biāo)的概率。

2.?? 本文中提出的算法

2.1?? 模型初始化

目前深度學(xué)習(xí)的算法被廣泛應(yīng)用于目標(biāo)跟蹤,通常需要大量的訓(xùn)練數(shù)據(jù)。由于紅外點(diǎn)狀小目標(biāo)視頻數(shù)據(jù)十分有限,因此運(yùn)用預(yù)訓(xùn)練跟蹤模型,將元學(xué)習(xí)運(yùn)用到卷積神經(jīng)網(wǎng)絡(luò)中,在共享域中使用包含紅外點(diǎn)狀目標(biāo)的靜態(tài)圖片對(duì)模型進(jìn)行離線的預(yù)訓(xùn)練,充分的表示點(diǎn)狀目標(biāo)的外觀特征,使得模型學(xué)習(xí)目標(biāo)的通用屬性,如時(shí)序性、空間特性等。本文中采用對(duì)VGG網(wǎng)絡(luò)模型進(jìn)行訓(xùn)練,來(lái)初始化跟蹤模型。

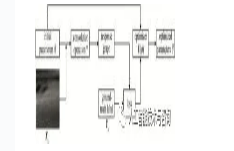

首先,隨機(jī)初始化網(wǎng)絡(luò)模型參量θ并將Xn輸入到VGG網(wǎng)絡(luò)中提取目標(biāo)特征f(Xn),利用網(wǎng)絡(luò)模型參量θ在f(Xn)上做卷積操作,得到目標(biāo)位置的響應(yīng)圖像,響應(yīng)圖像與真實(shí)標(biāo)簽Yn之間的差異來(lái)計(jì)算損失L,然后求得損失L對(duì)初始參量θ的導(dǎo)數(shù)并將其送到優(yōu)化網(wǎng)絡(luò)U(?)中,獲得更新后的參量θ*,訓(xùn)練過程如圖 2所示。

|

L=l(θ?f(Xn),Yn)L=l(θ?f(Xn),Yn) |

(4) |

|

l(S,Y)=ln[1+exp(?SY)]l(S,Y)=ln[1+exp(?SY)] |

(5) |

Figure?2.? Meta-learning training process

式中,l為分類損失函數(shù),*為卷積操作,S是響應(yīng)圖像,Y為訓(xùn)練數(shù)據(jù)的標(biāo)簽。

利用損失函數(shù)L來(lái)更新優(yōu)化器參量?與網(wǎng)絡(luò)模型參量θ,如下式所示[12]:

|

{??=??α?L?θ?=θ+U(?Lθ,??){??=??α?L?θ?=θ+U(?Lθ,??) |

(6) |

通過隨機(jī)梯度下降算法(stochastic gradient descent, SGD)[13]對(duì)網(wǎng)絡(luò)參量θ和優(yōu)化器參量?進(jìn)行優(yōu)化,得到更新后的網(wǎng)路模型參量θ*和優(yōu)化器參量?*,學(xué)習(xí)率α=0.0001,?Lθ?Lθ表示損失梯度,更新網(wǎng)絡(luò)U(·)為隨機(jī)梯度下降算法。

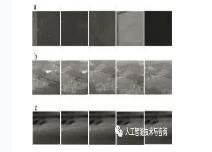

圖 3a為俯拍海面船舶的場(chǎng)景,受海面的反光,海面波浪等的影響。圖 3b為田野背景模糊小目標(biāo)紅外圖像序列,受到不同背景雜波的影響,如光照強(qiáng)度、樹木遮擋、形狀變化等。圖 3c為海天背景紅外圖像序列。由于高亮的云層的影響,目標(biāo)通常被淹沒在雜波中。圖像以“.jpg”格式存儲(chǔ),數(shù)據(jù)集獲取場(chǎng)景涵蓋了天空、海面等多種場(chǎng)景,背景相對(duì)復(fù)雜。

Figure?3.? Some examples of static data and dynamic video data in the pre-training stage

通過網(wǎng)絡(luò)的卷積層在離線訓(xùn)練階段學(xué)習(xí)包含紅外點(diǎn)狀目標(biāo)的靜態(tài)圖像中的通用屬性,如時(shí)序性、空間特性等。特定屬性是目標(biāo)在不同的紅外場(chǎng)景下所具有的明顯差異目標(biāo)特征的信息,通過初始幀中的目標(biāo)來(lái)學(xué)習(xí)目標(biāo)的特定表示,如尺度。

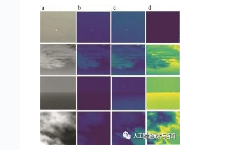

圖 4a是原圖,圖 4b是卷積層1,圖 4c是卷積層2,圖 4d是卷積層3的卷積層的特征可視化顯示的圖。從圖 4中可以看出,紅外點(diǎn)狀目標(biāo)占較小的像素,因此淺層特征更多地偏向于對(duì)圖像邊緣的信息,包含較多的位置信息和豐富的運(yùn)動(dòng)信息,同時(shí)會(huì)保留圖像更多的空間特性,這有利于目標(biāo)定位。隨著層數(shù)的加深,空間信息逐漸減少,從而影響分類器的定位精確度。

Figure?4.? Features of different layers extracted using VGG network

2.2?? 模型更新

在長(zhǎng)時(shí)目標(biāo)跟蹤過程中,跟蹤目標(biāo)的相關(guān)特性可能會(huì)發(fā)生變化,如目標(biāo)的形狀,目標(biāo)被遮擋,以及背景變化等。如果沒有根據(jù)目標(biāo)最新狀態(tài)進(jìn)行采樣來(lái)更新模型,會(huì)導(dǎo)致目標(biāo)跟蹤失敗。因此,為了適應(yīng)目標(biāo)在跟蹤過程中外觀的變化,避免跟蹤器產(chǎn)生漂移,更精確地跟蹤目標(biāo),因而根據(jù)跟蹤目標(biāo)和背景的變化來(lái)更新樣本和模型。

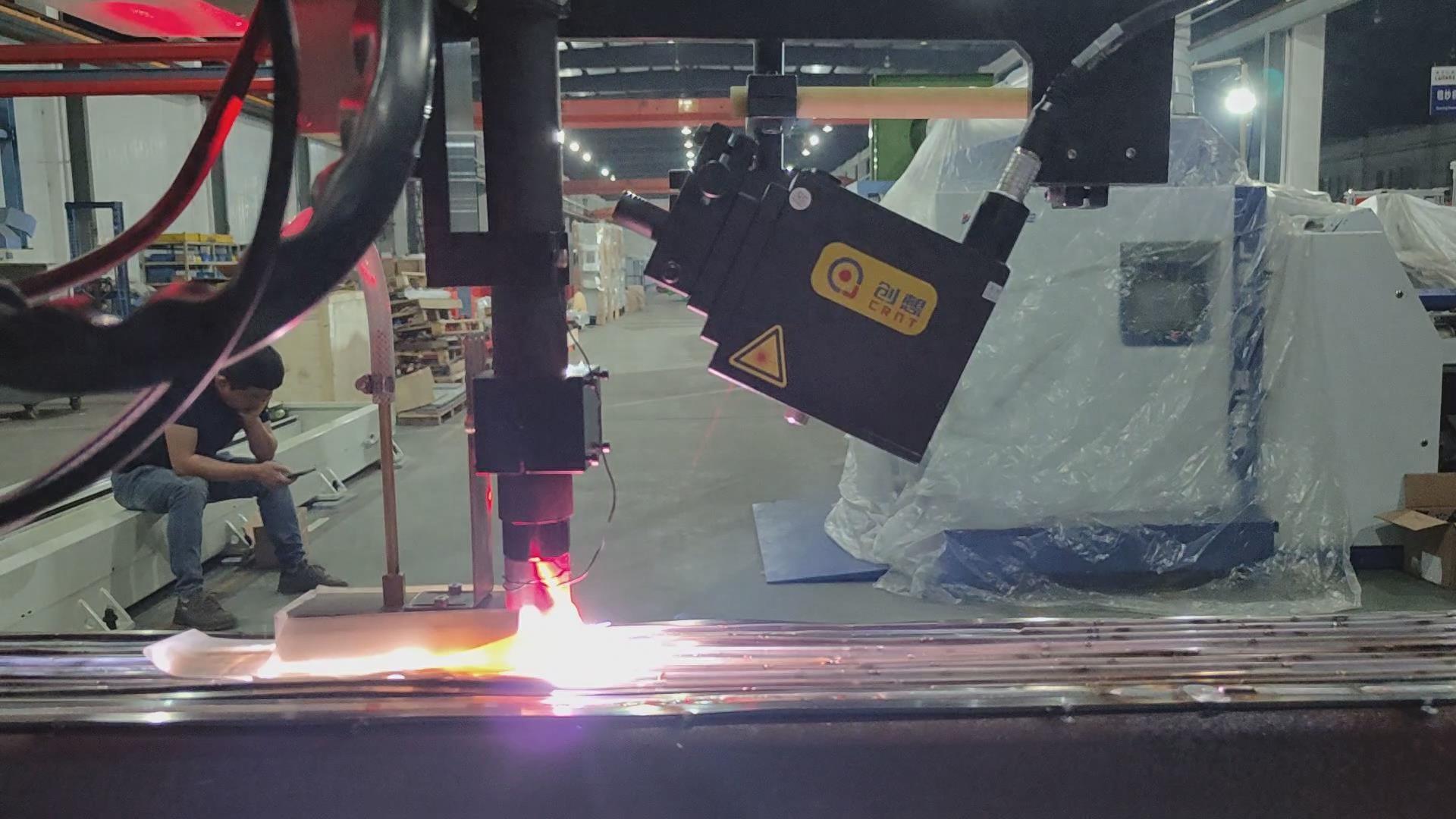

在后續(xù)幀中,當(dāng)?shù)?i>t幀候選樣本中前3幀的最大響應(yīng)值的平均值大于設(shè)定的閾值Tth,認(rèn)為當(dāng)前幀跟蹤結(jié)果可靠,則把R作為當(dāng)前幀中目標(biāo)的位置。若R小于閾值Tth(其中Tth=0.5為經(jīng)驗(yàn)值)時(shí),說(shuō)明目標(biāo)被遮擋,發(fā)生形變和光照變化,目標(biāo)和背景產(chǎn)生較大的變化(如圖 5所示),此時(shí)重新獲取當(dāng)前幀目標(biāo)信息,這時(shí)啟動(dòng)重檢測(cè),使用多尺度局部梯度強(qiáng)度評(píng)估算法[14]來(lái)檢測(cè)出當(dāng)前幀的目標(biāo)位置信息,當(dāng)檢測(cè)算法定位到目標(biāo)在當(dāng)前測(cè)試幀的位置時(shí),會(huì)按照模型初始化時(shí)的方式將檢測(cè)算法定位得到的目標(biāo)區(qū)域的基礎(chǔ)上采集樣本。通過檢測(cè)得到的目標(biāo)位置作為正樣本,其周圍區(qū)域作為負(fù)樣本來(lái)構(gòu)成樣本集合,將在線獲得的樣本作為訓(xùn)練數(shù)據(jù)來(lái)訓(xùn)練網(wǎng)絡(luò),對(duì)模型進(jìn)行訓(xùn)練更新,直到成功預(yù)測(cè)目標(biāo)位置。通過這種方式,使得模型能夠及時(shí)適應(yīng)目標(biāo)的外觀變化。

Figure?5.? The target is occlusion, deformation, back-ground clutter

給定視頻幀中第t幀的圖像,以t-1幀圖像中目標(biāo)的預(yù)測(cè)位置為中心獲得搜索區(qū)域圖像Xt,利用網(wǎng)絡(luò)獲得響應(yīng)圖像St:

|

St=θ??f(Xt)St=θ??f(Xt) |

(7) |

從St中通過響應(yīng)值最大的位置來(lái)估計(jì)出目標(biāo)所在的位置。

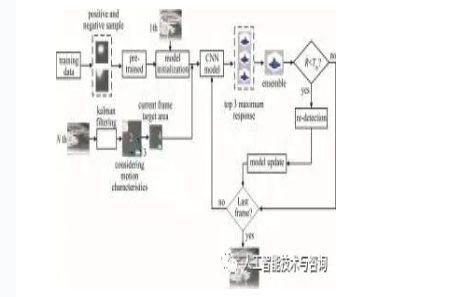

2.3?? 跟蹤模型

本文中算法以對(duì)卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural networks, CNN)進(jìn)行離線訓(xùn)練和在線模型更新相結(jié)合的方式對(duì)紅外點(diǎn)狀目標(biāo)進(jìn)行跟蹤。跟蹤過程的整體框架如圖 6所示。

Figure?6.? Flow chart of the entire algorithm

圖 6中,紫色的實(shí)線框1為初始幀給定的目標(biāo)區(qū)域,紅色的虛線框2為前一幀目標(biāo)區(qū)域,藍(lán)色虛線框3為待搜索區(qū)域,綠色實(shí)線框4為當(dāng)前幀目標(biāo)區(qū)域,藍(lán)色實(shí)線框5為最后一幀目標(biāo)區(qū)域。

當(dāng)前視頻幀將前一幀的目標(biāo)位置作為輸入,根據(jù)前一幀的目標(biāo)位置為中心,在它的周圍用多維高斯分布的形式進(jìn)行采樣,將采集的樣本輸入到模型中獲得輸出結(jié)果,輸出結(jié)果為輸入圖像塊的響應(yīng)值,取其中前3個(gè)具有最大響應(yīng)值的平均值的圖像塊位置作為預(yù)測(cè)目標(biāo)位置。如果將最大響應(yīng)值作為目標(biāo)位置,因測(cè)試和訓(xùn)練樣本之間的差異,背景變化等這些原因,響應(yīng)值最高的點(diǎn)不一定是最優(yōu)的目標(biāo)位置。因此,為了解決這個(gè)問題,本文中從多個(gè)響應(yīng)值中選擇前3個(gè)最高的響應(yīng)值,然后對(duì)它求平均值作為目標(biāo)的預(yù)測(cè)位置。

根據(jù)設(shè)定的閾值Tth來(lái)判斷目標(biāo)是否進(jìn)行重檢測(cè)。將取平均值后的響應(yīng)值R與設(shè)定的閾值Tth進(jìn)行比較,若R>Tth,認(rèn)為跟蹤準(zhǔn)確,則把R作為當(dāng)前幀中目標(biāo)的位置; 若R?Tth,那么認(rèn)為目標(biāo)發(fā)生了遮擋,本文中檢測(cè)方法使用多尺度局部梯度強(qiáng)度評(píng)估算法,再次檢測(cè)到目標(biāo)。通過檢測(cè)得到的目標(biāo)位置作為正樣本,其周圍區(qū)域作為負(fù)樣本組成一個(gè)小批量數(shù)據(jù),使用在線獲得的樣本作為訓(xùn)練數(shù)據(jù),對(duì)模型進(jìn)行更新。

在紅外視頻序列中,紅外點(diǎn)狀目標(biāo)在前后兩幀中的像素是相接近的,而且在相鄰的多幀圖像中,目標(biāo)位置信息有相關(guān)性,而背景雜波沒有這個(gè)特性。卡爾曼濾波根據(jù)前幾幀目標(biāo)狀態(tài)來(lái)預(yù)測(cè)當(dāng)前幀目標(biāo)可能的運(yùn)動(dòng)方向和運(yùn)動(dòng)速度。

當(dāng)目標(biāo)運(yùn)動(dòng)速度過快或者過慢時(shí),初步設(shè)定的以目標(biāo)區(qū)域大小的3倍的搜索框就不合理,在搜索框內(nèi)可能不存在目標(biāo),導(dǎo)致目標(biāo)的丟失。根據(jù)卡爾曼濾波預(yù)測(cè)的目標(biāo)運(yùn)動(dòng)速度自適應(yīng)調(diào)節(jié)搜索框的大小,根據(jù)預(yù)測(cè)的目標(biāo)運(yùn)動(dòng)方向把搜索框選擇在目標(biāo)可能存在的區(qū)域。因此在卡爾曼濾波預(yù)測(cè)的位置范圍內(nèi),用模型來(lái)確定最終的目標(biāo)位置。

在復(fù)雜的紅外背景下,目標(biāo)與背景的灰度差較小,當(dāng)目標(biāo)消失在雜波中或者重新出現(xiàn)時(shí),跟蹤算法會(huì)失去目標(biāo),采用重檢測(cè)使跟蹤算法發(fā)生跟蹤失敗時(shí),能夠讓跟蹤算法重新檢測(cè)到目標(biāo)是非常重要的。若逐幀都進(jìn)行重檢測(cè),那么計(jì)算量較大,因此通過閾值來(lái)判斷是否進(jìn)行重檢測(cè)。本文中檢測(cè)方法使用多尺度局部梯度強(qiáng)度評(píng)估算法,達(dá)到再次檢測(cè)到目標(biāo)的目的。首先計(jì)算前3幀的最大響應(yīng)值的平均值R。當(dāng)前3幀的最大響應(yīng)值的平均值R?Tth時(shí),認(rèn)為目標(biāo)發(fā)生了遮擋,需要進(jìn)行重檢測(cè); 當(dāng)R≥Tth時(shí),認(rèn)為跟蹤準(zhǔn)確,作為新的目標(biāo)位置。

|

Rˉ=Rt?1+Rt?2+Rt?33Rˉ=Rt?1+Rt?2+Rt?33 |

(8) |

式中,Tth=0.5為經(jīng)驗(yàn)值,Rt-1,?Rt-2,?Rt-3為前3幀的最大響應(yīng)值,R為平均響應(yīng)值。

3.?? 實(shí)驗(yàn)結(jié)果和分析

3.1?? 實(shí)驗(yàn)環(huán)境和數(shù)據(jù)集

為了測(cè)試本文中所提出算法的跟蹤性能,在不同的數(shù)據(jù)集上進(jìn)行了對(duì)比實(shí)驗(yàn)。這5幅紅外點(diǎn)狀圖像序列的詳細(xì)信息如表 1所示。本文中通過對(duì)具有不同背景的5幅紅外序列的數(shù)據(jù)集上對(duì)本文中提出的算法進(jìn)行了跟蹤對(duì)比實(shí)驗(yàn)。本文中所有的實(shí)驗(yàn)都是在一臺(tái)具有一個(gè)3.6GHz Intel Core i7 CPU、8G內(nèi)存的計(jì)算機(jī)上進(jìn)行的,并使用MatConvNet工具箱。

Table?1.? Data set for the test tracking

| databases | back-ground | image size | frame?numbers | target size/pixel(n×n) |

|---|---|---|---|---|

| seq.1 | sunny-sky | 256×200 | 30 | 8×8 |

| seq.2 | missile | 504×396 | 381 | 9×9 |

| seq.3 | could-sky 1 | 250×250 | 170 | 7×7 |

| seq.4 | sea-sky | 250×250 | 342 | 8×8 |

| seq.5 | could-sky 2 | 250×250 | 270 | 7×7 |

|?顯示表格

3.2?? 評(píng)價(jià)指標(biāo)

在本文實(shí)驗(yàn)中采用3個(gè)評(píng)價(jià)指標(biāo)來(lái)測(cè)試跟蹤算法的性能。

(1) 重疊率(intersection-over-union, IOU),它主要度量通過跟蹤算法估計(jì)的目標(biāo)位置框與目標(biāo)真實(shí)位置框之間的重疊部分[15]:

|

UIOU=A1∩A2A1∪A2UIOU=A1∩A2A1∪A2 |

(9) |

式中,A1為標(biāo)注的目標(biāo)框,A2為跟蹤的跟蹤框,∩為交集操作,∪為并集操作。

(2) 中心位置誤差(center location error, CLE),通過計(jì)算跟蹤框的中心位置之間的歐氏距離,ECLE的值越小,說(shuō)明該方法更加有效[16]:

|

ECLE=(x0?x1)2+(y0?y1)2??????????????????√ECLE=(x0?x1)2+(y0?y1)2 |

(10) |

式中,(x0,?y0)為目標(biāo)真實(shí)位置的中心坐標(biāo),(x1,?y1)為跟蹤到的目標(biāo)位置中心坐標(biāo)。

(3) 準(zhǔn)確率(precision plots,PRE),它的定義為:

|

EPRE=rsEPRE=rs |

(11) |

式中,s為紅外圖像序列總的幀數(shù),r為中心位置誤差的值小于閾值的圖像幀數(shù)[17]。比值越大,說(shuō)明該算法的跟蹤結(jié)果越準(zhǔn)確。

3.3?? 實(shí)驗(yàn)結(jié)果和分析

為了檢驗(yàn)本文中提出的算法跟蹤紅外點(diǎn)狀目標(biāo)的性能,選擇了中值光流算法[18]、在線學(xué)習(xí)及檢測(cè)(tracking learning detection, TLD)算法[19]、多實(shí)例學(xué)習(xí)(multiple instance learning, MIL)算法[20]等3種常規(guī)的跟蹤算法作為本文中算法的對(duì)比實(shí)驗(yàn)。本文中的實(shí)驗(yàn)是計(jì)算機(jī)環(huán)境Windows10,3.6GHz Intel Core i7 CPU、8G內(nèi)存,基于Python實(shí)現(xiàn)的。實(shí)驗(yàn)中采用的軟件開發(fā)平臺(tái)是Microsoft Visual Studio 2015,使用MatConvNet庫(kù)的MATLAB2014軟件。本文中的實(shí)驗(yàn)通過對(duì)具有不同背景的5幅紅外序列的數(shù)據(jù)集上對(duì)4種跟蹤算法進(jìn)行了跟蹤。

圖 7~圖 11中顯示了4個(gè)跟蹤算法在5個(gè)不同的紅外視頻序列上的跟蹤結(jié)果。綠色框表示目標(biāo)真實(shí)位置框(ground-truth, GT),紅色框通過本文中算法得到的跟蹤結(jié)果坐標(biāo)框,深藍(lán)色、橙色、紫色框依次分別是通過中值光流算法、TLD算法、MIL算法得到的跟蹤結(jié)果坐標(biāo)框。

Figure?7.? Representative visual results of four tracking algorithms on seq.1 dataset

Figure?8.? Representative visual results of four tracking algorithms on seq.2 dataset

Figure?9.? Representative visual results of four tracking algorithms on seq.3 dataset

Figure?10.? Representative visual results of four tracking algorithms on seq.4 dataset

Figure?11.? Representative visual results of four tracking algorithms on seq.5 dataset

在紅外視頻序列1中(如圖 7所示),在第1幀(如圖 7a所示),目標(biāo)與背景的灰度差較小,當(dāng)點(diǎn)狀目標(biāo)最先從云層中出現(xiàn)時(shí),TLD算法偏移較大,出現(xiàn)丟幀現(xiàn)象,失去了目標(biāo)。中值光流算法、MIL算法偏移較小。在第10幀(如圖 7b所示),中值光流算法偏移較大。從第20幀開始(如圖 7c所示),TLD算法和中值光流算法在不同的階段都失去了目標(biāo), 無(wú)法再次檢測(cè)到目標(biāo)。在信噪比較低的情況下,本文中算法能夠準(zhǔn)確跟蹤到目標(biāo)。

在紅外視頻序列2中(如圖 8所示),在第180幀(如圖 8b所示),中值光流算法、TLD算法和MIL算法偏移較大、失去了目標(biāo)。在第280幀(如圖 8c所示),MIL和中值光流算法都失去目標(biāo)。在第381幀(如圖 8d所示),中值光流算法、MIL算法、TLD算法失去了目標(biāo),無(wú)法恢復(fù)。本文中算法一直穩(wěn)定地跟蹤到目標(biāo),而其它3種算法跟蹤失敗,失去目標(biāo)。

在紅外視頻序列3中(如圖 9所示),在第1幀(如圖 9a所示),MIL算法發(fā)生微小的偏移。在第60幀(如圖 9b所示),MIL算法和TLD算法初始發(fā)生偏移,目標(biāo)并不處于跟蹤區(qū)域的中心。在第110幀(如圖 9c所示),紅外點(diǎn)狀目標(biāo)初步進(jìn)去云層中,這時(shí)中值光流算法、MIL算法中,目標(biāo)并不處于跟蹤區(qū)域的中心。在第170幀(如圖 9d所示), 目標(biāo)消失在云層被遮擋時(shí),背景與目標(biāo)之間的灰度差比較小并且紅外背景相對(duì)較復(fù)雜,中值光流算法失去了目標(biāo)。盡管是在復(fù)雜背景下,本文中算法依然能夠有效地準(zhǔn)確跟蹤到紅外點(diǎn)狀目標(biāo)。

在紅外視頻序列4中(如圖 10所示),在第140幀(如圖 10b所示),中值光流算法偏移變大,失去目標(biāo),無(wú)法再次檢測(cè)到目標(biāo),MIL算法偏移較小。在第240幀(如圖 7c所示),TLD算法、MIL算法跟蹤效果并不穩(wěn)定,而本文中算法一直穩(wěn)定地跟蹤到目標(biāo)。

在紅外視頻序列5中(如圖 11所示),在第100幀(如圖 11b所示),目標(biāo)重現(xiàn)在云層中出來(lái),目標(biāo)區(qū)域發(fā)生了變化,中值光流算法失去了目標(biāo),無(wú)法恢復(fù)。在第170幀(如圖 11c所示),目標(biāo)開始重新進(jìn)入云層中,TLD算法、MIL算法中的目標(biāo)并不在跟蹤區(qū)域的中心位置。在第270幀(如圖 11d所示),目標(biāo)消失在云層中被遮擋,MIL算法偏移較小,中值光流算法和TLD算法偏移較大,失去了目標(biāo),無(wú)法再次檢測(cè)到目標(biāo)。當(dāng)目標(biāo)從非云層區(qū)域移動(dòng)到云層區(qū)域時(shí),中值光流算法和TLD算法跟蹤失敗,MIL算法開始發(fā)生偏移,而本文中算法保持了較強(qiáng)的跟蹤性能。

綜上所述,通過對(duì)5幅圖像序列的對(duì)比,本文中提出的算法在不同的紅外場(chǎng)景下穩(wěn)定地跟蹤到目標(biāo)的同時(shí),還可以保證對(duì)整個(gè)視頻序列的準(zhǔn)確跟蹤,抗干擾能力較強(qiáng)。中值光流算法和TLD算法的跟蹤性能較差,對(duì)跟蹤過程常存在的如目標(biāo)遮擋、背景雜波和快速運(yùn)動(dòng)等問題解決較差。在突然變化的背景或背景雜波的環(huán)境中,本文中算法不僅準(zhǔn)確跟蹤到目標(biāo),而且跟蹤結(jié)果坐標(biāo)更加貼近真實(shí)目標(biāo)框。

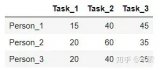

表 2顯示,將本文中算法與中值光流算法、TLD算法、MIL算法的跟蹤結(jié)果來(lái)評(píng)價(jià)算法的性能, 展現(xiàn)幾種跟蹤算法準(zhǔn)確跟蹤的幀數(shù)。其中occlusion表示目標(biāo)被遮擋的總幀數(shù)。實(shí)驗(yàn)表明,中值光流算法和TLD算法對(duì)目標(biāo)被局部遮擋的情況下跟蹤效果比較差,MIL算法有部分未跟蹤成功的情況,而本文中算法對(duì)整個(gè)視頻序列準(zhǔn)確跟蹤。

Table?2.? Number of successfully tracked frames(ours in comparison to medianflow, TLD, MIL results)

| sequence | frames | occlusion | medianflow | TLD | MIL | ours |

|---|---|---|---|---|---|---|

| sunny-sky | 30 | 10 | 10 | 1 | 25 | 30 |

| missile | 381 | 0 | 15 | 253 | 43 | 381 |

| could-sky 1 | 170 | 57 | 63 | 165 | 161 | 170 |

| sea-sky | 342 | 0 | 65 | 340 | 277 | 342 |

| could-sky 2 | 270 | 124 | 5 | 217 | 250 | 270 |

|?顯示表格

圖 12~圖 16是本文中提出的算法、中值光流算法、TLD算法、MIL算法等4種跟蹤算法在不同背景下的紅外圖像序列上的重疊率(IOU)、中心位置誤差圖(CLE)和基于中心位置誤差的精確度圖(PRE)。從圖 12~圖 16中清楚地看到,本文中算法的跟蹤結(jié)果受到的背景雜波和非目標(biāo)點(diǎn)的影響較小,表明該方法是比較有效的。還可以看出,與其它3種算法相比,本文中算法在不同背景下的性能都是較好的,這表明本文中算法具有更好的跟蹤性能。

Figure?12.? IOU, CLE, PRE plots of the four tracking algorithms on the seq. 1

Figure?13.? IOU, CLE, PRE plots of the four tracking algorithms on the seq.2

Figure?14.? IOU, CLE, PRE plots of the four tracking algorithms on the seq. 3

Figure?15.? IOU, CLE, PRE plots of the four tracking algorithms on the seq.4

Figure?16.? IOU, CLE, PRE plots of the four tracking algorithms on the seq.5

4.?? 結(jié)論

本文中把機(jī)器學(xué)習(xí)的方法運(yùn)用在紅外點(diǎn)狀目標(biāo)跟蹤中,使用元學(xué)習(xí)的線下訓(xùn)練,使得模型可以學(xué)習(xí)到跟蹤目標(biāo)的通用特征,有效解決了紅外點(diǎn)狀目標(biāo)訓(xùn)練數(shù)據(jù)不足的問題。此外,在長(zhǎng)時(shí)跟蹤過程中,目標(biāo)可能存在被遮擋、跟蹤可能會(huì)發(fā)生漂移等情況,從而丟失目標(biāo),因此,本文中提出重檢測(cè)機(jī)制,重新跟蹤到目標(biāo),實(shí)現(xiàn)穩(wěn)定跟蹤。與此同時(shí),通過卡爾曼濾波算法預(yù)測(cè)目標(biāo)運(yùn)動(dòng)模型,得到最優(yōu)的搜索區(qū)域。為了驗(yàn)證本文中算法的有效性,對(duì)不同背景下的紅外圖像序列上進(jìn)行測(cè)試,均表現(xiàn)出了良好的性能,實(shí)驗(yàn)結(jié)果表明了此方法的有效性。同時(shí),與現(xiàn)有方法進(jìn)行了比較,該算法優(yōu)于其它幾種紅外點(diǎn)狀目標(biāo)跟蹤算法。在后續(xù)的研究中,將在此基礎(chǔ)上,結(jié)合使用優(yōu)化算法來(lái)進(jìn)一步提高算法的實(shí)時(shí)性。

?【轉(zhuǎn)載聲明】轉(zhuǎn)載目的在于傳遞更多信息。如涉及作品版權(quán)和其它問題,請(qǐng)?jiān)?0日內(nèi)與本號(hào)聯(lián)系,我們將在第一時(shí)間刪除!

關(guān)注微信公眾號(hào):人工智能技術(shù)與咨詢。了解更多咨詢!

編輯:fqj

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論