對于深度學習本人也是半路出家. 現在的工作內容主要就是使用CNN做CV任務. 干調參這種活也有兩年時間了. 我的回答可能更多的還是側重工業應用, 技術上只限制在CNN這塊.

先說下我的觀點, 調參就是trial-and-error. 沒有其他捷徑可以走. 唯一的區別是有些人盲目的嘗試, 有些人思考后再嘗試.快速嘗試, 快速糾錯這是調參的關鍵.

◆ 首先說下可視化

我個人的理解, 對于可視化, 更多的還是幫助人類以自己熟悉的方式來觀察網絡. 因為, 你是不可能邊觀察網絡, 還邊調參的. 你只是訓練完成后(或者準確率到達一個階段后), 才能可視化. 在這之前, 網絡沒有學習到良好的參數, 你可視化了也沒意義, 網絡達到不錯的準確率了, 你看看其實也就聽個響. 同樣, 你的網絡訓練的一塌糊涂, 你可視化也沒什么意義, 唯一能夠看到的就是中間結果亂七八糟, 或者全黑全白, 這時候你直接看最后準確率就可以知道這網絡沒救了.

◆ 關于權重的可視化[Visualize Layer Weights](現在是否強求smooth其實意義不大, 這個后面說.)

同樣, 你看到一個不滿足平滑結果的圖像, 你知道, 這網絡訓練的不好, 但是為什么呢? 是數據不好? 沒有預處理? 網絡結構問題? Learning Rate太大或者太小? 或者就是差了一個LRN層(之前我就遇到, 加個LRN就能出smooth的weights, 當然這其實和預處理有關)?

Smooth是需要看一下的, 心里有個數. 但是具體調參怎么調是沒轍的. 第一, 你不可能告訴網絡, 這層你得學個邊界檢測的功能出來. 第二, 不同任務下會有不同的weights(雖然底層的特征有很大的通用性), 你覺得你憑什么來指導一個看圖片比你快得多的機器?

再說現在是否需要強求smooth. 現在的趨勢是鼓勵使用小filter, 3x3大小, 多加層次(這樣, 非線性更好點). 換句話說, 3x3的圖片, 總共才9個像素, 你怎么判斷smooth與否呢? 當然如果你使用大的filter, 一般5x5往上, 運氣不差的話, 你是可以看到smooth的結果的.

咱們再說另外一個極端, 一個網絡,運行的完美(滿足應用要求就算完美), 打開一看, 這weights不smooth啊. 你告訴我, 你打算怎么辦? 沒錯, 具有不平滑的權重的網絡同樣可以獲得很好的結果(這種情況我都習以為常了).

◆ 那么可視化網絡就不重要了?

非常重要, 但是不在訓練這塊, 而是幫助理解網絡的原理這塊. 理解網絡原理后, 你才能在設計結構的時候心里有感覺(只是有感覺而已), 網絡出了問題, 或者在某些情況下不滿意, 有更好的直覺去調整.(沒錯, 只是直覺, 雖然有些情況下的調整從網絡原理來看邏輯上應該可以工作, 但是人家就是不工作, 你能咬機器去么?)

◆ 那么怎樣訓練一個不錯的網絡呢?

這是一個很好的鏈接, 說明了如何從零開始不斷的trial-and-error(其實這里面沒遇到什么error):Using convolutional neural nets to detect facial keypoints tutorial

(鏈接網址:http://suo.im/533arJ)

對于調參我自己的經驗,有下面這些:

基本原則:快速試錯

一些大的注意事項:

★ 1. 剛開始,先上小規模數據,模型往大了放, 只要不爆顯存, 能用256個filter你就別用128個. 直接奔著過擬合去. 沒錯, 就是訓練過擬合網絡, 連測試集驗證集這些都可以不用.

為什么?

你要驗證自己的訓練腳本的流程對不對. 這一步小數據量, 生成速度快, 但是所有的腳本都是和未來大規模訓練一致的(除了少跑點循環)

如果小數據量下, 你這么粗暴的大網絡奔著過擬合去都沒效果. 那么, 你要開始反思自己了, 模型的輸入輸出是不是有問題? 要不要檢查自己的代碼(永遠不要懷疑工具庫, 除非你動過代碼)? 模型解決的問題定義是不是有問題? 你對應用場景的理解是不是有錯? 不要懷疑NN的能力, 不要懷疑NN的能力, 不要懷疑NN的能力. 就我們調參狗能遇到的問題, NN沒法擬合的, 這概率是有多小?

你可以不這么做, 但是等你數據準備了兩天, 結果發現有問題要重新生成的時候, 你這周時間就醬油了.

★ 2. Loss設計要合理.

一般來說分類就是Softmax, 回歸就是L2的loss. 但是要注意loss的錯誤范圍(主要是回歸), 你預測一個label是10000的值, 模型輸出0, 你算算這loss多大, 這還是單變量的情況下. 一般結果都是nan. 所以不僅僅輸入要做normalization, 輸出也要這么弄.

多任務情況下, 各loss想法限制在一個量級上, 或者最終限制在一個量級上, 初期可以著重一個任務的loss

★ 3. 觀察loss勝于觀察準確率

準確率雖然是評測指標, 但是訓練過程中還是要注意loss的. 你會發現有些情況下, 準確率是突變的, 原來一直是0, 可能保持上千迭代, 然后突然變1. 要是因為這個你提前中斷訓練了, 只有老天替你惋惜了. 而loss是不會有這么詭異的情況發生的, 畢竟優化目標是loss.

給NN一點時間, 要根據任務留給NN的學習一定空間. 不能說前面一段時間沒起色就不管了. 有些情況下就是前面一段時間看不出起色, 然后開始穩定學習.

★ 4. 確認分類網絡學習充分

分類網絡就是學習類別之間的界限. 你會發現, 網絡就是慢慢的從類別模糊到類別清晰的. 怎么發現? 看Softmax輸出的概率的分布. 如果是二分類, 你會發現, 剛開始的網絡預測都是在0.5上下, 很模糊. 隨著學習過程, 網絡預測會慢慢的移動到0,1這種極值附近. 所以, 如果你的網絡預測分布靠中間, 再學習學習.

★ 5. Learning Rate設置合理

太大: loss爆炸, 或者nan

太小: 半天loss沒反映(但是, LR需要降低的情況也是這樣, 這里可視化網絡中間結果, 不是weights, 有效果, 倆者可視化結果是不一樣的, 太小的話中間結果有點水波紋或者噪點的樣子, 因為filter學習太慢的原因, 試過就會知道很明顯)

需要進一步降低了: loss在當前LR下一路降了下來, 但是半天不再降了.

如果有個復雜點的任務, 剛開始, 是需要人肉盯著調LR的. 后面熟悉這個任務網絡學習的特性后, 可以扔一邊跑去了.

如果上面的Loss設計那塊你沒法合理, 初始情況下容易爆, 先上一個小LR保證不爆, 等loss降下來了, 再慢慢升LR, 之后當然還會慢慢再降LR, 雖然這很蛋疼.

LR在可以工作的最大值下往小收一收, 免得ReLU把神經元弄死了. 當然, 我是個心急的人, 總愛設個大點的.

★ 6. 對比訓練集和驗證集的loss

判斷過擬合, 訓練是否足夠, 是否需要early stop的依據, 這都是中規中矩的原則, 不多說了.

★ 7. 清楚receptive field的大小

CV的任務, context window是很重要的. 所以你對自己模型的receptive field的大小要心中有數. 這個對效果的影響還是很顯著的. 特別是用FCN, 大目標需要很大的receptive field. 不像有fully connection的網絡, 好歹有個fc兜底, 全局信息都有.

★ 簡短的注意事項:

1、預處理: -mean/std zero-center就夠了, PCA, 白化什么的都用不上. 我個人觀點, 反正CNN能學習encoder, PCA用不用其實關系不大, 大不了網絡里面自己學習出來一個.

2、shuffle, shuffle, shuffle.

3、網絡原理的理解最重要, CNN的conv這塊, 你得明白sobel算子的邊界檢測.

4、Dropout, Dropout, Dropout(不僅僅可以防止過擬合, 其實這相當于做人力成本最低的Ensemble, 當然, 訓練起來會比沒有Dropout的要慢一點, 同時網絡參數你最好相應加一點, 對, 這會再慢一點).

5、CNN更加適合訓練回答是否的問題, 如果任務比較復雜, 考慮先用分類任務訓練一個模型再finetune.

6、無腦用ReLU(CV領域).

7、無腦用3x3.

8、無腦用xavier.

9、LRN一類的, 其實可以不用. 不行可以再拿來試試看.

10、filter數量2^n.

11、多尺度的圖片輸入(或者網絡內部利用多尺度下的結果)有很好的提升效果.

12、第一層的filter, 數量不要太少. 否則根本學不出來(底層特征很重要).

13、sgd adam 這些選擇上, 看你個人選擇. 一般對網絡不是決定性的. 反正我無腦用sgd + momentum.

14、batch normalization我一直沒用, 雖然我知道這個很好, 我不用僅僅是因為我懶. 所以要鼓勵使用batch normalization.

15、不要完全相信論文里面的東西. 結構什么的覺得可能有效果, 可以拿去試試.

16、你有95%概率不會使用超過40層的模型.

17、shortcut的聯接是有作用的.

18、暴力調參最可取, 畢竟, 自己的生命最重要. 你調完這個模型說不定過兩天這模型就扔掉了.

19、機器, 機器, 機器.

20、Google的inception論文, 結構要好好看看.

21、一些傳統的方法, 要稍微了解了解. 我自己的程序就用過1x14的手寫filter, 寫過之后你看看inception里面的1x7, 7x1 就會會心一笑...

-

可視化

+關注

關注

1文章

1200瀏覽量

21034 -

深度學習

+關注

關注

73文章

5515瀏覽量

121551

發布評論請先 登錄

相關推薦

自制飛控板能用地面站軟件進行刷固件或者調參嗎?

ADRC的使用方法和調參大致的方向

PID調參的相關資料分享

針對PID調參進行詳細的講解

關于如何從零開始構建深度學習項目的詳細教程

深度學習和機器學習深度的不同之處 淺談深度學習的訓練和調參

什么是調參 CCP協議的實現原理

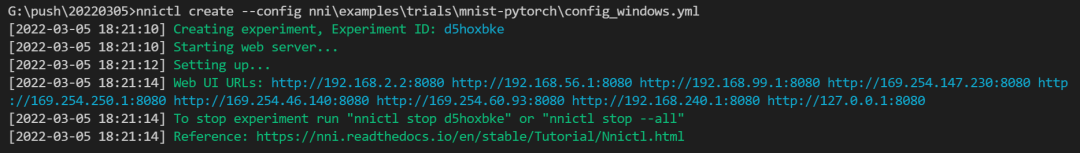

NNI:自動幫你做機器學習調參的神器

深度學習的調參經驗

深度學習的調參經驗

評論