來自 MIT CSAIL 的研究人員開發(fā)了一種精細(xì)程度遠(yuǎn)超傳統(tǒng)語義分割方法的「語義軟分割」技術(shù),連頭發(fā)都能清晰地在分割掩碼中呈現(xiàn)。在對比實(shí)驗(yàn)中,他們的結(jié)果遠(yuǎn)遠(yuǎn)優(yōu)于 PSPNet、Mask R-CNN、spectral matting 等基準(zhǔn)。這項(xiàng)技術(shù)對于電影行業(yè)的 CGI 技術(shù)具有重大意義,精細(xì)的分割掩碼能很好地分離圖像中的前景和背景,只要鼠標(biāo)一點(diǎn),就能輕易地改變前景、背景的種類。也就是說,像《變形金剛》《復(fù)仇者聯(lián)盟》《奇幻森林》中的大部分電影特效將可以完全自動化地生成。

隨著電影越來越關(guān)注 CGI,電影制作人必須更加擅長「合成」,即將前景和背景圖像融合,比如將演員放在飛機(jī)或行星上,或者放在電影《黑豹》里瓦坎達(dá)這樣的虛構(gòu)世界中。

讓這些圖像看起來真實(shí)并不容易。編輯必須捕捉前景和背景之間微妙的美學(xué)過渡,這對于頭發(fā)這種復(fù)雜精細(xì)的材料來說尤其困難,因?yàn)槿藗円呀?jīng)習(xí)慣了它的樣子。

麻省理工學(xué)院計(jì)算機(jī)科學(xué)與人工智能實(shí)驗(yàn)室(MIT CSAIL)的訪問研究員 Yagiz Aksoy 說:「這些圖像的棘手之處在于,并非每個(gè)像素都只屬于一個(gè)物體。很多情況下,你很難確定哪些像素屬于背景,哪些屬于特定的人。」

除了那些經(jīng)驗(yàn)最豐富的編輯,對其他人來說要把這些細(xì)節(jié)都處理好是一件乏味、耗時(shí)且非常困難的事情。但是在一篇新論文中,Aksoy 和他在 MIT CSAIL 的同事展示了一種方法,使用機(jī)器學(xué)習(xí)來自動化照片編輯過程中的多個(gè)步驟,并且稱這種方法也可用于運(yùn)動圖像。

該方法允許他們自動將輸入圖像分解成一組不同的層,這些層被層之間的一系列「軟過渡」分隔開。

該系統(tǒng)被稱為「語義軟分割」(semantic soft segmentation,SSS),它分析原始圖像的紋理和顏色,并將其與神經(jīng)網(wǎng)絡(luò)收集的圖像中物體的實(shí)際信息相結(jié)合。

Aksoy 說,「一旦計(jì)算出這些軟分割,用戶就不必手動改變過渡或?qū)D像特定層的外觀進(jìn)行單獨(dú)修改。」他上周在溫哥華的計(jì)算機(jī)圖形學(xué)會議 SIGGRAPH 上展示了這篇論文。「手動編輯任務(wù),如替換背景和調(diào)整顏色,將會變得更加容易。」

不過要說明的一點(diǎn)是,SSS 目前專注于靜態(tài)圖像。但是該團(tuán)隊(duì)表示,不久以后將它用于視頻也是可以的,這將推動其在電影制作中的應(yīng)用。

Aksoy 表示,該方法不需要專業(yè)編輯花幾分鐘時(shí)間逐個(gè)幀、逐個(gè)像素地調(diào)整圖像,而是使處理過程更簡單、快速,以便非專業(yè)用戶也可以更容易地進(jìn)行圖像編輯。他們期望,編輯只需點(diǎn)擊一下鼠標(biāo),就能組合圖像,創(chuàng)造那些成熟、真實(shí)的幻想世界。

他還表示,SSS 的目前版本可用于社交平臺,如 Instagram 和 Snapchat,以使其過濾器更加真實(shí),特別是用于改變自拍背景或模擬特定類型的相機(jī)時(shí)。未來,研究人員計(jì)劃將計(jì)算圖像所需時(shí)間從幾分鐘縮短到幾秒鐘,并通過提高系統(tǒng)匹配顏色和處理光照、陰影等問題的能力使圖像變得更加逼真。

論文:Semantic Soft Segmentation

論文鏈接:http://cfg.mit.edu/sites/cfg.mit.edu/files/sss_3.pdf

摘要:對圖像區(qū)域之間的軟過渡進(jìn)行準(zhǔn)確表征對于高品質(zhì)圖像編輯及合成至關(guān)重要。生成此類表征的現(xiàn)有技術(shù)很大程度上依賴于技術(shù)嫻熟的視覺藝術(shù)家,因?yàn)閳?zhí)行此類精確目標(biāo)選擇是一項(xiàng)繁冗的任務(wù)。本研究介紹了語義軟分割——一組與圖像中語義有意義的區(qū)域相對應(yīng)的層,它們在不同對象之間有準(zhǔn)確的軟過渡。我們利用光譜分割角度來處理這個(gè)問題,并提出了一種圖結(jié)構(gòu),其包含圖像的紋理和顏色特征以及神經(jīng)網(wǎng)絡(luò)生成的高級語義信息。軟分割是通過精心構(gòu)建的拉普拉斯矩陣的特征分解完全自動生成的。使用我們的語義軟分割,原本復(fù)雜的圖像編輯任務(wù)可以毫不費(fèi)力地完成。

圖 1:我們提出了一種方法,通過將高層次和低層次的圖像特征融合在一個(gè)圖結(jié)構(gòu)中來自動生成軟分割,即表示語義上有意義的區(qū)域以及它們之間軟過渡的層。語義軟分割使用為每個(gè)分割部分分配純色的方法實(shí)現(xiàn)可視化,它們可用作目標(biāo)圖像編輯任務(wù)的掩碼,所選圖層可在圖層顏色評估之后用于合成。原始圖像來自 [Lin et al. 2014](左上、右下)、Death to the Stock Photo(右上)、Y. Aksoy(左下)。

圖 2:對于輸入圖像,我們生成像素級的超維語義特征向量,并利用紋理和語義信息定義一張圖。構(gòu)建該圖的目的是使對應(yīng)的拉普拉斯矩陣及其特征向量能夠揭示語義對象和對象之間的軟過渡(soft transition)。我們使用特征向量創(chuàng)建初步的軟分割集,并結(jié)合它們獲取具備語義含義的分割。最后,我們細(xì)化軟分割,使之可用于目標(biāo)圖像編輯任務(wù)。圖源:[Lin et al. 2014],編輯結(jié)果的背景來自 Flickr 用戶 rumpleteaser。

圖 9、10:我們展示了我們的結(jié)果以及 Zhao et al. [2017] (PSPNet)、He et al. [2017] (Mask R-CNN) 和光譜摳圖(spectral matting)[Levin et al. 2008b] 的結(jié)果。分割結(jié)果在灰度圖像上重疊展示,方便圍繞分割邊界進(jìn)行更好的評估。注意:PSPNet 和 Mask R-CNN 在物體邊界方面不夠準(zhǔn)確,而光譜摳圖的軟分割結(jié)果超出了對象邊界。圖源:[Lin et al. 2014]。

圖 11:利用輸入圖像(a)和特征向量(b),我們的方法生成了 matte,見(c)。我們展示了具備不同未知區(qū)域?qū)挾鹊?trimap,它們通過 PSPNet [Zhao et al. 2017] (d) 或 Mask R-CNN [He et al. 2017] (e) 的語義分割方法生成,無法可靠地提供前景和背景區(qū)域,對使用信息流摳圖(information-flow matting)[Aksoy et al. 2017a] 生成的結(jié)果造成負(fù)面影響。在底部示例中,PSPNet trimap 是通過選擇與對象對應(yīng)的單個(gè)類別(左)或所有類別而生成的。我們還提供利用結(jié)果(f)生成的 trimap 的摳圖結(jié)果,展示了在給出準(zhǔn)確 trimap 的情況下?lián)笀D算法的性能。圖源: [Lin et al. 2014]。

方法

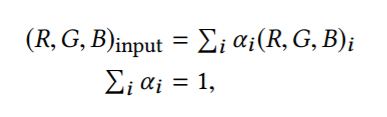

我們的目標(biāo)是從輸入圖像自動生成軟分割,也就是將場景中的目標(biāo)分解成多個(gè)層進(jìn)行表征,包括透明度和軟過渡。每個(gè)層的每個(gè)像素由一個(gè)不透明度α∈[0,1] 增強(qiáng),α=0 表示全透明,α=1 表示完全不透明,中間值表示部分不透明的程度。和該領(lǐng)域的其它研究(如 [Aksoy et al. 2017b; Singaraju and Vidal 2011])一樣,我們使用了一個(gè)加性的圖像構(gòu)造模型:

即我們將輸入的 RGB 像素表達(dá)為每個(gè)層 i 的像素之和,這些層由對應(yīng)的α值加權(quán)。我們還把每個(gè)像素的多個(gè)α值的和限制為 1,以表示完整的不透明輸入圖像。

我們的方法使用了與光譜摳圖相同的形式,也就是將軟分割任務(wù)形式化為特征值估計(jì)問題 [Levin et al. 2008b]。該方法的核心是構(gòu)建拉普拉斯矩陣 L 來表征圖像中每對像素屬于同一個(gè)分割的可能性。盡管光譜摳圖僅使用了低級局部顏色信息來構(gòu)建矩陣,我們描述了如何通過非局部線索和高級語義信息來增強(qiáng)這一方法。原始的方法也描述了如何利用稀疏化來從 L 的特征值來創(chuàng)建層,我們的研究表明,該原始技術(shù)的放寬限制的版本可以獲得更佳的結(jié)果。圖 2 展示了我們的方法的概覽。

圖 5:輸入圖像(a)、語義特征(b),與對應(yīng)本文提出的拉普拉斯矩陣(c,頂行)以及(光譜摳圖中使用的)摳圖拉普拉斯矩陣(d,底行)的最小特征值的幾個(gè)特征向量。綠色表示特征向量的正值,紅色表示負(fù)值。我們的拉普拉斯矩陣很清晰地揭示了特征向量中的語義邊界,而摳圖拉普拉斯矩陣的特征向量延伸到了語義邊界之外,如圖虛線框中所示。圖源:[Lin et al. 2014]。

圖 6:輸入圖像(a),像素級稀疏化之前的軟分割結(jié)果(b),像素級稀疏化之后的軟分割結(jié)果(c)。顏色編碼的分割部分使用單個(gè)阿爾法通道來展示,阿爾法通道對應(yīng)前景物體。最后一步清理因特征向量表達(dá)能力有限而造成的雜亂阿爾法值,同時(shí)維持軟過渡。底部示例展示了使用常數(shù) 0.9 作為稀疏化參數(shù) γ 的稀疏化結(jié)果(d),而我們使用空間變化的 γ_p 在過渡區(qū)域進(jìn)行松弛的稀疏化操作。其效果見嵌套小圖,我們的結(jié)果(c)保持了頭發(fā)周圍的軟過渡,而常數(shù)變量(d)導(dǎo)致了過度稀疏的結(jié)果。圖源:[Lin et al. 2014]。

圖 7:輸入圖像和計(jì)算出的語義特征(左),具備很多層的初始估計(jì)軟分割(中),grouping 后的中間軟分割結(jié)果(右)。通過為每個(gè)分割部分指定一個(gè)純色來可視化軟分割結(jié)果。注意這些結(jié)果會隨著松弛的稀疏化(relaxed sparsification)進(jìn)行進(jìn)一步細(xì)化。

-

人工智能

+關(guān)注

關(guān)注

1796文章

47666瀏覽量

240287 -

MIT

+關(guān)注

關(guān)注

3文章

253瀏覽量

23501

原文標(biāo)題:MIT提出精細(xì)到頭發(fā)絲的語義分割技術(shù),打造效果驚艷的特效電影

文章出處:【微信號:CAAI-1981,微信公眾號:中國人工智能學(xué)會】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

ZN-S8模塊式柔性自動化生產(chǎn)線實(shí)訓(xùn)系統(tǒng)有哪些技術(shù)指標(biāo)

模塊式柔性自動化生產(chǎn)線實(shí)訓(xùn)系統(tǒng)是什么

含有析取語義循環(huán)的不變式生成改進(jìn)方法

聚焦語義分割任務(wù),如何用卷積神經(jīng)網(wǎng)絡(luò)處理語義圖像分割?

用圖卷積網(wǎng)絡(luò)解決語義分割問題

語義分割算法系統(tǒng)介紹

分析總結(jié)基于深度神經(jīng)網(wǎng)絡(luò)的圖像語義分割方法

一種具有語義區(qū)域風(fēng)格約束的圖像生成框架

基于圖像語義分割的毛筆筆觸實(shí)時(shí)生成技術(shù)

普通視覺Transformer(ViT)用于語義分割的能力

語義分割標(biāo)注:從認(rèn)知到實(shí)踐

基于SAM設(shè)計(jì)的自動化遙感圖像實(shí)例分割方法

MIT提出語義分割技術(shù),電影特效自動化生成

MIT提出語義分割技術(shù),電影特效自動化生成

評論