編者按:多層神經網絡在多種基準任務上都有了顯著成果,例如文本、語音和圖像處理。盡管如此,這些深層神經網絡會導致高維非線性的參數空間,讓搜索難以進行,并且還會導致過度擬合和較差的泛化。早期由于數據不足、無法恢復梯度損失以及不良局部最小值而引起的高捕捉概率,讓使用反向傳播的神經網絡很容易失敗。

2006年,Hinton的深度學習提出了一些創新的方法以減少這些過度擬合和過度參數化的問題,包括減少連續梯度損失的ReLU和Dropout等。在這篇文章中,美國羅格斯大學的兩位研究者將關注深層網絡的過度參數化問題,盡管現在各項分類任務都有大量可用的數據。本文已提交到NIPS 2018,以下是論智對原文的大致編譯,如有錯誤請批評指正。

Dropout是用來減輕過度參數化、深度學習的過擬合以及避免偶然出現的不良局部最小值。具體說來,Dropout在每次更新時會添加一個帶有概率p的Bernoulli隨機變量、刪除隱藏的單元以及網絡中的連接,從而創造一個稀疏的網絡架構。學習結束后,深度學習網絡會通過計算每個權重的期望值進行重組。大多數案例證明,深度學習的Dropout能將常見基準的錯誤減少50%以上。

在這篇論文中,我們將介紹一種通用的Dropout類型,它可以在權重層面操作,在每次更新中插入梯度相關的噪音,稱為隨機Delta規則(SDR)。SDR是在每個權重上執行一個隨機變量,并對隨機變量中的每個參數提供更新之后的規則。雖然SDR在任意隨機變量下都能工作,但是我們將展示,Dropout在擁有二項式隨機變量中的固定參數下是非常特別的。最終我們在含有高斯SDR的標準基準下測試DenseNet,結果證明二項式Dropout有著非常大的優勢。

隨機delta規則(SDR)

眾所周知,神經傳輸會包含噪聲。如果皮質分離的神經元受到周期性、相同的刺激,將會產生不同的反應。SDR的部分motivation是基于生命系統中信號在神經元之間傳播的隨機性。顯然,平滑的神經速率函數是基于很多刺激實驗得來的平均值,這使得我們認為兩個神經元之間的突觸可以用一個具有固定參數的分布建模。

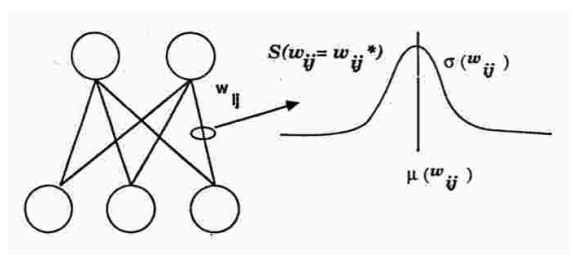

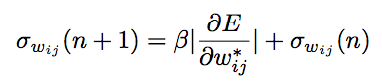

圖1顯示了我們用一個高斯隨機變量和平均μwij以及σwij實施的SDR算法。每個權重都會從高斯隨機變量中進行采樣。實際上,和Dropout一樣,很多網絡都是在訓練時的更新中進行采樣。這里和Dropout的不同之處在于,SDR在更新時,會根據錯誤的梯度調整權重和隱藏單元。

圖1

因此,每個權重梯度就是基于隱藏單元的隨機變量,基于此,系統可以:

給定相同的樣本/獎勵,生成多個回復假設

保持歷史預測,而不像Dropout一樣只有局部的隱藏單元權重

有可能會返回到不良局部最小值而造成貪婪搜索,但同時越來越遠離更好的局部最小值

最后一個優點是,如Hinton所說,局部噪聲的插入可能會導致收斂到更好的局部最小值的速度更快、更穩定。

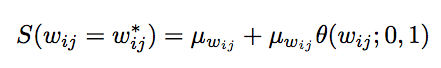

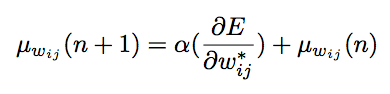

實施SDR有三個更新規則,以下是權重分布中的權重值的更新規則:

第一個更新規則用于計算權重分布的平均數:

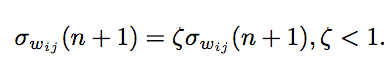

第二個用于權重分布的標準偏差:

第三種是將標準偏差收斂到0,讓平均權重值達到一個固定點,將所有樣本都聚集起來:

接下來,我們將講述Dropout如何成為SDR的特殊情況。最明顯的方法是首先將隨機搜索看作一種特殊的采樣分布。

將Dropout看作SDR的二項式固定參數

如之前所說,Dropout需要將每層的隱藏單元在Bernoulli過程中刪除。如果我們在同樣的網絡中,將Dropout和SDR進行對比,可以發現二者的不同在于隨機處理是否影響了權重或隱藏單元。圖2我們描述了Dropout在隱藏單元采樣時的收斂。可以看到明顯的不同是,SDR在適應性地更新隨機變量參數,而Dropout是用固定參數進和Binomial隨機變量進行采樣。另一個重要區別在于,SDR在隱藏層中的共享權重比Dropout的更“局部”。

圖2

那么,SDR所表現出的參數的增加,是否使得搜索更加有效、更加穩定?下一步我們將開展實驗。

測試及結果

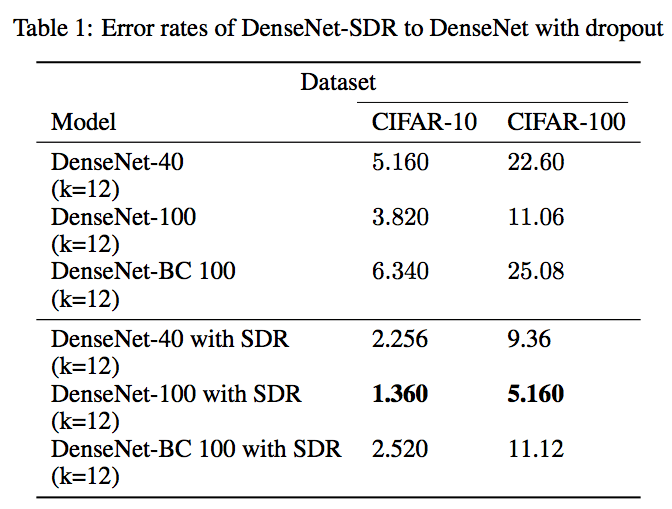

這里我們采用了在TensorFlow上搭建的經過改進的DenseNet。模型用DenseNet-40、DenseNet-100和DenseNet-BC 100網絡,它們經過了CIFAR-10和CIFAR-100的訓練,初始DenseNet參數相同。

最終的結果顯示,將SDR換成Dropout后的DenseNet測試中,錯誤率下降了50%以上。

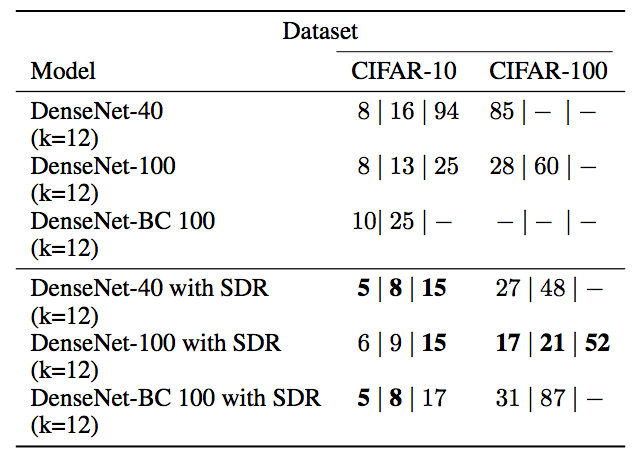

同時在錯誤率分別為15、10和5的情況下,訓練所需次數也比單獨DenseNet減少:

訓練精確度(DenseNet-100橙色,有SDR的DenseNet-100,藍色)

結語

這篇文章展示了一個基礎的深度學習算法(Dropout)是如何實施隨機搜索并幫助解決過度擬合的。未來我們將展示SDR是如何超越Dropout在深度學習分類中的表現的。

數據科學家、fast.ai創始人Jeremy Howard點評:“如果該論文結果真的這么好,那絕對值得關注。”

但是谷歌機器學習專家David Ha有不同意見:“結果看上去很可疑(我覺得他們搞錯了)。CIFAR-10的準確率能到98.64%,CIFAR-100真的能到94.84%嗎?”

-

神經元

+關注

關注

1文章

363瀏覽量

18511 -

Dropout

+關注

關注

0文章

13瀏覽量

10071 -

深度學習

+關注

關注

73文章

5515瀏覽量

121553

原文標題:爭議 | 錯誤減少50%!這難道是更快更準確的深度學習?

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

SDR_SDR是什么意思

介紹SDR的技術原理 以SDR LTE系統為例進一步解析SDR系統的工作流程

ref sdr sdram verilog代碼

SDR SDRAM Controller (White Pa

ref sdr sdram vhdl代碼

dropout正則化技術介紹

SDR的技術原理介紹及案例分析

基于動態dropout的改進堆疊自動編碼機方法

執行節點分析時的特殊情況介紹

Dropout如何成為SDR的特殊情況

Dropout如何成為SDR的特殊情況

評論