DeepMind提出了一種讓神經(jīng)網(wǎng)絡(luò)進(jìn)行抽象推理的新方法,類似人類的IQ測(cè)試。結(jié)果發(fā)現(xiàn)經(jīng)典模型如ResNet得分極低,數(shù)據(jù)稍有改動(dòng)就變“白癡”,而他們關(guān)注推理的架構(gòu)得分高很多,如果能給出結(jié)果的符號(hào)解釋,模型的預(yù)測(cè)性能和泛化性能還會(huì)顯著提高。

在許多長期存在的機(jī)器學(xué)習(xí)問題中,基于神經(jīng)網(wǎng)絡(luò)的模型持續(xù)取得了令人振奮的結(jié)果,但是,開發(fā)它們推理抽象概念的能力被證明是很困難的。已有的研究解決了通用學(xué)習(xí)系統(tǒng)的重要特性,基于此,DeepMind的最新研究提出了一種在學(xué)習(xí)機(jī)器中測(cè)量抽象推理的方法,并解釋了關(guān)于泛化(generalisation)本質(zhì)的一些重要見解。

要理解為什么抽象推理對(duì)于一般智力(general intelligence)至關(guān)重要,可以思考阿基米德的名言“尤里卡!”(希臘語Eureka,意即“我發(fā)現(xiàn)了!”):他注意到物體的體積相當(dāng)于物體溢出的水的體積,他在概念層面理解了“體積”,并因此推理出如何計(jì)算不規(guī)則物體的體積。

我們希望AI具有類似的能力。雖然目前的AI系統(tǒng)可以在復(fù)雜的戰(zhàn)略游戲中擊敗世界冠軍,但它們經(jīng)常對(duì)其他看似簡單的任務(wù)束手無策,特別是當(dāng)需要在新環(huán)境中發(fā)現(xiàn)并重新應(yīng)用抽象概念時(shí)。例如,如果一個(gè)AI專門訓(xùn)練來計(jì)算三角形的數(shù)量,那么即使是最好的AI系統(tǒng)也無法計(jì)算方塊或任何其他先前未遇到過的對(duì)象。

因此,要構(gòu)建更好、更智能的系統(tǒng),理解神經(jīng)網(wǎng)絡(luò)目前處理抽象概念的方式以及它們需要改進(jìn)的地方,這非常重要。為此,我們從人類智商測(cè)試(IQ測(cè)試)中測(cè)量抽象推理的方法中獲得了靈感。

人類IQ測(cè)試中的推理

標(biāo)準(zhǔn)的人類IQ測(cè)試通常要求測(cè)試者運(yùn)用他們從日常經(jīng)驗(yàn)中學(xué)到的原理來解釋感知上簡單的視覺場(chǎng)景。例如,人類測(cè)試者可能已經(jīng)通過觀察植物生長或建筑物的搭建,在數(shù)學(xué)課上學(xué)習(xí)加法,或跟蹤利息累計(jì)的銀行余額等了解了“進(jìn)展”這個(gè)概念(即事物某些屬性可能增加的概念)。然后,他們可以在IQ題中應(yīng)用這個(gè)概念來推斷隨著序列增加,形狀的數(shù)量、大小,甚至顏色的深淺等屬性。

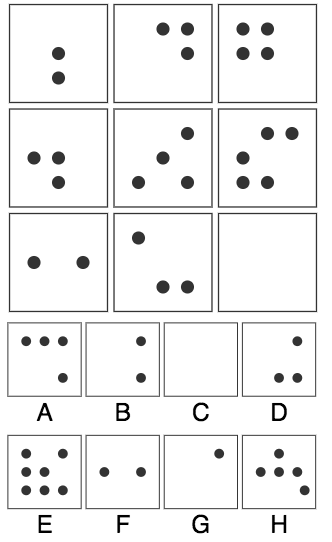

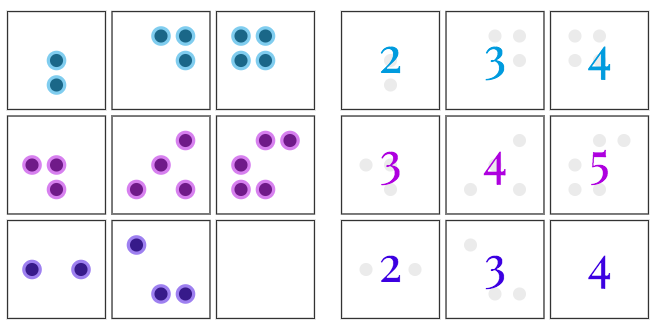

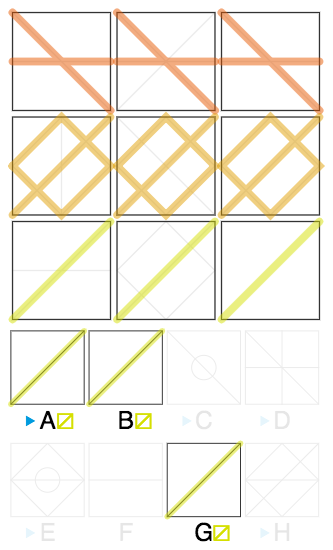

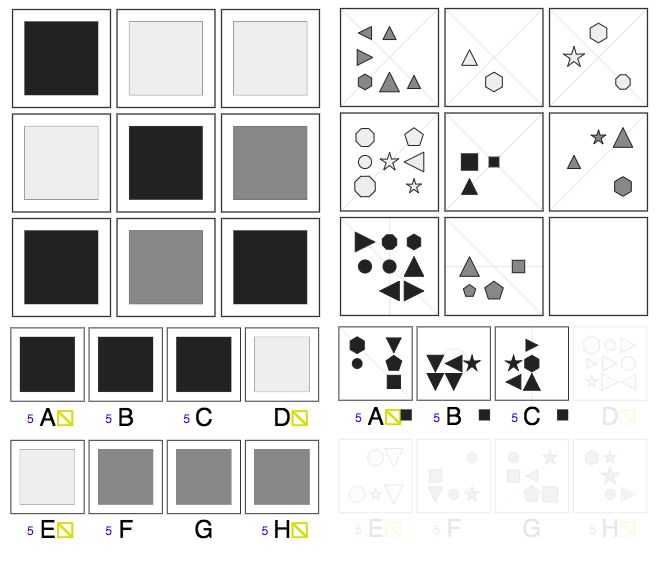

IQ測(cè)試題1:右下角應(yīng)該選哪個(gè)?

答案是A,為什么?

因?yàn)樵诿恳慌胖校娇蚶锖邳c(diǎn)的數(shù)目有一種“漸增”的關(guān)系,因此右下角黑點(diǎn)的數(shù)量應(yīng)該是4。

IQ測(cè)試題2:右下角應(yīng)該選哪個(gè)?

答案是A,為什么?

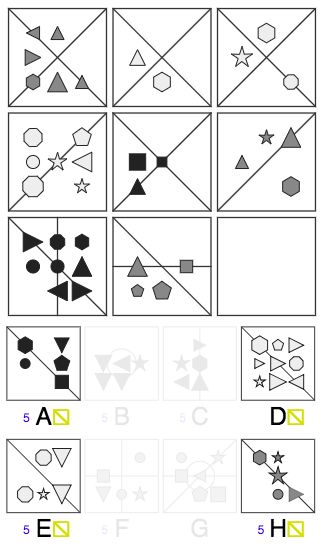

首先,每一列的三角形狀的數(shù)目分別是1個(gè)、5個(gè)和7個(gè),因此,右下角三角形狀的數(shù)量應(yīng)該是1,因此我們排除了B、F、G這三個(gè)答案,剩下A、C、D、E、H。

這道題中還需要觀察“線”的關(guān)系,我們觀察到每一排最右方的線是AND的關(guān)系,即同時(shí)出現(xiàn)在左邊兩個(gè)格的線才會(huì)出現(xiàn)在第三個(gè)格。

因此,我們得到了右下角格的線,進(jìn)一步排除C、D、E、H,正確答案就是A。

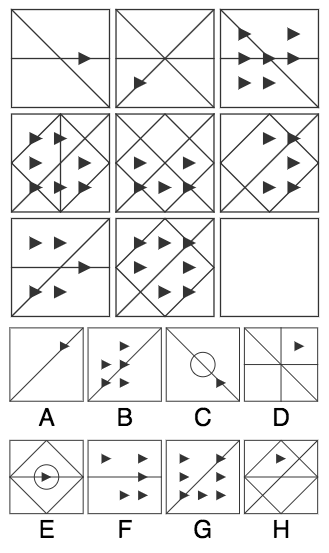

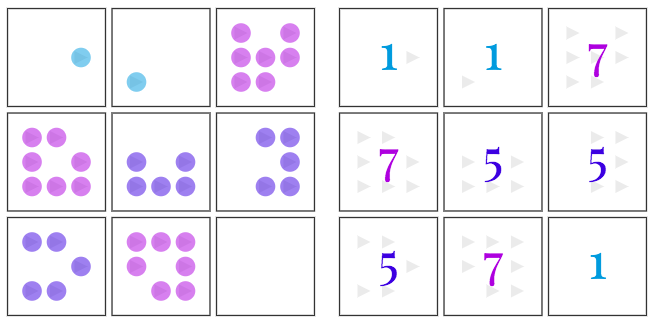

IQ測(cè)試題3:右下角應(yīng)該選哪個(gè)?

答案仍然是A,為什么?

首先,每一列的形狀的數(shù)量有一種“漸增”的關(guān)系,因此右下角形狀的數(shù)量應(yīng)該是5個(gè),排除D、G。

跟前一題類似,線同樣是AND的關(guān)系,我們得到右下角的線,符合的只有A、D、E、H,D已經(jīng)在前一步排除,因此剩下A、E、H三個(gè)選項(xiàng)。

再看形狀顏色,每一列都分別有淺灰、深灰和黑色,因此右下角應(yīng)該是黑色,得到正確答案A。

我們還沒有辦法讓機(jī)器學(xué)習(xí)智能體接觸到類似的“日常體驗(yàn)”,這意味著我們無法輕易地衡量它們將知識(shí)從現(xiàn)實(shí)世界遷移到視覺推理測(cè)試的能力。盡管如此,我們?nèi)匀豢梢詣?chuàng)建一個(gè)實(shí)驗(yàn)設(shè)置,充分利用人類視覺推理測(cè)試。我們不是研究從日常生活到視覺推理問題的知識(shí)遷移(人類的IQ測(cè)試是如此),而是研究從一組受控的視覺推理問題到另一組視覺推理問題的知識(shí)遷移。

為實(shí)現(xiàn)這一目標(biāo),我們構(gòu)建了一個(gè)用于創(chuàng)建矩陣問題的生成器,它涉及一組抽象因素,包括“進(jìn)展”(progression)之類的關(guān)系以及“顏色”、“大小”之類的屬性。雖然問題生成器使用了少量的潛在因素,但它仍然可以創(chuàng)建大量獨(dú)特的問題。

接下來,我們限制了生成器可用的因素或組合,以便為訓(xùn)練和測(cè)試模型創(chuàng)建不同的問題集,從而測(cè)量我們的模型能夠多大程度上推廣到已配置的測(cè)試集。例如,我們創(chuàng)建了一組測(cè)試題的訓(xùn)練集,其中只有在應(yīng)用于線條顏色時(shí)才會(huì)遇到“漸進(jìn)關(guān)系”,而在測(cè)試集中應(yīng)用于形狀大小時(shí)會(huì)遇到“漸進(jìn)關(guān)系”。如果模型在該測(cè)試集上表現(xiàn)良好,它將為推斷和應(yīng)用“漸進(jìn)關(guān)系”這個(gè)抽象概念的能力提供證據(jù),即使它以前從未遇見過“漸進(jìn)關(guān)系”。

抽象推理的證據(jù)

在機(jī)器學(xué)習(xí)評(píng)估中應(yīng)用的典型的泛化機(jī)制中,訓(xùn)練和測(cè)試數(shù)據(jù)來自相同的底層分布,我們測(cè)試的所有網(wǎng)絡(luò)都表現(xiàn)出良好的泛化誤差( generalisation error),其中一些網(wǎng)絡(luò)實(shí)現(xiàn)了令人印象深刻的絕對(duì)性能。表現(xiàn)最好的網(wǎng)絡(luò)顯式地計(jì)算了不同圖像方塊之間的關(guān)系,并且并行地評(píng)估每個(gè)潛在答案的適用性。我們稱這種架構(gòu)為Wild Relation Network(WReN)。

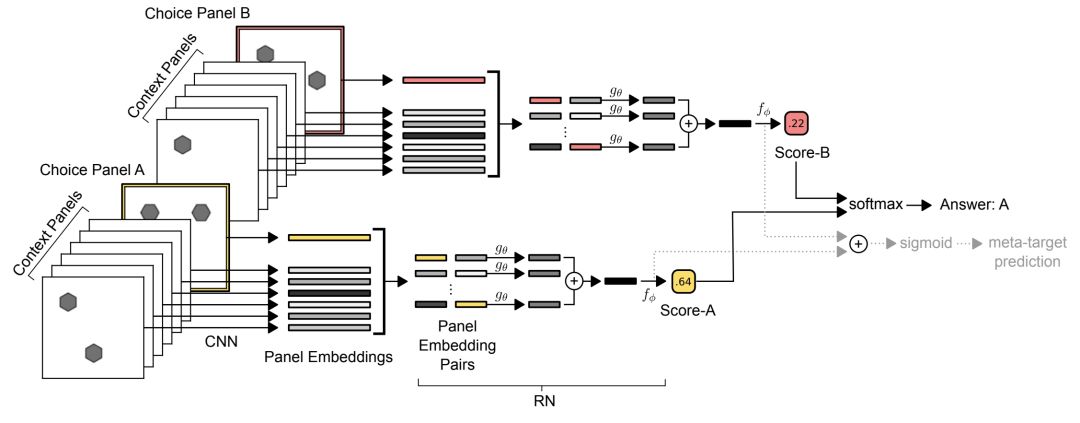

WReN模型

CNN會(huì)獨(dú)立處理每個(gè)內(nèi)容panel并且一個(gè)單獨(dú)的回答會(huì)選擇一個(gè)panel來產(chǎn)生9個(gè)矢量embedding。然后將這組embedding傳遞給RN(其輸出是單個(gè)sigmoid單元),為相關(guān)答案選擇panel的“得分”進(jìn)行編程。 通過該網(wǎng)絡(luò)進(jìn)行8次這樣的傳遞(為簡便起見,我們僅描繪2次),每次答案選擇一次,就會(huì)通過softmax函數(shù)得分以確定模型的預(yù)測(cè)答案。

當(dāng)需要使用屬性值在先前看到的屬性值之間“內(nèi)推”(interpolated),以及在不熟悉的組合中應(yīng)用已知的抽象關(guān)系時(shí),模型的泛化效果非常好。但是,同樣的網(wǎng)絡(luò)在“外推”(extrapolation)機(jī)制中表現(xiàn)糟糕得多,在這種情況下,測(cè)試集中的屬性值與訓(xùn)練期間的屬性值不在同一范圍內(nèi)。對(duì)于在訓(xùn)練中包含深色物體,但測(cè)試中包含淺色物體的謎題中就會(huì)出現(xiàn)這種情況。當(dāng)模型被訓(xùn)練來將以前見到的關(guān)系(比如形狀的數(shù)量)應(yīng)用到一個(gè)新的屬性(比如形狀的大小)時(shí),泛化性能也會(huì)更差。

實(shí)驗(yàn)結(jié)果

PGM數(shù)據(jù)集

我們將數(shù)據(jù)集稱為程序生成矩陣(Procedurally Generated Matrices,PGM)數(shù)據(jù)集。為了生成PGM,受Carpenter,Wang&Su等人的啟發(fā),通過從以下原始集中隨機(jī)抽樣來完成的:

關(guān)系類型(R,元素是r):包括progression,XOR, OR, AND, consistent union;

目標(biāo)類型(O,元素是o):包括shape,line;

屬性類型(A,元素是a):包括,type,color,position,number

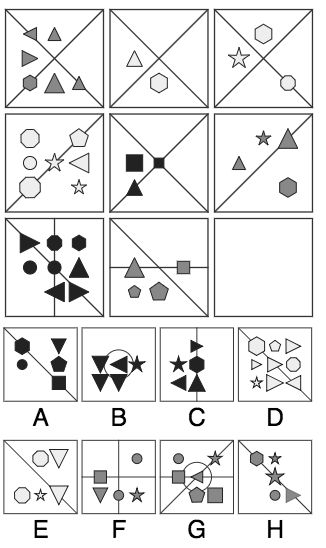

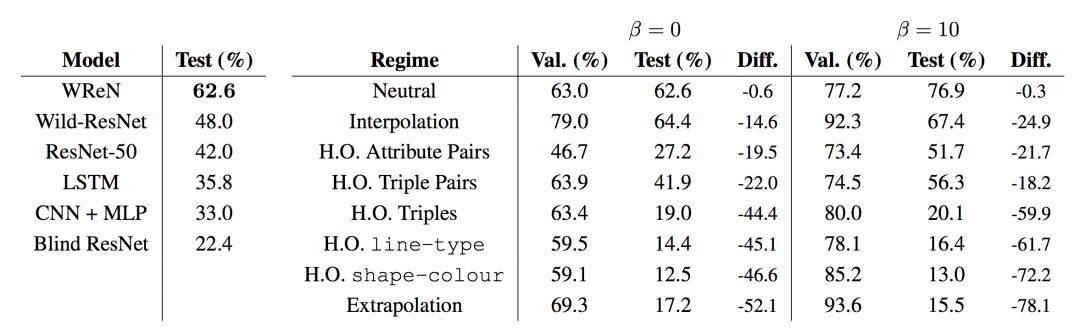

PGM問題—模型比較

我們首先比較了中性分裂(訓(xùn)練/測(cè)試)的所有模型,這與傳統(tǒng)的監(jiān)督學(xué)習(xí)制度最為接近。 也許令人驚訝的是,雖然它們是強(qiáng)大的圖像處理器的方法,CNN模型幾乎完全失敗了PGM推理問題(表1),性能略微優(yōu)于我們的基線 - context-blind的ResNet模型,該模型對(duì)內(nèi)容視而不見并僅在八個(gè)候選答案受過訓(xùn)練。 LSTM按順序考慮各個(gè)候選小組的能力,相對(duì)于CNN產(chǎn)生了小的改進(jìn)。 性能最佳的ResNet變體是ResNet-50,其性能優(yōu)于LSTM。 ResNet-50具有比我們的簡單CNN模型更多的卷積層,因此具有更強(qiáng)的推理其輸入特征的能力。

所有模型在中性分裂(左圖)上的的性能,以及根據(jù)β= 0的泛化誤差排序的泛化機(jī)制WReN模型(右圖)的泛化性能。

性能最佳的模型是WReN模型。 這種強(qiáng)大的性能可能部分歸因于Relation Network模塊,它是為了推理對(duì)象之間的關(guān)系而明確設(shè)計(jì)的,部分是由于評(píng)分結(jié)構(gòu)。 請(qǐng)注意,評(píng)分結(jié)構(gòu)不足以解釋改進(jìn)的性能,因?yàn)閃ReN模型基本上優(yōu)于最佳Wild-ResNet模型,該模型也具有評(píng)分結(jié)構(gòu)。

不同問題類型的表現(xiàn)

涉及單個(gè)[r,o,a]三元組的問題比涉及多個(gè)三元組的問題更容易。 有趣的是,有三個(gè)三元組的PGM比四個(gè)三元組更難。 雖然有四個(gè)三元組的問題顯得更為復(fù)雜,但是還有更多好的方法可以解決問題。在涉及單個(gè)三元組的PGM中,OR(64.7%)被證明是一種比XOR更容易的關(guān)系(53.2%)。具有結(jié)構(gòu)涉及線(78.3%)的PGM比涉及形狀的那些(46.2%)更容易,涉及形狀數(shù)(80.1%)比那些涉及形狀大小(26.4%)。這表明模型難以辨別細(xì)粒度的大小差異,而不是更顯著的變化,如線條的缺少或出現(xiàn),或形狀的數(shù)量。

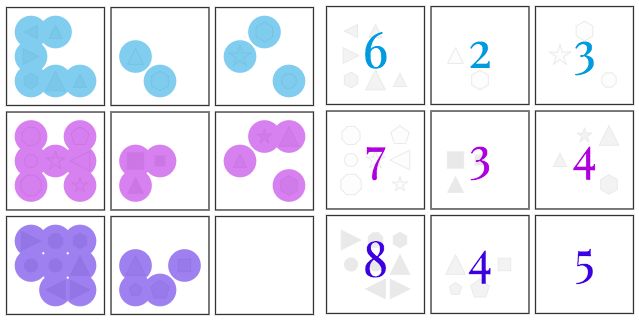

干擾物的影響

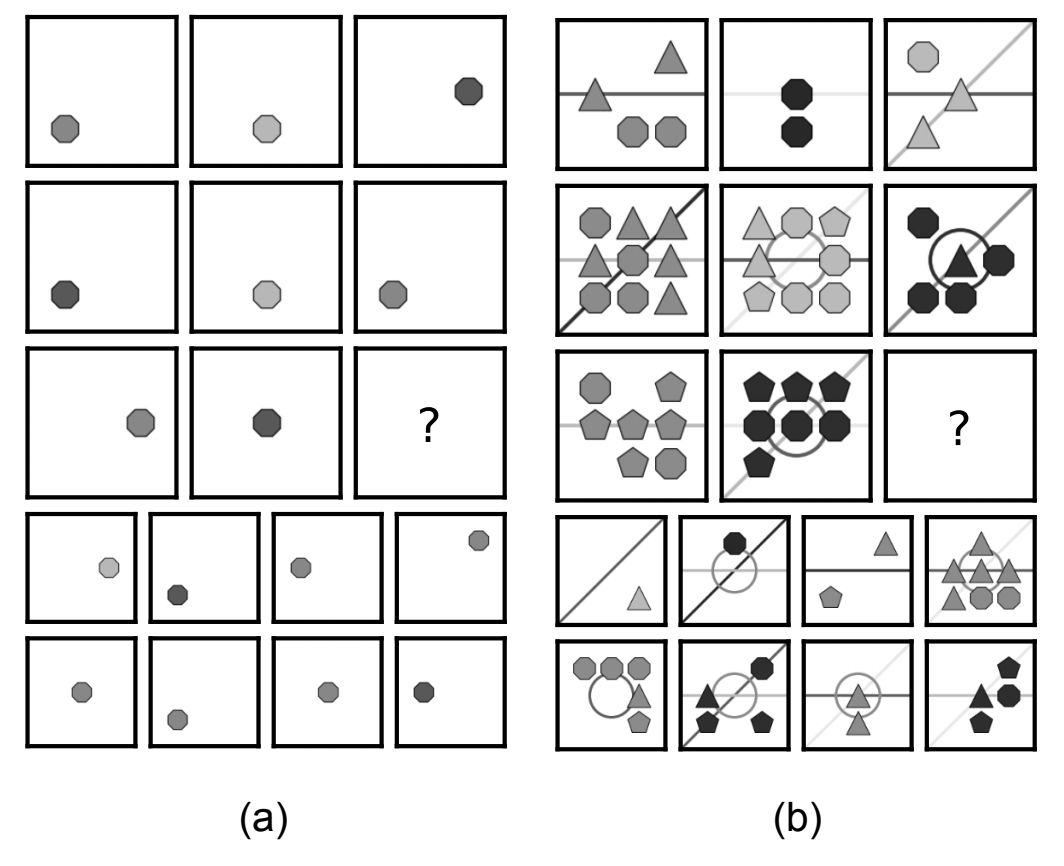

到目前為止報(bào)告的結(jié)果是包含干擾物屬性值的問題(見圖4)。 當(dāng)這些干擾物被移除時(shí),WReN模型的表現(xiàn)明顯更好(驗(yàn)證組的干擾物為79.3%,測(cè)試組的干擾物為78.3%,并與干擾者為63.0%和62.6%時(shí)的情況做比較)。

離心(distraction)的影響。在兩個(gè)PGM中,底層結(jié)構(gòu)S 是[形狀,顏色,連續(xù)單元],但是(b)包括形狀數(shù)、形狀類型,線顏色和線型的離心。

輔助訓(xùn)練的效果

然后,我們通過使用符號(hào)元目標(biāo)訓(xùn)練我們的模型來探索輔助訓(xùn)練對(duì)抽象推理和概括的影響。在中立狀態(tài)下,我們發(fā)現(xiàn)輔助訓(xùn)練使測(cè)試精度提高了13.9%。重要的是,模型捕獲數(shù)據(jù)的整體能力的改進(jìn)也適用于其他泛化機(jī)制。在將模型的三元組重新組合成新組合的情況下,差異最為明顯。因此,代表抽象語義原則的壓力使得它們可以簡單地解碼成離散的符號(hào)解釋,似乎提高了模型有效地組成其知識(shí)的能力。這一發(fā)現(xiàn)與先前關(guān)于離散通道(discrete channel)對(duì)知識(shí)表示的優(yōu)勢(shì)的觀察結(jié)果一致。

輔助訓(xùn)練分析

除了提高性能之外,使用元標(biāo)記(meta-targets)進(jìn)行培訓(xùn)還可以提供一種方法來衡量模型在給定PGM的情況下存在哪些形狀,屬性和關(guān)系,從而深入了解模型的策略。 使用這些預(yù)測(cè),WReN模型在其元目標(biāo)預(yù)測(cè)正確時(shí)達(dá)到了87.4%的測(cè)試準(zhǔn)確率,而在預(yù)測(cè)不正確時(shí)僅達(dá)到34.8%。

元目標(biāo)預(yù)測(cè)可以分解為對(duì)象,屬性和關(guān)系類型的預(yù)測(cè)。 我們利用這些細(xì)粒度預(yù)測(cè)來詢問WReN模型的準(zhǔn)確性如何隨其對(duì)每個(gè)屬性的預(yù)測(cè)而獨(dú)立變化。當(dāng)形狀元目標(biāo)預(yù)測(cè)正確(79.5%)時(shí),相比預(yù)測(cè)不正確(78.2%)時(shí)模型的精度有所提高;同樣,當(dāng)屬性元目標(biāo)預(yù)測(cè)正確(49%)時(shí),相比預(yù)測(cè)不正確(62.2%)時(shí)模型的精度有所提高。然而,對(duì)于關(guān)系屬性,正確和不正確的元目標(biāo)預(yù)測(cè)之間的差異很大(86.8%對(duì)32.1%)。 這個(gè)結(jié)果表明正確預(yù)測(cè)關(guān)系屬性對(duì)任務(wù)成功至關(guān)重要。

最后,當(dāng)模型被訓(xùn)練于不僅預(yù)測(cè)正確的答案,而且預(yù)測(cè)答案的“原因”(即考慮解決這個(gè)難題的特定關(guān)系和屬性)時(shí),我們觀察到了更好的泛化性能。有趣的是,在neutral split中,模型的準(zhǔn)確性與它推斷矩陣背后的關(guān)系的能力密切相關(guān):當(dāng)解釋正確時(shí),模型在87%的時(shí)候能選擇到正確的答案;但當(dāng)它的解釋錯(cuò)誤時(shí),準(zhǔn)確性下降到只有32%。這表明,當(dāng)模型正確地推斷出任務(wù)背后的抽象概念時(shí),它們能夠獲得更好的性能。

結(jié)論

最近有一些研究關(guān)注基于神經(jīng)網(wǎng)絡(luò)的解決機(jī)器學(xué)習(xí)問題的方法的優(yōu)點(diǎn)和缺點(diǎn),通常基于它們的泛化能力。我們的研究結(jié)果表明,尋找關(guān)于泛化的普遍結(jié)論可能是無益的:我們測(cè)試的神經(jīng)網(wǎng)絡(luò)在某些泛化方案中表現(xiàn)良好,而在其他時(shí)候表現(xiàn)很差。它們是否成功取決于一系列因素,包括所用模型的架構(gòu),以及模型是否被訓(xùn)練來為其答案選擇提供可解釋的“理由”。在幾乎所有情況下,當(dāng)需要推斷超出其經(jīng)驗(yàn)的輸入或處理完全陌生的屬性時(shí),系統(tǒng)的表現(xiàn)很差;這是一個(gè)關(guān)鍵且極為重要的研究領(lǐng)域,未來的工作可以集中于這個(gè)焦點(diǎn)。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4779瀏覽量

101174 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8439瀏覽量

133087 -

DeepMind

+關(guān)注

關(guān)注

0文章

131瀏覽量

10940

原文標(biāo)題:ResNet可能是白癡?DeepMind給神經(jīng)網(wǎng)絡(luò)們集體測(cè)智商

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

人工神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)方法有哪些?

一種基于綜合幾何特征和概率神經(jīng)網(wǎng)絡(luò)的HGU軸軌識(shí)別方法

圖像預(yù)處理和改進(jìn)神經(jīng)網(wǎng)絡(luò)推理的簡要介紹

一種基于高效采樣算法的時(shí)序圖神經(jīng)網(wǎng)絡(luò)系統(tǒng)介紹

基于神經(jīng)網(wǎng)絡(luò)的傳感器故障監(jiān)測(cè)與診斷方法研究

基于神經(jīng)網(wǎng)絡(luò)的傳感器故障監(jiān)測(cè)與診斷方法研究

傳感器故障檢測(cè)的Powell神經(jīng)網(wǎng)絡(luò)方法

神經(jīng)網(wǎng)絡(luò)在電磁場(chǎng)數(shù)值問題中的應(yīng)用

基于GA優(yōu)化T_S模糊神經(jīng)網(wǎng)絡(luò)的小電流接地故障選線新方法_王磊

DENSER是一種用進(jìn)化算法自動(dòng)設(shè)計(jì)人工神經(jīng)網(wǎng)絡(luò)(ANNs)的新方法

測(cè)量神經(jīng)網(wǎng)絡(luò)的抽象推理能力

DeepMind提出了一種讓神經(jīng)網(wǎng)絡(luò)進(jìn)行抽象推理的新方法

DeepMind提出了一種讓神經(jīng)網(wǎng)絡(luò)進(jìn)行抽象推理的新方法

評(píng)論