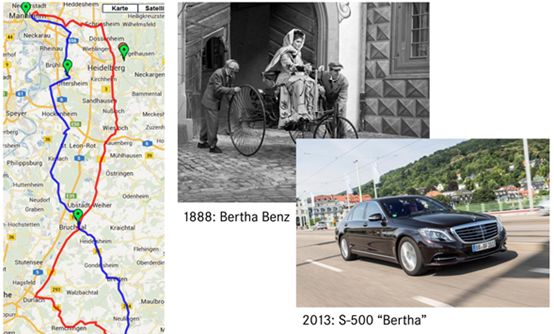

在1888年8月,奔馳創始人卡爾奔馳的妻子Bertha Benz開著丈夫發明的三輪內燃汽車從德國Mannheim到達Pforzheim,這次大約100公里的歷程標志著現代汽車的誕生。

125年后,2013年8月,奔馳沿著當年的路程,又走了一遍,不過這次是無人駕駛,為了向前輩以及前輩的賢內助致敬,奔馳將這輛基本沒改裝過的奔馳S500親切地稱之為Bertha。

Bertha的核心傳感器是一個1024*440像素的FOV為45度的雙目,奔馳將雙目基線長加大到35厘米,主要為了覆蓋更遠的距離,標準版S級雙目為30厘米。雙目的SGM和棒狀像素計算都使用FPGA完成,每幀圖像可以做到40萬個獨立深度測量。剩下的計算奔馳用一個FOV為90度的單目識別紅綠燈,用一個FOV為90度的單目做基于特征的輔助定位。另外還有4個120度的中距離毫米波雷達,KIT提供了高精度地圖,地圖包括限速、斑馬線位置、停止線、道路曲率等。由于是郊區行駛,奔馳只用了GPS,并未用外置慣性導航系統。這也是最接近量產的L4級無人車。

雙目相比單目有著壓倒性的絕對優勢,單目能做到的,雙目都能做到,單目卻做不到雙目的3D立體視覺。以紅綠燈檢測為例,Mobileye闖紅燈的視頻想必大家都看過了,識別紅綠燈是感知環節最難的技術點之一,百度和谷歌都是利用各自擁有的街景圖片庫資源,利用先驗信息,設定好ROI,以此提高識別紅綠燈的準確率。然而街景的更新速度很慢,在快速發展的中國或許不合適,在美國就比較合適。即便如此,Waymo也出現過闖紅燈的視頻,如果沒有街景配合,單純單目的紅綠燈識別率相當低。更致命的是,我國的紅綠燈千奇百怪,尤其是天津,一條路上有五種紅綠燈,簡直是無人車的噩夢。而V2X還遙遙無期。

目前有三種雙目識別紅綠燈方法,第一種是用目標候選區濾波法,在目標候選區分析視差值,將前景與背景分離,無需先驗知識。

第二種是關聯位置濾波法,這種方法需要先驗知識,就是統計紅綠燈的3維位置信息,特別是紅綠燈的高度,還有與斑馬線的直線距離,與路沿的直線距離。當無人車上線行駛時可以獲得目標的三維距離信息,與先驗知識庫做濾波。這種方法可以大幅度提高紅綠燈識別率。有時只需要紅綠燈的高度信息,相對街景,這個先驗知識可以輕松獲得。

第三種方法,即再投影法。將真實世界的紅綠燈建模,同時增加深度測量數據,將紅綠燈假想再投影到紅綠燈模型內,再配合深度測量數據判斷是不是紅綠燈。無論那一種,都要比單目好得多。

雙目的立體匹配幾乎都要用FPGA完成,懂算法又懂FPGA的人才非常罕見,FPGA價格也比較高,這限制了雙目的應用。加上FPGA廠家都位于美國,中國企業對此是有所顧慮的。美國對FPGA的銷售是睜一只眼閉一只眼,一旦較真起來,很可能買不到計算單元超過10萬的FPGA。單目的應用幾乎不用考慮硬件,價格低廉,因此應用遠比雙目廣泛。

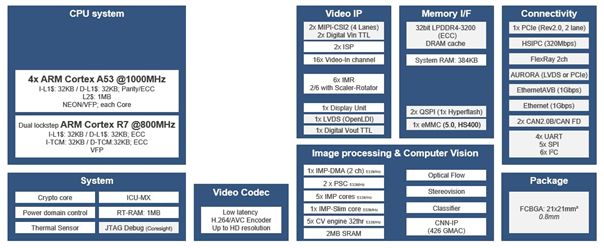

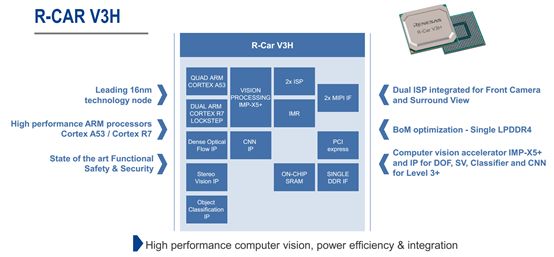

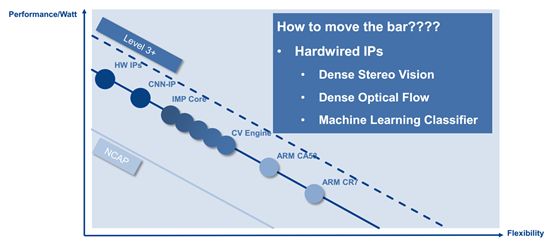

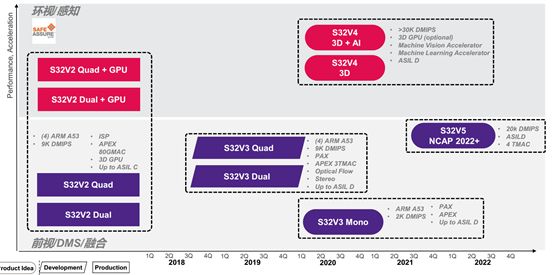

不過這種現象將在未來幾年有大幅度改觀。全球前三大汽車處理器廠家的兩大都推出了專用雙目設計的處理器,這就是瑞薩的R-CAR V3H和NXP的S32V3系列。兩者都是在2018年3季度有樣片。雙目可以不用FPGA了。

先來看瑞薩的R-CARV3H。

R-CAR V3H目前已確定獲得日產和豐田的訂單,日產將全線使用R-CAR V3H,包括高速公路自動駕駛,遙控泊車,全自動泊車,塞車輔助,無限制條件的AEB(L2階段的限制條件極多)。

R-CAR V3H的運算能力達到4.2TFLOPS,超過Mobileye EyeQ4的3TFLOPS,制造工藝上R-CAR V3H擁有絕對優勢,臺積電的16納米FinFET工藝完勝意法半導體的28納米FD-SOI工藝。當然Mobileye EyeQ4比R-CAR V3H要早兩年,但R-CAR V3H還有強大的CPU系統,包含4個A53和一個擁有鎖步功能的R7,這就意味著R-CAR V3H應該能滿足ISO 26262 ASIL-A或B級標準而不是Mobileye那樣只能通過AECQ-100 1級標準。

上圖為R-CAR V3H的內部框架圖

R-CAR V3H針對L3+級車輛,包含了立體視差和光流硬核IP,效率與FPGA相當,或許比FPGA略好。

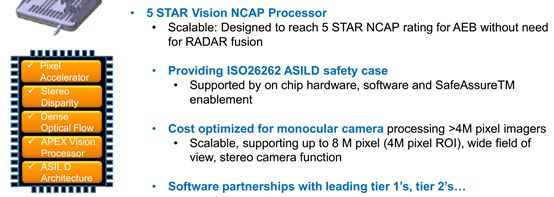

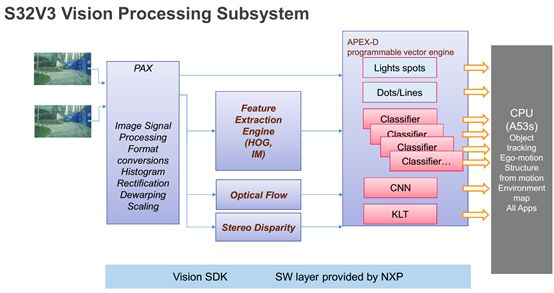

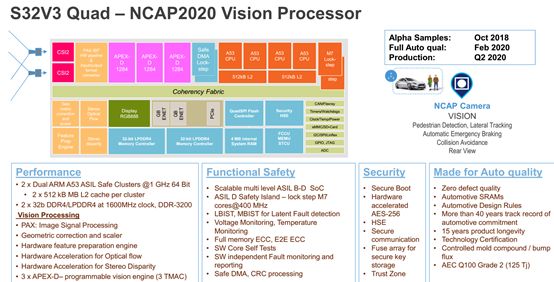

NXP計劃在2018年3季度推出S32V3的樣片,和V3H一樣也是立體視差和光流硬核IP。

S32V3最高可達ASIL-D級,安全等級遠超Mobileye。

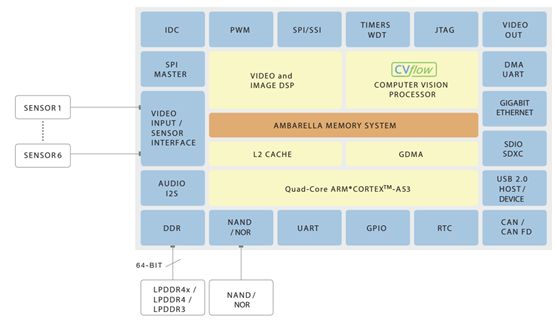

S32V3內部框架圖

除了NXP和瑞薩這兩家頂級企業,還有行車記錄儀芯片巨頭安霸的產品,運算性能比Mobileye即將在2018年3季度問世的EyeQ5還要強。安霸在2015年以3000萬美元的價格收購了意大利初創公司VisLab,這家公司由意大利帕爾馬大學團隊創立。目前,其創始人Alberto Broggi教授擔任安霸自動駕駛業務的負責人。

安霸第一代自動駕駛用芯片CV1能夠對應兩個800萬像素的雙目立體視覺,運算力達到2TFLOPS。采用索尼的IMX317圖像傳感器,像素精度可達3840*1728,如此高的像素,即使在FOV為75度30厘米基線的情況下也可以達到300米的有效距離,遠超大部分激光雷達的有效距離。

激光雷達的有效距離與物體反射率關系極為密切,通常廠家只給反射率為80%時的有效距離,對于白色車輛,反射率可能只有10%,有效距離會縮短到80%時的1/3甚至更少。一般MEMS激光雷達在10%反射率下有效距離只有30到70米,機械旋轉型的略好。

CV1可以直接輸出一張視差圖,幀率每秒一幀。同時還內含路障或隔離柵檢測,路沿與車道線檢測,交通信號檢測,一般障礙物檢測。

CV1只是安霸試水作品,安霸在2018年初推出CV2AQ,運算性能提高10倍,大約為14TFLOPS,三星的10納米工藝制造,通過了AEC-Q100 2級標準。

這款芯片異常強大,可以同時處理3200萬像素的數據,可以同時對應6個雙目,包括兩個800萬像素的雙目和4個200萬像素的雙目。而CV1僅能對應1個800萬像素的單目。

隨著FPGA的瓶頸被突破,雙目的大規模應用即將到來!

-

FPGA

+關注

關注

1630文章

21796瀏覽量

605998 -

立體視覺

+關注

關注

0文章

37瀏覽量

9810 -

無人駕駛

+關注

關注

98文章

4089瀏覽量

121005

原文標題:突破FPGA限制,雙目立體視覺時代即將到來

文章出處:【微信號:zuosiqiche,微信公眾號:佐思汽車研究】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

Veloce平臺在大規模SOC仿真驗證中的應用

大規模MIMO的利弊

真正虛擬化的測控時代即將到來

解讀全球十大公司物聯網戰略,一個萬物智能的世界即將到來 精選資料分享

大規模FPGA設計中的多點綜合技術

5G即將到來 將面臨這些問題

FPGA的瓶頸被突破,雙目的大規模應用即將到來!

FPGA的瓶頸被突破,雙目的大規模應用即將到來!

評論