深度學(xué)習(xí)(或生活中的大部分領(lǐng)域)的關(guān)鍵是演練。演練各種問題-從圖像處理到語音識(shí)別。每個(gè)問題都有其獨(dú)特的細(xì)微差別和方法。

但是,哪里可以獲得這些數(shù)據(jù)?現(xiàn)今你看到的很多研究論文都使用通常不向公眾開放的專有數(shù)據(jù)集。而這成為了如果你學(xué)習(xí)并應(yīng)用你新掌握的技能的阻礙。

如果你也遇到此問題,我們有解決方案提供給你。我們挑選了一系列公開可用的數(shù)據(jù)集供各位詳細(xì)閱讀。

在本文中,我們列出了一系列高質(zhì)量的數(shù)據(jù)集,每個(gè)深度學(xué)習(xí)愛好者都可以應(yīng)用和改進(jìn)他們的技能。使用這些數(shù)據(jù)集將使你成為一名更好的數(shù)據(jù)科學(xué)家,同時(shí)你所學(xué)到的知識(shí)將對(duì)你的職業(yè)生涯產(chǎn)生無價(jià)的幫助-。我們還收錄了具有最新技術(shù)(SOTA)結(jié)果的論文供你瀏覽并改進(jìn)你的模型。

▌如何使用這些數(shù)據(jù)集

首先要做的事-這些數(shù)據(jù)集的容量相當(dāng)大!所以請(qǐng)確保你的網(wǎng)絡(luò)是高速的、不限流量或有很多流量地下載數(shù)據(jù)。

有很多種可以使用這些數(shù)據(jù)集的方式。你可以使用它們來應(yīng)用各種深度學(xué)習(xí)技巧。也可以使用它們來磨練你的技能,了解如何識(shí)別和構(gòu)建每個(gè)問題,思考獨(dú)特的使用案例并展示給所有人你的發(fā)現(xiàn),讓大家都可以看到!

這些數(shù)據(jù)集分為三類-圖像處理,自然語言處理,以及音頻/語音處理。

讓我們開始更深入的了解!

▌圖像處理

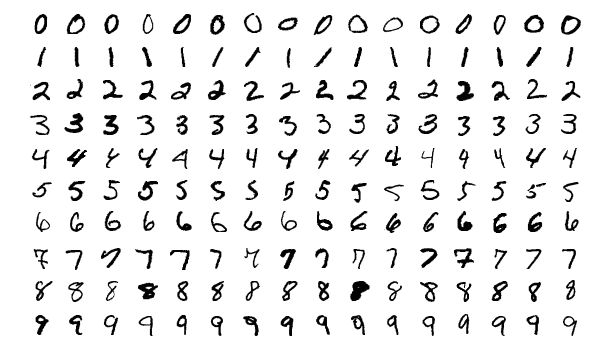

MNIST

MNIST是最受歡迎的深度學(xué)習(xí)數(shù)據(jù)集之一。這是一個(gè)手寫數(shù)字?jǐn)?shù)據(jù)集,包含一組60,000個(gè)示例的訓(xùn)練集和一組10,000個(gè)示例的測試集。這是一個(gè)對(duì)于在實(shí)際數(shù)據(jù)中嘗試學(xué)習(xí)技術(shù)和深度識(shí)別模式的很好的數(shù)據(jù)庫,同時(shí)嘗試學(xué)習(xí)如何在數(shù)據(jù)預(yù)處理中花費(fèi)最少的時(shí)間和精力。

大小:?50 MB

記錄數(shù)量:分為10個(gè)類別的70,000個(gè)圖片

SOTA:Dynamic Routing Between Capsules

MS-COCO

COCO是一個(gè)規(guī)模大且豐富的物體檢測,分割和字幕數(shù)據(jù)集。它有幾個(gè)特點(diǎn):

物體分割

文中識(shí)別

超像素物質(zhì)分割

330K圖像(> 200K標(biāo)記)

150萬個(gè)物體實(shí)例

80個(gè)物體類別

91個(gè)物質(zhì)類別

每張圖片5個(gè)字幕

250,000有關(guān)鍵點(diǎn)的人

大小:?25 GB(壓縮)

記錄數(shù)量:330K圖像,80個(gè)物體類別,每幅圖像5個(gè)字幕,250,000個(gè)有關(guān)鍵點(diǎn)的人

SOTA:Mask R-CNN

ImageNet

ImageNet是依據(jù)WordNet層次結(jié)構(gòu)組織的圖像數(shù)據(jù)集。WordNet包含大約100,000個(gè)短語,ImageNet提供了平均大約1000個(gè)圖像來說明每個(gè)短語。

大小:?150GB

記錄數(shù)量:圖像總數(shù):?1,500,000;每個(gè)都有多個(gè)邊界框和相應(yīng)的類標(biāo)簽

SOTA:Aggregated Residual Transformations for Deep Neural Networks

Open Images Dataset

Open Images是一個(gè)包含近900萬個(gè)圖像URL的數(shù)據(jù)集。這些圖像已經(jīng)用數(shù)千個(gè)類別的圖像級(jí)標(biāo)簽邊框進(jìn)行了注釋。該數(shù)據(jù)集包含9,011,219張圖像的訓(xùn)練集,41,260張圖像的驗(yàn)證集以及125,436張圖像的測試集。

大小:500 GB(壓縮)

記錄數(shù)量:9,011,219張超過5k標(biāo)簽的圖像

SOTA:Resnet 101圖像分類模型(在V2數(shù)據(jù)上訓(xùn)練):Model checkpoint,Checkpoint readme,Inference code.

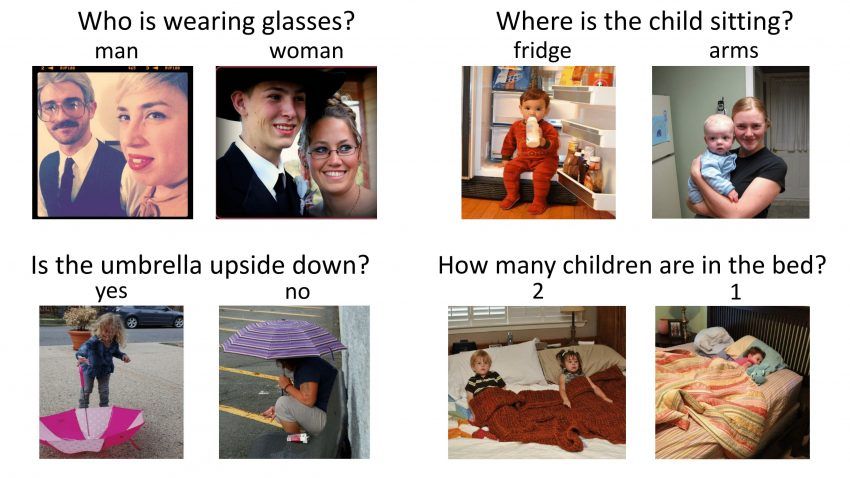

VisualQA

VQA是一個(gè)包含有關(guān)圖像的開放式問題的數(shù)據(jù)集。這些問題需要理解是視覺和語言。這個(gè)數(shù)據(jù)集有一些有趣的特點(diǎn):

265,016張圖片(COCO和抽象場景)

每張圖片至少有3個(gè)問題(平均5.4個(gè)問題)

每個(gè)問題10個(gè)基于事實(shí)答案

每個(gè)問題3個(gè)似乎合理(但看起來不正確)的答案

自動(dòng)評(píng)估指標(biāo)

大小:25 GB(壓縮)

記錄數(shù)量:265,016張圖片,每張圖片至少3個(gè)問題,每個(gè)問題10個(gè)基于事實(shí)答案

SOTA:Tips and Tricks for Visual Question Answering: Learnings from the 2017 Challenge

The Street View House Numbers (SVHN)

這是用于開發(fā)物體檢測算法的真實(shí)世界圖像數(shù)據(jù)集。這些只需要最少的數(shù)據(jù)預(yù)處理。它與本列表中提到的MNIST數(shù)據(jù)集類似,但擁有更多標(biāo)簽數(shù)據(jù)(超過600,000個(gè)圖像)。這些數(shù)據(jù)是從谷歌街景中查看的房屋號(hào)碼中收集的。

大小:2.5 GB

記錄數(shù)量:10個(gè)課程中的6,30,420張圖片

SOTA:Distributional Smoothing With Virtual Adversarial Training

CIFAR-10

這是另一個(gè)圖像分類的數(shù)據(jù)集。它包含了10個(gè)類別的60,000個(gè)圖像(每個(gè)類在上圖中表示為一行)。總共有50,000個(gè)訓(xùn)練圖像和10,000個(gè)測試圖像。數(shù)據(jù)集分為6個(gè)部分- 5個(gè)培訓(xùn)批次和1個(gè)測試批次。每批有10,000個(gè)圖像。

大小:170 MB

記錄數(shù)量:10個(gè)類別的60,000張圖片

SOT:ShakeDrop regularization

Fashion-MNIST

Fashion-MNIST包含60,000個(gè)訓(xùn)練圖像和10,000個(gè)測試圖像。它是一個(gè)類似MNIST的時(shí)尚產(chǎn)品數(shù)據(jù)庫。開發(fā)人員認(rèn)為MNIST已被過度使用,因此他們將其作為MNIST的直接替代品。每張圖片都以灰度顯示,并與10個(gè)類別的標(biāo)簽相關(guān)聯(lián)。

大小:30 MB

記錄數(shù)量:10個(gè)類別的70,000張圖片

SOTA:Random Erasing Data Augmentation

▌自然語言處理

IMDB Reviews

這是一個(gè)電影愛好者的夢寐以求的數(shù)據(jù)集。它意味著二元情感分類,并具有比此領(lǐng)域以前的任何數(shù)據(jù)集更多的數(shù)據(jù)。除了訓(xùn)練和測試評(píng)估示例之外,還有更多未標(biāo)記的數(shù)據(jù)可供使用。包括文本和預(yù)處理的詞袋格式。

大小:80 MB

記錄數(shù)量:25,000個(gè)高度差異化的電影評(píng)論用于訓(xùn)練,25,000個(gè)測試

SOTA:Learning Structured Text Representations

Twenty Newsgroups

顧名思義,該數(shù)據(jù)集包含有關(guān)新聞組的信息。為了選擇這個(gè)數(shù)據(jù)集,從20個(gè)不同的新聞組中挑選了1000篇新聞文章。這些文章具有一定特征,如主題行,簽名和引用。

大小:20 MB

記錄數(shù)量:來自20個(gè)新聞組的20,000條消息

DOTA:Very Deep Convolutional Networks for Text Classification

Sentiment140

Sentiment140是一個(gè)可用于情感分析的數(shù)據(jù)集。一個(gè)流行的數(shù)據(jù)集,非常適合開始你的NLP旅程。情緒已經(jīng)從數(shù)據(jù)中預(yù)先移除。最終的數(shù)據(jù)集具有以下6個(gè)特征:

推文的極性

推文的ID

推文的日期

問題

推文的用戶名

推文的文本

大小:80 MB(壓縮)

記錄數(shù)量:160,000條推文

SOTA:Assessing State-of-the-Art Sentiment Models on State-of-the-Art Sentiment Datasets

WordNet

在上面的ImageNet數(shù)據(jù)集中提到,WordNet是一個(gè)很大的英文同義詞集。 同義詞集是每個(gè)都描述了不同的概念的同義詞組。WordNet的結(jié)構(gòu)使其成為NLP非常有用的工具。

大小:10 MB

記錄數(shù)量:117,000個(gè)同義詞集通過少量“概念關(guān)系”與其他同義詞集相關(guān)聯(lián)。

SOTA:Wordnets: State of the Art and Perspectives

Yelp Reviews

這是Yelp為了學(xué)習(xí)目的而發(fā)布的一個(gè)開源數(shù)據(jù)集。它包含了由數(shù)百萬用戶評(píng)論,商業(yè)屬性和來自多個(gè)大都市地區(qū)的超過20萬張照片。這是一個(gè)非常常用的全球NLP挑戰(zhàn)數(shù)據(jù)集。

大小:2.66 GB JSON,2.9 GB SQL和7.5 GB照片(全部壓縮)

記錄數(shù)量:5,200,000條評(píng)論,174,000條商業(yè)屬性,20萬張圖片和11個(gè)大都市區(qū)

SOTA:Attentive Convolution

The Wikipedia Corpus

這個(gè)數(shù)據(jù)集是維基百科全文的集合。它包含來自400多萬篇文章的將近19億字。使得這個(gè)成為強(qiáng)大的NLP數(shù)據(jù)集的是你可以通過單詞,短語或段落本身的一部分進(jìn)行搜索。

大小:20 MB

記錄數(shù)量:4,400,000篇文章,19億字

SOTA:Breaking The Softmax Bottelneck: A High-Rank RNN language Model

The Blog Authorship Corpus

這個(gè)數(shù)據(jù)集包含了從blogger.com收集的數(shù)千名博主的博客帖子。每個(gè)博客都作為一個(gè)單獨(dú)的文件提供。每個(gè)博客至少包含200個(gè)常用英語單詞。

大小:300 MB

記錄數(shù)量:681,288個(gè)帖子,超過1.4億字

SOTA:Character-level and Multi-channel Convolutional Neural Networks for Large-scale Authorship Attribution

Machine Translation of Various Languages

此數(shù)據(jù)集包含四種歐洲語言的訓(xùn)練數(shù)據(jù)。這里的任務(wù)是改進(jìn)當(dāng)前的翻譯方法。您可以參加以下任何語言組合:

英語-漢語和漢語-英語

英語-捷克語和捷克語-英語

英語-愛沙尼亞語和愛沙尼亞語-英語

英語-芬蘭語和芬蘭語-英語

英語-德語和德語-英語

英語-哈薩克語和哈薩克語-英語

英文-俄文和俄文-英文

英語-土耳其語和土耳其語-英語

大小:?15 GB

記錄數(shù)量:約30,000,000個(gè)句子及其翻譯

SOTA:Attention Is All You Need

▌音頻/語音處理

Free Spoken Digit Dataset

此列表中的另一個(gè)被MNIST啟發(fā)而創(chuàng)建的數(shù)據(jù)集!這是為了解決識(shí)別音頻樣本中的口頭數(shù)字而創(chuàng)建。這是一個(gè)開源數(shù)據(jù)集,所以希望隨著人們繼續(xù)貢獻(xiàn)更多樣本幫助它不斷成長。目前,它包含以下特點(diǎn):

3個(gè)說話者

1500個(gè)錄音(每個(gè)數(shù)字每個(gè)說話者讀50個(gè))

英語發(fā)音

大小:10 MB

記錄數(shù)量:1500個(gè)音頻樣本

SOTA:Raw Waveform-based Audio Classification Using Sample-level CNN Architectures

Free Music Archive (FMA)

FMA是一個(gè)音樂分析的數(shù)據(jù)集。數(shù)據(jù)集包括了完整長度和HQ音頻,預(yù)先計(jì)算的特征,以及音軌和用戶級(jí)元數(shù)據(jù)。它是一個(gè)用于評(píng)估MIR中的一些任務(wù)的開源數(shù)據(jù)集。下面是數(shù)據(jù)集的csv文件列表以及它們包含的內(nèi)容:

tracks.csv:每首曲目元數(shù)據(jù),如ID,標(biāo)題,藝術(shù)家,流派,標(biāo)簽和播放次數(shù),共106,574首曲目

genres.csv:所有163種風(fēng)格的ID與他們的名字和起源(用于推斷流派層次和頂級(jí)流派)。

features.csv:用librosa提取的常用特征。

echonest.csv:由Echonest(現(xiàn)在的Spotify)提供的為13,129首音軌的子集的音頻功能。

大小:?1000 GB

記錄數(shù)量:約100,000軌道

SOTA:Learning to Recognize Musical Genre from Audio

Ballroom

該數(shù)據(jù)集包含舞池跳舞音頻文件。以真實(shí)音頻格式提供了許多舞蹈風(fēng)格的一些特征摘錄。以下是數(shù)據(jù)集的一些特點(diǎn):

實(shí)例總數(shù):698

持續(xù)時(shí)間:約30秒

總持續(xù)時(shí)間:約20940秒

大小:14GB(壓縮)

記錄數(shù)量:約700個(gè)音頻樣本

SOTA:A Multi-Model Approach To Beat Tracking Considering Heterogeneous Music Styles

Million Song Dataset

Million Song Dataset是免費(fèi)的一百萬首當(dāng)代流行音樂曲目的音頻特征和元數(shù)據(jù)集合。其目的是:

鼓勵(lì)對(duì)擴(kuò)大到商業(yè)規(guī)模的算法進(jìn)行研究

為評(píng)估研究提供參考數(shù)據(jù)集

作為使用API創(chuàng)建大型數(shù)據(jù)集的捷徑(例如The Echo Nest)

幫助新研究人員在MIR領(lǐng)域開始工作

數(shù)據(jù)集的核心是一百萬首歌曲的特征分析和元數(shù)據(jù)。這個(gè)數(shù)據(jù)集不包含任何音頻,只是派生的功能。示例音頻可以通過使用哥倫比亞大學(xué)提供的code從7digital等服務(wù)中獲取。

大小:280 GB

記錄數(shù)量:PS - 它的一百萬首歌曲!

SOTA:Preliminary Study on a Recommender System for the Million Songs Dataset Challenge

LibriSpeech

該數(shù)據(jù)集是大約1000小時(shí)的英語演講的大型語料庫。這些數(shù)據(jù)來自LibriVox項(xiàng)目的有聲讀物。它們已被分割并適當(dāng)對(duì)齊。如果您正在尋找一個(gè)起點(diǎn),請(qǐng)查看在kaldi-asr.org和語言模型上進(jìn)行了訓(xùn)練了的已準(zhǔn)備好的聲學(xué)模型,這些模型適合在http://www.openslr.org/11/進(jìn)行評(píng)測。

大小:?60 GB

記錄數(shù)量:1000小時(shí)的演講

SOTA:Letter-Based Speech Recognition with Gated ConvNets

VoxCeleb

VoxCeleb是一個(gè)大規(guī)模演講者識(shí)別數(shù)據(jù)集。它包含了來自YouTube視頻的約1,251位知名人士的約10萬個(gè)話語。數(shù)據(jù)大部分是性別平衡的(男性占55%)。這些名人橫跨不同的口音,職業(yè)和年齡。開發(fā)和測試集之間沒有重疊。對(duì)于獨(dú)立和識(shí)別哪個(gè)超級(jí)巨星的音頻來說,這是一個(gè)有趣的使用案例。

大小:150 MB

記錄數(shù)量:1,251位名人的100,000條話語

SOTA:VoxCeleb: a large-scale speaker identification dataset

分析Vidhya實(shí)踐問題:為了您的練習(xí),我們還提供實(shí)際生活問題和數(shù)據(jù)集讓你可以實(shí)際演練。在本節(jié)中,我們列舉了在我們DataHack平臺(tái)上的深度學(xué)習(xí)實(shí)踐問題。

Twitter Sentiment Analysis

仇恨型演講以種族主義和性別歧視為形式的言論已成為推特上的麻煩事,重要的是將這類推文與其他的分開。在這個(gè)實(shí)際問題中,我們同時(shí)提供正常的和仇恨型推文的推特?cái)?shù)據(jù)。你作為數(shù)據(jù)科學(xué)家的任務(wù)是確定哪些推文是仇恨型推文,哪些不是。

大小:3 MB

記錄數(shù)量:31,962條推文

Age Detection of Indian Actors

對(duì)于任何深度學(xué)習(xí)愛好者來說,這是一個(gè)令人著迷的挑戰(zhàn)。該數(shù)據(jù)集包含數(shù)千個(gè)印度演員的圖像,你的任務(wù)是確定他們的年齡。所有圖像都是手動(dòng)選擇,并從視頻幀中剪切的,這使得尺度,姿勢,表情,照度,年齡,分辨率,遮擋和化妝的高度干擾性。

大小:48 MB(壓縮)

記錄數(shù)量:訓(xùn)練集中的19,906幅圖像和測試集中的6636幅圖像

SOTA:Hands on with Deep Learning – Solution for Age Detection Practice Problem

Urban Sound Classification

這個(gè)數(shù)據(jù)集包含超過8000個(gè)來自10個(gè)類別的城市聲音摘錄。這個(gè)實(shí)踐問題是為了在向您介紹常見分類方案中的音頻處理。

大小:訓(xùn)練集-3 GB(壓縮),測試集- 2 GB(壓縮)

記錄數(shù)量:來自10個(gè)類別的8732個(gè)城市聲音標(biāo)注的聲音片段(<= 4s)

如果您知道其他開源數(shù)據(jù)集,可以用來推薦其他人開始他們的深度學(xué)習(xí)/非結(jié)構(gòu)化數(shù)據(jù)集之旅,請(qǐng)隨時(shí)把它們推薦給我們并附上應(yīng)該包括這些數(shù)據(jù)集的原因。

如果原因很好,我會(huì)把它們列入清單。我們非常歡迎您在評(píng)論區(qū)域讓我們知道使用這些數(shù)據(jù)集的經(jīng)驗(yàn)。最后祝大家學(xué)習(xí)愉快!

-

圖像處理

+關(guān)注

關(guān)注

27文章

1300瀏覽量

56890 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5513瀏覽量

121546 -

自然語言

+關(guān)注

關(guān)注

1文章

291瀏覽量

13398

原文標(biāo)題:資源 | 25個(gè)深度學(xué)習(xí)開源數(shù)據(jù)集

文章出處:【微信號(hào):AI_Thinker,微信公眾號(hào):人工智能頭條】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

#硬聲創(chuàng)作季 #深度學(xué)習(xí) 深度學(xué)習(xí)基礎(chǔ)-1.2.1 數(shù)據(jù)集及其拆分

計(jì)算機(jī)視覺/深度學(xué)習(xí)領(lǐng)域常用數(shù)據(jù)集匯總

LSM6DSM示例代碼哪里可以獲得

哪里可以獲得CYW54907+評(píng)估板?

哪里可以獲得有關(guān)簽證命令SCPI的手冊(cè)

請(qǐng)問我在哪里可以獲得Discovery固件庫?

從哪里可以獲得我的機(jī)器的主機(jī)ID?

什么是深度學(xué)習(xí)?使用FPGA進(jìn)行深度學(xué)習(xí)的好處?

哪里可以獲得近距離通信設(shè)備(SRD)的規(guī)范?

谷歌為何對(duì)深度學(xué)習(xí)感興趣?

如何在Hadoop上運(yùn)行這些深度學(xué)習(xí)工作

深度學(xué)習(xí)數(shù)據(jù)集,哪里可以獲得這些數(shù)據(jù)?

深度學(xué)習(xí)數(shù)據(jù)集,哪里可以獲得這些數(shù)據(jù)?

評(píng)論