編者按:自然語言推理所用的數(shù)據(jù)集再近年得到了研究和發(fā)展,但是在本文中,來自華盛頓大學(xué)、卡內(nèi)基梅隆大學(xué)和紐約大學(xué)等機(jī)構(gòu)的研究人員發(fā)現(xiàn),這些數(shù)據(jù)集中不可避免出現(xiàn)了明顯的“人工痕跡”,使得模型的表現(xiàn)被高估了,評(píng)估自然語言推理模型的問題仍然存在。以下是論智的編譯。

自然語言推理是NLP領(lǐng)域被廣泛研究的領(lǐng)域之一,有了這一技術(shù),許多復(fù)雜的語義任務(wù)如問題回答和文本總結(jié)都能得到解決。而用于自然語言推理的大規(guī)模數(shù)據(jù)集是通過向眾包工作者提供一個(gè)句子(前提)p,然后讓他們創(chuàng)作出三個(gè)新的與之相關(guān)的句子(假設(shè))h創(chuàng)造出來的。自然語言推理的目的就是判斷是否能根據(jù)p的語義推斷出h。我們證明,利用這種方法,使得數(shù)據(jù)中的很大一部分只需查看新生成的句子,無需看“前提”,就能了解到數(shù)據(jù)的標(biāo)簽。具體來說,一個(gè)簡單的文本分類模型在SNLI數(shù)據(jù)集上對(duì)句子分類的正確率達(dá)到了67%,在MultiNLI上的正確率為53%。分析表明,特定的語言現(xiàn)象,比如否定和模糊與某些推理類別非常相關(guān)。所以這一研究表示,目前的自然語言推理模型的成功被高估了,這一問題仍然難以解決。

2015年,Bowman等人通過眾包標(biāo)記的方法創(chuàng)造了大規(guī)模推斷數(shù)據(jù)集SNLI;2018年,Williams等人又推出了MultiNLI數(shù)據(jù)集。在這一過程中,研究人員從一些語料中抽取某個(gè)前提句子p,讓眾包標(biāo)注者基于p創(chuàng)作三個(gè)新句子,創(chuàng)作的句子與p有三種關(guān)系標(biāo)準(zhǔn):

包含(Entailment):h與p非常相關(guān);

中立(Neutral):h與p可能相關(guān);

矛盾(Contradiction):h與p絕對(duì)不相關(guān)。

下面是SNLI數(shù)據(jù)集中具體的例子:

在這篇論文中,我們發(fā)現(xiàn),通過眾包生成的句子人工痕跡太過明顯,以至于分類器無需查看條件句子p就能將其正確分類。下面我們將詳細(xì)講解分析過程。

注釋中的“人工痕跡”其實(shí)很明顯

我們猜想,注釋任務(wù)的框架對(duì)眾包人員編寫句子時(shí)會(huì)產(chǎn)生顯著的影響,這一影響會(huì)反映在數(shù)據(jù)中,我們稱之為“人工注釋(annotation artifacts)”。

為了確定這種人為行為對(duì)數(shù)據(jù)的影響程度,我們訓(xùn)練一個(gè)模型來預(yù)測生成句子的標(biāo)簽,無需查看前提句子。具體來說,我們使用現(xiàn)成的文本分類器fastText,它可以將文本模型化為許多單詞和二元語法(bigrams),以預(yù)測句子的標(biāo)簽。

下表顯示,每個(gè)測試集中大部分?jǐn)?shù)據(jù)都能在不看前提句子的情況下被正確分類,這也證明了即使不用對(duì)自然語言推理建模,分類器也能表現(xiàn)得很好。

人工注釋的特點(diǎn)

之前我們說到,超過一半的MultiNLI數(shù)據(jù)和三分之二的SNLI數(shù)據(jù)都有明顯的人工痕跡,為了從中總結(jié)出它們的特點(diǎn),我們將對(duì)數(shù)據(jù)進(jìn)行大致分析,重點(diǎn)關(guān)注詞匯的選擇和句子的長度。

詞匯選擇

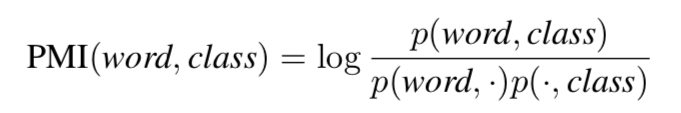

為了了解特定詞匯的選擇是否會(huì)影響句子的分類,我們計(jì)算了訓(xùn)練集中每個(gè)單詞和類別之間的點(diǎn)互信息(PMI):

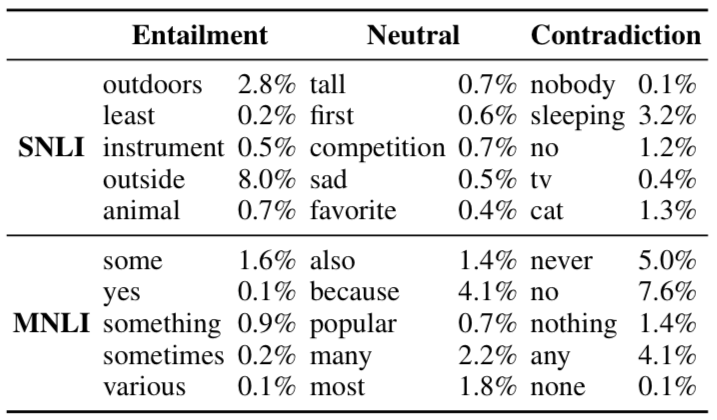

下表顯示了每個(gè)分類中與類別最相關(guān)的幾個(gè)單詞,以及訓(xùn)練語句中包含這些單詞的比例。

相關(guān)句子(Entailment)

與前提句子完全相關(guān)的生成句子都含有通用詞匯,如動(dòng)物、樂器和戶外等,這些詞語還有可能衍生出更具體的詞語例如小狗、吉他、沙灘等等。另外,這些據(jù)此都會(huì)用確切的數(shù)字代替近似值(一些、至少、各種等等),并且會(huì)移除明確的性別。有些還會(huì)帶有具體的環(huán)境,例如室內(nèi)或室外,這些都是SNLI數(shù)據(jù)集中圖片的個(gè)性特征。

中立句子

中立關(guān)系的句子中,最常見的就是修飾詞(高、悲傷、受歡迎)和最高級(jí)詞語(第一、最愛、最多)。除此之外,中立句子比較常見的是原因和目的從句,例如因?yàn)椤?/p>

不相關(guān)句子

否定詞例如“沒有人”、“不”、“從不”、“沒有”等都是不相關(guān)句子的常見詞語。

句子長度

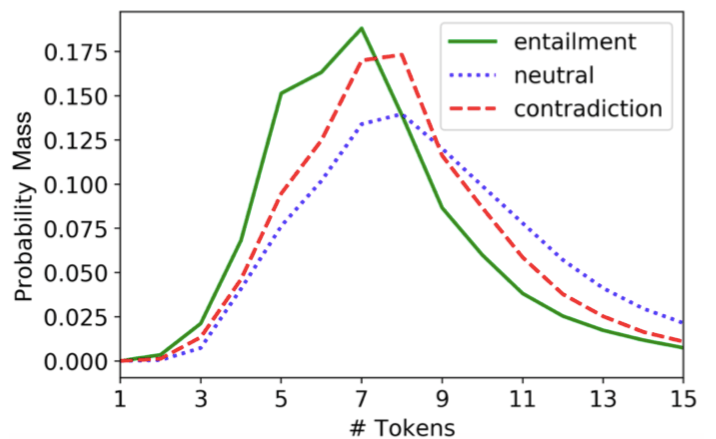

我們發(fā)現(xiàn),生成句子中tokens的數(shù)量在不同的推理類別中并不是平均分配的。下圖顯示,中性的句子中token往往較長,而相關(guān)句子往往較短。句子長度的差異可能表明,眾包工作者在生成相關(guān)句子時(shí)只是簡單地從前提句子p中刪除了幾個(gè)單詞。而事實(shí)上,當(dāng)每個(gè)句子都用bag of words表示時(shí),SNLI中有8.8%的相關(guān)生成句子完全包含在前提句子之中,而只有0.2%的中性和矛盾句子包含前提。

結(jié)論

通過觀察結(jié)果,并對(duì)比其他人工注釋分析,我們得到了三個(gè)主要結(jié)論。

很多數(shù)據(jù)集都包含有“人工痕跡”

監(jiān)督模型需要利用人工注釋。Levy等人證明了監(jiān)督詞匯推理模型在很大程度上以來數(shù)據(jù)集中人工生成的詞匯。

人工注釋會(huì)高估模型性能。大多數(shù)測試集都能單獨(dú)依靠人工注釋解決問題,所以我們鼓勵(lì)開發(fā)額外的標(biāo)準(zhǔn),能夠給讓人了解NLI模型的真實(shí)性能。

-

自然語言

+關(guān)注

關(guān)注

1文章

291瀏覽量

13398

原文標(biāo)題:自然語言推理數(shù)據(jù)集“人工痕跡”嚴(yán)重,模型性能被高估

文章出處:【微信號(hào):jqr_AI,微信公眾號(hào):論智】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

PyTorch教程-16.7。自然語言推理:微調(diào) BERT

【大語言模型:原理與工程實(shí)踐】揭開大語言模型的面紗

python自然語言

什么是人工智能、機(jī)器學(xué)習(xí)、深度學(xué)習(xí)和自然語言處理?

一種注意力增強(qiáng)的自然語言推理模型aESIM

PyTorch教程16.4之自然語言推理和數(shù)據(jù)集

PyTorch教程16.5之自然語言推理:使用注意力

PyTorch教程16.7之自然語言推理:微調(diào)BERT

自然語言推理數(shù)據(jù)集“人工痕跡”嚴(yán)重,模型性能被高估

自然語言推理數(shù)據(jù)集“人工痕跡”嚴(yán)重,模型性能被高估

評(píng)論