兩個國產推理模型的發布,讓全球AI圈“提前過年”了。

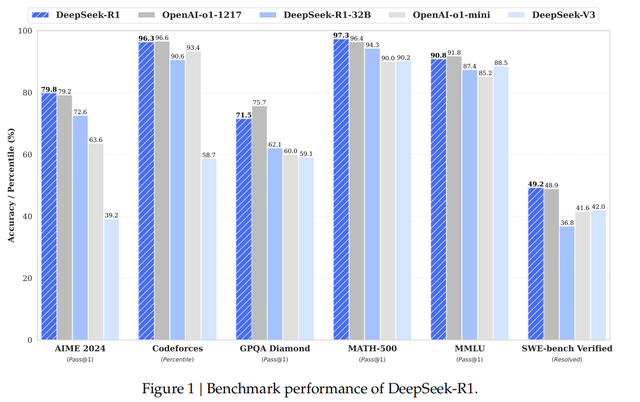

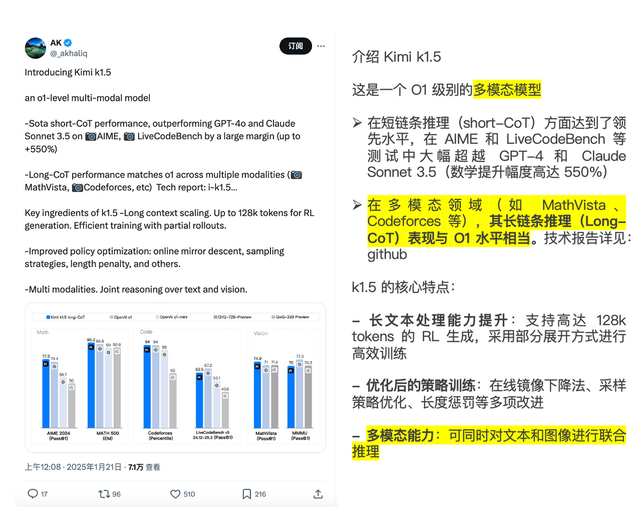

前兩天,月之暗面推出了Kimi k1.5多模態思考模型,DeepSeek也發布了DeepSeek-R1文本推理模型,二者都在推理能力上對標OpenAI正式版o1。

不到兩個月,國產推理模型就實現了對OpenAI o1滿血版(2024年12月上線)的對標,而且與OpenAI藏著掖著的技術秘訣不同,兩家中國公司雙雙公開了他們的特色技術道理:DeepSeek R1的極高性價比,kimi k1.5原創技術long2short 高效思維鏈+原生多模態。

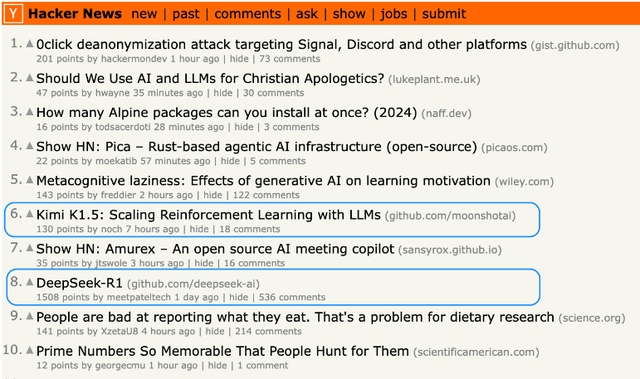

因此Kimi/DeepSeek“雙子星”一夜卷翻硅谷,技術報告paper一放出,就吸引了大量海內外同行的關注和解讀,在github的熱度飆升。

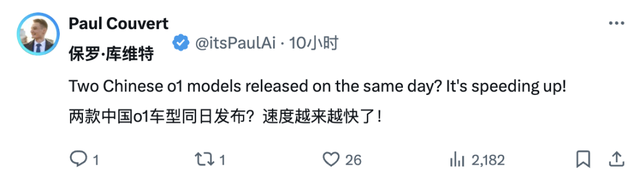

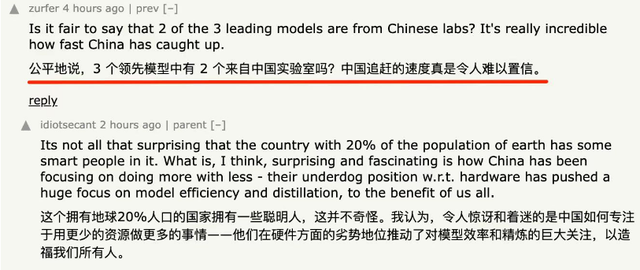

目前來看,海外同行的反饋以振奮為主流。比如Answera公司的創始人保羅·庫弗特(Paul Couvert)就感嘆,兩款中國o1同日發布,(中國AI)追趕速度越來越快了!

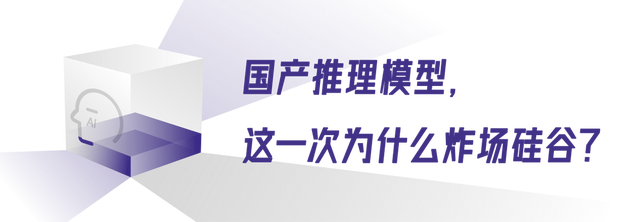

當然,自然也少不了“潑冷水”的。

OpenAI CEO奧特曼在社交媒體說,“twitter hype is out of control”(推特上的各種炒作已經失控了)。他認為外界猜測的“AI即將取代大部分中層崗位”(主要靠推理模型)過度夸大了。希望大家冷靜下來,把期待值降低100倍(cut your expectations 100x)。

或許有人好奇,國產推理模型真的崛起了嗎?大模型技術如何從“規模擴展”發展到“推理擴展”?對于推理模型這個路線,我們到底該保持興奮還是冷靜一下?本文就來給大家一一解讀。

兩個中國AI公司的新模型,吸引了全球海內外同行的高度關注。原因很簡單,推理模型太火了。

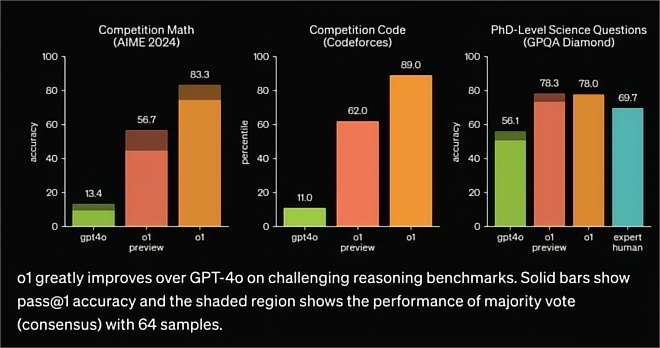

2024年第四季度,出現了reasoning model的新形態LLM,采用思維鏈進行“慢思考”,在推理階段投入更多計算(推理拓展思路),這種創新帶給大模型超前的推理能力,可以減少幻覺,提高可靠性,處理更為復雜的任務,達到人類專家/研究生級別的智能,被認為是規模拓展Scaling Law撞墻后最具潛力的新技術。

o1系列之后,頭部模廠都開始向“慢思考”的推理模型技術路線投入,包括大廠谷歌、百度、阿里、科大訊飛、夸克,以及AI六小虎中的智譜、DeepSeek、階躍星辰等,此前也都推出過準o1的推理模型,但一直沒有全面對標正式版o1的國產推理模型。

要證明國產推理模型的崛起,有兩個前提條件:一是經得起全球同行的審視;二是具備原創能力而非簡單跟隨,全面對標而非部分達標。

目前來看,Kimi k1.5/ DeepSeeK R1達到了上述條件。

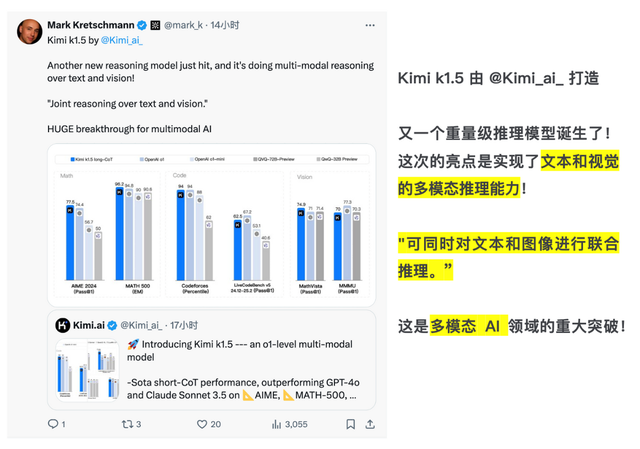

Kimi k1.5/ DeepSeeK R1首次真正對標了正式版o1,取得了SOTA成績。其中,k1.5還是國內首個多模態o1,同時支持文本和圖像推理。這在全球推理模型領域都是比較亮眼的成績。

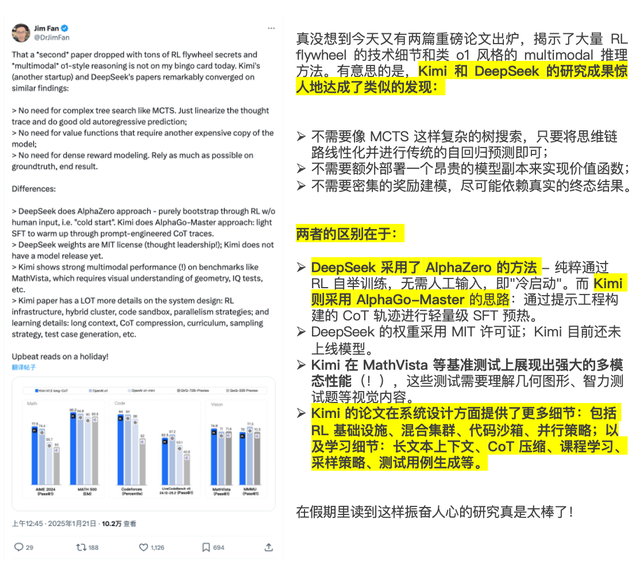

而且,不同于OpenAI o1藏著掖著的風格,Kimi和DeepSeeK都發布了詳細的技術報告,分享模型訓練技術的探索經驗,立刻在海外AI圈掀起了解讀論文的熱潮。

比如英偉達的研究科學家第一時間開扒,得出的結論是,Kimi和DeepSeeK的研究“振奮人心”。

作為當前AI領域最主流的敘事和技術高地,推理模型的風吹草動,都會引發全球從業者的目光。而中國公司一口氣在推理模型賽道上,拿出兩個重磅論文,模型含金量高,經過了目光聚焦且嚴苛的審視,其中還包含很多原創技術。

可以說,從Kimi k1.5/ DeepSeeK R1的“雙子星”開始,國產推理模型是真的崛起了。

推理模型,國內AI公司是怎么追趕的?我們和海外AI圈一起“黑著眼眶熬著夜”,苦讀kimi/ DeepSeek論文,簡單總結一下:

總路線上,k1.5和R1都使用了強化學習(RL)技術,來提升模型推理能力。但在技術細節上,kimi/ DeepSeek都拿出了全新的思路。

DeepSeek沒有采用業界普遍的監督微調(SFT)作為冷啟動的方案,提出了一種多階段循環的訓練方式,用少量冷啟動數據,微調模型作為強化學習的起點,然后在RL環境中通過獎勵信號來自我進化,實現了非常好的推理效果。

Kimi k1.5則首創了long2short思維鏈,讓LLM通過獎勵機制進行探索性學習,自主擴展訓練數據,來擴展上下文長度,從而優化RL訓練表現,在短鏈思維推理方面取得了SOTA成績。

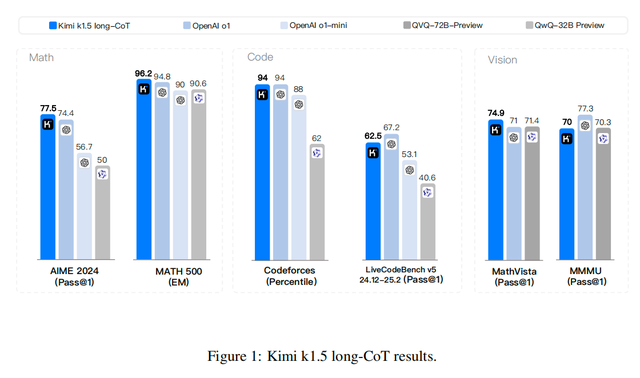

性能最強的long-CoT版本Kimi k1.5,數學、代碼、多模態推理能力可以達到長思考SOTA模型OpenAI o1正式版的水平。

基于long-CoT版本簡化的short-CoT,性能依舊強悍,但推理更加高效,大幅超越了全球范圍內短思考SOTA模型GPT-4o和Claude 3.5 Sonnet的水平,領先達到550%。

除此之外,兩大國產推理模型還各有亮點。

DeepSeek-R1延續了“AI界拼多多”的優秀傳統,API每百萬輸出tokens 16 元,與o1每百萬輸出tokens 60美元的定價一比,性價比拉滿。

Kimi k1.5則是OpenAI之外,首個達到o1多模態推理性能的模型,k1.5支持文本、圖像交疊的多模態輸入,可以進行聯合推理,填補了國內多模態思考模型的空白。

在人類的感官中,視覺信息占比超過70%,有了多模態能力,認識自家的Benchmark圖表自然不在話下。

眾所周知,o1要么用起來貴(200美元每月的訂閱費),要么根本用不上(OpenAI不向國內提供服務)。因此,國產推理模型的上述亮點,帶給海內外AI開發者的價值不是一般大,很多開發者都倍感興奮。

一位開發者在論壇感嘆,這兩個中國實驗室“用更少的資源做更多的事情,他們對模型效率和精煉的巨大關注,造福我們所有人”。

Amarok開發者Mark Kretschmann也在社交媒體上不吝褒獎,直呼k1.5是“多模態AI領域的重大突破”。

可以看到,面對“推理拓展”這個全新技術領域,中國AI“雙子星”靠原創硬實力穩穩拿下,并走出了一條有別于OpenAI的發展創新之路。

OpenAI奧特曼建議大家放低預期,那么,中國AI公司發力推理模型,價值究竟有沒有、有多大?

對于中國AI公司來說,點亮推理模型的技術版圖,有兩方面的意義:

一是仰望星空,可以拉近中美AI的技術距離。大模型的領先不會從天上掉下來,而是日拱一卒、水滴石穿的努力,保持對最新技術路線的跟進,能讓中國AI的水平快速提高。對標ChatGPT用了半年左右,而對標正式版o1只用了不到三個月,

以Kimi為例,去年11月推出k0-math數學模型,12月發布k1視覺思考模型,今年1月發布k1.5多模態思考模型,三個月三次迭代,進化速度極快。說明對天花板技術的貼身跟進,是中國AI最快最好的練兵場。

二是腳踏實地,中國的行業沃土為國產AI提供了更廣闊的落地場景,推理模型的落地情況會比o1更好。海外AI多以個人消費者為主,o1的主要用例是程序員的代碼助手、數據分析師、個人開發者,普通人上手門檻高。而國產大模型更多面向行業場景,AI改造的業務場景中包含大量容錯率低的嚴肅生產場景,以前的大語言模型很難解決復雜任務,十分需要少幻覺、高可靠的推理模型。所以,國產推理模型的落地也許會更快、更廣。

從這些角度看,在各行各業引入專家級AI的推理模型,加速行業智能化,恐怕仍會由國產AI率先垂范。k1.5、R1等國產推理模型,將在其中貢獻不可或缺的基座價值。Kimi官方也表示,2025會繼續沿著路線圖,加速升級k系列強化學習模型,帶來更多模態、更多領域的能力和更強的通用能力。

所以不出預料的話,我們很快就能用上花錢少、出活好的專家級國產AI了。

中國AI“雙子星”炸開的2025年大模型開局,分外精彩。推理模型作為模廠的下一個分水嶺,誰抓住了國產推理模型的崛起時刻,也就先一步抓住了未來。

審核編輯 黃宇

-

AI

+關注

關注

87文章

31513瀏覽量

270308 -

硅谷

+關注

關注

1文章

123瀏覽量

16572 -

模型

+關注

關注

1文章

3305瀏覽量

49217

發布評論請先 登錄

相關推薦

OpenAI發布o1大模型,數理化水平比肩人類博士,國產云端推理芯片的新藍海?

對標OpenAI o1,DeepSeek-R1發布

TMS320C54x DSP CPU和外設參考集,第1卷

國產AI卷翻硅谷,奧特曼發文“陰陽”,類o1模型都在卷什么?

國產AI卷翻硅谷,奧特曼發文“陰陽”,類o1模型都在卷什么?

評論