一、XGBoost超參數(shù)調(diào)優(yōu)技巧

XGBoost(eXtreme Gradient Boosting)是一種基于梯度提升決策樹(GBDT)的高效梯度提升框架,在機(jī)器學(xué)習(xí)競賽和實際業(yè)務(wù)應(yīng)用中取得了卓越的成績。然而,XGBoost模型涉及眾多超參數(shù),這些參數(shù)的組合和調(diào)優(yōu)對于模型性能至關(guān)重要。以下是一些XGBoost超參數(shù)調(diào)優(yōu)的技巧:

- 理解主要超參數(shù) :

- 學(xué)習(xí)率(Learning Rate) :控制每次迭代更新模型時的步長。較小的學(xué)習(xí)率可以使模型在訓(xùn)練過程中更加穩(wěn)定,但可能導(dǎo)致收斂速度變慢;較大的學(xué)習(xí)率可能加速收斂,但也可能導(dǎo)致模型過擬合。

- 樹的最大深度(Max Depth) :限制決策樹的最大深度,有助于防止模型過擬合。較深的樹能夠捕獲更多的數(shù)據(jù)特征,但也可能導(dǎo)致模型在訓(xùn)練集上過擬合。

- 最大迭代次數(shù)(Number of Boosting Rounds) :控制模型迭代的次數(shù)。迭代次數(shù)過少可能導(dǎo)致模型欠擬合,迭代次數(shù)過多則可能導(dǎo)致過擬合。

- 交叉驗證與早停 :

- 使用交叉驗證(如K折交叉驗證)來評估模型性能,以選擇最佳的迭代次數(shù)和防止過擬合。

- 引入早停(Early Stopping)策略,在驗證集性能不再提升時停止訓(xùn)練,避免模型在訓(xùn)練集上過擬合。

- 網(wǎng)格搜索與隨機(jī)搜索 :

- 網(wǎng)格搜索(Grid Search)通過遍歷給定的參數(shù)組合來尋找最佳參數(shù)。雖然這種方法能夠找到全局最優(yōu)解,但計算量大,耗時長。

- 隨機(jī)搜索(Random Search)通過隨機(jī)選擇參數(shù)組合進(jìn)行搜索,可以在有限的計算資源下找到較好的參數(shù)組合。

- 貝葉斯優(yōu)化 :

- 貝葉斯優(yōu)化利用目標(biāo)函數(shù)的先驗知識,通過構(gòu)建概率模型來指導(dǎo)搜索過程,能夠在較少的迭代次數(shù)內(nèi)找到較好的參數(shù)組合。

- 粒子群優(yōu)化算法 :

- 正則化與剪枝 :

- 正則化項(如L1、L2正則化)有助于防止模型過擬合,通過增加模型的復(fù)雜度懲罰項來限制模型的復(fù)雜度。

- 剪枝技術(shù)可以減少決策樹的分支數(shù)量,從而降低模型的復(fù)雜度并提高泛化能力。

- 特征選擇與縮放 :

- 對特征進(jìn)行選擇和縮放有助于提高模型的性能和穩(wěn)定性。選擇重要的特征可以減少噪聲和冗余信息對模型的影響;縮放特征可以確保所有特征在相同的尺度上,有助于模型更好地學(xué)習(xí)數(shù)據(jù)特征。

- 模型評估與選擇 :

- 使用多種評估指標(biāo)(如準(zhǔn)確率、精確率、召回率、F1值等)來全面評估模型性能。

- 根據(jù)具體任務(wù)和數(shù)據(jù)集特點選擇合適的評估指標(biāo)和模型類型(如分類、回歸等)。

二、XGBoost在圖像分類中的應(yīng)用

雖然XGBoost在分類、回歸和排序等任務(wù)中都表現(xiàn)出色,但它在圖像分類領(lǐng)域的應(yīng)用相對較少。這主要是因為圖像分類任務(wù)通常需要處理高維數(shù)據(jù)(如像素值、顏色特征等),而XGBoost主要適用于處理結(jié)構(gòu)化數(shù)據(jù)(如表格數(shù)據(jù))。然而,通過一些轉(zhuǎn)換和預(yù)處理步驟,XGBoost仍然可以在圖像分類任務(wù)中發(fā)揮一定的作用。以下是一些XGBoost在圖像分類中的應(yīng)用方法和注意事項:

- 特征提取與轉(zhuǎn)換 :

- 使用卷積神經(jīng)網(wǎng)絡(luò)(CNN)等深度學(xué)習(xí)模型提取圖像特征。CNN能夠從原始圖像中學(xué)習(xí)并提取有用的特征表示,這些特征可以用于后續(xù)的XGBoost分類任務(wù)。

- 將提取的特征轉(zhuǎn)換為適合XGBoost輸入的結(jié)構(gòu)化數(shù)據(jù)格式。這通常涉及將特征向量展平為一維數(shù)組或?qū)⑵滢D(zhuǎn)換為其他適合XGBoost處理的數(shù)據(jù)結(jié)構(gòu)。

- 數(shù)據(jù)預(yù)處理與增強(qiáng) :

- 對圖像數(shù)據(jù)進(jìn)行預(yù)處理和增強(qiáng)以提高模型的泛化能力。這包括調(diào)整圖像大小、歸一化像素值、應(yīng)用數(shù)據(jù)增強(qiáng)技術(shù)(如旋轉(zhuǎn)、翻轉(zhuǎn)、裁剪等)等步驟。

- 注意保持預(yù)處理和增強(qiáng)步驟的一致性,以確保模型在訓(xùn)練和測試階段能夠處理相同類型的數(shù)據(jù)。

- 模型訓(xùn)練與調(diào)優(yōu) :

- 使用提取的特征和預(yù)處理后的數(shù)據(jù)訓(xùn)練XGBoost模型。在訓(xùn)練過程中,可以根據(jù)需要調(diào)整XGBoost的超參數(shù)以優(yōu)化模型性能。

- 注意監(jiān)控模型的過擬合情況,并使用交叉驗證和早停策略來防止過擬合。同時,可以利用特征重要性分析來識別對分類結(jié)果影響最大的特征。

- 模型評估與應(yīng)用 :

- 使用驗證集或測試集對訓(xùn)練好的XGBoost模型進(jìn)行評估。根據(jù)評估結(jié)果調(diào)整模型參數(shù)或特征提取方法以進(jìn)一步提高性能。

- 將訓(xùn)練好的模型應(yīng)用于實際圖像分類任務(wù)中。注意處理輸入數(shù)據(jù)的格式和預(yù)處理步驟以確保模型能夠正確處理新的圖像數(shù)據(jù)。

- 與其他模型的比較 :

- 將XGBoost與其他圖像分類模型(如CNN、支持向量機(jī)、隨機(jī)森林等)進(jìn)行比較以評估其性能。這有助于了解XGBoost在圖像分類任務(wù)中的優(yōu)勢和局限性。

需要注意的是,雖然XGBoost在圖像分類任務(wù)中可以通過特征提取和轉(zhuǎn)換等方法進(jìn)行應(yīng)用,但其性能可能不如專門用于圖像分類的深度學(xué)習(xí)模型(如CNN)。因此,在選擇模型時應(yīng)根據(jù)具體任務(wù)和數(shù)據(jù)集特點進(jìn)行權(quán)衡和選擇。

綜上所述,XGBoost超參數(shù)調(diào)優(yōu)技巧包括理解主要超參數(shù)、交叉驗證與早停、網(wǎng)格搜索與隨機(jī)搜索、貝葉斯優(yōu)化、粒子群優(yōu)化算法、正則化與剪枝、特征選擇與縮放以及模型評估與選擇等方面。在圖像分類任務(wù)中,XGBoost可以通過特征提取與轉(zhuǎn)換、數(shù)據(jù)預(yù)處理與增強(qiáng)、模型訓(xùn)練與調(diào)優(yōu)、模型評估與應(yīng)用等方法進(jìn)行應(yīng)用,但需要注意其性能可能不如專門用于圖像分類的深度學(xué)習(xí)模型。

-

參數(shù)

+關(guān)注

關(guān)注

11文章

1859瀏覽量

32427 -

圖像分類

+關(guān)注

關(guān)注

0文章

93瀏覽量

11956 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8438瀏覽量

133078 -

XGBoost

+關(guān)注

關(guān)注

0文章

16瀏覽量

2243

發(fā)布評論請先 登錄

相關(guān)推薦

常見xgboost錯誤及解決方案

使用Python實現(xiàn)xgboost教程

xgboost與LightGBM的優(yōu)勢對比

xgboost的并行計算原理

xgboost在圖像分類中的應(yīng)用

卡爾曼濾波在圖像處理中的應(yīng)用實例 如何調(diào)優(yōu)卡爾曼濾波參數(shù)

MCF8316A調(diào)優(yōu)指南

MCT8316A調(diào)優(yōu)指南

MCT8315A調(diào)優(yōu)指南

MMC SW調(diào)優(yōu)算法

開環(huán)增益對超調(diào)量的影響

深度解析JVM調(diào)優(yōu)實踐應(yīng)用

機(jī)器學(xué)習(xí)8大調(diào)參技巧

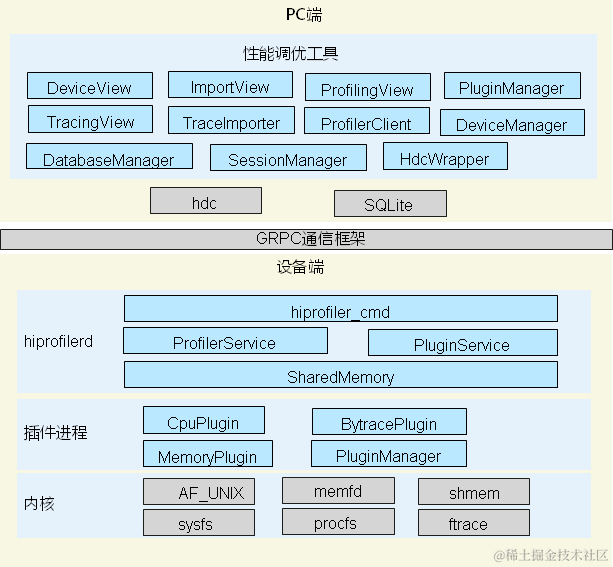

鴻蒙開發(fā)實戰(zhàn):【性能調(diào)優(yōu)組件】

xgboost超參數(shù)調(diào)優(yōu)技巧 xgboost在圖像分類中的應(yīng)用

xgboost超參數(shù)調(diào)優(yōu)技巧 xgboost在圖像分類中的應(yīng)用

評論