如果想在 AI 領域引領一輪新浪潮,就需要使用到 Transformer。

盡管名為 Transformer,但它們不是電視銀幕上的變形金剛,也不是電線桿上垃圾桶大小的變壓器。

在人工智能的快速發展中,Transformer 模型作為一種神經網絡,以其獨特的自注意力機制,引領了自然語言處理的新浪潮,以革命性的方式推動了整個行業的進步。本文將帶您深入了解 Transformer 模型的起源,探討其如何通過自注意力機制捕捉數據元素間的微妙聯系,并理解其在 AI 領域中的關鍵作用。

什么是 Transformer 模型?

Transformer 模型是一種神經網絡,通過追蹤連續數據(例如句子中的單詞)中的關系了解上下文,進而理解其含義。

Transformer 模型使用一套不斷發展的數學方法(這套方法被稱為注意力或自注意力),檢測一系列數據元素之間的微妙影響和依賴關系,包括距離遙遠的數據元素。

谷歌在 2017 年的一篇論文中首次描述了 Transformer,定義它為一種迄今為止所發明的最新、最強大的模型。這種模型正在推動機器學習領域的進步,一些人將其稱為 Transformer AI。

斯坦福大學的研究人員在 2021 年 8 月的一篇論文中將 Transformrer 稱為“基礎模型”,他們認為其推動了 AI 的范式轉變。他們在論文中寫道:“在過去幾年中,基礎模型的規模之大、范圍之廣,超出了我們的想象。”

Transformer 模型能夠做什么?

Transformer 可以近乎實時地翻譯文本和語音,為不同人群包括聽障人士提供會議和課堂服務。

它們還能幫助研究人員了解 DNA 中的基因鏈和蛋白質中的氨基酸,從而加快藥物設計的速度。

Transformer 有時也被稱為基礎模型,目前已經連同許多數據源用于大量應用中

Transformer 可通過檢測趨勢和異常現象,為防止欺詐、簡化制造流程、提供在線建議或改善醫療服務提供助力。

每當人們在谷歌或微軟必應上進行搜索時,就會用到 Transformer。

Transformer AI 的良性循環

Transformer 模型適用于一切使用連續文本、圖像或視頻數據的應用。

這使這些模型可以形成一個良性的 Transformer AI 良性循環:使用大型數據集創建而成的 Transformer 能夠做出準確的預測,從而被越來越廣泛地應用,因此產生的數據也越來越多,這些數據又被用于創建更好的模型。

斯坦福大學的研究人員表示,Transformer 標志著 AI 發展的下一個階段,有人將這個階段稱為 Transformer AI 時代

NVIDIA 創始人兼首席執行官黃仁勛在 GTC 2022 上發表的主題演講中表示:“Transformer 讓自監督學習成為可能,AI 迎來了了飛速發展的階段。”

Transformer 取代 CNN 和 RNN

Transformer 正在許多場景中取代卷積神經網絡和遞歸神經網絡(CNN 和 RNN),而這兩種模型在七年前還是最流行的深度學習模型。

事實上,在過去幾年發表的關于 AI 的 arXiv 論文中,有 70% 都提到了 Transformer。這與 2017 年 IEEE 的研究報告將 RNN 和 CNN 稱為最流行的模式識別模型時相比,變化可以說是翻天覆地。

無標記且性能更強大

在 Transformer 出現之前,用戶不得不使用大量帶標記的數據集訓練神經網絡,而制作這些數據集既費錢又耗時。Transformer 通過數學方法發現元素之間的模式,因此實現了不需要進行標記,這讓網絡和企業數據庫中的數萬億張圖像和數 PB 文本數據有了用武之地。

此外,Transformer 使用的數學方法支持并行處理,因此這些模型得以快速運行。

Transformer 目前在流行的性能排行榜上獨占鰲頭,比如 2019 年為語言處理系統開發的基準測試 SuperGLUE。

Transformer 的注意力機制

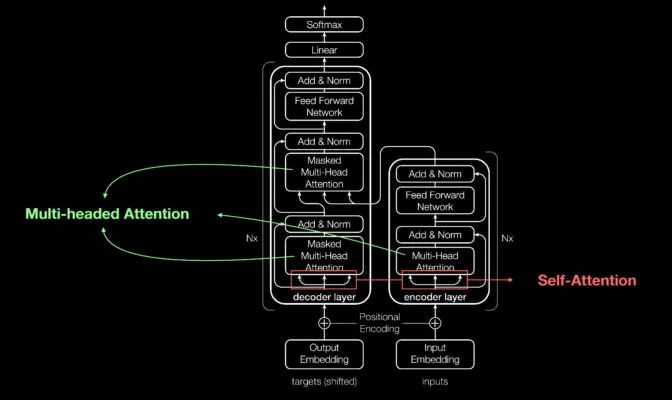

與大多數神經網絡一樣,Transformer 模型本質上是處理數據的大型編碼器/解碼器模塊。

其能夠獨占鰲頭的原因是在這些模塊的基礎上,添加了其他微小但具有戰略意義的模塊(如下圖所示)。

Aidan Gomez(2017 年定義 Transformer 的論文的 8 位共同作者之一)展示內容的概覽圖

Transformer 使用位置編碼器標記進出網絡的數據元素。注意力單元跟蹤這些標簽,計算每個元素與其他元素間關系的代數圖。

注意力查詢通常通過計算被稱為多頭注意力中的方程矩陣并行執行。

通過這些工具,計算機也能看到人類所看到的模式。

自注意力機制能夠明確意義

例如在下面的句子中:

她把壺里的水倒到杯子里,直到它被倒滿。

我們知道這里的“它”指的是杯子,而在下面的句子中:

她壺里的水倒到杯子里,直到它被倒空。

我們知道這里的“它”指的是壺。

領導 2017 年這篇開創性論文研究工作的前 Google Brain 高級研究科學家 Ashish Vaswani 表示:“意義是事物之間的關系所產生的結果,而自注意力是一種學習關系的通用方法。”

Vaswani 表示:“由于需要單詞之間的短距離和長距離關系,因此機器翻譯能夠很好地驗證自注意力。”

“現在我們已經看到,自注意力是一種強大、靈活的學習工具。”

Transformer 名稱的由來

注意力對于 Transformer 非常關鍵,谷歌的研究人員差點把這個詞作為他們 2017 年模型的名稱。

在 2011 年就開始研究神經網絡的 Vaswani 表示:“注意力網絡這個名稱不夠響亮。”

該團隊的高級軟件工程師 Jakob Uszkoreit 想出了“Transformer”這個名稱。

Vaswani 表示:“我當時覺得我們是在轉換表征,但其實轉換的只是語義。”

Transformer 的誕生

在 2017 年 NeurIPS 大會上發表的論文中,谷歌團隊介紹了他們的 Transformer 及其為機器翻譯創造的準確率記錄。

憑借一系列技術,他們僅用 3.5 天就在 8 顆 NVIDIA GPU 上訓練出了自己的模型,所用時間和成本遠低于訓練之前的模型。這次訓練使用的數據集包含多達十億對單詞。

2017 年參與這項工作并做出貢獻的谷歌實習生 Aidan Gomez 回憶道:“距離論文提交日期只有短短三個月的時間。提交論文的那天晚上,Ashish 和我在谷歌熬了一個通宵。我在一間小會議室里睡了幾個小時,醒來時正好趕上提交時間。一個來得早的人開門撞到了我的頭。”

這讓 Aidan 一下子清醒了。

“那天晚上,Ashish 告訴我,他相信這將是一件足以改變游戲規則的大事。但我不相信,我認為這只是讓基準測試進步了一點。事實證明他說得非常對。”Gomez 現在是初創公司 Cohere 的首席執行官,該公司提供基于 Transformer 的語言處理服務。

機器學習的重要時刻

Vaswani 回憶道,當看到結果超過了 Facebook 團隊使用 CNN 所得到的結果時,他感到非常興奮。

Vaswani 表示:“我覺得這可能成為機器學習的一個重要時刻。”

一年后,谷歌的另一個團隊嘗試用 Transformer 處理正向和反向文本序列。這有助于捕捉單詞之間的更多關系,提高模型理解句子意義的能力。

他們基于 Transformer 的雙向編碼器表征(BERT)模型創造了 11 項新記錄,并被加入到谷歌搜索的后臺算法中。

“由于文本是公司最常見的數據類型之一”,在短短幾周內,全球的研究人員就將 BERT 應用于多個語言和行業的用例中。Anders Arpteg,這位擁有 20 年機器學習研究經驗的專家表示,因為文本是公司最常見的數據類型之一,所以這種調整變得尤為重要。

小結

Transformer 模型的誕生標志著自然語言處理技術的一次重大飛躍。本文上篇為您揭示了這一模型的基本原理和發展歷程。隨著對 Transformer 模型的深入理解,我們可以看到其在機器翻譯、文本理解、基因序列分析等多個領域的廣泛應用,預示著 AI 技術革新與發展的無限可能。

-

AI

+關注

關注

87文章

31516瀏覽量

270333 -

模型

+關注

關注

1文章

3306瀏覽量

49223 -

Transformer

+關注

關注

0文章

145瀏覽量

6047

原文標題:什么是 Transformer 模型(一)

文章出處:【微信號:NVIDIA_China,微信公眾號:NVIDIA英偉達】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

transformer專用ASIC芯片Sohu說明

【「大模型啟示錄」閱讀體驗】如何在客服領域應用大模型

自動駕駛中一直說的BEV+Transformer到底是個啥?

【《大語言模型應用指南》閱讀體驗】+ 基礎知識學習

Transformer能代替圖神經網絡嗎

Transformer語言模型簡介與實現過程

llm模型有哪些格式

Transformer模型在語音識別和語音生成中的應用優勢

使用PyTorch搭建Transformer模型

大語言模型:原理與工程時間+小白初識大語言模型

【大語言模型:原理與工程實踐】大語言模型的基礎技術

【大語言模型:原理與工程實踐】揭開大語言模型的面紗

一文詳解Transformer神經網絡模型

Transformer模型能夠做什么

Transformer模型能夠做什么

評論