遷移學習(Transfer Learning)是機器學習領(lǐng)域中的一個重要概念,其核心思想是利用在一個任務(wù)或領(lǐng)域中學到的知識來加速或改進另一個相關(guān)任務(wù)或領(lǐng)域的學習過程。這種方法在數(shù)據(jù)稀缺或領(lǐng)域遷移的情況下尤為有效,因為它能夠顯著減少對大量標記數(shù)據(jù)的需求,提高模型的學習效率和泛化能力。

遷移學習的基本概念

遷移學習允許我們將源任務(wù)(Source Task)上訓練得到的模型或知識遷移到目標任務(wù)(Target Task)上。這里的“知識”可以是模型的參數(shù)、特征表示或數(shù)據(jù)間的關(guān)系等。遷移學習旨在通過復用已有的學習成果,來加速對新任務(wù)的學習過程,同時提高新任務(wù)的性能。

遷移學習的實現(xiàn)方法

遷移學習有多種實現(xiàn)方法,主要包括以下幾種:

- 樣本遷移(Instance-based Transfer Learning)

樣本遷移主要關(guān)注如何在源領(lǐng)域和目標領(lǐng)域之間有效地選擇和加權(quán)樣本。它通常涉及在源領(lǐng)域中找到與目標領(lǐng)域相似的數(shù)據(jù),并給這些相似數(shù)據(jù)較高的權(quán)重,以便在訓練過程中更多地利用這些數(shù)據(jù)。然而,由于實際操作中很難準確衡量樣本間的相似性,這種方法的應(yīng)用相對有限。 - 特征遷移(Feature-based Transfer Learning)

特征遷移是最常用的遷移學習方法之一。它通過觀察和利用源領(lǐng)域和目標領(lǐng)域數(shù)據(jù)之間的共同特征,將源領(lǐng)域中的特征表示遷移到目標領(lǐng)域中。這通常需要將兩個領(lǐng)域的特征投影到同一個特征空間,然后在該空間中進行特征遷移。特征遷移的一個典型應(yīng)用是在深度學習中,通過遷移預訓練模型的卷積層或全連接層權(quán)重來加速新任務(wù)的訓練。 - 模型遷移(Model-based Transfer Learning)

模型遷移是將整個預訓練模型(或模型的一部分)直接應(yīng)用于目標任務(wù)。這通常涉及到對預訓練模型的微調(diào)(Fine-tuning),即保持大部分模型參數(shù)不變,只調(diào)整與目標任務(wù)相關(guān)的部分參數(shù)。模型遷移的好處是可以直接利用預訓練模型強大的特征提取能力,同時快速適應(yīng)新任務(wù)的需求。 - 關(guān)系遷移(Relational Transfer Learning)

關(guān)系遷移主要關(guān)注源領(lǐng)域和目標領(lǐng)域之間數(shù)據(jù)關(guān)系的遷移。它試圖在源領(lǐng)域中學習到的數(shù)據(jù)關(guān)系(如社會網(wǎng)絡(luò)中的關(guān)系、圖像中的空間關(guān)系等)應(yīng)用到目標領(lǐng)域中。關(guān)系遷移在處理具有復雜關(guān)系結(jié)構(gòu)的數(shù)據(jù)時非常有用,但目前這種方法的研究和應(yīng)用相對較少。

遷移學習的代碼示例

這里僅提供一個基于Keras的模型遷移的簡單代碼示例,用于說明如何在圖像分類任務(wù)中應(yīng)用遷移學習。

import tensorflow as tf

from tensorflow.keras.applications.vgg16 import VGG16, preprocess_input, decode_predictions

from tensorflow.keras.layers import Dense, Flatten

from tensorflow.keras.models import Model

from tensorflow.keras.optimizers import Adam

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# 加載預訓練的VGG16模型

base_model = VGG16(weights='imagenet', include_top=False, input_shape=(224, 224, 3))

# 凍結(jié)預訓練模型的權(quán)重

base_model.trainable = False

# 在預訓練模型的基礎(chǔ)上添加自定義層

x = Flatten()(base_model.output)

x = Dense(256, activation='relu')(x)

predictions = Dense(10, activation='softmax')(x) # 假設(shè)有10個類別

# 創(chuàng)建新模型

model = Model(inputs=base_model.input, outputs=predictions)

# 編譯模型

model.compile(optimizer=Adam(lr=0.0001), loss='categorical_crossentropy', metrics=['accuracy'])

# 數(shù)據(jù)增強

train_datagen = ImageDataGenerator(preprocessing_function=preprocess_input,

rotation_range=40,

width_shift_range=0.2,

height_shift_range=0.2,

shear_range=0.2,

zoom_range=0.2,

horizontal_flip=True,

fill_mode='nearest')

# 假設(shè)已有訓練集和驗證集的路徑

train_generator = train_datagen.flow_from_directory(

'path_to_train',

target_size=(224, 224),

batch_size=32,

class_mode='categorical')

validation_generator = train_datagen.flow_from_directory(

'path_to_validation',

target_size=(224, 224),

batch_size=32,

class_

mode='categorical')

# 訓練模型

history = model.fit(

train_generator,

steps_per_epoch=train_generator.samples // train_generator.batch_size,

epochs=10, # 根據(jù)實際情況調(diào)整epoch數(shù)

validation_data=validation_generator,

validation_steps=validation_generator.samples // validation_generator.batch_size

)

# 評估模型

# 注意:這里假設(shè)你有一個測試集,并且你希望用整個測試集來評估模型

test_datagen = ImageDataGenerator(preprocessing_function=preprocess_input)

test_generator = test_datagen.flow_from_directory(

'path_to_test',

target_size=(224, 224),

batch_size=32,

class_mode='categorical',

shuffle=False) # 測試時不需要打亂數(shù)據(jù)

test_loss, test_acc = model.evaluate(test_generator, steps=test_generator.samples // test_generator.batch_size)

print(f'Test accuracy: {test_acc:.4f}')

遷移學習的深入討論

1. 遷移學習的優(yōu)勢

- 數(shù)據(jù)效率 :遷移學習可以顯著減少對目標領(lǐng)域標記數(shù)據(jù)的需求,尤其是在數(shù)據(jù)稀缺的情況下。

- 學習速度 :通過復用預訓練模型的知識,遷移學習可以加速新任務(wù)的訓練過程。

- 性能提升 :由于預訓練模型通常具有較高的特征提取能力,遷移學習往往能夠提升目標任務(wù)的性能。

2. 遷移學習的挑戰(zhàn)

- 負遷移 :如果源領(lǐng)域和目標領(lǐng)域之間的差異過大,遷移學習可能會導致性能下降,即負遷移現(xiàn)象。

- 領(lǐng)域適應(yīng)性 :如何有效地將源領(lǐng)域的知識遷移到目標領(lǐng)域,同時保持模型的泛化能力,是一個具有挑戰(zhàn)性的問題。

- 計算資源 :預訓練模型通常規(guī)模較大,需要較高的計算資源來訓練和部署。

3. 遷移學習的應(yīng)用場景

- 圖像識別 :在醫(yī)學影像分析、衛(wèi)星圖像解析等領(lǐng)域,遷移學習可以顯著提高識別精度和效率。

- 自然語言處理 :在情感分析、文本分類等任務(wù)中,遷移學習可以利用大規(guī)模語料庫預訓練的模型來提升性能。

- 推薦系統(tǒng) :在冷啟動問題中,遷移學習可以利用用戶在其他領(lǐng)域的行為數(shù)據(jù)來推薦新的內(nèi)容。

4. 遷移學習的未來展望

隨著深度學習技術(shù)的不斷發(fā)展,遷移學習將在更多領(lǐng)域發(fā)揮重要作用。未來,我們可以期待以下幾個方面的發(fā)展:

- 更高效的遷移策略 :研究如何更準確地評估源領(lǐng)域和目標領(lǐng)域之間的相似性,從而制定更有效的遷移策略。

- 無監(jiān)督遷移學習 :探索如何在沒有標簽數(shù)據(jù)的情況下進行遷移學習,以進一步提高數(shù)據(jù)利用效率。

- 終身學習 :將遷移學習與終身學習相結(jié)合,使模型能夠持續(xù)從多個任務(wù)中學習和積累知識。

總之,遷移學習作為一種強大的機器學習技術(shù),已經(jīng)在多個領(lǐng)域取得了顯著成果。隨著研究的深入和技術(shù)的進步,我們有理由相信遷移學習將在未來發(fā)揮更加重要的作用。

-

代碼

+關(guān)注

關(guān)注

30文章

4825瀏覽量

69043 -

機器學習

+關(guān)注

關(guān)注

66文章

8438瀏覽量

133080 -

遷移學習

+關(guān)注

關(guān)注

0文章

74瀏覽量

5588

發(fā)布評論請先 登錄

相關(guān)推薦

關(guān)于數(shù)字電路的基本概念和學習內(nèi)容

智能天線的基本概念

人工智能基本概念機器學習算法

USB基本概念及從機編程方法介紹

遷移學習

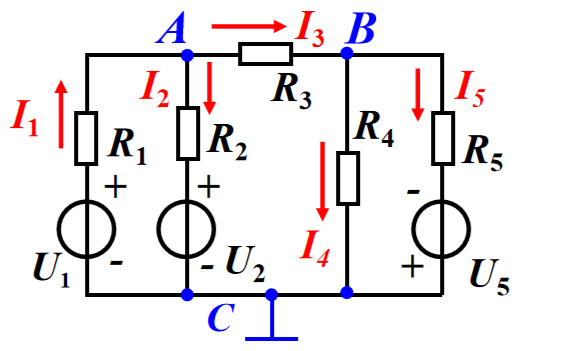

電路的基本概念定律和分析方法的學習課件免費下載

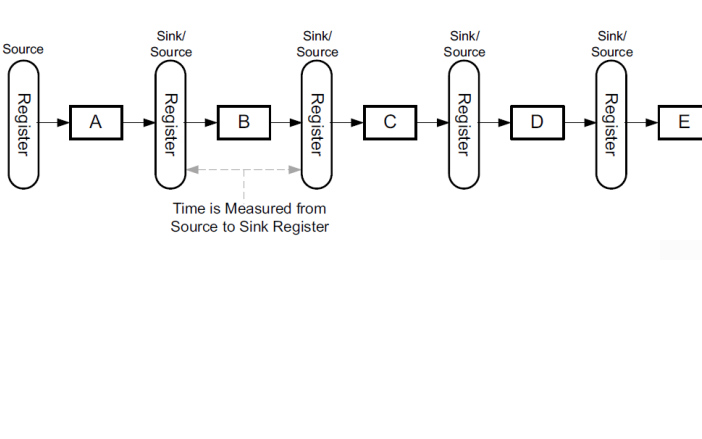

FPGA學習教程之硬件設(shè)計基本概念

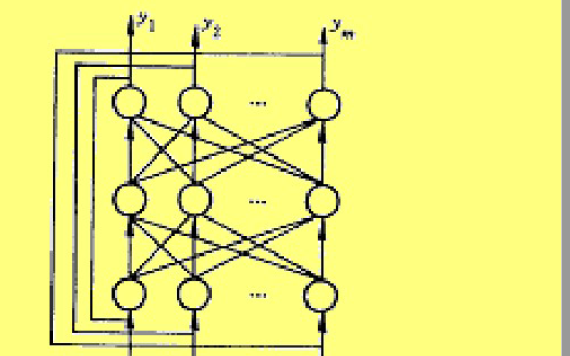

神經(jīng)網(wǎng)絡(luò)的基本概念學習課件免費下載

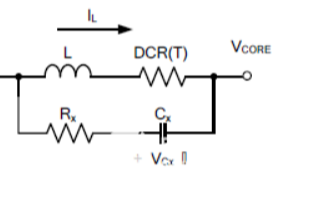

DCR溫度補償?shù)?b class='flag-5'>基本概念和實現(xiàn)方法

Linux內(nèi)核實現(xiàn)內(nèi)存管理的基本概念

遷移學習的基本概念和實現(xiàn)方法

遷移學習的基本概念和實現(xiàn)方法

評論