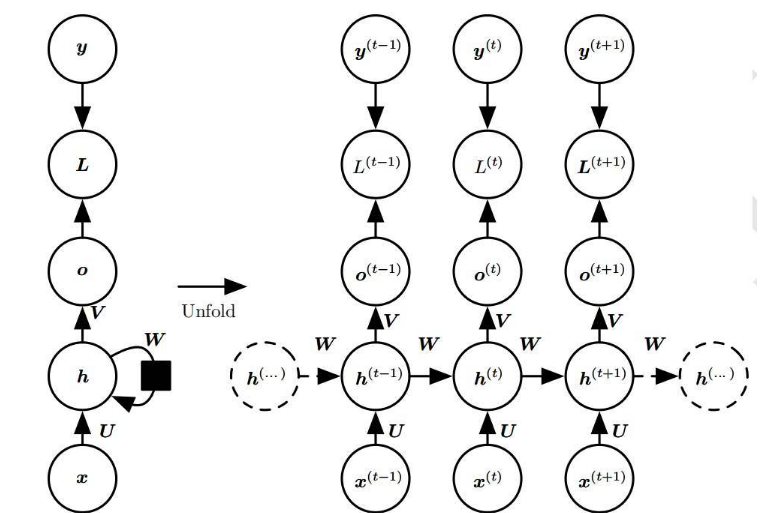

循環(huán)神經網絡(Recurrent Neural Networks,簡稱RNN)是一種具有記憶功能的神經網絡,它能夠處理序列數(shù)據(jù),如文本、語音和時間序列等。

- 梯度消失和梯度爆炸問題

RNN在訓練過程中,由于其循環(huán)結構,梯度在反向傳播時會經過多次乘法操作。這可能導致梯度在某些情況下變得非常小,即梯度消失問題,或者變得非常大,即梯度爆炸問題。這些問題會導致RNN的訓練過程變得非常困難,甚至無法收斂。

- 長期依賴問題

RNN的一個重要特點是能夠捕捉長距離的依賴關系。然而,在實際應用中,RNN往往難以捕捉超過一定時間步的依賴關系。這是因為在反向傳播過程中,梯度會隨著時間步的增加而逐漸衰減,導致RNN對長期依賴關系的學習能力受限。

- 參數(shù)數(shù)量較多

RNN的每個時間步都有一個權重矩陣,這導致其參數(shù)數(shù)量隨著時間步的增加而線性增長。這不僅增加了模型的復雜度,而且也增加了訓練的難度。此外,大量的參數(shù)也容易導致模型的過擬合問題。

- 訓練速度較慢

由于RNN需要在每個時間步進行前向傳播和反向傳播,因此其訓練速度相對較慢。特別是在處理長序列數(shù)據(jù)時,RNN的訓練過程可能需要花費大量的時間。這限制了RNN在實時應用中的可行性。

- 難以并行計算

RNN的循環(huán)結構使得其在每個時間步的計算都依賴于前一個時間步的輸出。這導致RNN難以實現(xiàn)并行計算,從而限制了其在大規(guī)模數(shù)據(jù)集上的應用。相比之下,卷積神經網絡(Convolutional Neural Networks,簡稱CNN)等其他類型的神經網絡可以更容易地實現(xiàn)并行計算。

- 難以捕捉局部特征

RNN的主要優(yōu)勢在于捕捉序列數(shù)據(jù)中的全局特征,但在捕捉局部特征方面表現(xiàn)不佳。這導致RNN在處理具有復雜局部結構的數(shù)據(jù)時,如圖像和音頻信號等,可能不如其他類型的神經網絡,如CNN和循環(huán)卷積神經網絡(Recurrent Convolutional Neural Networks,簡稱RCNN)等。

- 難以處理不規(guī)則序列

RNN通常假設輸入序列具有固定的長度,但在實際應用中,很多序列數(shù)據(jù)的長度是不規(guī)則的。這使得RNN在處理這類數(shù)據(jù)時面臨一定的困難。雖然可以通過填充(padding)和截斷(truncation)等方法來處理不規(guī)則序列,但這些方法可能會影響模型的性能。

- 難以適應新的數(shù)據(jù)分布

RNN在訓練完成后,其參數(shù)和權重矩陣是固定的。當面臨新的數(shù)據(jù)分布時,RNN可能無法很好地適應這些變化。這導致RNN在實際應用中可能需要不斷地進行重新訓練,以適應新的數(shù)據(jù)分布。

- 難以解釋和可視化

RNN的循環(huán)結構和大量的參數(shù)使得其模型的解釋性和可視化變得非常困難。這限制了RNN在需要模型解釋性的應用場景中的使用,如醫(yī)療診斷和金融風控等。

- 難以實現(xiàn)端到端的訓練

RNN在某些任務中,如語音識別和機器翻譯等,需要與其他模型(如聲學模型和語言模型等)結合使用。這導致RNN難以實現(xiàn)端到端的訓練,從而增加了模型的復雜性和訓練難度。

總之,盡管RNN在處理序列數(shù)據(jù)方面具有獨特的優(yōu)勢,但它仍然存在許多問題,如梯度消失和梯度爆炸、長期依賴問題、參數(shù)數(shù)量較多、訓練速度較慢等。為了克服這些問題,研究人員提出了許多改進的RNN模型,如長短時記憶網絡(Long Short-Term Memory,簡稱LSTM)和門控循環(huán)單元(Gated Recurrent Unit,簡稱GRU)等。

-

數(shù)據(jù)

+關注

關注

8文章

7139瀏覽量

89576 -

參數(shù)

+關注

關注

11文章

1859瀏覽量

32427 -

語音識別

+關注

關注

38文章

1742瀏覽量

112923 -

循環(huán)神經網絡

+關注

關注

0文章

38瀏覽量

2993

發(fā)布評論請先 登錄

相關推薦

什么是RNN (循環(huán)神經網絡)?

循環(huán)神經網絡的缺點是存在什么問題

循環(huán)神經網絡的缺點是存在什么問題

評論