深度神經網絡(Deep Neural Networks, DNNs)作為人工智能領域的重要技術之一,通過模擬人腦神經元之間的連接,實現了對復雜數據的自主學習和智能判斷。其設計方法不僅涉及網絡結構的構建,還包括激活函數的選擇、優化算法的應用、正則化技術的引入等多個方面。本文將從網絡結構設計、關鍵組件選擇、優化與正則化策略、以及未來發展趨勢四個方面詳細探討深度神經網絡的設計方法。

一、網絡結構設計

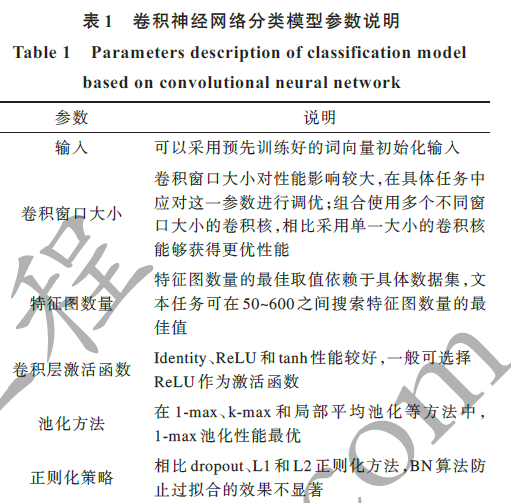

1.1 卷積神經網絡(CNN)

卷積神經網絡(CNN)是深度學習中應用最廣泛的網絡結構之一,尤其在圖像處理和視頻分析領域表現出色。CNN的核心在于其卷積層和池化層,這些層通過局部連接和權值共享的特性,有效減少了網絡參數的數量,并提高了計算效率。

- 卷積層 :用于特征提取,通過卷積操作捕捉圖像的局部特征。不同的卷積核可以提取不同的特征,如邊緣、紋理等。

- 池化層 :用于降采樣,通過減少特征圖的尺寸來降低網絡的計算復雜度,同時提高模型的泛化能力。

- 全連接層 :通常位于CNN的末端,用于將學到的特征表示映射到樣本的標記空間,實現分類或回歸任務。

1.2 循環神經網絡(RNN)及其變種

循環神經網絡(RNN)特別適用于處理序列數據,如自然語言處理(NLP)中的文本生成、機器翻譯等任務。RNN通過引入循環結構,使得網絡能夠記憶序列中的歷史信息。然而,標準的RNN存在梯度消失和梯度爆炸的問題,限制了其處理長序列數據的能力。為此,研究者們提出了多種RNN的變種,如長短期記憶網絡(LSTM)和門控循環單元(GRU),通過引入門機制(如輸入門、遺忘門、輸出門)來控制信息的流動,有效解決了長程依賴問題。

1.3 Transformer

Transformer是一種基于自注意力機制的神經網絡結構,由Vaswani等人在2017年提出。它徹底改變了自然語言處理領域的研究方向,通過自注意力機制捕捉序列中各部分之間的依賴關系,實現了并行計算,大幅提升了訓練速度和效果。Transformer由編碼器和解碼器組成,編碼器用于將輸入序列映射到一系列連續的表示,解碼器則根據這些表示生成輸出序列。

二、關鍵組件選擇

2.1 激活函數

激活函數是神經網絡中引入非線性的關鍵組件,常見的激活函數包括Sigmoid、Tanh、ReLU及其變種(如Leaky ReLU、PReLU等)。ReLU函數由于其簡單、高效和梯度消失問題較小的特點,在深度學習中得到了廣泛應用。然而,ReLU函數也存在“死亡神經元”的問題,即當輸入小于0時,輸出始終為0,導致神經元無法被激活。為解決這一問題,研究者們提出了多種ReLU的變種。

2.2 正則化技術

正則化技術是防止神經網絡過擬合的重要手段。常見的正則化方法包括L1正則化、L2正則化、Dropout、DropConnect等。Dropout通過在訓練過程中隨機丟棄一部分神經元及其連接,減少了神經元之間的共適應性,從而提高了模型的泛化能力。DropConnect則是Dropout的一種擴展,它在訓練過程中隨機丟棄一部分連接,而不是整個神經元。

2.3 注意力機制

注意力機制使得神經網絡能夠關注重要的信息,忽略無關的部分,從而提高網絡的計算效率和泛化能力。在自然語言處理領域,注意力機制被廣泛應用于機器翻譯、文本生成等任務中。通過引入注意力機制,模型能夠捕捉到輸入序列中不同部分的相對重要性,從而生成更加準確和流暢的輸出序列。

三、優化與正則化策略

3.1 優化算法

優化算法是神經網絡訓練過程中的核心環節,它決定了網絡參數的更新方式和速度。常見的優化算法包括隨機梯度下降(SGD)、動量(Momentum)、RMSprop、Adam等。Adam算法由于其自適應學習率和動量項的特點,在深度學習中得到了廣泛應用。它能夠根據梯度的一階矩估計和二階矩估計自動調整學習率,使得網絡能夠更快地收斂到最優解。

3.2 梯度消失與梯度爆炸

梯度消失和梯度爆炸是深度神經網絡訓練過程中常見的問題。為了解決這些問題,研究者們提出了多種策略,如使用ReLU等激活函數、引入殘差連接(如ResNet中的skip connections)、采用梯度裁剪(gradient clipping)等方法。這些策略有助于保持梯度的穩定性,使得網絡能夠正常訓練。

3.3 模型壓縮與剪枝

模型壓縮與剪枝是降低神經網絡計算復雜度和存儲需求的重要手段。通過剪去網絡中的冗余連接和神經元,可以顯著減少模型的參數數量和計算量,同時保持模型的性能不變或略有下降。

模型壓縮與剪枝是深度神經網絡設計中不可或缺的環節,尤其在資源受限的環境下(如移動端或嵌入式設備)顯得尤為重要。這些方法旨在通過減少模型中的冗余參數和計算量,從而在保持模型性能的同時降低其復雜度和存儲需求。

3.1 剪枝技術

剪枝技術主要通過移除網絡中的不重要連接或神經元來實現模型壓縮。根據剪枝的粒度,可以分為細粒度剪枝(即剪除單個權重)、組剪枝(剪除權重矩陣中的整個行或列)和結構化剪枝(剪除整個通道或層)。

- 細粒度剪枝 :雖然能夠取得較高的壓縮率,但由于其不規則性,往往難以在硬件上高效實現。

- 組剪枝和結構化剪枝 :則更易于硬件加速,因為它們保持了網絡結構的規則性。

剪枝過程中,需要確定哪些連接或神經元是不重要的。這通常通過評估權重的重要性來實現,常用的評估指標包括權重的絕對值、權重的一階或二階導數等。剪枝后,為了恢復模型的性能,往往需要進行重訓練。

3.2 量化技術

量化技術通過將模型的權重和激活值從浮點數轉換為低比特整數(如8位、4位甚至更低),從而顯著減少模型的存儲需求和計算復雜度。量化過程可以分為訓練后量化(Post-Training Quantization)和量化感知訓練(Quantization-Aware Training, QAT)兩種。

- 訓練后量化 :在模型訓練完成后進行,不需要重新訓練模型,因此簡單易行。但由于沒有考慮量化對模型性能的影響,因此量化后的模型性能可能會有所下降。

- 量化感知訓練 :在模型訓練過程中就考慮量化的影響,通過調整訓練過程中的超參數(如學習率、量化精度等),使得模型在量化后仍然能夠保持較好的性能。

3.3 知識蒸餾

知識蒸餾是一種將大模型(教師模型)的知識轉移到小模型(學生模型)中的技術。通過讓教師模型指導學生模型的訓練過程,可以使得學生模型在保持較小規模的同時,學習到教師模型的豐富知識,從而提高其性能。

知識蒸餾的核心在于定義一種有效的知識傳遞方式。常見的知識傳遞方式包括軟標簽(即教師模型的輸出概率分布)、中間層特征映射、注意力圖等。通過將這些知識作為額外的監督信息,可以引導學生模型更好地學習教師模型的表示能力。

3.4 自動化機器學習(AutoML)

隨著自動化機器學習(AutoML)技術的發展,越來越多的研究者開始探索將AutoML應用于深度神經網絡的設計中。AutoML技術可以自動搜索最優的網絡結構、超參數等,從而減輕人工設計的負擔并提高模型的性能。

在深度神經網絡設計中,AutoML技術可以應用于多個方面,如神經網絡架構搜索(NAS)、超參數優化等。通過定義一個搜索空間和一個優化目標(如準確率、計算復雜度等),AutoML算法可以自動搜索出滿足優化目標的網絡結構和超參數組合。

3.5 未來發展趨勢

隨著深度學習技術的不斷發展,深度神經網絡的設計方法也在不斷創新和完善。未來,我們可以期待以下幾個方面的發展趨勢:

- 更加高效的模型壓縮與剪枝技術 :通過更加精細的剪枝策略和更加高效的量化方法,可以進一步降低模型的復雜度和存儲需求。

- 更加智能的自動化機器學習技術 :AutoML技術將不斷成熟和完善,能夠自動搜索出更加高效和準確的網絡結構和超參數組合。

- 更加豐富的網絡結構創新 :隨著對神經網絡工作原理的深入理解,我們可以期待更多新穎的網絡結構被提出和應用,如具有萬有逼近性質的神經網絡架構等。

- 更加融合的多模態學習 :隨著多模態數據的不斷增多和應用場景的不斷拓展,多模態學習將成為深度學習領域的一個重要研究方向。通過融合不同模態的數據和信息,可以進一步提高模型的性能和泛化能力。

綜上所述,深度神經網絡的設計方法是一個復雜而多維的過程,涉及網絡結構的設計、關鍵組件的選擇、優化與正則化策略以及模型壓縮與剪枝等多個方面。隨著技術的不斷發展和創新,我們可以期待更加高效、準確和智能的深度神經網絡設計方法的出現和應用。

-

人工智能

+關注

關注

1796文章

47666瀏覽量

240274 -

深度神經網絡

+關注

關注

0文章

61瀏覽量

4557 -

卷積神經網絡

+關注

關注

4文章

367瀏覽量

11914

發布評論請先 登錄

相關推薦

深度神經網絡是什么

基于深度神經網絡的激光雷達物體識別系統

卷積神經網絡模型發展及應用

【連載】深度學習筆記7:Tensorflow入門

【人工神經網絡基礎】為什么神經網絡選擇了“深度”?

基于深度神經網絡的文本分類分析

綜述深度神經網絡的解釋方法及發展趨勢

深度神經網絡的設計方法

深度神經網絡的設計方法

評論