導(dǎo) 讀

本文是對發(fā)表于計算機(jī)視覺領(lǐng)域頂級會議 ICCV 2023 的論文MotionBERT: A Unified Perspective on Learning Human Motion Representations的解讀。該論文由北京大學(xué)王亦洲課題組與上海人工智能實(shí)驗(yàn)室合作完成。

這項(xiàng)工作提出了一個統(tǒng)一的視角,從大規(guī)模、多樣化的數(shù)據(jù)中學(xué)習(xí)人體運(yùn)動的通用表征,進(jìn)而以一個統(tǒng)一的范式完成各種以人為中心的下游視頻任務(wù)。實(shí)驗(yàn)表明提出的框架在三維人體姿態(tài)估計、動作識別、人體網(wǎng)格重建等多個下游任務(wù)上均能帶來顯著提升,并達(dá)到現(xiàn)有最佳的表現(xiàn)。

?

?

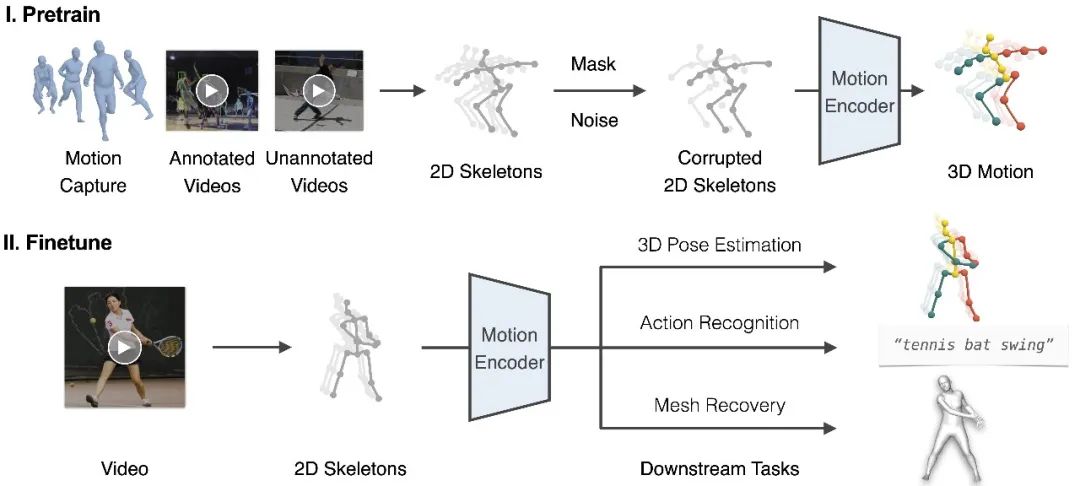

圖1. 以統(tǒng)一的范式完成各種以人為中心的視頻任務(wù)

01

背景介紹

感知和理解人類活動一直是機(jī)器智能的核心追求。為此,研究者們定義了各種任務(wù)來從視頻中估計人體運(yùn)動的語義標(biāo)簽,例如骨骼關(guān)鍵點(diǎn)、行為類別、三維表面網(wǎng)格等。盡管現(xiàn)有的工作在這些任務(wù)上已經(jīng)取得了顯著的進(jìn)步,但它們往往被建模為孤立的任務(wù)。理想情況下,我們可以構(gòu)建一個統(tǒng)一的以人為中心的運(yùn)動表征,其可以在所有相關(guān)的下游任務(wù)中共享。

構(gòu)建這種表征的一個重要挑戰(zhàn)是人體運(yùn)動數(shù)據(jù)資源的異質(zhì)性。運(yùn)動捕捉(MoCap)系統(tǒng)提供了基于標(biāo)記和傳感器的高精度 3D 運(yùn)動數(shù)據(jù),但其內(nèi)容通常被限制在簡單的室內(nèi)場景。動作識別數(shù)據(jù)集提供了動作語義的標(biāo)注,但它們要么不包含人體姿態(tài)標(biāo)簽,要么只有日常活動的有限動作類別。具備外觀和動作多樣性的非受限人類視頻可以從互聯(lián)網(wǎng)大量獲取,但獲取精確的姿勢標(biāo)注需要額外的努力,且獲取準(zhǔn)確真實(shí)(GT)的三維人體姿態(tài)幾乎是不可能的。因此,大多數(shù)現(xiàn)有的研究都致力于使用單一類型的人體運(yùn)動數(shù)據(jù)解決某一特定任務(wù),而無法受益于其他數(shù)據(jù)資源的特性。

在這項(xiàng)工作中,我們提供了一個新的視角來學(xué)習(xí)人體運(yùn)動表征。關(guān)鍵的想法是,我們可以以統(tǒng)一的方式從多樣化的數(shù)據(jù)來源中學(xué)習(xí)多功能的人體運(yùn)動表征,并利用這種表征以統(tǒng)一的范式處理不同的下游任務(wù)。

02

方法概覽

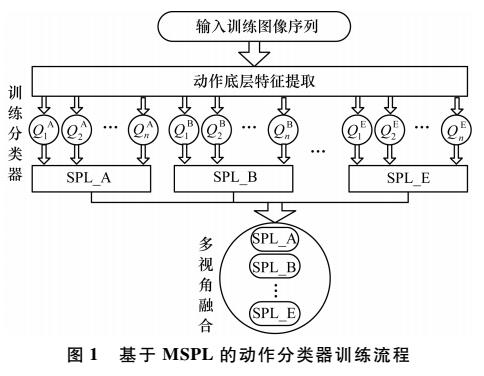

圖2. 框架概覽

我們提出了一個包括預(yù)訓(xùn)練和微調(diào)兩個階段的框架,如圖2所示。在預(yù)訓(xùn)練階段,我們從多樣化的運(yùn)動數(shù)據(jù)源中提取 2D 關(guān)鍵點(diǎn)序列,并添加隨機(jī)掩碼和噪聲。隨后,我們訓(xùn)練運(yùn)動編碼器從損壞的 2D 關(guān)鍵點(diǎn)中恢復(fù) 3D 運(yùn)動。這個具有挑戰(zhàn)性的代理任務(wù)本質(zhì)上要求運(yùn)動編碼器(i)從時序運(yùn)動中推斷出潛在的 3D 人體結(jié)構(gòu);(ii)恢復(fù)錯誤和缺失的數(shù)據(jù)。通過這種方式,運(yùn)動編碼器隱式地學(xué)習(xí)到人體運(yùn)動的常識,如關(guān)節(jié)拓?fù)洌硐拗坪蜁r間動態(tài)。在實(shí)踐中,我們提出雙流空間-時間變換器(DSTformer)作為運(yùn)動編碼器來捕獲骨骼關(guān)鍵點(diǎn)之間的長距離關(guān)系。我們假設(shè),從大規(guī)模和多樣化的數(shù)據(jù)資源中學(xué)習(xí)到的運(yùn)動表征可以在不同的下游任務(wù)之間共享,并有利于它們的性能。因此,對于每個下游任務(wù),我們僅需要微調(diào)預(yù)訓(xùn)練的運(yùn)動表征以及一個簡單的回歸頭網(wǎng)絡(luò)(1-2層 MLP)。

在設(shè)計統(tǒng)一的預(yù)訓(xùn)練框架時,我們面臨兩個關(guān)鍵挑戰(zhàn):

如何構(gòu)建合適的代理任務(wù)(pretext task)學(xué)習(xí)的運(yùn)動表征。

如何使用大規(guī)模但異質(zhì)的人體運(yùn)動數(shù)據(jù)。

針對第一個挑戰(zhàn),我們遵循了語言和視覺建模的成功實(shí)踐[1]來構(gòu)建監(jiān)督信號,即遮蔽輸入的一部分,并使用編碼的表征來重構(gòu)整個輸入。我們注意到這種“完形填空”任務(wù)在人體運(yùn)動分析中自然存在,即從 2D 視覺觀察中恢復(fù)丟失的深度信息,也就是 3D 人體姿態(tài)估計。受此啟發(fā),我們利用大規(guī)模的 3D 運(yùn)動捕捉數(shù)據(jù)[2],設(shè)計了一個 2D 至 3D 提升(2D-to-3D lifting)的代理任務(wù)。我們首先通過正交投影 3D 運(yùn)動來提取 2D 骨架序列 x。然后,我們通過隨機(jī)遮蔽和添加噪聲來破壞 x,從而產(chǎn)生破壞的 2D 骨架序列,這也類似于 2D 檢測結(jié)果,因?yàn)樗趽酢z測失敗和錯誤。在此之后,我們使用運(yùn)動編碼器來獲得運(yùn)動表征并重建 3D 運(yùn)動。

對于第二個挑戰(zhàn),我們注意到 2D 骨架可以作為一種通用的中介,因?yàn)樗鼈兛梢詮母鞣N運(yùn)動數(shù)據(jù)源中提取。因此,可以進(jìn)一步將 RGB 視頻納入到 2D 到 3D 提升框架以進(jìn)行統(tǒng)一訓(xùn)練。對于 RGB 視頻,2D 骨架可以通過手動標(biāo)注或 2D 姿態(tài)估計器給出。由于這一部分?jǐn)?shù)據(jù)缺少三維姿態(tài)真值(GT),我們使用加權(quán)的二維重投影誤差作為監(jiān)督。

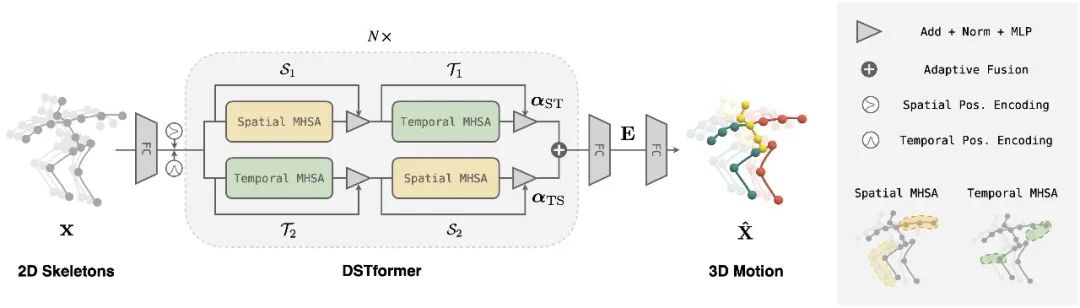

圖3. DSTformer 網(wǎng)絡(luò)結(jié)構(gòu)

在運(yùn)動編碼器的具體實(shí)現(xiàn)上,我們根據(jù)以下原則設(shè)計了一個雙流時空變換器(DSTformer)網(wǎng)絡(luò)結(jié)構(gòu)(如圖3所示):

兩個流都有綜合建模時空上下文信息的能力。

兩個流側(cè)重不同方面的時空特征。

將兩個流融合在一起時根據(jù)輸入的時空特征動態(tài)平衡融合權(quán)重。

03

實(shí)驗(yàn)結(jié)論

我們在三個下游任務(wù)上進(jìn)行了定性和定量的評估,所提出的方法均取得了最佳表現(xiàn)。

圖4. 效果展示

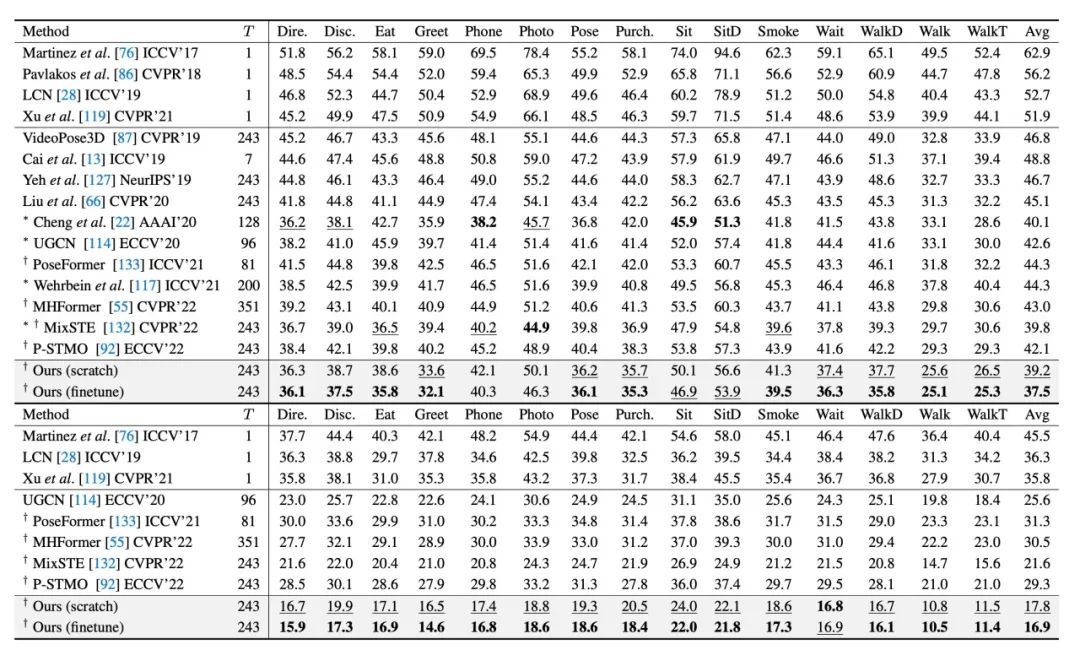

表1. 三維人體姿態(tài)估計的定量評估。數(shù)字代表 Human3.6M 上的平均關(guān)節(jié)誤差 MPJPE(mm)。(上)使用檢測到的 2D 姿態(tài)序列作為輸入。(下)使用真值(GT)2D 姿態(tài)序列作為輸入。

對于三維人體姿態(tài)估計任務(wù),我們在 Human3.6M[3]上進(jìn)行了定量測試。如表1所示,本文的兩個模型都優(yōu)于最先進(jìn)的方法。所提出的預(yù)訓(xùn)練運(yùn)動表征額外降低了誤差,這證明了在廣泛而多樣的人體運(yùn)動數(shù)據(jù)上進(jìn)行預(yù)訓(xùn)練的好處。

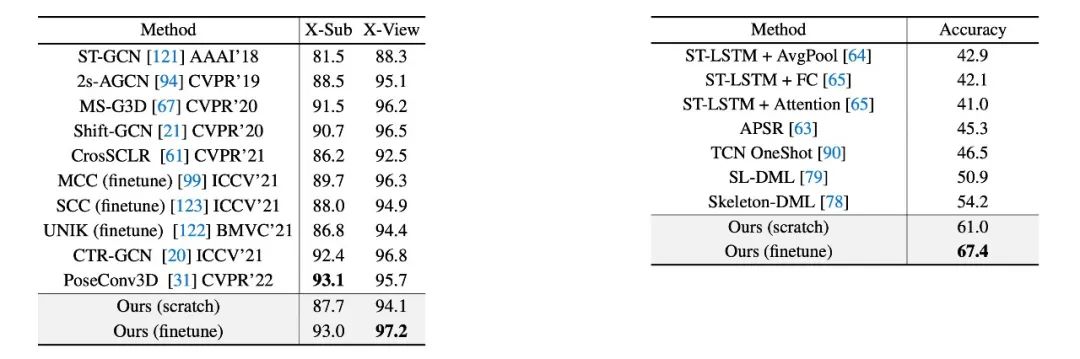

表2. 基于骨架的動作識別準(zhǔn)確度的定量評估。(左)NTU-RGB+D 上的跨角色(X-Sub)和跨視角(X-View)識別準(zhǔn)確度。(右)NTU-RGB+D-120 上的單樣本學(xué)習(xí)識別精度。所有結(jié)果都是第一選項(xiàng)準(zhǔn)確度(%)。

對于基于骨架的動作識別任務(wù),我們在 NTU-RGB+D[4]和 NTU-RGB+D-120[5]上進(jìn)行了定量測試。在完全監(jiān)督的場景下本文的方法與最先進(jìn)的方法相當(dāng)或更好,如表2(左)所示。值得注意的是,預(yù)訓(xùn)練階段帶來了很大的性能提升。此外,本文研究了可用于未見動作和稀缺標(biāo)簽的單樣本學(xué)習(xí)設(shè)置。表2(右)說明所提出的模型大幅度優(yōu)于此前最佳的模型。值得注意的是,預(yù)訓(xùn)練運(yùn)動表征只需1-2輪微調(diào)即可達(dá)到最佳性能。

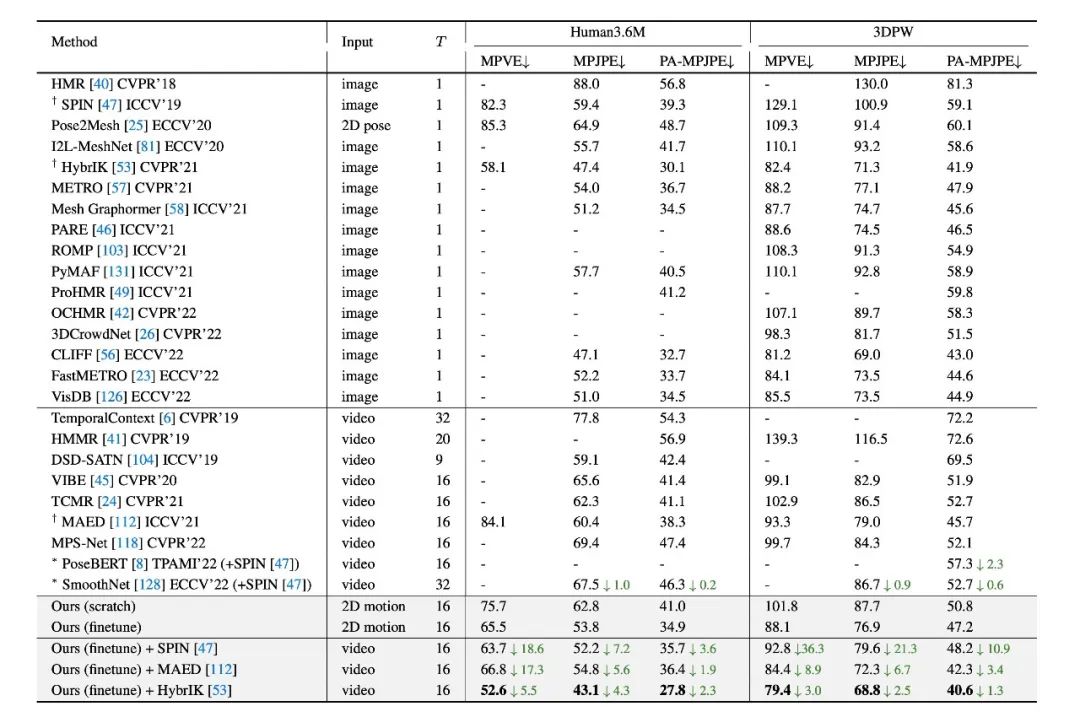

表3. 人體表面網(wǎng)格重建的定量評估。數(shù)字代表平均三維位置誤差(mm)。

對于人體表面網(wǎng)格重建任務(wù),我們在 Human3.6M[3] 和 3DPW[6]數(shù)據(jù)集上進(jìn)行了定量測試。本文的模型超過了此前所有基于視頻的方法。此外,所提出的預(yù)訓(xùn)練運(yùn)動表征可以和 RGB 圖像的方法相結(jié)合并進(jìn)一步改善其表現(xiàn)。

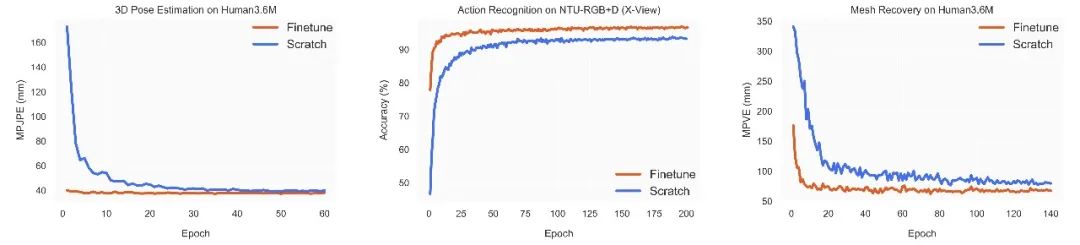

圖5. 在三個下游任務(wù)上隨機(jī)初始化訓(xùn)練和微調(diào)預(yù)訓(xùn)練運(yùn)動表征的學(xué)習(xí)曲線對比。

我們還比較了微調(diào)預(yù)訓(xùn)練運(yùn)動表征和隨機(jī)初始化訓(xùn)練模型的訓(xùn)練過程。如圖5所示,使用預(yù)訓(xùn)練運(yùn)動表征的模型在所有三個下游任務(wù)上都具有更好的性能和更快的收斂速度。這表明該模型在預(yù)訓(xùn)練期間學(xué)習(xí)了關(guān)于人體運(yùn)動的可遷移知識,有助于多個下游任務(wù)的學(xué)習(xí)。

04

總 結(jié)

在這項(xiàng)工作中,我們提出了:

一個統(tǒng)一的視角以解決各種以人為中心的視頻任務(wù)。

一個預(yù)訓(xùn)練框架以從大規(guī)模和多樣化的數(shù)據(jù)源中學(xué)習(xí)人體運(yùn)動表征。

一個通用的人體運(yùn)動編碼器 DSTformer 以全面建模人體運(yùn)動的時空特征。

在多個基準(zhǔn)測試上的實(shí)驗(yàn)結(jié)果證明了學(xué)習(xí)到的運(yùn)動表征的多功能性。未來的研究工作可以探索將學(xué)習(xí)到的運(yùn)動表征作為一種以人為中心的語義特征與通用視頻架構(gòu)融合,并應(yīng)用到更多視頻任務(wù)(例如動作評價、動作分割等)。

-

編碼器

+關(guān)注

關(guān)注

45文章

3667瀏覽量

135242 -

模型

+關(guān)注

關(guān)注

1文章

3305瀏覽量

49220 -

數(shù)據(jù)源

+關(guān)注

關(guān)注

1文章

63瀏覽量

9718

原文標(biāo)題:ICCV 2023 | 北大提出MotionBERT:人體運(yùn)動表征學(xué)習(xí)的統(tǒng)一視角

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

多站低頻雷達(dá)運(yùn)動人體微多普勒特征提取與跟蹤技術(shù)【論文干貨】

人體上肢運(yùn)動表面肌電特征研究

基于多區(qū)域的人體運(yùn)動跟蹤研究

監(jiān)測人體健康和運(yùn)動表現(xiàn)

基于多區(qū)域的人體運(yùn)動跟蹤分析

基于視角相容性的多視角數(shù)據(jù)缺失補(bǔ)全

基于塊稀疏模型的人體運(yùn)動模式識別方法

基于多視角自步學(xué)習(xí)的人體動作識別方法

北大提出MotionBERT:人體運(yùn)動表征學(xué)習(xí)的統(tǒng)一視角

北大提出MotionBERT:人體運(yùn)動表征學(xué)習(xí)的統(tǒng)一視角

評論