7月6日至8日,第六屆世界人工智能大會(WAIC2023)展覽將于上海隆重舉辦,規模達5萬平米,參展企業總數預計突破400家,創歷年新高。

作為AI芯片領域的領軍企業,昆侖芯再度牽手WAIC,傾力打造特裝展區。屆時,昆侖芯將攜多層級產品矩陣亮相,生動展示公司十余年發展歷程、產品優勢性能、端到端解決方案及生態共創成果。現場更有工作人員進行互動講解,歡迎蒞臨參觀。

7月6日 1000

7月7日-8日 900

上海世博展覽館H2館B601

展區亮點

昆侖芯系列產品展示

自2011年起,昆侖芯團隊便基于真實AI場景需求研究AI計算加速,并于2017年正式提出自研XPU架構。基于該架構,昆侖芯先后打造兩代云端AI芯片,并相繼推出多款AI加速卡及AI加速器組產品。

昆侖芯1代AI芯片

昆侖芯1代AI芯片搭載昆侖芯自研XPU架構,采用14nm工藝,16GB HBM先進內存和2.5D封裝技術,提供高達512 GB/s的內存帶寬,256 TOPS的算力,是國內為數不多經歷過互聯網大規模核心算法考驗的云端AI芯片。

昆侖芯AI加速卡K100

昆侖芯AI加速卡K100是專為邊緣推理打造的AI加速卡,搭載昆侖芯1代AI芯片,支持128 TOPS@INT8算力,功耗低至75W,體積小巧,適用于各類智能邊緣計算場景。

昆侖芯AI加速卡K200

昆侖芯AI加速卡K200搭載昆侖芯1代AI芯片,提供高達256 TOPS@INT8算力,HBM 16GB內存和512 GB/s訪存帶寬,支持計算機視覺、自然語言處理、語音等深度學習及傳統機器學習任務,適用于云數據中心或其他高計算密度的訓練和推理場景。

昆侖芯2代AI芯片

昆侖芯2代AI芯片搭載昆侖芯自研的新一代XPU-R架構,是國內首款采用GDDR6顯存的通用AI芯片。采用7nm制程工藝,相比1代性能提升2-3倍,算力強大,整數精度算力達到256 TOPS,半精度為128 TFLOPS。

昆侖芯AI加速卡R100

昆侖芯AI加速卡R100是一款基于昆侖芯2代芯片,半高半長形態的AI加速卡,可提供高達128 TOPS@INT8 和最高170 TOPS@INT8 兩種算力模式,為多樣的邊緣AI應用場景提供最優的性能及功耗比。

昆侖芯AI加速卡RG800

昆侖芯AI加速卡RG800基于昆侖芯自研的XPU-R架構,是一款定位于數據中心應用場景的AI加速卡,既可用于常規模型的訓練,也可用于多業務并發的高性能AI推理應用,助力各行業實現降本增效,推進產業智能化升級。

昆侖芯AI加速卡R200

昆侖芯AI加速卡R200采用昆侖芯2代AI芯片,為數據中心高性能推理提供256 TOPS@INT8的強大算力,全面支持自然語言處理、計算機視覺、語音以及傳統機器學習等各類人工智能任務。

昆侖芯AI加速器組R480-X8

昆侖芯AI加速器組R480-X8采用昆侖芯2代AI芯片,搭載8顆昆侖芯AI加速模塊R300。R480-X8可實現芯片間互聯,提供200 GB/s片間互聯雙向聚合帶寬、高達1 PetaFLOPS@FP16的算力,多機可構建多節點大規模并行計算集群,滿足大型模型訓練和推理的需求。

左右滑動,了解昆侖芯兩代芯片產品

昆侖芯第二代系列產品矩陣首次亮相

針對不同參數級別的昆侖芯第二代系列產品矩陣首次亮相,展現強大產品實力,為千行百業智能化升級注入“芯”動力。

昆侖芯AI加速卡R100

昆侖芯AI加速卡RG800

昆侖芯AI加速卡R200-8F

昆侖芯大模型端到端解決方案(繼正式發布后首次參展)

昆侖芯賦能“智慧+”場景案例展示

昆侖芯始終堅持開拓創新,用更快、更強、更省的算力賦能AI應用場景,樹立“智慧+”場景新標桿。昆侖芯結合互聯網、金融、工業、交通、物流與園區等多場景的實際情況,采用先進AI技術成果打造端到端解決方案,提升管理水平與工作效率,降低人力成本與資金損耗。進入昆侖芯官網(www.kunlunxin.com)「解決方案」欄目,可了解更多昆侖芯行業解決方案詳細信息。

繼XceedCon2023昆侖芯首屆生態大會后,本次展覽,昆侖芯再次聯合眾多知名生態伙伴,集中展示搭載昆侖芯AI芯片及AI加速卡產品的板卡設計參考、服務器、加速模組、工控機、軟硬一體機等硬件產品,覆蓋互聯網、大模型、智慧金融、智慧物流、智慧工業、智慧交通、智能制造等領域,全面展示昆侖芯技術實力及生態布局。

-

AI

+關注

關注

87文章

31520瀏覽量

270339 -

模型訓練

+關注

關注

0文章

20瀏覽量

1366 -

昆侖芯片

+關注

關注

0文章

13瀏覽量

2298

原文標題:WAIC 2023 | 昆侖芯攜生態伙伴重磅亮相世博展覽館,共筑AI算力芯基建

文章出處:【微信號:昆侖芯科技,微信公眾號:昆侖芯科技】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

新品| LLM630 Compute Kit,AI 大語言模型推理開發平臺

IBM與AMD攜手將在IBM云上部署AMD Instinct MI300X加速器

FPGA和ASIC在大模型推理加速中的應用

NVIDIA助力麗蟾科技打造AI訓練與推理加速解決方案

如何訓練自己的AI大模型

AMD助力HyperAccel開發全新AI推理服務器

進一步解讀英偉達 Blackwell 架構、NVlink及GB200 超級芯片

FCom富士晶體振蕩器:AI PC和大型模型的關鍵支持者

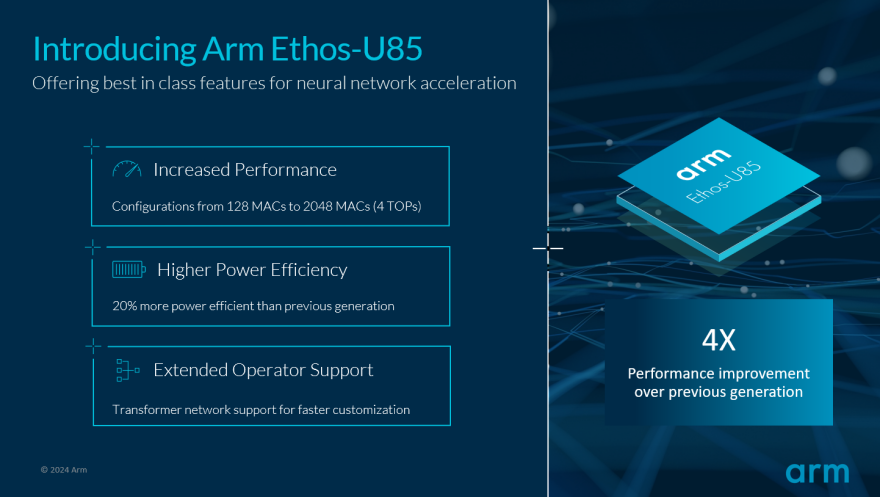

Arm推動生成式AI落地邊緣!全新Ethos-U85 AI加速器支持Transformer 架構,性能提升四倍

Hitek Systems開發基于PCIe的高性能加速器以滿足行業需求

昆侖芯AI加速器組R480-X8滿足大型模型訓練和推理的需求

昆侖芯AI加速器組R480-X8滿足大型模型訓練和推理的需求

評論