6月,在第五屆智源大會AI系統分論壇上,上海天數智芯半導體有限公司(以下簡稱“天數智芯”)對外宣布,在天垓100加速卡的算力集群,基于北京智源人工智能研究院(以下簡稱“智源研究院”)70億參數的Aquila語言基礎模型,使用代碼數據進行繼續訓練,穩定運行19天,模型收斂效果符合預期,證明天數智芯有支持百億級參數大模型訓練的能力。

在北京市海淀區的大力支持下,智源研究院、天數智芯與愛特云翔共同合作,聯手開展基于自主通用GPU的大模型CodeGen(高效編碼)項目,通過中文描述來生成可用的C、Java、Python代碼以實現高效編碼。智源研究院負責算法設計、訓練框架開發、大模型的訓練與調優,天數智芯負責提供天垓100加速卡、構建算力集群及全程技術支持,愛特云翔負責提供算存網基礎硬件及智能化運維服務。

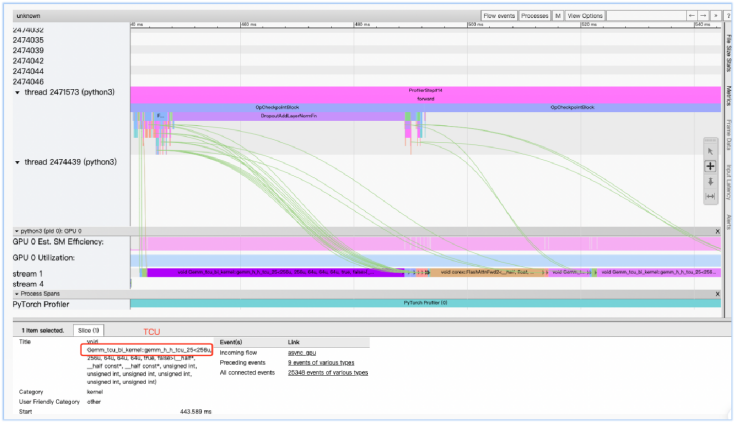

在三方的共同努力下,在基于天垓100加速卡的算力集群上,100B Tokens編程語料、70億參數量的AquilaCode大模型參數優化工作結果顯示,1個Epoch后loss下降到0.8,訓練速度達到87K Tokens/s,線性加速比高達95%以上。與國際主流的A100加速卡集群相比,天垓100加速卡集群的收斂效果、訓練速度、線性加速比相當,穩定性更優。在HumanEval基準數據集上,以Pass@1作為評估指標,自主算力集群訓練出來的模型測試結果達到相近參數級別大模型的SOAT水平,在AI編程能力與國際主流GPU產品訓練結果相近。

圖 基于天垓100算力集群的AquilaCode大模型訓練性能采樣

天垓100率先完成百億級參數大模型訓練,邁出了自主通用GPU大模型應用的重要的一步。這一成果充分證明了天垓產品可以支持大模型訓練,打通了國內大模型創新發展的關鍵“堵點”,對于我國大模型自主生態建設、產業鏈安全保障具有十分重大的意義。

接下來,天數智芯將與合作伙伴們繼續深入合作,建設更大規模的天垓100算力集群,完成更大參數規模的大模型訓練,以自主通用GPU產品更好支持國內大模型創新應用,進一步夯實我國算力基礎,助力人工智能產業自主生態建設。

責任編輯:彭菁

-

編程

+關注

關注

88文章

3637瀏覽量

93988 -

模型

+關注

關注

1文章

3313瀏覽量

49231 -

天數智芯

+關注

關注

0文章

97瀏覽量

5583

原文標題:天垓100率先完成百億級參數大模型訓練,天數智芯迎來新的里程碑

文章出處:【微信號:IluvatarCoreX,微信公眾號:天數智芯】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

昆侖芯率先完成Deepseek訓練推理全版本適配

紫光國芯與天翼云完成兼容互認證

摩爾線程與羽人科技完成大語言模型訓練測試

llm模型訓練一般用什么系統

天數智芯參與建設的中國移動智算中心(呼和浩特)項目圓滿完成

深度學習模型訓練過程詳解

依圖天問大模型4.0重磅發布

摩爾線程與師者AI攜手完成70億參數教育AI大模型訓練測試

摩爾線程和滴普科技完成大模型訓練與推理適配

【大語言模型:原理與工程實踐】大語言模型的預訓練

【大語言模型:原理與工程實踐】揭開大語言模型的面紗

天數智芯主導DeepSpark開源社區百大應用開放平臺24.03版本正式發布

天數智芯天垓100率先完成百億級參數大模型訓練

天數智芯天垓100率先完成百億級參數大模型訓練

評論