01

—

方法介紹

Few-shot NER的三階段:Train、Adapt、Recognize,即在source域訓(xùn)練,在target域的support上微調(diào),在target域的query上測試。

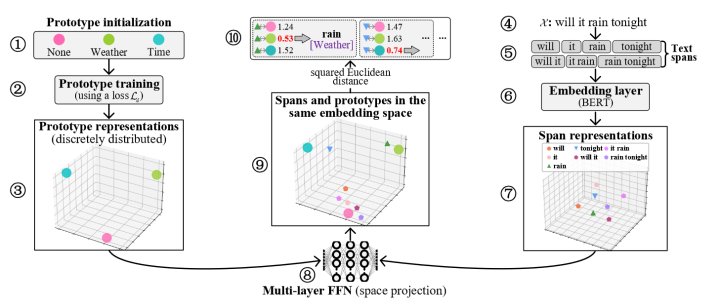

如上圖,左邊(1-3)表示的是原型的loss1(訓(xùn)練目標(biāo)為各個原型分散分布),右邊(4-7)表示的是span的representation獲取,中間(8)是一個多層FFN(為了使得原型表示和span表示最終映射到同一個向量空間),中間(9-10)則是計算原型和span在同一個空間的loss2(為了使得實(shí)體span更靠近原型表示)

02

—

和過往工作相比

1、使得Adapt階段不只是通過對support集中的實(shí)體詞表示平均得到實(shí)體原型表示,而是能夠進(jìn)行finetune(文中提到Ma et al. (2022) claim that the finetuning method is far more effective in using the limited information in support sets.)

2、過往的原型網(wǎng)絡(luò)的訓(xùn)練方法使得最終的原型表示較接近,本文通過構(gòu)造loss1(上一段提到的)使得原型表示分散開

03

—

實(shí)驗(yàn)結(jié)果

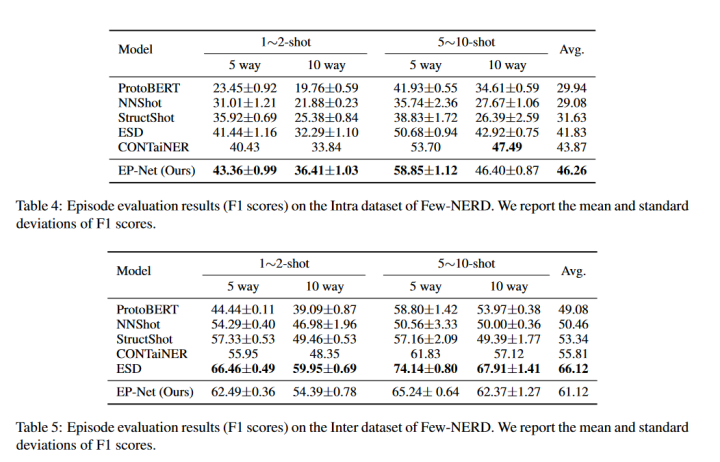

這里僅挑選附錄部分的FEW-NERD實(shí)驗(yàn)結(jié)果

從實(shí)驗(yàn)結(jié)果來看,在INTRA上效果較好,在INTER上不如ESD。其中INTRA是指source和target之間的實(shí)體的粗粒度類型無交集,INTER則在粗粒度上有交集(細(xì)粒度上無交集)。(另外,2022年還有一篇SOTA文章Decomposed metalearning for few-shot named entity recognition,這里沒有進(jìn)行對比)

04

—

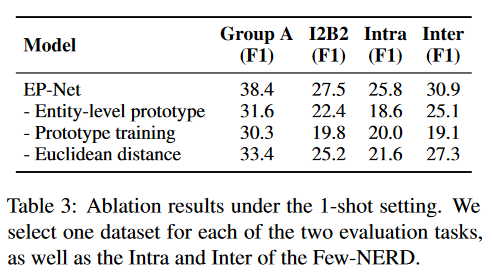

消融實(shí)驗(yàn)

1、使用token-level

2、缺少loss1(把原型打散的loss,方法介紹中有說)

3、使用cosine similarity而不是Euclidean distance來衡量span-prototype相似度

-

網(wǎng)絡(luò)

+關(guān)注

關(guān)注

14文章

7600瀏覽量

89251 -

Target

+關(guān)注

關(guān)注

0文章

13瀏覽量

8490

原文標(biāo)題:COLING2022 | 少樣本NER:分散分布原型增強(qiáng)的實(shí)體級原型網(wǎng)絡(luò)

文章出處:【微信號:zenRRan,微信公眾號:深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

基于將 CLIP 用于下游few-shot圖像分類的方案

三階段充電器的關(guān)鍵參數(shù)疑點(diǎn)

中國聯(lián)通召開學(xué)習(xí)實(shí)踐活動第三階段工作會議

中芯國際將在2019年量產(chǎn)14納米FinFET,并勾勒28納米三階段藍(lán)圖

5G第三階段測試規(guī)劃詳解

五大設(shè)備商的5G三階段測試進(jìn)展對比

我國5G完成第三階段測試 離5G商用又近了一步

華為完成中國5G技術(shù)研發(fā)試驗(yàn)第三階段測試 刷新業(yè)界紀(jì)錄

京東方投34億元建12英寸OLED微顯示器件生產(chǎn)線,分三階段

介紹兩個few-shot NER中的challenge

UBBF 2023 | 邁向F5.5G,華為發(fā)布三階段全光目標(biāo)網(wǎng)架構(gòu)

邁向F5.5G,華為發(fā)布三階段全光目標(biāo)網(wǎng)架構(gòu)

基于顯式證據(jù)推理的few-shot關(guān)系抽取CoT

Few-shot NER的三階段

Few-shot NER的三階段

評論