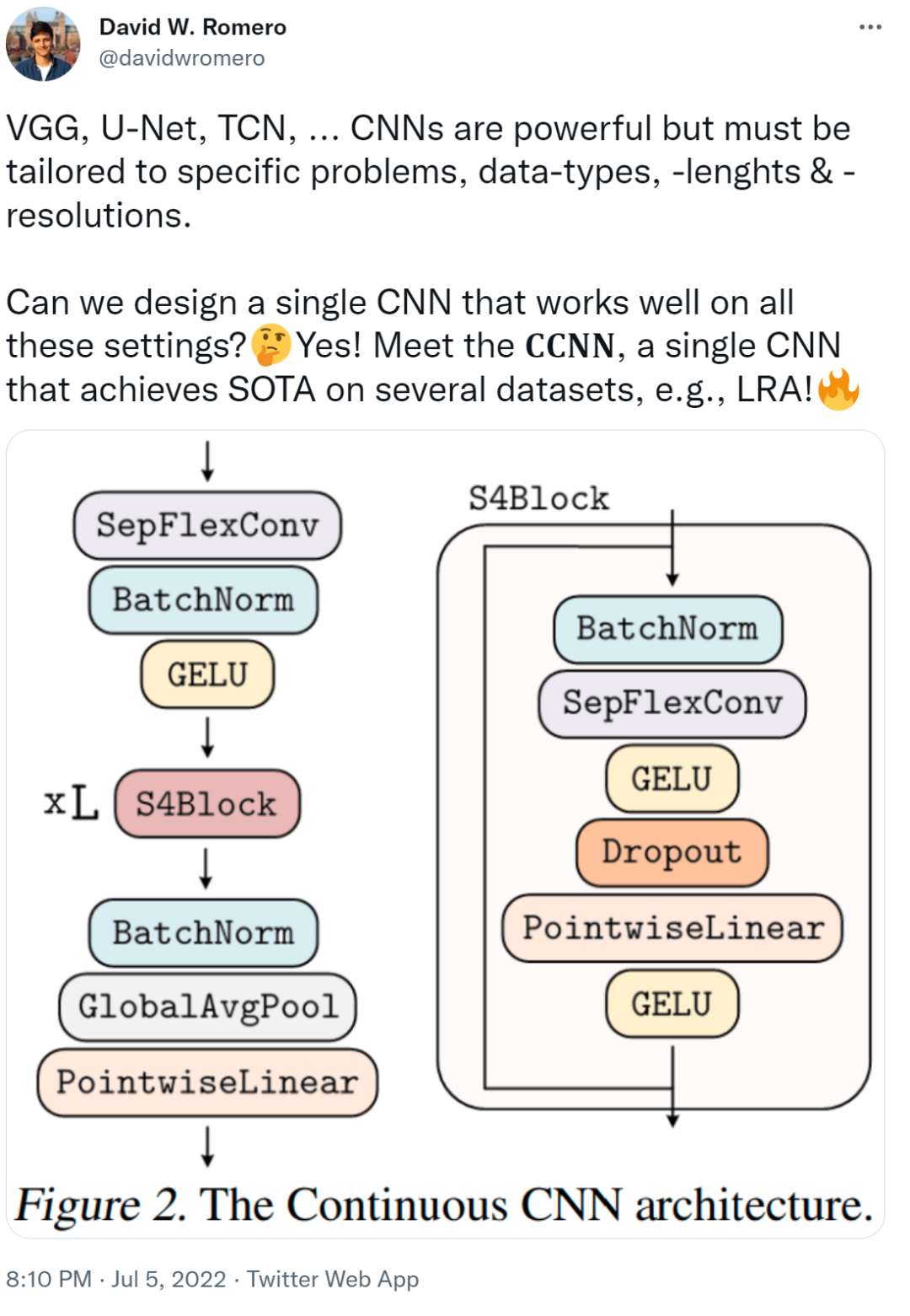

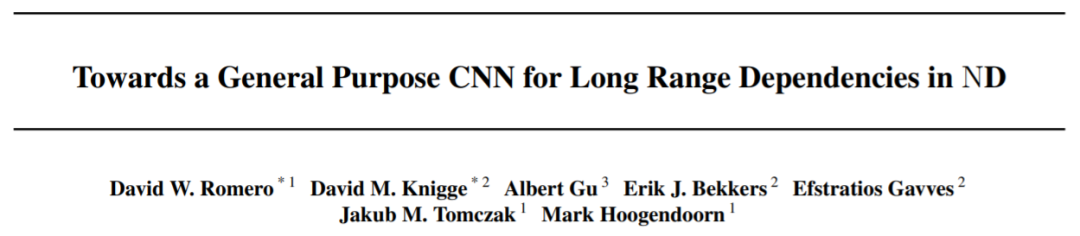

在 VGG、U-Net、TCN 網(wǎng)絡(luò)中... CNN 雖然功能強(qiáng)大,但必須針對(duì)特定問題、數(shù)據(jù)類型、長(zhǎng)度和分辨率進(jìn)行定制,才能發(fā)揮其作用。我們不禁會(huì)問,可以設(shè)計(jì)出一個(gè)在所有這些網(wǎng)絡(luò)中都運(yùn)行良好的單一 CNN 嗎? 本文中,來自阿姆斯特丹自由大學(xué)、阿姆斯特丹大學(xué)、斯坦福大學(xué)的研究者提出了 CCNN,單個(gè) CNN 就能夠在多個(gè)數(shù)據(jù)集(例如 LRA)上實(shí)現(xiàn) SOTA !

- 論文地址:https://arxiv.org/pdf/2206.03398.pdf

- 代碼地址:https://github.com/david-knigge/ccnn

- 該研究提出 Continuous CNN(CCNN):一個(gè)簡(jiǎn)單、通用的 CNN,可以跨數(shù)據(jù)分辨率和維度使用,而不需要結(jié)構(gòu)修改。CCNN 在序列 (1D)、視覺 (2D) 任務(wù)、以及不規(guī)則采樣數(shù)據(jù)和測(cè)試時(shí)間分辨率變化的任務(wù)上超過 SOTA;

- 該研究對(duì)現(xiàn)有的 CCNN 方法提供了幾種改進(jìn),使它們能夠匹配當(dāng)前 SOTA 方法,例如 S4。主要改進(jìn)包括核生成器網(wǎng)絡(luò)的初始化、卷積層修改以及 CNN 的整體結(jié)構(gòu)。

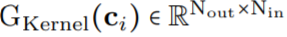

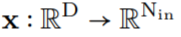

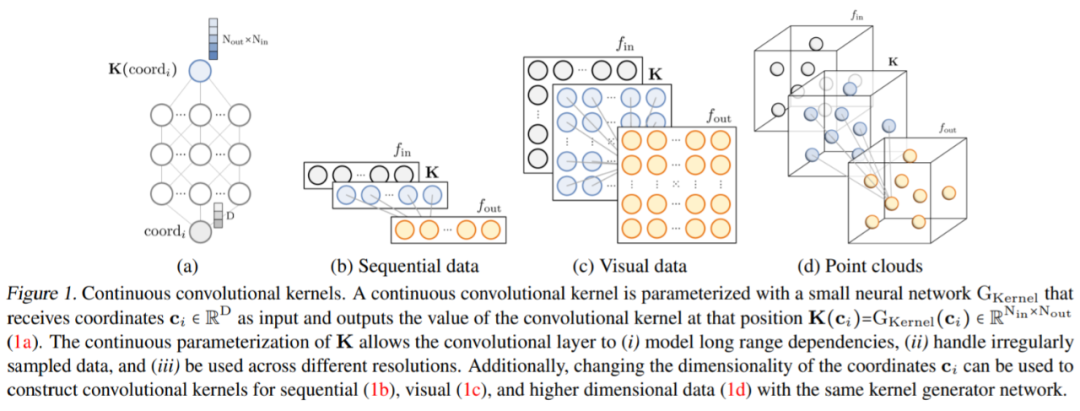

作為核生成器網(wǎng)絡(luò),同時(shí)將卷積核參數(shù)化為連續(xù)函數(shù)。該網(wǎng)絡(luò)將坐標(biāo)

作為核生成器網(wǎng)絡(luò),同時(shí)將卷積核參數(shù)化為連續(xù)函數(shù)。該網(wǎng)絡(luò)將坐標(biāo) 映射到該位置的卷積核值:

映射到該位置的卷積核值: (圖 1a)。通過將 K 個(gè)坐標(biāo)

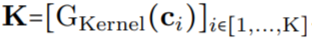

(圖 1a)。通過將 K 個(gè)坐標(biāo) 的向量通過 G_Kernel,可以構(gòu)造一個(gè)大小相等的卷積核 K,即

的向量通過 G_Kernel,可以構(gòu)造一個(gè)大小相等的卷積核 K,即 。隨后,在輸入信號(hào)

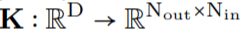

。隨后,在輸入信號(hào) 和生成的卷積核

和生成的卷積核 之間進(jìn)行卷積運(yùn)算,以構(gòu)造輸出特征表示

之間進(jìn)行卷積運(yùn)算,以構(gòu)造輸出特征表示 ,即

,即 。

。

任意數(shù)據(jù)維度的一般操作。通過改變輸入坐標(biāo) c_i 的維數(shù) D,核生成器網(wǎng)絡(luò) G_Kernel 可用于構(gòu)造任意維數(shù)的卷積核。因此可以使用相同的操作來處理序列 D=1、視覺 D=2 和更高維數(shù)據(jù) D≥3。 不同輸入分辨率的等效響應(yīng)。如果輸入信號(hào) x 有分辨率變化,例如最初在 8KHz 觀察到的音頻現(xiàn)在在 16KHz 觀察到,則與離散卷積核進(jìn)行卷積以產(chǎn)生不同的響應(yīng),因?yàn)楹藢⒃诿總€(gè)分辨率下覆蓋不同的輸入子集。另一方面,連續(xù)核是分辨率無關(guān)的,因此無論輸入的分辨率如何,它都能夠識(shí)別輸入。 當(dāng)以不同的分辨率(例如更高的分辨率)呈現(xiàn)輸入時(shí),通過核生成器網(wǎng)絡(luò)傳遞更精細(xì)的坐標(biāo)網(wǎng)格就足夠了,以便以相應(yīng)的分辨率構(gòu)造相同的核。對(duì)于以分辨率 r (1) 和 r (2) 采樣的信號(hào) x 和連續(xù)卷積核 K,兩種分辨率下的卷積大約等于與分辨率變化成比例的因子:

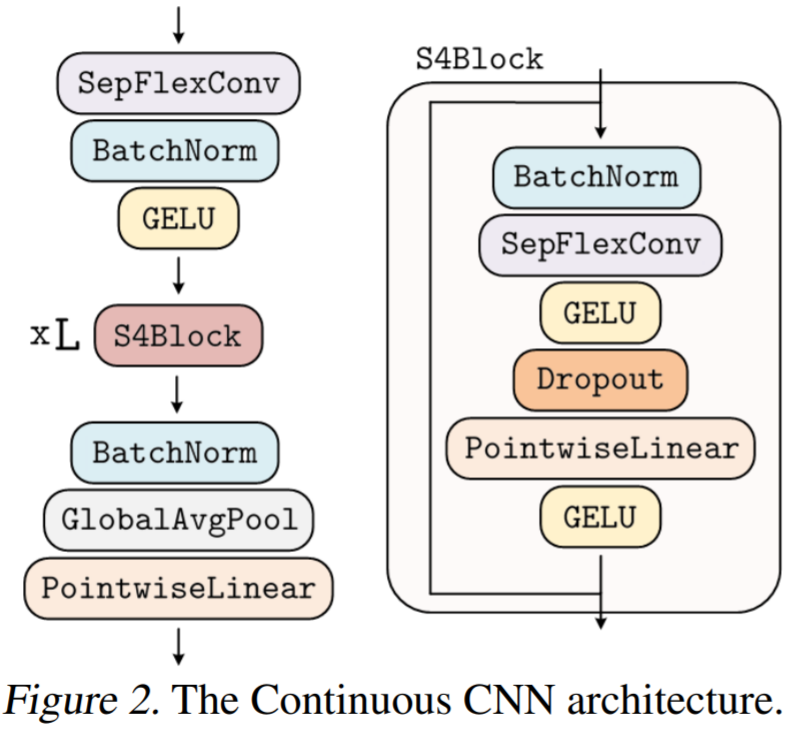

生成的核計(jì)算的,之后是從 N_in 到 N_out 進(jìn)行逐點(diǎn)卷積。這種變化允許構(gòu)建更廣泛的 CCNN—— 從 30 到 110 個(gè)隱藏通道,而不會(huì)增加網(wǎng)絡(luò)參數(shù)或計(jì)算復(fù)雜度。

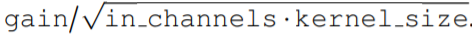

生成的核計(jì)算的,之后是從 N_in 到 N_out 進(jìn)行逐點(diǎn)卷積。這種變化允許構(gòu)建更廣泛的 CCNN—— 從 30 到 110 個(gè)隱藏通道,而不會(huì)增加網(wǎng)絡(luò)參數(shù)或計(jì)算復(fù)雜度。正確初始化核生成器網(wǎng)絡(luò) G_Kernel。該研究觀察到,在以前的研究中核生成器網(wǎng)絡(luò)沒有正確初始化。在初始化前,人們希望卷積層的輸入和輸出的方差保持相等,以避免梯度爆炸和消失,即 Var (x)=Var (y)。因此,卷積核被初始化為具有方差 Var (K)=gain^2 /(in channels ? kernel size) 的形式,其增益取決于所使用的非線性。 然而,神經(jīng)網(wǎng)絡(luò)的初始化使輸入的 unitary 方差保留在輸出。因此,當(dāng)用作核生成器網(wǎng)絡(luò)時(shí),標(biāo)準(zhǔn)初始化方法導(dǎo)致核具有 unitary 方差,即 Var (K)=1。結(jié)果,使用神經(jīng)網(wǎng)絡(luò)作為核生成器網(wǎng)絡(luò)的 CNN 經(jīng)歷了與通道?內(nèi)核大小成比例的特征表示方差的逐層增長(zhǎng)。例如,研究者觀察到 CKCNNs 和 FlexNets 在初始化時(shí)的 logits 大約為 1e^19。這是不可取的,這可能導(dǎo)致訓(xùn)練不穩(wěn)定和需要低學(xué)習(xí)率。 為了解決這個(gè)問題,該研究要求 G_Kernel 輸出方差等于 gain^2 /(in_channels?kernel_size)而不是 1。他們通過、

重新加權(quán)核生成器網(wǎng)絡(luò)的最后一層。因此,核生成器網(wǎng)絡(luò)輸出的方差遵循傳統(tǒng)卷積核的初始化,而 CCNN 的 logits 在初始化時(shí)呈現(xiàn)單一方差。

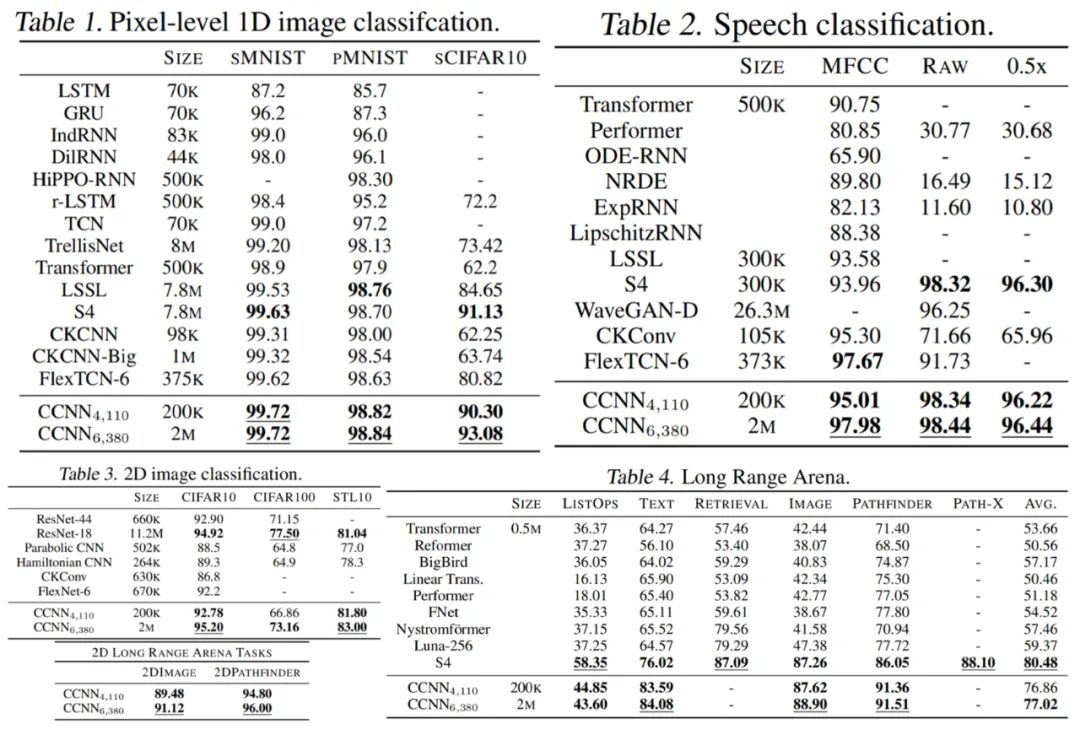

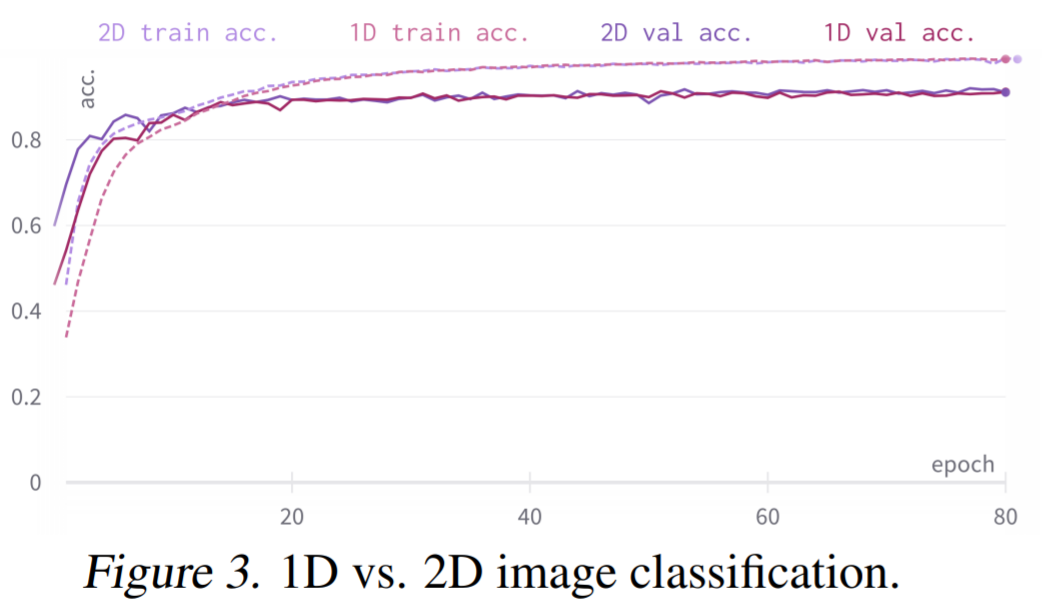

重新加權(quán)核生成器網(wǎng)絡(luò)的最后一層。因此,核生成器網(wǎng)絡(luò)輸出的方差遵循傳統(tǒng)卷積核的初始化,而 CCNN 的 logits 在初始化時(shí)呈現(xiàn)單一方差。實(shí)驗(yàn)結(jié)果 如下表 1-4 所示,CCNN 模型在所有任務(wù)中都表現(xiàn)良好。 首先是 1D 圖像分類 CCNN 在多個(gè)連續(xù)基準(zhǔn)上獲得 SOTA,例如 Long Range Arena、語(yǔ)音識(shí)別、1D 圖像分類,所有這些都在單一架構(gòu)中實(shí)現(xiàn)的。CCNN 通常比其他方法模型更小架構(gòu)更簡(jiǎn)單。 然后是 2D 圖像分類:通過單一架構(gòu),CCNN 可以匹配并超越更深的 CNN。

聲明:本文內(nèi)容及配圖由入駐作者撰寫或者入駐合作網(wǎng)站授權(quán)轉(zhuǎn)載。文章觀點(diǎn)僅代表作者本人,不代表電子發(fā)燒友網(wǎng)立場(chǎng)。文章及其配圖僅供工程師學(xué)習(xí)之用,如有內(nèi)容侵權(quán)或者其他違規(guī)問題,請(qǐng)聯(lián)系本站處理。

舉報(bào)投訴

-

架構(gòu)

+關(guān)注

關(guān)注

1文章

519瀏覽量

25556 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5516瀏覽量

121557 -

cnn

+關(guān)注

關(guān)注

3文章

353瀏覽量

22338

原文標(biāo)題:解決CNN固有缺陷, CCNN憑借單一架構(gòu),實(shí)現(xiàn)多項(xiàng)SOTA

文章出處:【微信號(hào):CVSCHOOL,微信公眾號(hào):OpenCV學(xué)堂】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

想選擇一款能夠實(shí)現(xiàn)多個(gè)通道數(shù)據(jù)采集的ADC,求推薦

各位專家好!這邊想選擇一款能夠實(shí)現(xiàn)多個(gè)通道數(shù)據(jù)采集的ADC,由于對(duì)通道間的幅度和相位一致性要求較高,最好可以嚴(yán)格控制各通道之間的同步,要求單個(gè)

發(fā)表于 01-24 08:28

Mamba入局圖像復(fù)原,達(dá)成新SOTA

MambaIRv2,更高性能、更高效率!另外還有ACM MM 2024上的Freqmamba方法,在圖像去雨任務(wù)中取得了SOTA性能! 顯然,這種基于Mamba的方法在圖像復(fù)原領(lǐng)域,比

在單個(gè)C2000?MCU上使用FCL和SFRA進(jìn)行雙軸電機(jī)控制

電子發(fā)燒友網(wǎng)站提供《在單個(gè)C2000?MCU上使用FCL和SFRA進(jìn)行雙軸電機(jī)控制.pdf》資料免費(fèi)下載

發(fā)表于 09-14 09:40

?0次下載

CISC(復(fù)雜指令集)與RISC(精簡(jiǎn)指令集)的區(qū)別

的例子如果要在RISC架構(gòu)上實(shí)現(xiàn),將ADDRA, ADDRB中的數(shù)據(jù)讀入寄

存器,相乘和將結(jié)果寫回內(nèi)存的操作都必須由軟件來實(shí)現(xiàn),比如:MOV A, ADDRA; MOV B, ADDR

發(fā)表于 07-30 17:21

請(qǐng)問如何使用AT CIPSEND或AT CIPSENDBUF發(fā)送多個(gè)數(shù)據(jù)包?

我可以使用 AT CIPSEND 發(fā)送單個(gè)數(shù)據(jù)包。但是我必須發(fā)送一系列二進(jìn)制數(shù)據(jù)包。如何使用AT CISEND或AT CIPSENDBUF發(fā)送多個(gè)數(shù)據(jù)包,什么是正確的算法?

到目前為止,我嘗試

發(fā)表于 07-15 07:37

20個(gè)數(shù)據(jù)可以訓(xùn)練神經(jīng)網(wǎng)絡(luò)嗎

當(dāng)然可以,20個(gè)數(shù)據(jù)點(diǎn)對(duì)于訓(xùn)練一個(gè)神經(jīng)網(wǎng)絡(luò)來說可能非常有限,但這并不意味著它們不能用于訓(xùn)練。實(shí)際上,神經(jīng)網(wǎng)絡(luò)可以訓(xùn)練在非常小的數(shù)據(jù)集

CNN在多個(gè)領(lǐng)域中的應(yīng)用

,通過多層次的非線性變換,能夠捕捉到數(shù)據(jù)中的隱藏特征;而卷積神經(jīng)網(wǎng)絡(luò)(CNN),作為神經(jīng)網(wǎng)絡(luò)的一種特殊形式,更是在圖像識(shí)別、視頻處理等領(lǐng)域展現(xiàn)出了卓越的性能。本文旨在深入探究深度學(xué)習(xí)、

CNN的定義和優(yōu)勢(shì)

CNN是模型還是算法的問題,實(shí)際上它兼具了兩者的特性,但更側(cè)重于作為一種模型存在。本文將從CNN的定義、結(jié)構(gòu)、原理、應(yīng)用等多個(gè)方面進(jìn)行深入探討,旨在全面解析

如何利用CNN實(shí)現(xiàn)圖像識(shí)別

卷積神經(jīng)網(wǎng)絡(luò)(CNN)是深度學(xué)習(xí)領(lǐng)域中一種特別適用于圖像識(shí)別任務(wù)的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)。它通過模擬人類視覺系統(tǒng)的處理方式,利用卷積、池化等操作,自動(dòng)提取圖像中的特征,進(jìn)而實(shí)現(xiàn)高效的圖像識(shí)別。本文將從CNN的基本原理、構(gòu)建過程、訓(xùn)練策略以

cnn卷積神經(jīng)網(wǎng)絡(luò)三大特點(diǎn)是什么

(Local Connectivity) 局部連接是CNN的核心特點(diǎn)之一,它允許網(wǎng)絡(luò)在處理圖像時(shí)只關(guān)注局部區(qū)域的特征。與傳統(tǒng)的全連接神經(jīng)網(wǎng)絡(luò)不同,CNN的卷積層只對(duì)輸入數(shù)據(jù)的局部區(qū)域進(jìn)

卷積神經(jīng)網(wǎng)絡(luò)cnn模型有哪些

(Convolutional Layer) 卷積層是CNN的核心,用于提取圖像的局部特征。卷積操作通過滑動(dòng)窗口(濾波器或卷積核)在輸入數(shù)據(jù)上進(jìn)行計(jì)算,生成特征圖(Feature Map)。卷積核的權(quán)重在訓(xùn)練

NB81是否支持OneNet SOTA功能?應(yīng)該如何激活SOTA?

NB81是否支持OneNet SOTA功能?

可以支持,應(yīng)該如何激活SOTA?

發(fā)表于 06-04 06:14

旋變位置不變的情況下,當(dāng)使能SOTA功能與關(guān)閉SOTA功能時(shí),APP中DSADC采樣得到的旋變sin和cos兩者值不一樣,為什么?

旋變位置不變的情況下,當(dāng)使能SOTA功能與關(guān)閉SOTA功能時(shí),APP中DSADC采樣得到的旋變sin和cos兩者值不一樣,用示波器采的輸入到MCU端的差分電壓是一樣的,難道是SOTA使能后影響了MCU芯片內(nèi)部的等效阻抗嗎,有專家

發(fā)表于 05-17 08:13

stm32讀sd卡單個(gè)數(shù)據(jù)塊最后80個(gè)字節(jié)全是0,怎么crc還校驗(yàn)正確?

stm32 讀sd卡單個(gè)數(shù)據(jù)塊最后80個(gè)字節(jié)全是0,怎么crc還校驗(yàn)正確。PS. 用的是SDIO口,4bit總線,1M的SDIO_CK.

發(fā)表于 04-25 07:19

宏集eX700M系列HMI實(shí)現(xiàn)港口設(shè)備數(shù)據(jù)上云

宏集eX700M系列HMI幫助國(guó)內(nèi)某信息化公司實(shí)現(xiàn)港口設(shè)備的數(shù)據(jù)采集、處理和上云,推動(dòng)港口設(shè)備信息化。

單個(gè)CNN就能夠在多個(gè)數(shù)據(jù)集上實(shí)現(xiàn)SOTA

單個(gè)CNN就能夠在多個(gè)數(shù)據(jù)集上實(shí)現(xiàn)SOTA

評(píng)論