NVIDIA A30 GPU 基于最新的 NVIDIA Ampere 體系結(jié)構(gòu),可加速各種工作負載,如大規(guī)模人工智能推理、企業(yè)培訓和數(shù)據(jù)中心主流服務器的 HPC 應用程序。 A30 PCIe 卡將第三代 Tensor 內(nèi)核與大容量 HBM2 內(nèi)存( 24 GB )和快速 GPU 內(nèi)存帶寬( 933 GB / s )組合在一個低功耗外殼中(最大 165 W )。

A30 支持廣泛的數(shù)學精度:

雙精度( FP64 )

單精度( FP32 )

半精度( FP16 )

腦浮 16 ( BF16 )

整數(shù)( INT8 )

它還支持 Tensor Float 32 ( TF32 )和 Tensor Core FP64 等創(chuàng)新技術(shù),提供了一個單一的加速器來加速每個工作負載。

圖 1 顯示了 TF32 ,其范圍為 FP32 ,精度為 FP16 。 TF32 是 PyTorch 、 TensorFlow 和 MXNet 中的默認選項,因此在上一代 NVIDIA Volta 架構(gòu)中實現(xiàn)加速不需要更改代碼。

A30 的另一個重要特點是多實例 GPU ( MIG )能力。 MIG 可以最大限度地提高從大到小工作負載的 GPU 利用率,并確保服務質(zhì)量( QoS )。單個 A30 最多可以被劃分為四個 MIG 實例,以同時運行四個應用程序,每個應用程序都與自己的流式多處理器( SMs )、內(nèi)存、二級緩存、 DRAM 帶寬和解碼器完全隔離。有關(guān)更多信息,請參閱 支持的 MIG 配置文件 。

對于互連, A30 支持 PCIe Gen4 ( 64 GB / s )和高速第三代 NVLink (最大 200 GB / s )。每個 A30 都可以支持一個 NVLink 橋接器與一個相鄰的 A30 卡連接。只要服務器中存在一對相鄰的 A30 卡,這對卡就應該通過跨越兩個 PCIe 插槽的 NVLink 橋接器連接,以獲得最佳橋接性能和平衡的橋接拓撲。

性能和平衡的橋接拓撲。

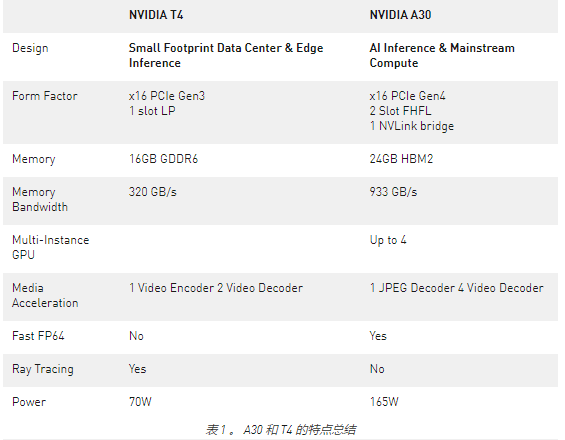

除了表 1 中總結(jié)的硬件優(yōu)勢外, A30 可以實現(xiàn)比 T4 GPU 更高的每美元性能。 A30 還支持端到端軟件堆棧解決方案:

圖書館

GPU 加速了 PyTorch 、 TensorFlow 和 MXNet 等深度學習框架

優(yōu)化的深度學習模型

可從 NGC 和[2000]以上的容器中獲得

性能分析

為了分析 A30 相對于 T4 和 CPU 的性能改進,我們使用以下數(shù)據(jù)集對 MLPerf 推斷 v1.1 。 中的六個模型進行了基準測試:

ResNet-50v1 。 5 ( ImageNet )

SSD 大尺寸 ResNet-34 ( COCO )

3D Unet (布拉茨 2019 )

DLRM ( 1TB 點擊日志,離線場景)

BERT (第 1.1 版,第 384 小節(jié))

RNN-T (圖書館語言)

MLPerf 基準測試套件 涵蓋了廣泛的推理用例,從圖像分類和對象檢測到推薦,以及自然語言處理( NLP )。

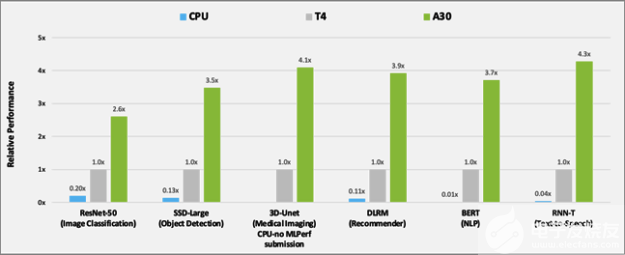

圖 2 顯示了 A30 與 T4 和 BERT 在人工智能推理工作負載上的性能比較結(jié)果。對于 CPU 推斷, A30 比 CPU 快約 300 倍。

與T4相比,A30在使用這六種機型進行推理時提供了大約3-4倍的性能加速比。性能加速是由于30個較大的內(nèi)存大小。這使得模型的批量更大,內(nèi)存帶寬更快(幾乎是3倍T4),可以在更短的時間內(nèi)將數(shù)據(jù)發(fā)送到計算核心。

圖 2 使用 MLPerf 比較 A30 與 T4 和 CPU 的性能。

CPU:8380H (不在 3D Unet 上提交)

除了人工智能推理之外, A30 還可以快速預訓練人工智能模型,例如 BERT 大型 TF32 ,以及使用 FP64 張量核加速 HPC 應用。帶有 TF32 的 A30 Tensor Cores 的性能比 T4 高出 10 倍,無需對代碼進行任何更改。它們還提供了自動混合精度的額外 2 倍提升,使吞吐量增加了 20 倍。

硬件解碼器

在構(gòu)建視頻分析或視頻處理管道時,必須考慮以下幾個操作:

計算模型或預處理步驟的需求。 這取決于 Tensor 內(nèi)核、 GPU DRAM 和其他硬件組件,它們可以加速模型或幀預處理內(nèi)核。

傳輸前的視頻流編碼。 這樣做是為了最小化網(wǎng)絡上所需的帶寬。為了加快這一工作量,請使用 NVIDIA 硬件解碼器。

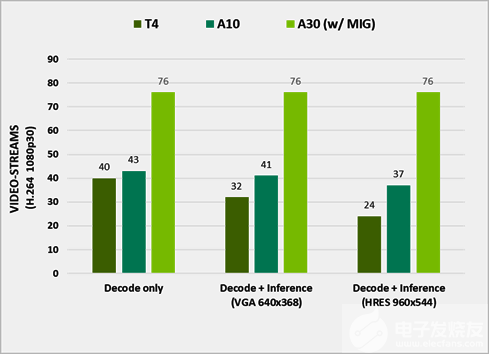

圖 3 在不同 GPU 上處理的流的數(shù)量

使用 DeepStream 5.1 測試性能。它代表了 e2e 在視頻捕獲和解碼、預處理、批處理、推理和后處理方面的性能。已關(guān)閉輸出渲染以獲得最佳性能,運行 ResNet10 、 ResNet18 和 ResNet50 網(wǎng)絡以推斷 H.264 1080p30 視頻流。

A30 旨在通過提供四個視頻解碼器、一個 JPEG 解碼器和一個光流解碼器來加速智能視頻分析( IVA )。

要使用這些解碼器和計算資源來分析視頻,請使用 NVIDIA DeepStream SDK ,它為基于人工智能的多傳感器處理、視頻、音頻和圖像理解提供了一個完整的流分析工具包。有關(guān)更多信息,請參閱 TAO 工具包與 DeepStream 的集成 或者 使用 NVIDIA DeepStream 構(gòu)建實時編校應用程序,第 1 部分:培訓 。

接下來呢?

A30 代表了數(shù)據(jù)中心最強大的端到端人工智能和 HPC 平臺,使研究人員、工程師和數(shù)據(jù)科學家能夠交付真實世界的結(jié)果,并將解決方案大規(guī)模部署到生產(chǎn)中。有關(guān)更多信息,請參閱 NVIDIA A30 Tensor Core GPU 數(shù)據(jù)表 和 NVIDIA A30 GPU 加速器產(chǎn)品簡介 。

關(guān)于作者

Maggie Zhang 是 NVIDIA 的深度學習工程師,致力于深度學習框架和應用程序。她在澳大利亞新南威爾士大學獲得計算機科學和工程博士學位,在那里她從事 GPU / CPU 異構(gòu)計算和編譯器優(yōu)化。

Tanay Varshney 是 NVIDIA 的一名深入學習的技術(shù)營銷工程師,負責廣泛的 DL 軟件產(chǎn)品。他擁有紐約大學計算機科學碩士學位,專注于計算機視覺、數(shù)據(jù)可視化和城市分析的橫斷面。

Davide Onofrio 是 NVIDIA 的高級深度學習軟件技術(shù)營銷工程師。他在 NVIDIA 專注于深度學習技術(shù)開發(fā)人員關(guān)注內(nèi)容的開發(fā)和演示。戴維德在生物特征識別、虛擬現(xiàn)實和汽車行業(yè)擔任計算機視覺和機器學習工程師已有多年經(jīng)驗。他的教育背景包括米蘭理工學院的信號處理博士學位。Ivan Belyavtsev 是一名圖形開發(fā)工程師,主要致力于開發(fā)人員支持和優(yōu)化基于虛擬引擎的游戲。他還是 Innopolis 大學游戲開發(fā)領(lǐng)域的計算機圖形學導師。

Shar Narasimhan 是 AI 的高級產(chǎn)品營銷經(jīng)理,專門從事 NVIDIA 的 Tesla 數(shù)據(jù)中心團隊的深度學習培訓和 OEM 業(yè)務。

審核編輯:郭婷

-

NVIDIA

+關(guān)注

關(guān)注

14文章

5076瀏覽量

103734 -

人工智能

+關(guān)注

關(guān)注

1796文章

47683瀏覽量

240337 -

深度學習

+關(guān)注

關(guān)注

73文章

5516瀏覽量

121559

發(fā)布評論請先 登錄

相關(guān)推薦

恩智浦推出EdgeLock A30安全認證器

恩智浦發(fā)布EdgeLock A30安全認證器

《CST Studio Suite 2024 GPU加速計算指南》

深度學習工作負載中GPU與LPU的主要差異

FPGA和ASIC在大模型推理加速中的應用

NVIDIA助力麗蟾科技打造AI訓練與推理加速解決方案

NVIDIA與思科合作打造企業(yè)級生成式AI基礎設施

AMD助力HyperAccel開發(fā)全新AI推理服務器

使用NVIDIA A30 GPU加速AI推理工作負載

使用NVIDIA A30 GPU加速AI推理工作負載

評論