為了到2025年實現采用人工智能(AI)的實時同聲傳譯,日本正推進研究。目前已完全可以實現語音識別,以后的目標是提高翻譯準確率和速度。世界上有很多和日語具有相同特征的語言,如果能實現日語的同聲傳譯,就有望推進國際性普及。

演講者用英語做大約1分鐘的演講,背后的屏幕上顯示出基于AI的日語同聲傳譯。這是日本情報通信研究機構(NICT,注:日語的“情報”有“信息”之意)2020年11月舉行的發布會上的一幕。從演講者發言到出現譯文大約需要10秒,但幾乎沒有翻譯錯誤。

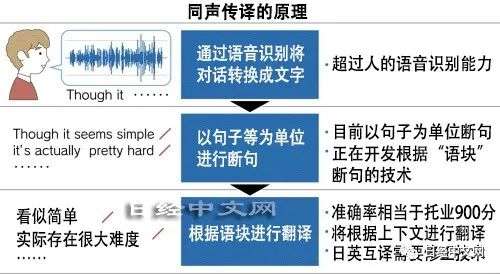

同聲傳譯一般是對說話內容進行語音識別,然后由使用AI的翻譯軟件將其轉換成其他語言。現有的服務大多是從說完話才開始翻譯。因此,語速快的對話很難翻譯,表達相同的內容時,同聲傳譯所用時間是母語會話時間的2倍。按這樣的水平很難用于商務用途,亟需可以克服這一缺點的技術。

現在同聲傳譯的翻譯準確率提高,但存在延時

日本情報通信研究機構通過2019年度之前的日本國家研究項目,已在語音識別方面實現了充分的性能。該機構的目標是從2020年度開始兼顧翻譯準確率和速度。發布會上有10秒的延時,但今后有望縮小到跟同聲傳譯人員相當的2、3秒。

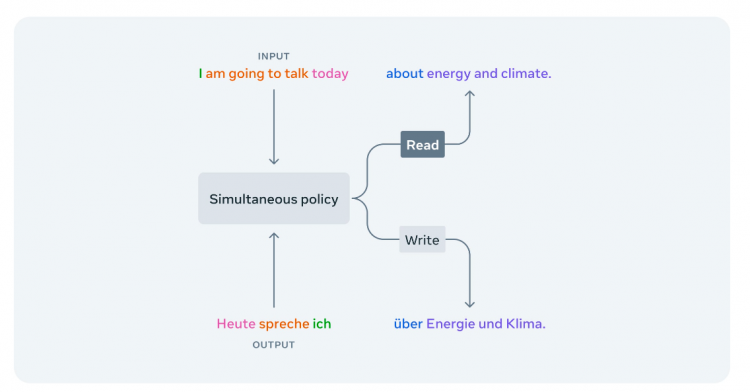

日本情報通信研究機構開發的是在發言過程中就可以開始翻譯的AI。斷句的預處理技術是其中的關鍵。

翻譯軟件由斷句的預處理和對句子進行翻譯的翻譯引擎構成。現有技術要想順暢翻譯,只能以句子單位進行斷句,因此會有延時。如果在說完話之前就開始翻譯,則可以縮短時差。

日本情報通信研究機構在預處理中采用按“語塊”(chunk,或稱:語義塊)斷句的方法,比以句子為單位斷句翻譯得更精準。專業的同聲傳譯人員也使用這種方法。這樣可以保證翻譯準確度,并減少延時。

日本情報通信研究機構在開發中將使用大量的數據。該機構在2021年度末之前,將從同聲傳譯人員等手中收集劃分語義的位置及其譯文的數據。2022年度將開發按照語義斷句并翻譯的AI。

與英譯日相比,日譯英的同聲傳譯難度更高。因為斷句的預處理比較難。

在日語中,動詞及表示否定等的重要詞語出現在句尾,因此需要預讀,然后進行翻譯。而動詞等關鍵詞語在句子前半部分出現的英語等更好翻譯。在日語中,句子省略主語的情況也很多,AI要補充完整句子以后再翻譯,因此容易出錯。

為了防止誤譯,需要進行修正的技術。比如提前給AI提供演講內容相關數據,讓它進行學習,它就能夠讀懂后面要說的話,從而更準確地完成同聲傳譯。

日本情報通信研究機構還將改進翻譯引擎。通過日英、英日及所有語言翻譯都使用的技術來控制翻譯準確度。如果這項性能不高,即使預處理速度再快、修正功能出色,也起不到作用。

日本情報通信研究機構的翻譯引擎除了市售的便攜式翻譯機以外,還被松下、NTT docomo及NEC等的語音翻譯服務采用。該機構的研究員隅田英一郎自信地說“英日翻譯準確率換算成托業考試(TOEIC)分數的話,相當于900分左右”。

在提高翻譯準確率方面值得期待的是,得到美國特斯拉首席執行官(CEO)馬斯克等人資助的研究企業OpenAI在2020年6月公布了語言AI“GPT-3”。這款AI可以寫出跟人水平接近的比較自然的文章。

GPT-3利用巨大的“大腦”學習大量文件,獲得了很強的能力。開發中使用的數據相當于數千億詞匯量。如果能在翻譯引擎中應用GPT-3的系統,就有可能大幅提高性能。

圍繞同聲傳譯,全球的大型IT企業都在競爭,不過日本情報通信研究機構仍有勝算。隅田研究員指出“美國微軟、中國百度及美國谷歌都是以句子為單位進行斷句,以語塊斷句的方法尚未取得成果。都在同一水平上”。各公司都在下力氣開發的中英語同聲傳譯也跟日本情報通信研究機構開發一樣,存在10秒左右的延時。

如果能實現日語翻成其他主要語言的同聲傳譯,在國際上就會占據優勢。

英語、中文及法語等使用人數較多的語言都是動詞跟在名詞后面的類型。占到全球語言的約4成。其實,世界上有一半語言和日語一樣,把動詞放在句尾。同類型的語言之間更容易實現同聲傳譯。如果在不同類型語言之間的同聲傳譯方面,能開發出優異的技術,則有可能應用于9成的語言。

責任編輯:xj

-

AI

+關注

關注

87文章

31534瀏覽量

270342 -

人工智能

+關注

關注

1796文章

47682瀏覽量

240300 -

翻譯

+關注

關注

0文章

47瀏覽量

10829

發布評論請先 登錄

相關推薦

Auracast廣播音頻創新實時語言翻譯解決方案

NVIDIA展望2025年AI的應用前景

中科創達RUBIK AI Glass Lite版預計2025年實現量產

AI加速采用推動存儲器市場2025年顯著增長

NVIDIA AI正加速推進藥物研發

小米隱秘布局AI眼鏡,預計2025年Q2發布

廣州市積極推進新型儲能產業 儲能產業到2025年力爭達600億元以上

美光預測AI需求將大幅增長,計劃2025年投產EUV DRAM

AI同聲傳譯技術的新興力量知了未來已推動跨語言溝通革新

中興通訊全場景AI終端應用與裸眼3D新品亮相

AI同聲傳譯讓你瞬間掌握60種語言的那一天會發生什么事情?

為了到2025年實現采用AI的實時同聲傳譯,日本正推進研究

為了到2025年實現采用AI的實時同聲傳譯,日本正推進研究

評論