NVMe over Fabric(又名NVMe- oF)是一種新興技術,它支持對數據中心的計算和存儲進行分解。美光科技正通過與Marvell、Foxconn-Ingrasys和英偉達(NVIDIA)等關鍵技術合作伙伴的合作,共同解鎖NVMe-oF技術可以帶來的優勢。我們還在開發創新技術,如異構存儲器存儲引擎(HSE),這將有助于使用NVMe-oF優化對閃存的大規模訪問。

NVMe-oF是什么?

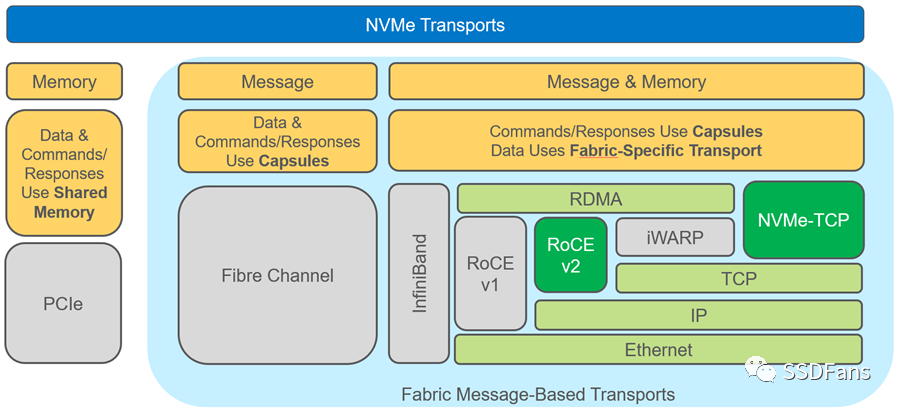

NVMe- oF從字面上來看是網絡上的NVMe協議的擴展,其擴展范圍遠遠超出了目前搭載SSD的服務器。NVMe早在2011年就出現了,而fabrics擴展則在2016年首次標準化。NVMe-oF繼承了NVMe的所有優點,包括輕量級和高效的命令集、多核感知和協議并行性。NVMe-oF是真正的網絡無關的,因為它支持所有常見的fabrics,包括光纖通道、InfiniBand和以太網。圖1比較了NVMe和NVMe- of模型,并標注出了用戶可用的各種網絡和網絡傳輸選項。

圖1 NVMe和NVMe-oF模型對比

從圖1可以看出,有兩種以太網傳輸選項,RoCE v2和NVMe-TCP,每一種都各有優缺點。RoCE v2延遲較低,但需要專用的支持RDMA的NIC (RNIC);NVMe-TCP不需要專用的RNIC,但是其傳輸延遲和CPU使用率都更高,它使用的是標準NIC。相比之下,RoCE v2目前在市場上更為流行。

NVMe over Fabrics的優勢是什么?

使用NVMe就意味著只能使用基于PCIe交換機的服務器機架。雖然這是一種完全有效的存儲擴展方法,但它的范圍是非常有限的。NVMe-oF則允許在數據中心范圍內連接無數的存儲空間。

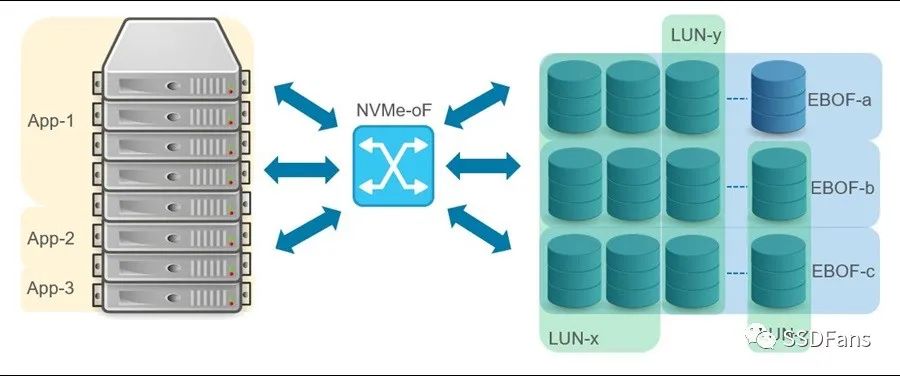

如今,NVMe-oF已經很成熟了,許多用戶接受了將全閃存陣列(AFA)連接到服務器的技術。然而,NVMe-oF的優勢只有在計算和存儲完全分開時才能完全發揮出來。也就是說,通過網絡將一個NVMe SSD池提供給一個服務器池,這種方式允許按需提供計算和存儲。計算和存儲的分解提升了存儲的可伸縮性和可共享性,并支持可組合性,如圖2所示。

圖2 計算和存儲分解圖

分類存儲的另一個維度是存儲服務(即數據保護、復制、壓縮等)。存儲服務可以由服務器(onload模型)管理,也可以卸載到接近實際存儲的數據處理單元(DPU)。onload模型需要消耗額外的CPU周期和網絡帶寬,可以實現成本最小化,而卸載模型的成本較高,并且根據供應情況,可能產生瓶頸。由于onload模型的TCO(總成本)優勢,大規模追求低成本存儲使其附加了存儲策略。

什么是EBOF、JBOF和JBOD ?

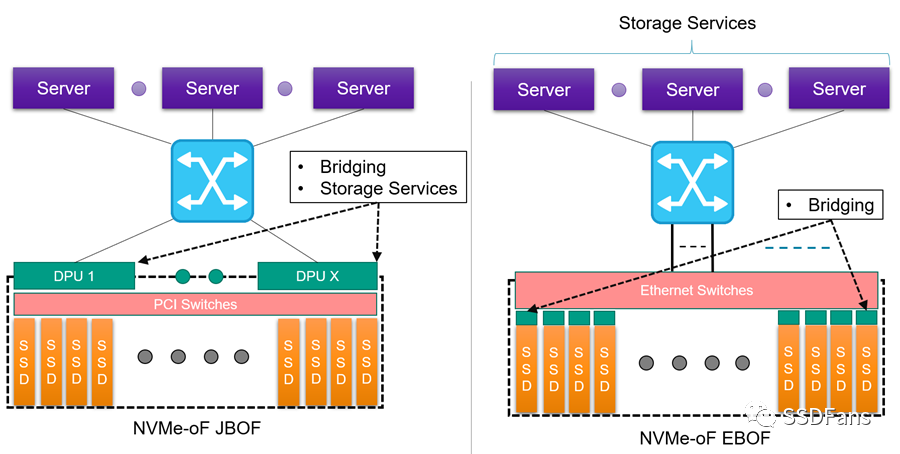

全閃存陣列有兩種接入方式: 通過網絡接入(EBOF)和直接連接 (JBOF)。不要混淆JBOF和JBOD(只是一堆磁盤)。JBOD通常用于在PCIe上使用NVMe擴展機架中的存儲。EBOF或JBOF可以使用NVMe-oF在數據中心之間擴展存儲。如圖3所示,JBOF使用PCIe交換機向SSD擴展,而EBOF使用以太網交換機向SSD擴展。JBOF和EBOF都使用NVMe-oF連接回服務器。

圖3 EBOF 和 JBOF對比圖

除了以太網和PCIe交換之外,這兩種方法的主要區別在于從NVMe到NVMe-oF的轉換發生在哪里。在JBOF上,轉換或橋接是在外圍使用一個或多個DPU (x DPU到y SSD, x:y比率)。在EBOF上,橋接在SSD載體完成(x橋接到x SSD, 1:1的比例)。雖然JBOF有使用DPU的處理能力來運行存儲服務的優勢,但它確實存在一個潛在的瓶頸,并且和EBOF模型相比,帶來了額外的成本,具有一些新功能。當橋與固態硬盤的比例不是1:1時,成本權衡和瓶頸問題就開始顯現出來了。

使用Marvell 88SN2400和Foxconn-Ingrasys EBOF測試系統

通過與Marvell和Foxconn-Ingrasys的合作,我們一直在NVMe- oF環境中測試Micron 7300主流NVMe SSD,并在各種不同的應用程序和工作負載下進行測試。

在介紹測試結果之前,讓我們先看一下Foxconn-Ingrasys EBOF和Marvell的88SN2400轉換器控制器和PresteraCX 8500交換機。

Marvell的88SN2400是一款用于云和企業數據中心的SSD轉換器的NVMe控制器。這與Marvell交換機相結合,本質上允許用戶在NVMe和NVMe- oF之間進行轉換或“橋接”。88SN2400轉換器控制器是Foxconn-Ingrasys EBOF的一個關鍵組件,與Micron 7300 SSD一起,使高性能2U存儲器達到高達73.1 GB/s的帶寬和高達2000萬IOPs。圖4顯示了Foxconn-Ingrasys EBOF,在2U機箱中有24 U.2插槽。

Foxconn-Ingrasys U.2 Carrier采用標準的U.2 SSD格式。U.2載波支持雙以太網端口,以解決需要路徑冗余的應用程序,它在驅動器側有一個PCIe Gen3 x4用于NVMe SSD。

Marvell的88SN2400轉換器控制器支持RoCE v2和NVMe-TCP傳輸。然而,在我們的測試中,我們關注的是RoCE v2。

如何使用NVIDIAGPUDirect存儲(GDS)進行擴展?

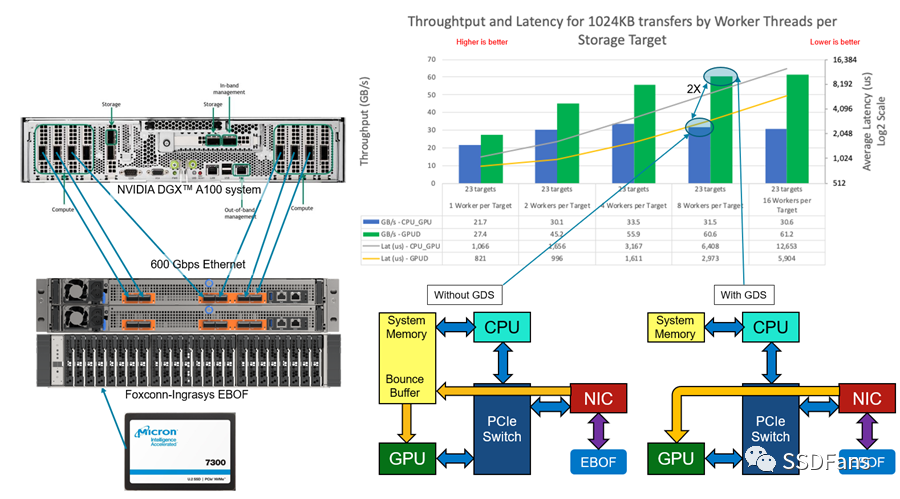

我們一直在使用NVIDIAGPUDirect存儲(GDS)在人工智能和機器學習工作負載方面進行大量工作。我們想通過將Foxconn-Ingrasys EBOF與Marvell的88SN2400轉換器控制器連接到NVIDIA DGXA100系統,來了解在fabrics環境中事物是如何伸縮的。這是一個簡單的gdsio (GPUDirect Storage I/O)工具測試,可以比較在NVMe-oF環境中使用和不使用GDS的帶寬和延遲。

圖6 DGX A100 with EBOF

在圖6中,有一個裝載了Micron 7300 SSD的EBOF,它使用8個計算網絡端口中的6個直接連接到NVIDIA DGXA100,提供600gb /s的可用網絡帶寬。GDS可以讓數據在對等點之間直接傳輸,跳過了在GDS未啟用時使用的高延遲反彈緩沖區。在這個測試中,我們將SSD的全部能力(約61 GB/s)用于工作負載。未來的測試將添加一個以太網交換機,并進一步擴大EBOF的數量。

NVMe-oF如何與HSE形成規模?

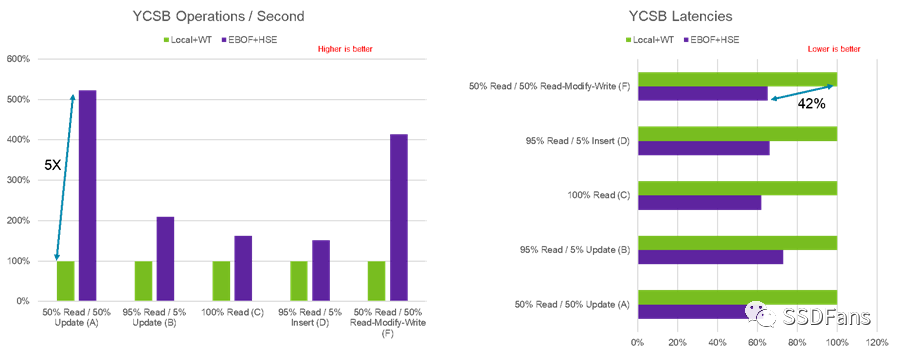

Micron一直在研究一些驚人的技術,其中之一是異構內存存儲引擎(HSE)。HSE是一個閃存感知的存儲引擎,它提高了存儲類內存(SCM)和SSD的性能。它還通過減少寫放大增加了SSD的有效壽命,所有這些都在大規模部署的情況下進行。NVMe-oF是進一步擴大HSE規模的理想途徑。為了驗證HSE在Fabric附加存儲環境下的有效性,我們使用MongoDB和YCSB (Yahoo!云服務基準)。在圖7中,我們比較了使用本地Micron 7300 SSD的默認內置MongoDB存儲引擎(WiredTiger)和使用Micron 7300 SSD的Micron HSE在EBOF中的性能。

圖7 WiredTiger和HSE對比圖

與MongoDB中使用的帶有本地SSD的傳統WiredTiger存儲引擎相比,HSE在fabric環境中的有效性是非常顯著的。可以實現每秒5倍的YCSB操作改進,降低42%的延遲,同時增加了存儲的可伸縮性。

NVMe-oF的未來是什么?

NVMe-oF是一種創新技術,它最終將使數據中心完全分解,在這些中心中,可以組合應用程序,然后以一種經濟有效的方式動態地提供適量的計算和存儲。

如今,人們使用低成本橋接器或基于處理器的平臺來連接NVMe SSD,并將其橋接到EBOF或JBOF。在未來,我們可能會看到SSD的本地NVMe進一步降低TCO并提高性能。

美光科技正在設計下一代數據中心SSD,其功能和特性針對NVMe應用進行了優化。

責任編輯:xj

原文標題:再見,Intel!GPU直連NVMe SSD!

文章出處:【微信公眾號:ssdfans】歡迎添加關注!文章轉載請注明出處。

-

gpu

+關注

關注

28文章

4775瀏覽量

129357 -

intel

+關注

關注

19文章

3483瀏覽量

186439 -

SSD

+關注

關注

21文章

2887瀏覽量

117859 -

nvme

+關注

關注

0文章

222瀏覽量

22732

原文標題:再見,Intel!GPU直連NVMe SSD!

文章出處:【微信號:SSDFans,微信公眾號:SSDFans】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

三個月開發NVMe IP 不是夢

存儲技術未來演進:NVMe over Fabrics (NVMeoF)

一文詳解 ALINX NVMe IP 特性

淺談ALINX NVMe IP產品特性

得瑞領新亮相2024云棲大會,展現企業級NVMe SSD創新實力

m2接口sata和nvme怎么區分

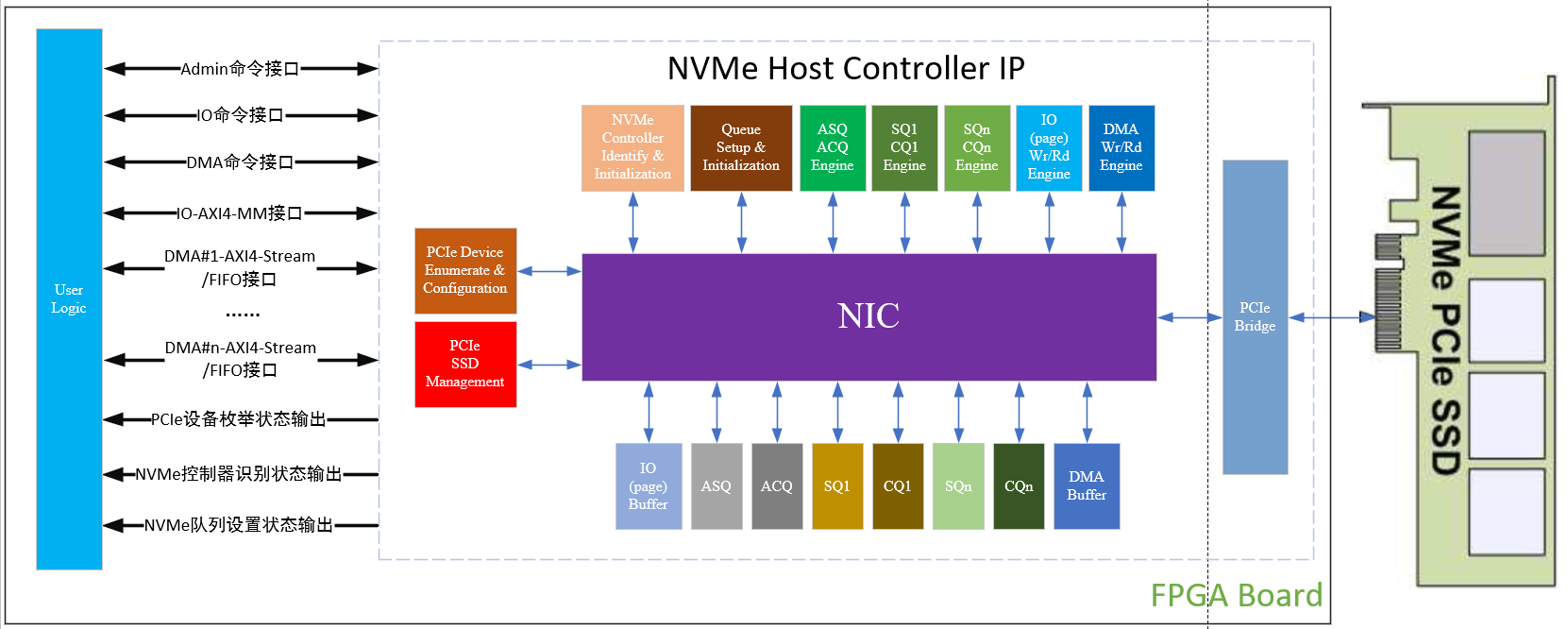

高性能NVMe主機控制器,Xilinx FPGA PCIe 3

高性能NVMe主機控制器,Xilinx FPGA NVMe Host Accelerator IP

Xilinx FPGA高性能NVMe SSD主機控制器,NVMe Host Controller IP

Xilinx FPGA NVMe主機控制器IP,高性能版本介紹應用

NVMe Host Controller IP實現高性能存儲解決方案

Xilinx FPGA NVMe Host Controller IP,NVMe主機控制器

Xilinx FPGA NVMe控制器,NVMe Host Controller IP

NVMe-oF的優勢及未來

NVMe-oF的優勢及未來

評論