面部識別系統存在問題的原因有很多,其中最重要的一點是它們往往對某些人口群體和性別表現出偏見。近日,麻省理工學院研究人員還進行了一項新研究,即研究AI對某些面部表情的偏見。研究人員稱,表情對面部識別系統的影響“至少”與戴圍巾、帽子、假發或眼鏡有影響一樣,而且面部識別系統在這方面是用高度偏差的數據集訓練的。

這項研究增加了越來越多的證據表明面部識別容易受到有害的、普遍存在的偏見的影響。研究人員去年秋天發表的一篇論文顯示,亞馬遜、微軟等公司的人工智能對順性別男性和女性的準確率都在95%以上,但有38%的情況下,將跨性別男性誤認為女性。“性別色彩項目”和美國國家標準與技術研究所(NIST)對主要供應商系統的獨立基準測試表明,面部識別技術表現出種族和性別偏見,同時表明目前的面部識別程序可能非常不準確,有時錯誤分類率高達96%。

在他們的研究過程中,合作作者使用三種不同的領先的人臉識別模型進行了實驗,這些模型在包括VGGFace2(一個包含超過9100人的300萬張圖片的數據庫)和MS1M-ArcFace(擁有超過85000人的580萬張圖片)的開源數據庫上進行了訓練。他們將它們與四種語料庫進行對比,具體規模如下:

● 這種復雜的面部表情包含了230個人在實驗室控制的環境下拍攝的照片。

● 擴展的Cohn-Kanade(CK+),一個最廣泛使用的用于訓練和評估面部表情識別系統的數據庫,包含123個人的593張照片序列

● CelebA是一個大規模的人臉屬性數據集,包含10000位名人的20萬張圖片。

● 微軟于2016年發布的一項面向公眾的人臉識別基準和數據集MS-Celeb-1M,該數據集包含了100萬名名人的近1000萬張圖片。

正如研究人員指出的那樣,長期以來,學術界和企業一直從網絡、電影和社交媒體等來源上搜集面部照片,以解決模型訓練數據稀缺的問題。像大多數機器學習模型一樣,面部識別模型需要大量的數據才能達到基本的精確度水平。但事實證明,這些數據來源通常是不平衡的,因為一些面部表情比其他表情更不常見。例如,人們傾向于在社交網絡上分享更多快樂的臉,而不是悲傷的臉。

為了通過表情對四種基準語料庫中的圖像進行分類,研究人員使用了來自Affectiva的軟件,該軟件可以識別多達7種面部表情:6種基本情緒和中性表情。他們發現,在所有數據集中,“中性”圖像的比例超過了60%,在微軟MS-Celeb-1M名人圖片庫中達到83.7%。第二常見的面部表情是“快樂”,在所有的數據集中,大約90%的圖像顯示的是一個“中立”或“快樂”的人。至于其他5種面部表情,“驚訝”和“厭惡”的比例很少超過6%,而“悲傷”、“恐懼”和“憤怒”的比例非常低(通常低于1%)。結果也因性別而異。在VGGFace2中,“快樂”女性的數量幾乎是“快樂”男性數量的兩倍。

研究人員在一篇描述他們工作的論文中寫道:“一方面,模型是使用高偏差的數據進行訓練的,這些數據會導致異構性能。另一方面,人們只會對主流表情進行評估,隱藏了其對某些特定面部表情圖像的真實表現。此外,性別偏見也很重要,因為它可能會導致男女雙方的表現不同。”

接下來,研究人員進行了一項分析,以確定像CelebA這樣的示例集中的面部表情偏差對面部識別系統預測的影響程度。在上述三種算法中,在顯示“中性”或“高興”表情的人臉上,性能更好,這也是訓練數據庫中最常見的表情。這項研究的結果表明,面部表情的差異并不能誘使系統誤認為一個人是另一個人。然而,他們也暗示,面部表情偏差會導致系統的“真實”比較分數(衡量算法區分同一張臉圖像的能力的分數)之間的差異高達40%。

研究人員只使用了某個軟件來對情緒進行分類,這可能會在他們的實驗中引入無意識的偏見,而且他們沒有測試任何商業部署的系統,比如亞馬遜的Rekognition、谷歌Cloud的Vision API或微軟Azure的Face API。盡管如此,他們主張在未來的人臉識別數據庫中減少面部表情偏差,并進一步開發適用于現有數據庫和已經在問題數據集上訓練過的模型的偏差減少方法。

研究人員表示:用于開發和評估人臉識別系統的人臉數據庫缺乏面部表情的多樣性,這一缺點之一是會導致系統存在安全漏洞,面部表情的微小變化很容易誤導圍繞這些有偏見的數據庫開發的人臉識別系統。面部表情對人臉識別系統計算出的匹配分數有影響。這種影響可能會被利用為一個可能的漏洞,從而降低匹配的概率。

責任編輯:YYX

-

人臉識別

+關注

關注

76文章

4015瀏覽量

82314 -

面部識別

+關注

關注

1文章

375瀏覽量

26710

發布評論請先 登錄

相關推薦

云數據庫是哪種數據庫類型?

數據庫數據恢復—通過拼接數據庫碎片恢復SQLserver數據庫

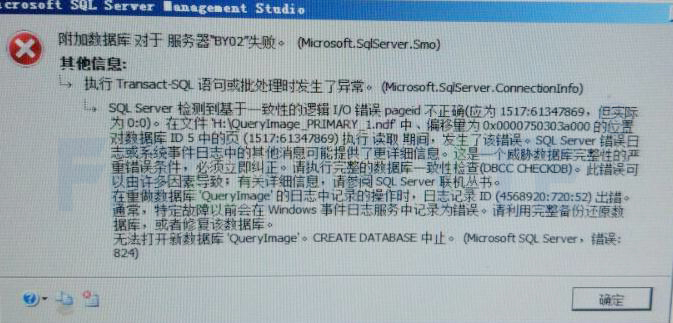

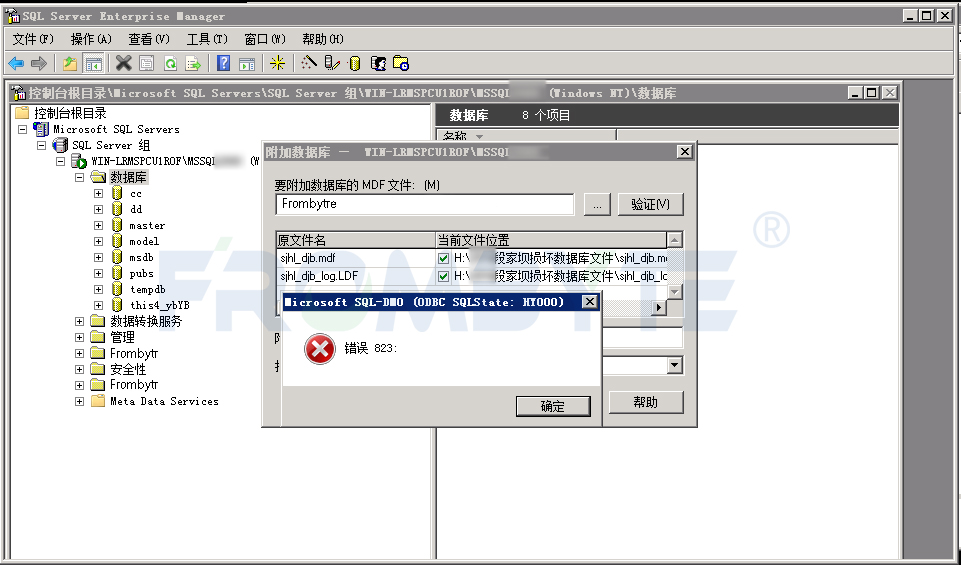

數據庫數據恢復—SQL Server數據庫出現823錯誤的數據恢復案例

隧道人臉識別門禁系統應用于隧道工程等場所的智能化安全管理系統

自研創新 數智未來 2024中國數據庫技術大會盛大召開

基于FPGA的人臉識別技術

基于OpenCV的人臉識別系統設計

數據庫數據恢復—SQL Server數據庫所在分區空間不足報錯的數據恢復案例

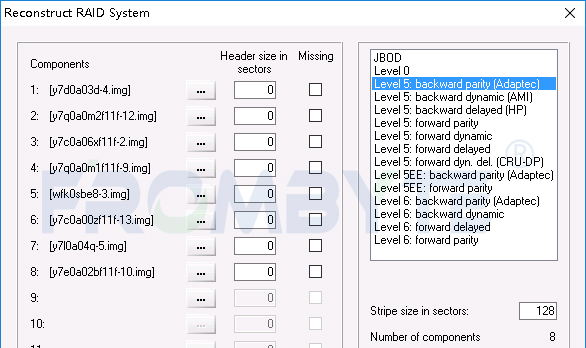

數據庫數據恢復—raid5陣列上層Sql Server數據庫數據恢復案例

未來的人臉識別數據庫中應減少面部表情偏差

未來的人臉識別數據庫中應減少面部表情偏差

評論