在卷積神經網絡中,感受野是一個非常重要的概念,今天,我們具體來看一下感受野的相關概念以及如何計算感受野。

感受野

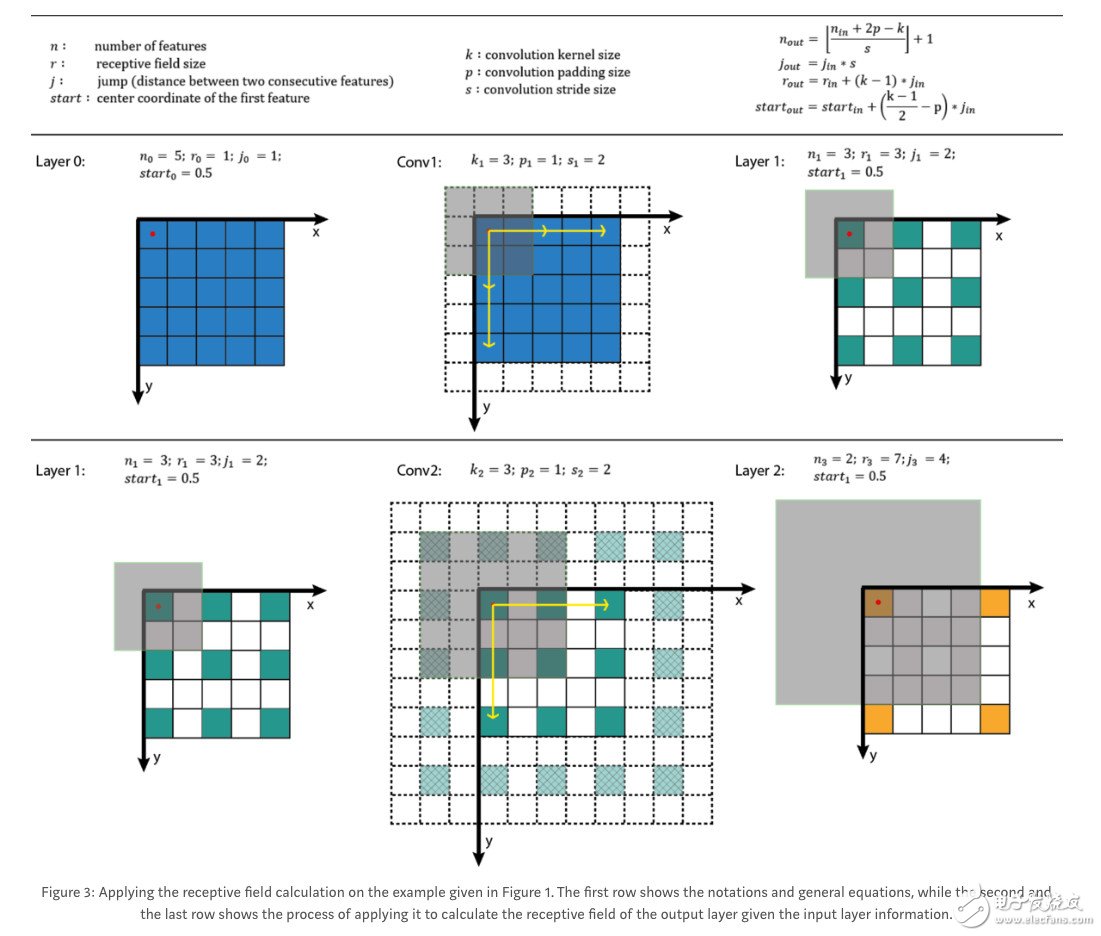

讓我們快速回顧一下如何計算感受野的大小。

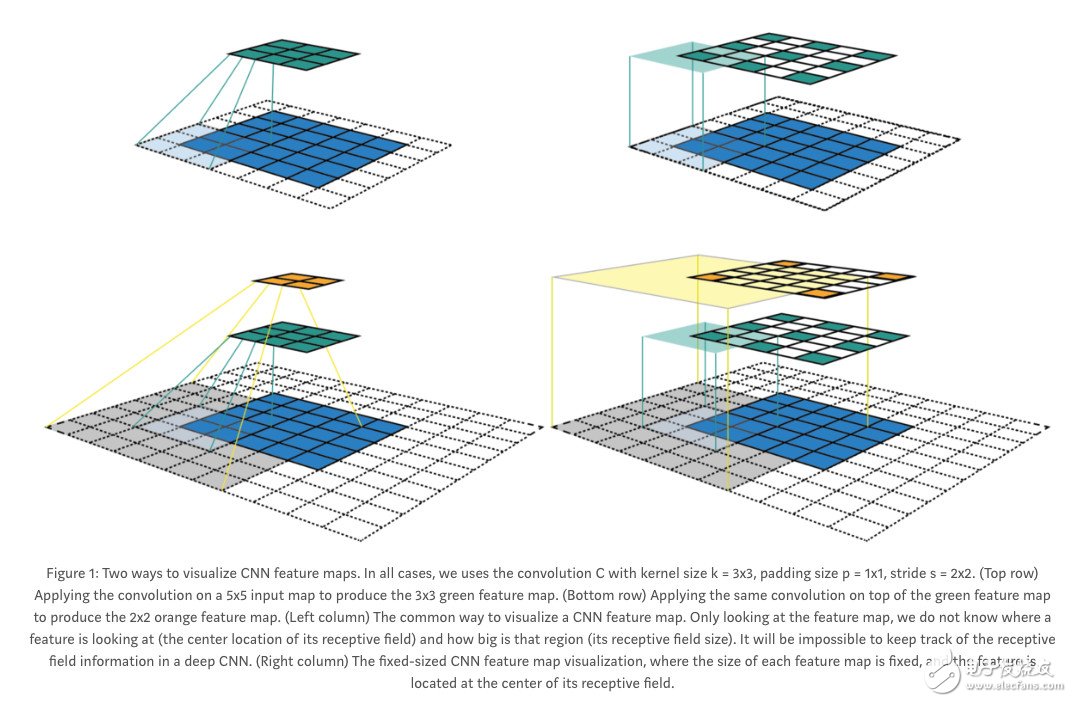

為了更好地理解感受野,我們可能希望以不同的方式可視化卷積步驟。

在右邊,我們查看輸出神經元,也就是新的feature map,而不改變當前feature map的分辨率。我們也可以用下面的方法計算每一層新的感受野。

在現(xiàn)實生活中,我們打算用一個程序來實現(xiàn)這一點。

注:據(jù)我所知,雙線性上采樣和大多數(shù)其他上采樣方法不會增加感受野。但是,如果我的邏輯是對的,轉置卷積應該會增加感受野。很容易想象,放置在一個轉置卷積之后的平均神經元通過多個途徑接收輸入。

有效感受野

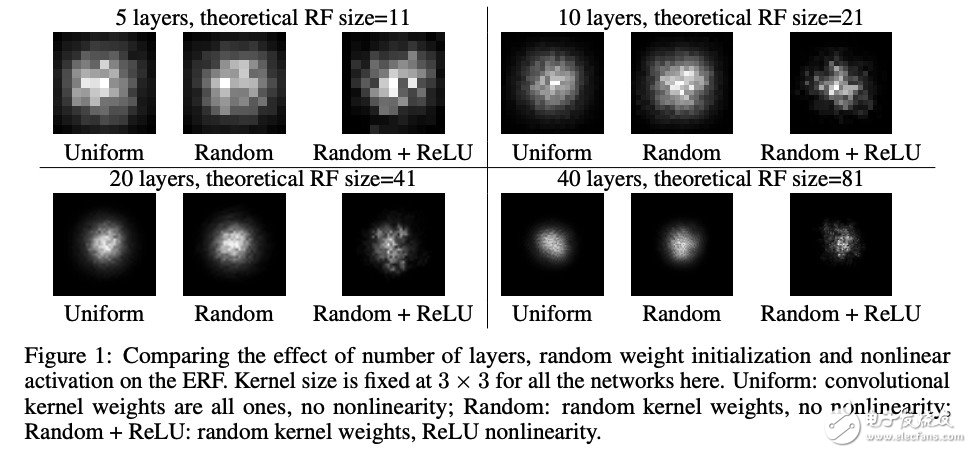

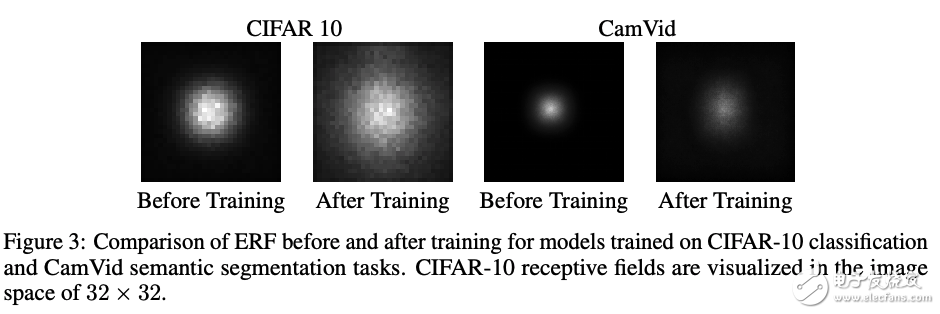

在這篇論文中:Understanding the Effective Receptive Field in Deep Convolutional Neural Networks,作者嘗試從輸出映射的中心像素向網絡反向傳播一個梯度,并將所有其他梯度設置為零。然后,我們檢查應用于輸入層的梯度。

實驗表明,梯度的性質是高斯的,中心像素受影響較大,離中心越遠梯度信號越弱。梯度信號的衰減是指數(shù)級的,這意味著應用于感受野的大多數(shù)像素的梯度將是可忽略的(如果有的話)。因此,這使得作者創(chuàng)造了“有效感受野”這個術語,因為實際的感受野只占理論感受野的一小部分。這是有意義的,因為更多的中央神經元將有更多的路徑來傳播信息,從而將從最后一層的中心像素的梯度傳播回所有可能的路徑,導致了梯度有更大的幅度。

那么,還有什么影響有效感受野呢?

Relu—添加任何激活都會改變ERF的分布,因為梯度的大小現(xiàn)在也依賴于輸入。實際上,只有Relu似乎創(chuàng)建了一個較少的高斯分布,因為Relu將導致我們的梯度的很大一部分為零。

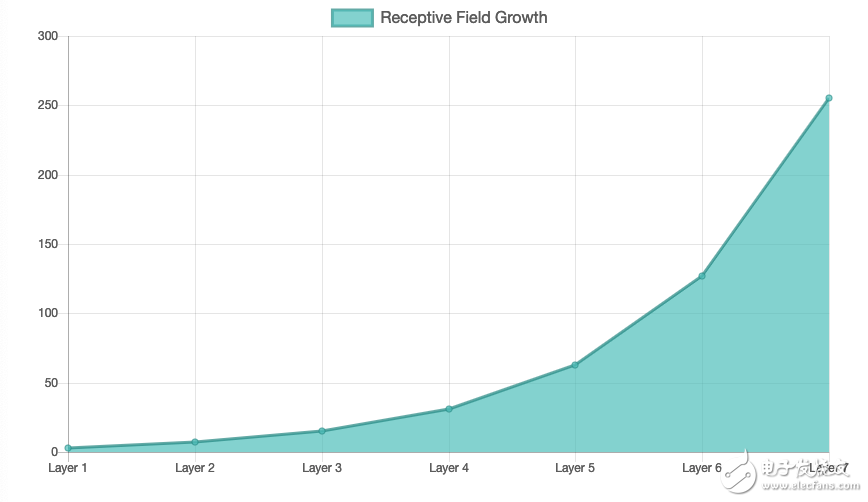

添加層—正如所期望的那樣,添加層使ERF成倍增長。然而,相對于我們的理論感受野,我們的ERF正在縮小。我們的有效感受野在理論感受野中所占的比例越來越小。注意,隨著層數(shù)的增加,ERF / RF比值的收縮速度也會變小。此外,作者指出,stride卷積和dilated卷積都顯示出可以擴展ERF,雖然他們沒有提到相對于理論RF的影響。

訓練—在訓練過程中,ERF擴展到RF的更大部分,這是有意義的,因為網絡學會適應把越來越大的權重放在我們感受野的更多外部像素上。在CamVid中,ERF從100增加到150直徑,而理論RF為505 x 505。

最后,讓我們看一下fast-rcnn的RPN。

我們最大的anchor應該是64*8 = 512,使用一個程序我們可以很容易地找到我們的RF是1335,這是一半以上。從之前的實驗中我可以推測出ERF大約是RF的1/3。好,在RPN中負責計算512×512錨點作為對象或前景的概率的單元格只有大約445×445個輸入數(shù)據(jù)的窗口,小于錨框。對于負責調整我們的建議邊界框的回歸部分也可以進行類似的計算。在這一點上,令人驚訝的是,我們的RPN竟然這么好!

-

神經網絡

+關注

關注

42文章

4781瀏覽量

101176

發(fā)布評論請先 登錄

相關推薦

卷積神經網絡如何使用

卷積神經網絡模型發(fā)展及應用

卷積神經網絡(CNN)基礎詳細說明及其注意事項

【科普】卷積神經網絡(CNN)基礎介紹

卷積神經網絡的感受野計算

卷積神經網絡的感受野計算

評論