神經模態芯片的發展方向首先是規模化,即擴大神經元的規模,這也是Intel和IBM等大廠主要押注的方向。

如果我們回顧深度學習的發展歷程,我們會發現其實神經網絡的原理早在上世紀60年代就已初見雛形,但是由于訓練數據量不夠以及算力不夠,因此直到2012年才被人們重新發現,并且發現了眾多之前完全沒有想到的應用場景和市場。對于神經模態計算,大廠押注的也是類似的情況:神經模態計算的原理看起來是正確的(尤其是今天深度學習已經獲得了很大的成功,那么基于相似原理的神經模態計算應該不會很不靠譜),目前或許只要把神經元的數量和神經突觸連接數量跨過一個閾值(就像當年AlexNet跨過網絡深度的門檻一樣),那么神經模態計算就有可能爆發出巨大的能量,甚至遠超之前的想象。這次Intel發布的超過八百萬神經元的Pohoiki Beach系統顯然就是在往規模化的方向大力發展。

根據Intel的官方消息,下一步將繼續發布神經元數量更大的Pohoiki Spring計劃,可見Intel是在往大規模神經模態計算的方向大力推進。

除了發展規模化之外,另一個方向就是利用神經模態計算低功耗和低延遲的特點并進一步優化芯片設計來開發出高能效比低延遲的芯片。這類芯片或許神經元數量不多,但是可以實現非常低的功耗和非常好的能效比,從而可以部署在傳統深度學習無法部署的場景。事實上,目前如何高效訓練大規模神經模態神經元的算法還沒有找到,因此在現有訓練框架的基礎下,或許優先把能效比做到極致是比把神經元數量做大更接地氣的方向。

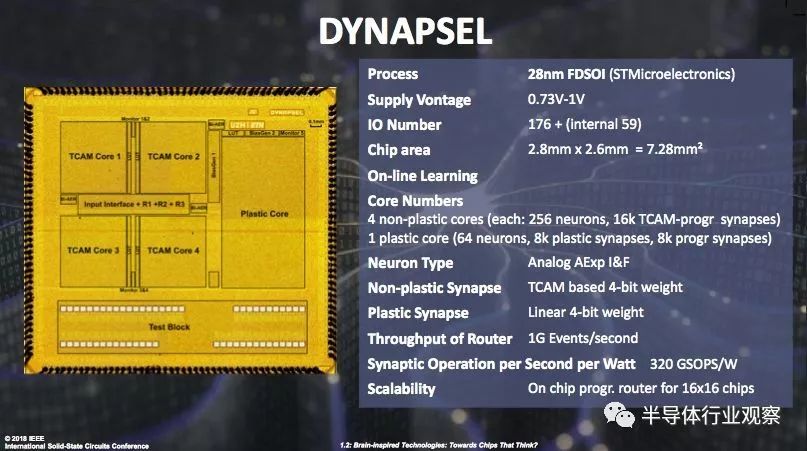

瑞士蘇黎世理工大學的Giacomo Indiveri教授就是這個方向的代表性人物,研究組在十數年內已經發表了多篇電路和系統論文,其研發的芯片作為歐洲神經模態計算研究的代表性工作在2018年ISSCC主題演講中被重點介紹。

-

IBM

+關注

關注

3文章

1766瀏覽量

74861 -

intel

+關注

關注

19文章

3483瀏覽量

186439

原文標題:市面精品 | 全套英語學習資源泄露,手慢則無!(禁止外傳)

文章出處:【微信號:AI_shequ,微信公眾號:人工智能愛好者社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

MLOps平臺的發展方向

模態分解合集matlab代碼

結合芯片行業現狀,數字芯片設計什么方向最值得投身?

神經模態芯片發展的方向

神經模態芯片發展的方向

評論