本篇簡單介紹了如何使用SQLite的C語言API中最基礎(chǔ)的幾個(gè)函數(shù),實(shí)現(xiàn)對數(shù)據(jù)庫的讀寫,后續(xù)再介紹其它常用的C語言API函數(shù)的用法。

2022-09-25 08:52:32 1126

1126

將模型稱為 “視覺語言” 模型是什么意思?一個(gè)結(jié)合了視覺和語言模態(tài)的模型?但這到底是什么意思呢?

2023-03-03 09:49:37 664

664

大型語言模型的出現(xiàn)極大地推動(dòng)了自然語言處理領(lǐng)域的進(jìn)步,但同時(shí)也存在一些局限性,比如模型可能會(huì)產(chǎn)生看似合理但實(shí)際上是錯(cuò)誤或虛假的內(nèi)容,這一現(xiàn)象被稱為幻覺(hallucination)。幻覺的存在使得

2023-08-15 09:33:45 1090

1090

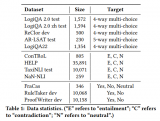

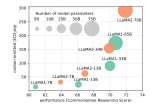

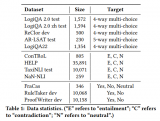

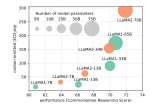

最新研究揭示,盡管大語言模型LLMs在語言理解上表現(xiàn)出色,但在邏輯推理方面仍有待提高。為此,研究者們推出了GLoRE,一個(gè)全新的邏輯推理評(píng)估基準(zhǔn),包含12個(gè)數(shù)據(jù)集,覆蓋三大任務(wù)類型。

2023-11-23 15:05:16 472

472

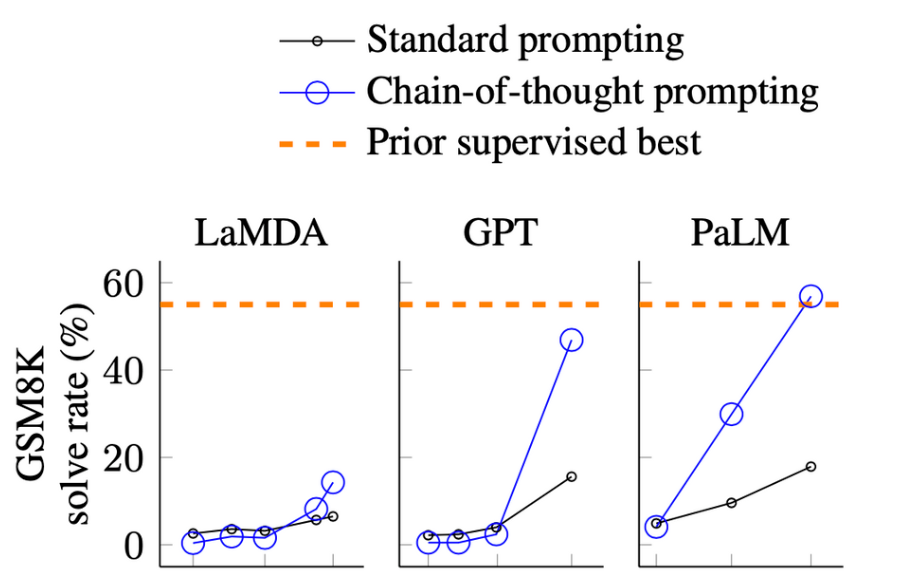

在大型語言模型(LLMs)的應(yīng)用中,提示工程(Prompt Engineering)是一種關(guān)鍵技術(shù),用于引導(dǎo)模型生成特定輸出或執(zhí)行特定任務(wù)。通過精心設(shè)計(jì)的提示,可以顯著提高LLMs的性能和適用性。本文將介紹提示工程的主要方法和技巧,包括少樣本提示、提示壓縮和提示生成。

2023-12-13 14:21:47 273

273

NVIDIA NeMo 大型語言模型(LLM)服務(wù)幫助開發(fā)者定制大規(guī)模語言模型;NVIDIA BioNeMo 服務(wù)幫助研究人員生成和預(yù)測分子、蛋白質(zhì)及 DNA ? 美國加利福尼亞州圣克拉拉

2022-09-21 15:24:52 433

433

電子發(fā)燒友網(wǎng)報(bào)道(文/李彎彎)大語言模型(LLM)是基于海量文本數(shù)據(jù)訓(xùn)練的深度學(xué)習(xí)模型。它不僅能夠生成自然語言文本,還能夠深入理解文本含義,處理各種自然語言任務(wù),如文本摘要、問答、翻譯

2024-01-02 09:28:33 1267

1267 ,最終為降低頂事件發(fā)生概率提供有效的改進(jìn)途徑。研究案例采用該定量模型,以文件破壞重大風(fēng)險(xiǎn)作為故障樹頂事件,得出其概率和底事件概率重要度,找出了引起安全問題的存儲(chǔ)風(fēng)險(xiǎn),從而有效地保證軟件開發(fā)過程

2010-04-24 09:54:02

的問題,而對于不同地址的訪問并不是緩存一致性協(xié)議所要考慮的問題。存儲(chǔ)一致性問題在任何具有或不具有高速緩存的系統(tǒng)中都存在,雖然高速緩存的存在有可能進(jìn)一步加劇存儲(chǔ)一致性問題。存儲(chǔ)器模型(memory model

2022-04-11 15:42:37

關(guān)于數(shù)據(jù)庫,只要知道簡單的SQL語言,就可以輕松的進(jìn)行操作。有些復(fù)雜的測試數(shù)據(jù),非常適合用數(shù)據(jù)庫存儲(chǔ)。附件是我編寫的吉時(shí)利2400測***曲線的例子,標(biāo)準(zhǔn)件的波形圖保存在了數(shù)據(jù)庫中。通過此例程,可以掌握簡單的數(shù)據(jù)庫操作。

2018-12-10 21:23:10

傳輸數(shù)據(jù)。與逐字節(jié)數(shù)據(jù)傳輸模型不同,讀/寫數(shù)據(jù)模型可以處理數(shù)據(jù)塊;c)使用緩沖隊(duì)列傳輸模型——允許客戶端對數(shù)據(jù)傳輸進(jìn)行隊(duì)列處理。考慮到前面提到的每個(gè)模型的最佳應(yīng)用是什么?在第一種方法中,我嘗試使用第一個(gè)

2020-04-23 13:56:48

請問一下,我在做tdms數(shù)據(jù)存儲(chǔ)練習(xí)的時(shí)候,搭建的模型如下,只有一個(gè)組(嘗試),組里面有兩個(gè)通道,模型如下,但最終用excel表格打開數(shù)據(jù)文件,卻只有一個(gè)通道(第一組),請問這是怎么回事呢?我搭的模型有問題嗎?

2015-01-21 20:18:23

如圖,daq助手運(yùn)行沒問題,單獨(dú)接一個(gè)波形圖的時(shí)候圖像和助手設(shè)置里面的一樣。但是接到存儲(chǔ)數(shù)據(jù)(右下角那堆)那部分的時(shí)候就發(fā)現(xiàn)有問題了,只能存100個(gè)數(shù)據(jù),而且連續(xù)運(yùn)行會(huì)出現(xiàn)錯(cuò)誤數(shù)據(jù),也是一百個(gè)這樣

2015-02-14 17:35:05

多種形式和任務(wù)。這個(gè)階段是從語言模型向?qū)υ?b class="flag-6" style="color: red">模型轉(zhuǎn)變的關(guān)鍵,其核心難點(diǎn)在于如何構(gòu)建訓(xùn)練數(shù)據(jù),包括訓(xùn)練數(shù)據(jù)內(nèi)部多個(gè)任務(wù)之間的關(guān)系、訓(xùn)練數(shù)據(jù)與預(yù)訓(xùn)練之間的關(guān)系及訓(xùn)練數(shù)據(jù)的規(guī)模。

獎(jiǎng)勵(lì)建模階段的目標(biāo)是構(gòu)建一個(gè)文本

2024-03-11 15:16:39

一個(gè)串口數(shù)據(jù)處理的VI程序,(串口通訊的數(shù)據(jù)可見20131112.dat文件), 實(shí)現(xiàn)對數(shù)據(jù)文件中的讀取、驗(yàn)證、分析處理、顯示(數(shù)據(jù)需取絕對值---去除最高位的符號(hào)位即可,以十進(jìn)制數(shù)的形式和曲線形式顯示)、存儲(chǔ)等。利用LabVIEW的強(qiáng)大信號(hào)分析處理功能,開發(fā)一套操作簡便的數(shù)據(jù)信息分析系統(tǒng)。

2013-11-29 12:01:13

。 3.大型應(yīng)用監(jiān)控系統(tǒng) 一般來說,大型監(jiān)控系統(tǒng)都能達(dá)到一千點(diǎn)以上,最典型的案例就是平安城市。這類應(yīng)用的最大特點(diǎn)就是系統(tǒng)龐大、復(fù)雜、數(shù)據(jù)量大,大部分都會(huì)采用分級(jí)存儲(chǔ)、中心集中備份的策略,對數(shù)據(jù)的存儲(chǔ)

2012-12-12 15:46:47

目錄:一、五大內(nèi)存分區(qū)二、C語言程序的存儲(chǔ)區(qū)域三、C語言程序的段四、在C語言的程序中,對變量的使用還有以下注意五、程序中段的使用六、const的使用七、單片機(jī)C語言中的data、idata

2021-11-30 06:48:47

自然語言處理——53 語言模型(數(shù)據(jù)平滑)

2020-04-16 11:11:25

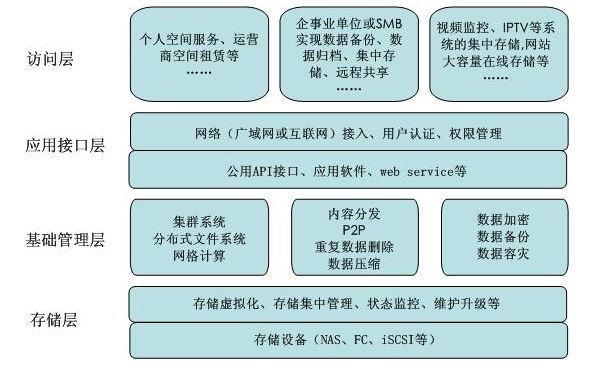

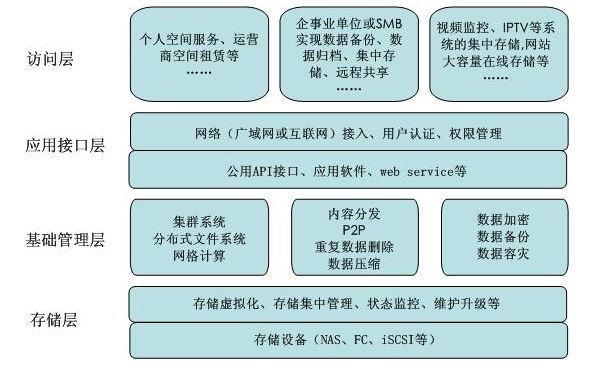

針對用戶對遠(yuǎn)程數(shù)據(jù)存儲(chǔ)與異地數(shù)據(jù)備份的需求增加,提出一種基于IPv6協(xié)議的Internet存儲(chǔ)服務(wù)模型。設(shè)計(jì)應(yīng)用層的Internet存儲(chǔ)訪問協(xié)議,結(jié)合IPv6協(xié)議的安全性特點(diǎn)設(shè)計(jì)安全存儲(chǔ)模型

2009-04-13 09:13:40 15

15 可以計(jì)算以2,10,e為底的對數(shù)

# 進(jìn)行對數(shù)運(yùn)算的IP核,可以計(jì)算以2,10,e為底的對數(shù),最高可輸入24bit寬度的數(shù)據(jù)。# 由AHDL語言寫成,可在MaxplusII和QuartusII中使用,源代

2009-06-14 09:27:34 53

53 提出了一個(gè)適用于入侵檢測系統(tǒng)的通用數(shù)據(jù)模型,并分析了該模型的存儲(chǔ)結(jié)構(gòu)及其在入侵檢測領(lǐng)域中的應(yīng)用。該模型用基特征和類特征的自然連接表示一類事件,采用二元存儲(chǔ)結(jié)

2009-06-29 08:20:43 13

13 結(jié)合對象存儲(chǔ)的特點(diǎn),提出基于QoS 的存儲(chǔ)系統(tǒng)模型。該模型將遷移任務(wù)劃分為細(xì)粒度的遷移請求,使對象存儲(chǔ)設(shè)備在實(shí)現(xiàn)數(shù)據(jù)遷移的同時(shí)能響應(yīng)I/O 請求。元數(shù)據(jù)服務(wù)器按相同的

2009-10-07 11:56:59 9

9 C語言之自然對數(shù)的底e的計(jì)算,很好的C語言資料,快來學(xué)習(xí)吧。

2016-04-22 17:45:55 0

0 C語言教程之自然對數(shù)的底e的計(jì)算,很好的C語言資料,快來學(xué)習(xí)吧。

2016-04-22 17:45:55 0

0 C語言教程之對數(shù)組進(jìn)行升序和降序排序,很好的C語言資料,快來學(xué)習(xí)吧。

2016-04-25 16:09:48 0

0 大型網(wǎng)絡(luò)異常數(shù)據(jù)庫的快速數(shù)據(jù)定位模型仿真_朱保鋒

2017-01-03 18:00:37 0

0 數(shù)據(jù)流編程模型將程序的計(jì)算與通信分離,暴露了應(yīng)用程序潛在的并行性并簡化了編程難度。分布式計(jì)算框架利用廉價(jià)PC構(gòu)建多核集群解決了大規(guī)模并行計(jì)算問題,但多核集群層次性存儲(chǔ)結(jié)構(gòu)和處理單元對數(shù)據(jù)流程序的性能

2017-11-23 15:48:59 3

3 為了實(shí)現(xiàn)在線海量數(shù)據(jù)的高效存儲(chǔ)與訪問,在內(nèi)存云分級(jí)存儲(chǔ)架構(gòu)下,提出一種基于數(shù)據(jù)重要性的遷移模型( MMDS)。首先,通過數(shù)據(jù)本身的大小、時(shí)間重要性、用戶訪問總量等因素對數(shù)據(jù)本身的重要性進(jìn)行計(jì)算;其次

2017-12-27 16:54:33 1

1 自然語言處理常用模型使用方法一、N元模型二、馬爾可夫模型以及隱馬爾可夫模型及目前常用的自然語言處理開源項(xiàng)目/開發(fā)包有哪些?

2017-12-28 15:42:30 5382

5382

如今有許多企業(yè)存儲(chǔ)討論的重點(diǎn)是將數(shù)據(jù)轉(zhuǎn)移到公共云上進(jìn)行歸檔,因?yàn)檫M(jìn)入的成本并不高,尤其是在需要即時(shí)容量的情況下。但是,一旦企業(yè)采用公共云,可能會(huì)出現(xiàn)這樣的情況,需要將數(shù)據(jù)遷移回本地部署的數(shù)據(jù)中心,以實(shí)現(xiàn)逆向云存儲(chǔ)戰(zhàn)略。

2018-06-14 09:01:29 3012

3012 數(shù)據(jù)先要通過存儲(chǔ)層存儲(chǔ)下來,然后根據(jù)數(shù)據(jù)需求和目標(biāo)來建立相應(yīng)的數(shù)據(jù)模型和數(shù)據(jù)分析指標(biāo)體系對數(shù)據(jù)進(jìn)行分析產(chǎn)生價(jià)值。

2020-03-27 10:06:10 1017

1017 伴隨著傳統(tǒng)企業(yè)數(shù)字化、智能化的腳步,數(shù)據(jù)中心的技術(shù)也同樣在不斷更新,無論是計(jì)算能力、存儲(chǔ)能力還是信息交互能力都在向前演進(jìn),大型數(shù)據(jù)中心憑借其強(qiáng)大運(yùn)算能力、存儲(chǔ)能力備受廣大企業(yè)的歡迎。 不過,大型

2020-12-22 10:37:59 2199

2199 在存儲(chǔ)的快速發(fā)展過程中,不同的廠商對云存儲(chǔ)提供了不同的結(jié)構(gòu)模型,在這里,我們介紹一個(gè)比較有代表性的云存儲(chǔ)結(jié)構(gòu)模型。

2020-12-25 11:23:26 3537

3537

12月29日,華為針對數(shù)據(jù)存儲(chǔ)兩大業(yè)界難題,發(fā)布了2021年奧林帕斯懸紅,獎(jiǎng)勵(lì)全球在數(shù)據(jù)存儲(chǔ)領(lǐng)域取得突破性貢獻(xiàn)的科研工作者。 在12月29日舉辦的2020全球數(shù)據(jù)存儲(chǔ)教授論壇上,華為針對數(shù)據(jù)存儲(chǔ)兩大

2020-12-30 13:39:09 2052

2052 Python官方文檔說法是“Python數(shù)據(jù)模型”,大多數(shù)Python書籍作者說法是“Python對象模型”,它們是一個(gè)意思,表示“計(jì)算機(jī)編程語言中對象的屬性”。這句話有點(diǎn)抽象,只要知道對象是Python對數(shù)據(jù)的抽象,在Python中萬物皆對象就可以了。

2021-02-10 15:59:00 2278

2278

深度學(xué)習(xí)模型應(yīng)用于自然語言處理任務(wù)時(shí)依賴大型、高質(zhì)量的人工標(biāo)注數(shù)據(jù)集。為降低深度學(xué)習(xí)模型對大型數(shù)據(jù)集的依賴,提出一種基于BERT的中文科技自然語言處理預(yù)訓(xùn)練模型 ALICE。通過對遮罩語言模型進(jìn)行

2021-05-07 10:08:16 14

14 云存儲(chǔ)中的數(shù)據(jù)可能會(huì)遭受非法竊取或篡改,從而使用戶數(shù)據(jù)的機(jī)密性面臨威脅。為了更加安全、高效地存儲(chǔ)海量數(shù)據(jù),提出一種攴持索引、可追溯、可驗(yàn)證的云存儲(chǔ)與區(qū)塊鏈結(jié)合的存儲(chǔ)模型CBaS( Cloud

2021-05-10 16:07:35 7

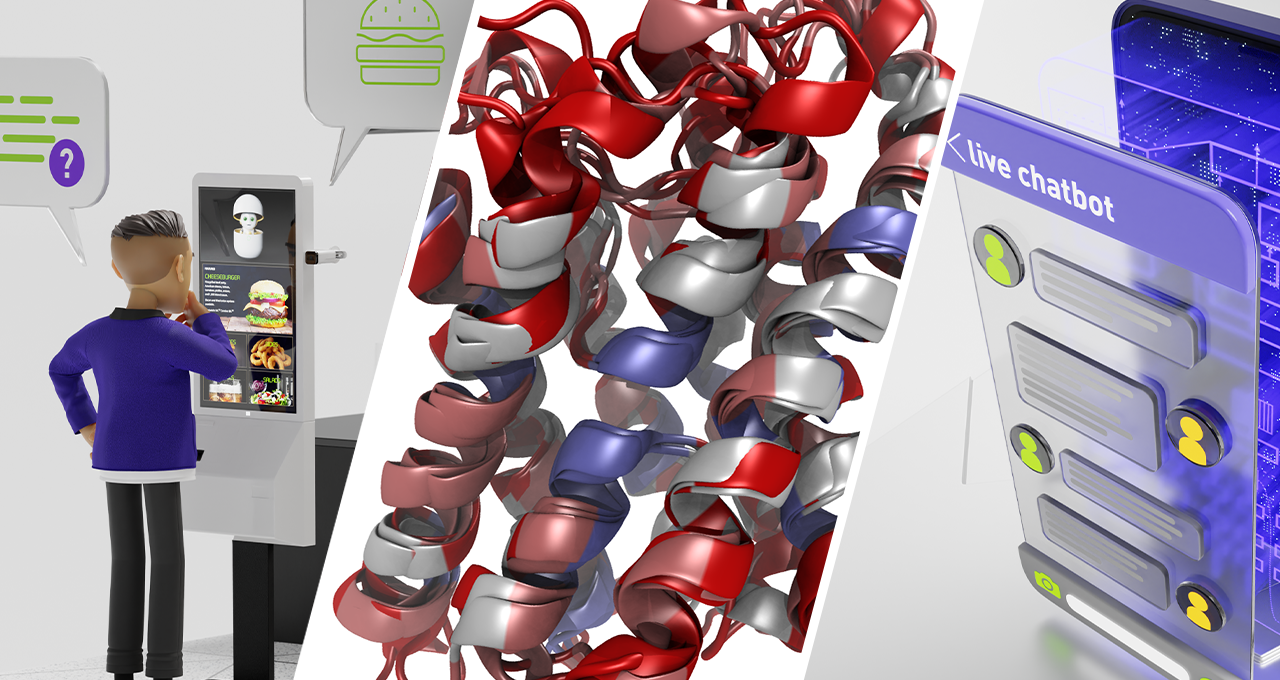

7 NVIDIA為全球企業(yè)開發(fā)和部署大型語言模型打開了一扇新的大門——使這些企業(yè)能夠建立他們自己的、特定領(lǐng)域的聊天機(jī)器人、個(gè)人助理和其他AI應(yīng)用程序,并能夠以前所未有的水平理解語言中的微妙和細(xì)微差別

2021-11-12 14:30:07 1327

1327 目錄:一、五大內(nèi)存分區(qū)二、C語言程序的存儲(chǔ)區(qū)域三、C語言程序的段四、在C語言的程序中,對變量的使用還有以下注意五、程序中段的使用六、const的使用七、單片機(jī)C語言中的data、idata

2021-11-20 20:36:09 12

12 Keil中 數(shù)據(jù)的存儲(chǔ)code、data、idata、pdata、xdata、pdata模型選擇SMALL COMPACT LARGE

2021-12-05 11:36:05 5

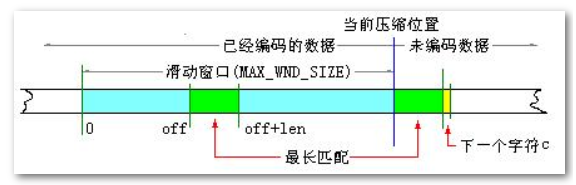

5 浪潮存儲(chǔ)基于“云存智用 運(yùn)籌新數(shù)據(jù)”的理念,不斷技術(shù)創(chuàng)新,將智能壓縮技術(shù)適配到存儲(chǔ)平臺(tái),打造敏捷高效的存儲(chǔ)產(chǎn)品,在保障性能無損的情況下,提升數(shù)據(jù)存儲(chǔ)的效率,提高了存儲(chǔ)空間利用率,降低數(shù)據(jù)存儲(chǔ)成本,讓用戶能輕松應(yīng)對數(shù)字經(jīng)濟(jì)時(shí)代的海量數(shù)據(jù)的挑戰(zhàn)。

2022-04-08 09:27:42 6081

6081

由于亂序語言模型不使用[MASK]標(biāo)記,減輕了預(yù)訓(xùn)練任務(wù)與微調(diào)任務(wù)之間的gap,并由于預(yù)測空間大小為輸入序列長度,使得計(jì)算效率高于掩碼語言模型。PERT模型結(jié)構(gòu)與BERT模型一致,因此在下游預(yù)訓(xùn)練時(shí),不需要修改原始BERT模型的任何代碼與腳本。

2022-05-10 15:01:27 1173

1173 NVIDIA NeMo 大型語言模型(LLM)服務(wù)幫助開發(fā)者定制大規(guī)模語言模型;NVIDIA BioNeMo 服務(wù)幫助研究人員生成和預(yù)測分子、蛋白質(zhì)及 DNA

2022-09-22 10:42:29 742

742 韓國先進(jìn)的移動(dòng)運(yùn)營商構(gòu)建包含數(shù)百億個(gè)參數(shù)的大型語言模型,并使用 NVIDIA DGX SuperPOD 平臺(tái)和 NeMo Megatron 框架訓(xùn)練該模型。

2022-09-27 09:24:30 914

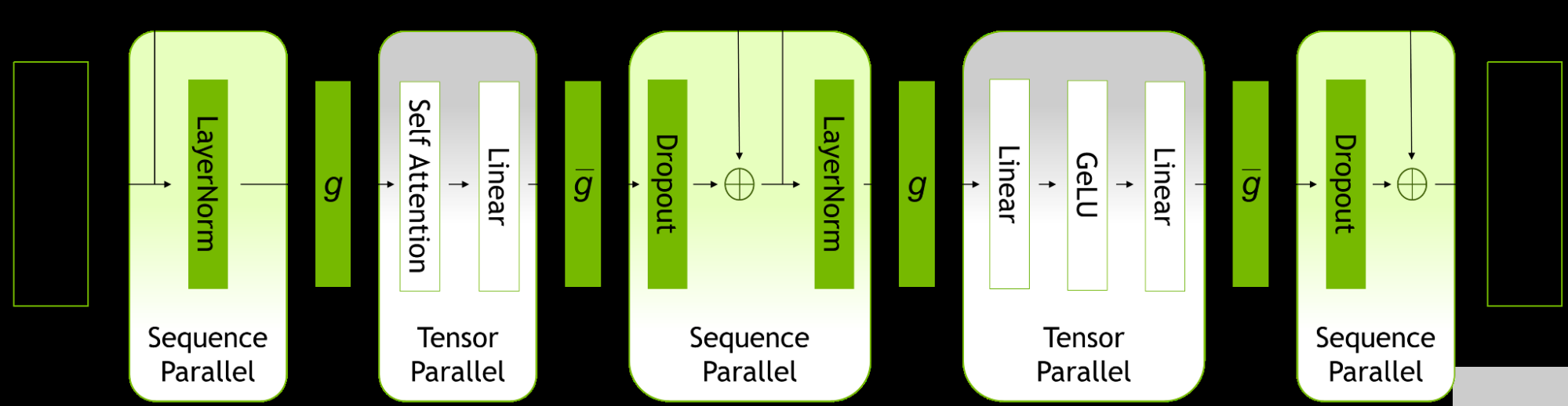

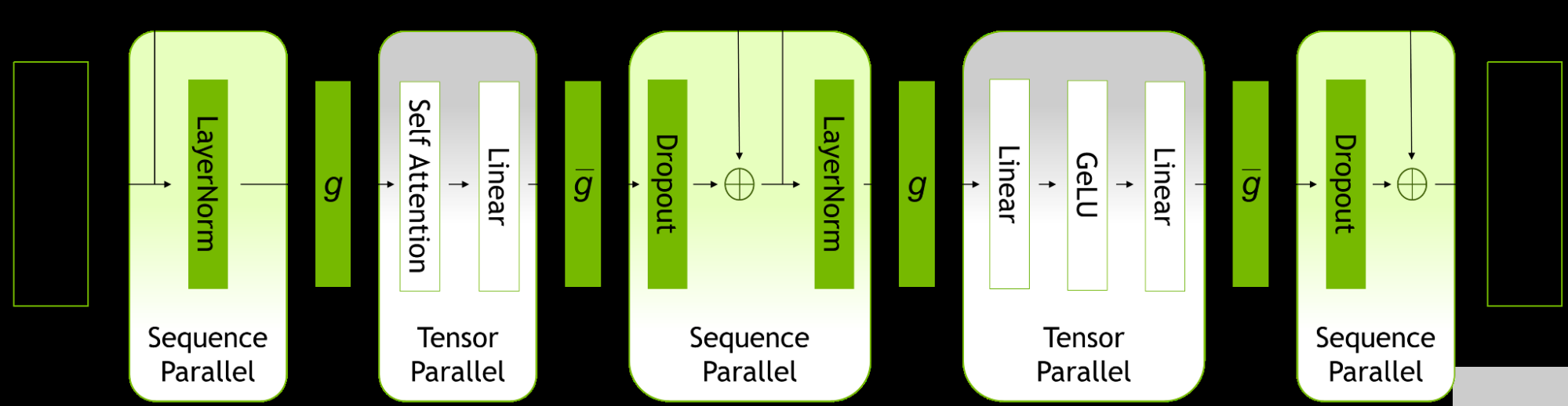

914 隨著大型語言模型( LLM )的規(guī)模和復(fù)雜性不斷增長, NVIDIA 今天宣布更新 NeMo Megatron 框架,提供高達(dá) 30% 的訓(xùn)練速度。

2022-10-10 15:39:42 642

642

的 COVID-19 研究。一位決賽入圍選手教會(huì)了大型語言模型(LLMs)一種新的語言——基因序列,使這些模型能夠提供基因組學(xué)、流行病學(xué)和蛋白質(zhì)工程方面的洞察。 這項(xiàng)開創(chuàng)性的成果發(fā)表于 10 月,是由來自美國阿貢國家實(shí)驗(yàn)室、NVIDIA、芝加哥大學(xué)等組織機(jī)構(gòu)的二

2022-11-16 21:40:02 395

395 。 這一聯(lián)合團(tuán)隊(duì)的研究指出,經(jīng)過基因組學(xué)訓(xùn)練的大型語言模型(LLM)可將應(yīng)用擴(kuò)展到大量基因組學(xué)任務(wù)。 該團(tuán)隊(duì)使用 NVIDIA 的超級(jí)計(jì)算機(jī) Cambridge-1 來訓(xùn)練參數(shù)規(guī)模從 500M 到 2.5B 不等的各種大型語言模型(LLM)。這些模型在各種基因組數(shù)據(jù)集上進(jìn)行了訓(xùn)練,以探

2023-01-17 01:05:04 443

443 BigCode 是一個(gè)開放的科學(xué)合作組織,致力于開發(fā)大型語言模型。近日他們開源了一個(gè)名為 SantaCoder 的語言模型,該模型擁有 11 億個(gè)參數(shù)

2023-01-17 14:29:53 692

692 索引是一個(gè)數(shù)據(jù)庫,用于存儲(chǔ)爬蟲發(fā)現(xiàn)的信息。在索引層中進(jìn)行了大量預(yù)處理,以最大限度地減少必須搜索的數(shù)據(jù)量。這最大限度地減少了延遲并最大限度地提高了搜索相關(guān)性。

2023-02-21 14:28:33 719

719 最近,人們對大型語言模型所展示的強(qiáng)大能力(例如思維鏈 ^[2]^ 、便簽本 ^[3]^ )產(chǎn)生了極大的興趣,并開展了許多工作。我們將之統(tǒng)稱為大模型的突現(xiàn)能力 ^[4]^ ,這些能力可能只存在于大型模型

2023-02-22 11:16:05 674

674

通過大規(guī)模數(shù)據(jù)集訓(xùn)練來學(xué)習(xí)識(shí)別、總結(jié)、翻譯、預(yù)測和生成文本及其他內(nèi)容。 大型語言模型是 Transformer 模型最成功的應(yīng)用之一。它們不僅將人類的語言教給 AI,還可以幫助 AI 理解蛋白質(zhì)、編寫軟件代碼等等。 除了加速翻譯軟件、聊天機(jī)器人

2023-02-23 19:50:04 3876

3876 大型語言模型能識(shí)別、總結(jié)、翻譯、預(yù)測和生成文本及其他內(nèi)容。

2023-03-08 13:57:00 6986

6986 和運(yùn)行自定義大型語言模型和生成式AI模型,這些模型專為企業(yè)所在領(lǐng)域的特定任務(wù)而創(chuàng)建,并且在專有數(shù)據(jù)上訓(xùn)練。 ? Getty Images、Morningstar、Quantiphi、Shutterstock公

2023-03-22 13:45:40 261

261

能夠構(gòu)建、完善和運(yùn)行自定義大型語言模型和生成式 AI 模型,這些模型專為企業(yè)所在領(lǐng)域的特定任務(wù)而創(chuàng)建,并且在專有數(shù)據(jù)上訓(xùn)練。 Getty Images、Morningstar、Quantiphi、Shutterst

2023-03-23 06:50:04 365

365 NVIDIA NeMo 服務(wù)幫助企業(yè)將大型語言模型與其專有數(shù)據(jù)相結(jié)合,賦能智能聊天機(jī)器人、客戶服務(wù)等更多應(yīng)用。 如今的大型語言模型知識(shí)淵博,但它們的工作方式有點(diǎn)像時(shí)間膠囊——所收集的信息僅限于第一次

2023-03-25 09:10:03 274

274 能夠構(gòu)建、完善和運(yùn)行自定義大型語言模型和生成式 AI 模型,這些模型專為企業(yè)所在領(lǐng)域的特定任務(wù)而創(chuàng)建,并且在專有數(shù)據(jù)上訓(xùn)練。 Getty Images、Morningstar、Quantiphi、Shutterst

2023-03-25 15:20:04 285

285 對于任何沒有額外微調(diào)和強(qiáng)化學(xué)習(xí)的預(yù)訓(xùn)練大型語言模型來說,用戶得到的回應(yīng)質(zhì)量可能參差不齊,并且可能包括冒犯性的語言和觀點(diǎn)。這有望隨著規(guī)模、更好的數(shù)據(jù)、社區(qū)反饋和優(yōu)化而得到改善。

2023-04-24 10:07:06 2167

2167

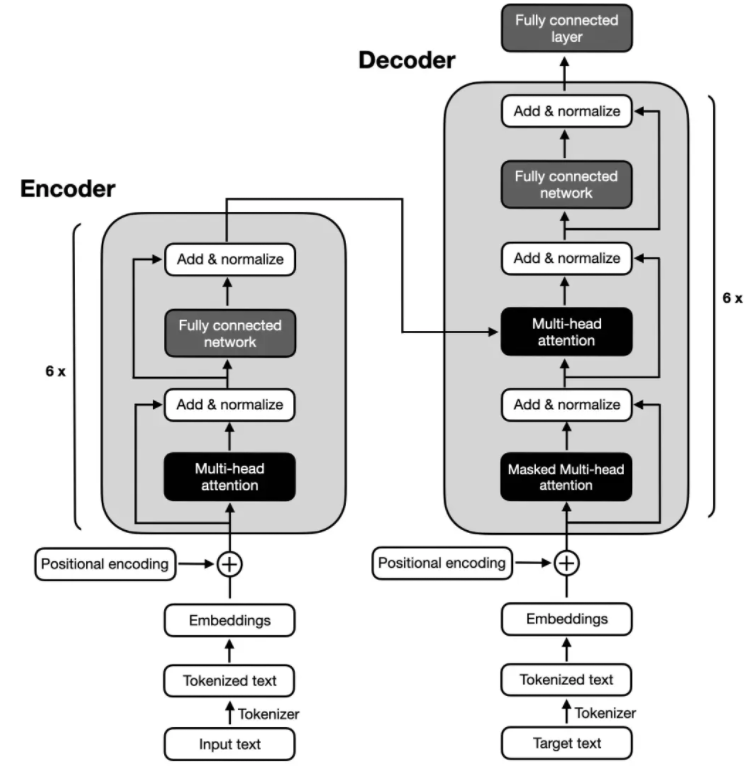

GPT是基于Transformer架構(gòu)的大語言模型,近年迭代演進(jìn)迅速。構(gòu)建語言模型是自然語言處理中最基本和最重要的任務(wù)之一。GPT是基于Transformer架構(gòu)衍生出的生成式預(yù)訓(xùn)練的單向語言模型,通過對大 量語料數(shù)據(jù)進(jìn)行無監(jiān)督學(xué)習(xí)

2023-04-28 10:01:59 584

584

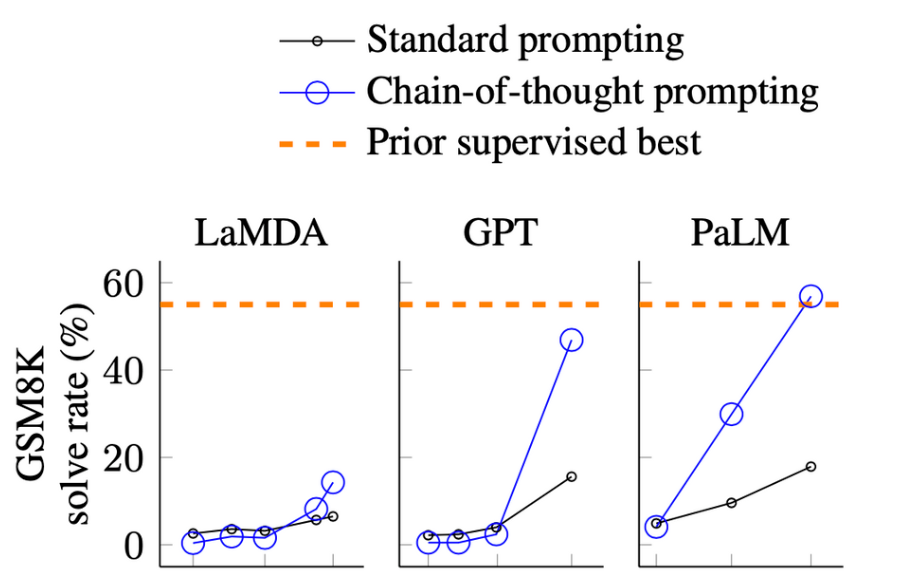

近來NLP領(lǐng)域由于語言模型的發(fā)展取得了顛覆性的進(jìn)展,擴(kuò)大語言模型的規(guī)模帶來了一系列的性能提升,然而單單是擴(kuò)大模型規(guī)模對于一些具有挑戰(zhàn)性的任務(wù)來說是不夠的

2023-05-10 11:13:17 1377

1377

大型語言模型LLM(Large Language Model)具有很強(qiáng)的通用知識(shí)理解以及較強(qiáng)的邏輯推理能力,但其只能處理文本數(shù)據(jù)。

2023-05-10 16:53:15 700

700

? 大型語言模型能否捕捉到它們所處理和生成的文本中的語義信息?這一問題在計(jì)算機(jī)科學(xué)和自然語言處理領(lǐng)域一直存在爭議。然而,MIT的一項(xiàng)新研究表明,僅基于文本形式訓(xùn)練、用于預(yù)測下一個(gè)token的語言模型

2023-05-25 11:34:11 434

434

近日,IBM 存儲(chǔ)推出了基于其閃存產(chǎn)品 IBM FlashSystem 的新能力,幫助企業(yè)高效應(yīng)對數(shù)據(jù)安全威脅。

2023-05-25 16:35:02 829

829 ChatGPT 在 2022 年年底的橫空出世,引發(fā)了各行各業(yè)對生成式人工智能、大型語言模型和基礎(chǔ)模型的廣泛關(guān)注和討論,人工智能發(fā)展的“質(zhì)變時(shí)刻”正在加速到來。作為人工智能應(yīng)用的“三駕馬車

2023-05-25 16:36:22 723

723

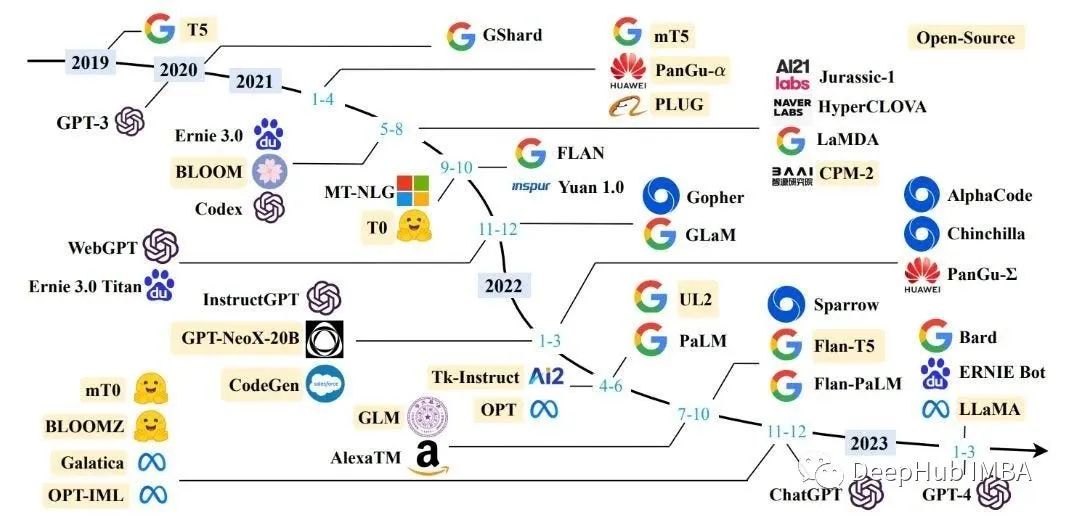

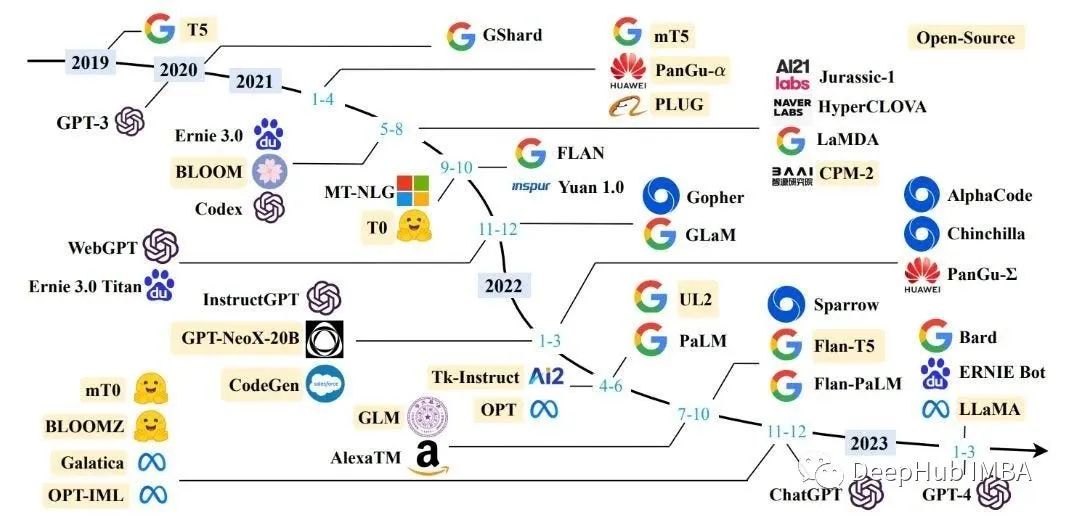

大型語言模型研究的發(fā)展有三條技術(shù)路線:Bert 模式、GPT 模式、混合模式。其中國內(nèi)大多采用混合模式, 多數(shù)主流大型語言模型走的是 GPT 技術(shù)路線,直到 2022 年底在 GPT-3.5 的基礎(chǔ)上產(chǎn)生了 ChatGPT。

2023-06-09 12:34:53 3158

3158

近年來,像 GPT-4 這樣的大型語言模型 (LLM) 因其在自然語言理解和生成方面的驚人能力而受到廣泛關(guān)注。但是,要根據(jù)特定任務(wù)或領(lǐng)域定制LLM,定制培訓(xùn)是必要的。本文提供了有關(guān)自定義訓(xùn)練 LLM 的詳細(xì)分步指南,其中包含代碼示例和示例。

2023-06-12 09:35:43 1781

1781 他預(yù)計(jì),深度學(xué)習(xí)和大型語言模型會(huì)繼續(xù)發(fā)展:這個(gè)領(lǐng)域的未來可能會(huì)有一小部分重大突破,加之許多細(xì)微改進(jìn),所有這些都將融入到一個(gè)龐大而復(fù)雜的工程體系。他還給出了一些有趣、可執(zhí)行的思想實(shí)驗(yàn)。

2023-06-12 16:38:48 262

262 本文旨在更好地理解基于 Transformer 的大型語言模型(LLM)的內(nèi)部機(jī)制,以提高它們的可靠性和可解釋性。 隨著大型語言模型(LLM)在使用和部署方面的不斷增加,打開黑箱并了解它們的內(nèi)部

2023-06-25 15:08:49 987

987

?? 大型語言模型(LLM) 是一種深度學(xué)習(xí)算法,可以通過大規(guī)模數(shù)據(jù)集訓(xùn)練來學(xué)習(xí)識(shí)別、總結(jié)、翻譯、預(yù)測和生成文本及其他內(nèi)容。大語言模型(LLM)代表著 AI 領(lǐng)域的重大進(jìn)步,并有望通過習(xí)得的知識(shí)改變

2023-07-05 10:27:35 1460

1460 簡單來說,語言模型能夠以某種方式生成文本。它的應(yīng)用十分廣泛,例如,可以用語言模型進(jìn)行情感分析、標(biāo)記有害內(nèi)容、回答問題、概述文檔等等。但理論上,語言模型的潛力遠(yuǎn)超以上常見任務(wù)。

2023-07-14 11:45:40 454

454

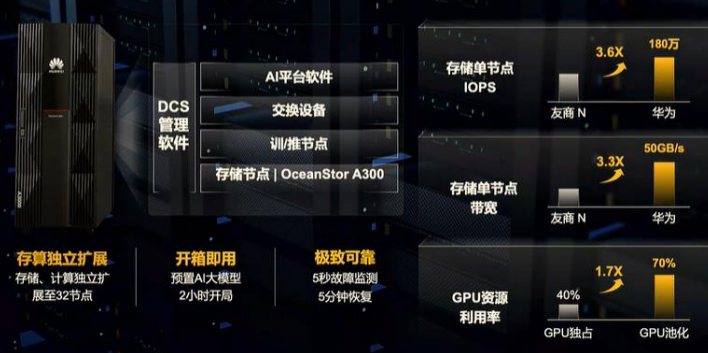

7月14日,華為發(fā)布大模型時(shí)代AI存儲(chǔ)新品, 為基礎(chǔ)模型訓(xùn)練、行業(yè)模型訓(xùn)練,細(xì)分場景模型訓(xùn)練推理提供存儲(chǔ)最優(yōu)解,釋放AI新動(dòng)能。 企業(yè)在開發(fā)及實(shí)施大模型應(yīng)用過程中,面臨四大挑戰(zhàn): ● 首先,數(shù)據(jù)

2023-07-14 15:20:02 475

475

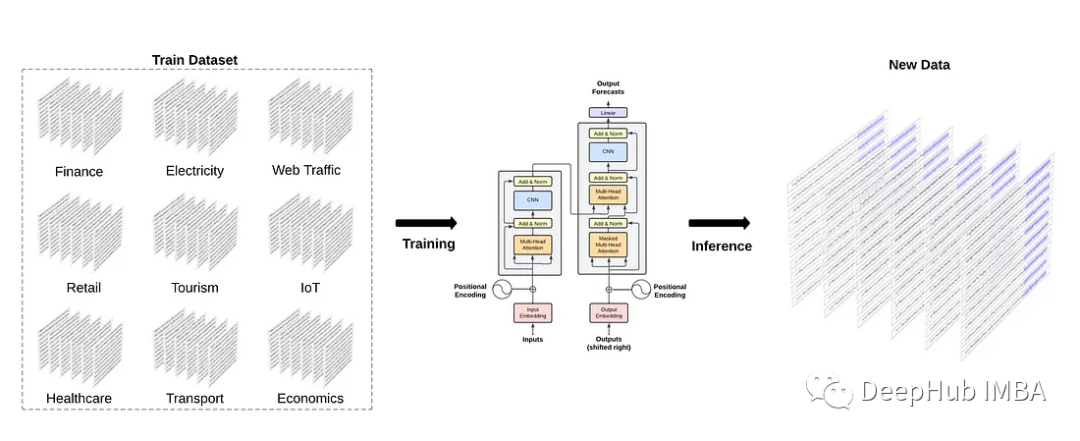

來源: DeepHub IMBA 大型語言模型(llm)是一種人工智能(AI),在大量文本和代碼數(shù)據(jù)集上進(jìn)行訓(xùn)練。它們可以用于各種任務(wù),包括生成文本、翻譯語言和編寫不同類型的創(chuàng)意內(nèi)容。 今年開始

2023-07-28 12:20:02 440

440

近日,美智庫蘭德公司高級(jí)工程師克里斯托弗·莫頓(Christopher Mouton)在C4ISRNET網(wǎng)站撰文,分析ChatGPT等大型語言模型的出現(xiàn)給國家安全帶來的新風(fēng)險(xiǎn)。主要觀點(diǎn)如下:

2023-08-04 11:44:53 304

304 大型語言模型(llm)是一種人工智能(AI),在大量文本和代碼數(shù)據(jù)集上進(jìn)行訓(xùn)練。它們可以用于各種任務(wù),包括生成文本、翻譯語言和編寫不同類型的創(chuàng)意內(nèi)容。今年開始,人們對開源LLM越來越感興趣。這些模型

2023-08-01 00:21:27 554

554

對話文本數(shù)據(jù),作為人類交流的生動(dòng)表現(xiàn),正成為訓(xùn)練大型模型的寶貴資源。這些數(shù)據(jù)不僅蘊(yùn)含了豐富的語言特點(diǎn)和人類交流方式,更在模型訓(xùn)練中發(fā)揮著重要的意義,從而為其賦予更強(qiáng)大的智能和更自然的交流能力。 大型模型

2023-08-14 10:11:11 368

368 。 大型模型,特別是基于深度學(xué)習(xí)的預(yù)訓(xùn)練語言模型,如GPT-3.5,依賴于大規(guī)模的文本數(shù)據(jù)來進(jìn)行訓(xùn)練。這些模型之所以強(qiáng)大,源于它們從這些數(shù)據(jù)中學(xué)習(xí)到的語義、關(guān)聯(lián)和結(jié)構(gòu)。文本數(shù)據(jù)中蘊(yùn)含著豐富的知識(shí)、思想和信息,通過模型的

2023-08-14 10:06:23 328

328 近日,清華大學(xué)新聞與傳播學(xué)院發(fā)布了《大語言模型綜合性能評(píng)估報(bào)告》,該報(bào)告對目前市場上的7個(gè)大型語言模型進(jìn)行了全面的綜合評(píng)估。近年,大語言模型以其強(qiáng)大的自然語言處理能力,成為AI領(lǐng)域的一大熱點(diǎn)。它們

2023-08-10 08:32:01 607

607

今天,Meta發(fā)布了Code Llama,一款可以使用文本提示生成代碼的大型語言模型(LLM)。

2023-08-25 09:06:57 885

885

,大型語言模型(Large Language Models,LLM)徹底改變了自然語言處理領(lǐng)域,使機(jī)器能夠生成類似人類的文本并進(jìn)行有意義的對話。這些模型,例如OpenAI的GPT,擁有驚人的語言理解和生成能力。它們可以被用于廣泛的自然語言處理任務(wù),包括文本生成、翻譯、自動(dòng)摘要、情緒分析等

2023-09-04 16:55:25 345

345

騰訊發(fā)布混元大語言模型 騰訊全球數(shù)字生態(tài)大會(huì)上騰訊正式發(fā)布了混元大語言模型,參數(shù)規(guī)模超千億,預(yù)訓(xùn)練語料超2萬億tokens。 作為騰訊自研的通用大語言模型,混元大語言模型具有中文創(chuàng)作能力、任務(wù)執(zhí)行

2023-09-07 10:23:54 815

815 構(gòu)建高質(zhì)量的大語言模型數(shù)據(jù)集是訓(xùn)練強(qiáng)大自然語言處理模型的關(guān)鍵一步。以下是一些關(guān)鍵步驟和考慮因素,有助于創(chuàng)建具有多樣性、準(zhǔn)確性和時(shí)效性的數(shù)據(jù)集: 數(shù)據(jù)收集:數(shù)據(jù)集的首要任務(wù)是收集大量文本數(shù)據(jù)。這可

2023-09-11 17:00:04 548

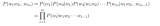

548 大語言模型涉及數(shù)據(jù)的通常有有多個(gè)階段(Aligning language models to follow instructions [1] ):pre-train、sft(supervised

2023-09-19 10:00:06 506

506

隨著各大公司爭相加入人工智能的潮流,芯片和人才供不應(yīng)求。初創(chuàng)公司SambaNova(https://sambanova.ai/)聲稱,其新處理器可以幫助公司在幾天內(nèi)建立并運(yùn)行自己的大型語言模型

2023-09-27 16:10:51 304

304 AI大模型將AI帶入新的發(fā)展階段。AI大模型需要更高效的海量原始數(shù)據(jù)收集和預(yù)處理,更高性能的訓(xùn)練數(shù)據(jù)加載和模型數(shù)據(jù)保存,以及更加及時(shí)和精準(zhǔn)的行業(yè)推理知識(shí)庫。以近存計(jì)算、向量存儲(chǔ)為代表的AI數(shù)據(jù)新范式正在蓬勃發(fā)展。

2023-10-23 11:26:09 325

325

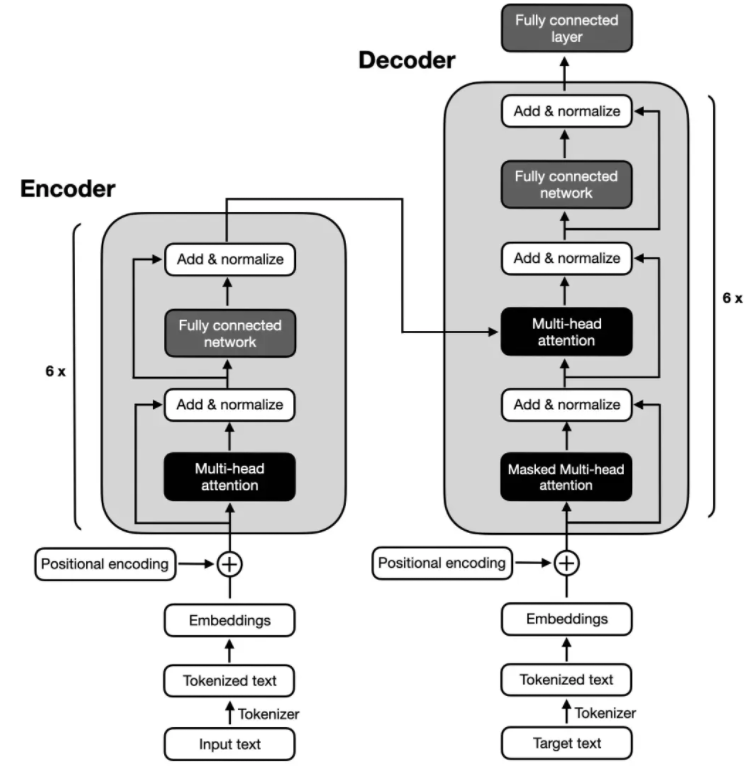

Transformer 架構(gòu)的問世標(biāo)志著現(xiàn)代語言大模型時(shí)代的開啟。自 2018 年以來,各類語言大模型層出不窮。

2023-10-24 11:42:05 337

337

求解大型COMSOL模型需要多少內(nèi)存? COMSOL是一種非常強(qiáng)大的跨學(xué)科有限元分析軟件,可以用于解決各種復(fù)雜的問題,包括流體力學(xué)、電磁學(xué)、熱傳遞、結(jié)構(gòu)力學(xué)等。但是,在處理大型模型時(shí),COMSOL

2023-10-29 11:35:24 875

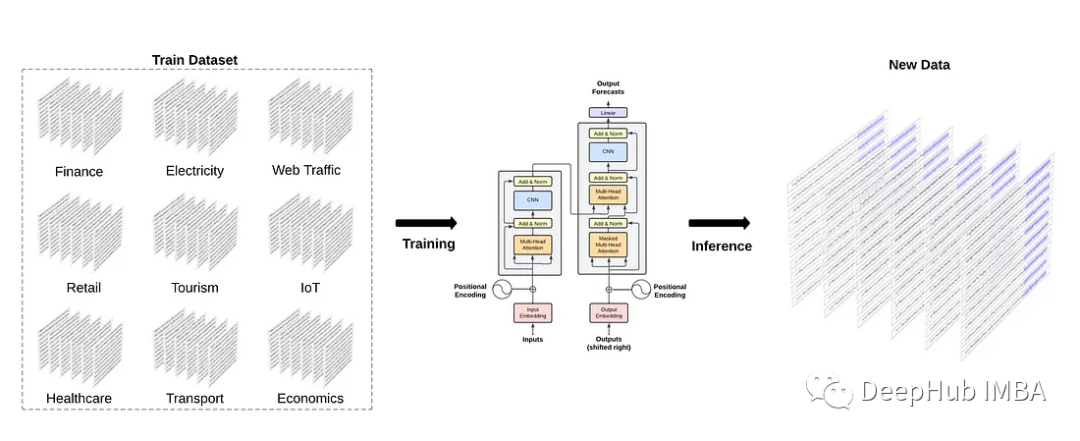

875 適應(yīng)各種各樣的任務(wù),而無需進(jìn)一步的訓(xùn)練。 這就引出了一個(gè)問題: 時(shí)間序列的基礎(chǔ)模型能像自然語言處理那樣存在嗎? 一個(gè)預(yù)先訓(xùn)練了大量時(shí)間序列數(shù)據(jù)的大型模型,是否有可能在未見過的數(shù)據(jù)上產(chǎn)生準(zhǔn)確的預(yù)測? 通過

2023-11-03 10:15:22 279

279

簡介章節(jié)講的是比較基礎(chǔ)的,主要介紹了本次要介紹的概念,即檢索(Retrieval)和大語言模型(LLM)

2023-11-15 14:50:36 281

281

本文基于亞馬遜云科技推出的大語言模型與生成式AI的全家桶:Bedrock對大語言模型進(jìn)行介紹。大語言模型指的是具有數(shù)十億參數(shù)(B+)的預(yù)訓(xùn)練語言模型(例如:GPT-3, Bloom, LLaMA)。這種模型可以用于各種自然語言處理任務(wù),如文本生成、機(jī)器翻譯和自然語言理解等。

2023-12-04 15:51:46 355

355 隨著人工智能技術(shù)的快速發(fā)展,大型預(yù)訓(xùn)練模型如GPT-4、BERT等在自然語言處理領(lǐng)域取得了顯著的成功。這些大模型背后的關(guān)鍵之一是龐大的數(shù)據(jù)集,為模型提供了豐富的知識(shí)和信息。本文將探討大模型數(shù)據(jù)集的突破邊界以及未來發(fā)展趨勢。

2023-12-06 16:10:44 247

247 大模型在多領(lǐng)域表現(xiàn)卓越,在自然語言理解、學(xué)習(xí)能力、視覺聽覺識(shí)別等領(lǐng)域可以媲美甚至超越人類。提高大模型的創(chuàng)造能力、減少對數(shù)據(jù)的依賴性、加強(qiáng)隱私保護(hù)等將會(huì)是大模型迭代的重點(diǎn)。

2023-12-07 10:48:04 386

386

大規(guī)模語言模型(Large Language Models,LLM),也稱大規(guī)模語言模型或大型語言模型,是一種由包含數(shù)百億以上參數(shù)的深度神經(jīng)網(wǎng)絡(luò)構(gòu)建的語言模型,使用自監(jiān)督學(xué)習(xí)方法通過大量無標(biāo)注

2023-12-07 11:40:43 1134

1134

的人工智能模型,旨在理解和生成自然語言文本。這類模型的核心是深度神經(jīng)網(wǎng)絡(luò),通過大規(guī)模的訓(xùn)練數(shù)據(jù)和強(qiáng)大的計(jì)算能力,使得模型能夠?qū)W習(xí)到語言的語法、語境和語義等多層次的信息。 大語言模型的發(fā)展歷史可以追溯到深度學(xué)習(xí)的

2023-12-21 17:53:59 553

553 ,帶你發(fā)現(xiàn)大語言模型的潛力,解鎖無限可能。 揭秘大語言模型的魔法 在動(dòng)手操作之前,我們先來揭秘一下大語言模型的魔法。這些模型通過大量的文本數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練,使其具備了超強(qiáng)的理解和生成自然語言的能力。搞懂它的構(gòu)造和培訓(xùn)過程

2023-12-29 14:18:59 276

276 大型語言模型(LLM)是基于人工智能的先進(jìn)模型,經(jīng)過訓(xùn)練,它可以密切反映人類自然交流的方式處理和生成人類語言。這些模型利用深度學(xué)習(xí)技術(shù)和大量訓(xùn)練數(shù)據(jù)來全面理解語言結(jié)構(gòu)、語法、上下文和語義。

2024-01-03 16:05:25 438

438

隨著開源預(yù)訓(xùn)練大型語言模型(Large Language Model, LLM )變得更加強(qiáng)大和開放,越來越多的開發(fā)者將大語言模型納入到他們的項(xiàng)目中。其中一個(gè)關(guān)鍵的適應(yīng)步驟是將領(lǐng)域特定的文檔集成到預(yù)訓(xùn)練模型中,這被稱為微調(diào)。

2024-01-04 12:32:39 228

228

韓國互聯(lián)網(wǎng)巨頭Kakao最近宣布開發(fā)了一種名為“蜜蜂”(Honeybee)的多模態(tài)大型語言模型。這種創(chuàng)新模型能夠同時(shí)理解和處理圖像和文本數(shù)據(jù),為更豐富的交互和查詢響應(yīng)提供了可能性。

2024-01-19 16:11:20 221

221 大型語言模型(LLM)正在迅速發(fā)展,變得更加強(qiáng)大和高效,使人們能夠在廣泛的應(yīng)用程序中越來越復(fù)雜地理解和生成類人文本。

2024-03-17 17:17:08 503

503

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論